Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA de ponta. Saiba mais

Uma equipe de cientistas da computação desenvolveu um método que ajuda a inteligência artificial a entender quando usar ferramentas em vez de confiar no conhecimento interno, imitando como especialistas humanos resolvem problemas complexos.

A pesquisa da Universidade da Califórnia em San Diego e da Universidade de Tsinghua demonstra uma melhoria de 28% na precisão quando os sistemas de IA aprendem a equilibrar o conhecimento interno com ferramentas externas — uma capacidade crítica para a implementação da IA em trabalhos científicos.

Como os cientistas ensinaram a IA a tomar decisões melhores

“Enquanto a integração de LLMs com ferramentas pode aumentar a confiabilidade, essa abordagem geralmente resulta em uma dependência excessiva de ferramentas, diminuindo a capacidade do modelo de resolver problemas simples por meio do raciocínio básico”, afirmam os pesquisadores em seu artigo. “Em contraste, os especialistas humanos primeiro avaliam a complexidade do problema usando conhecimento de domínio antes de escolher uma abordagem de solução apropriada.”

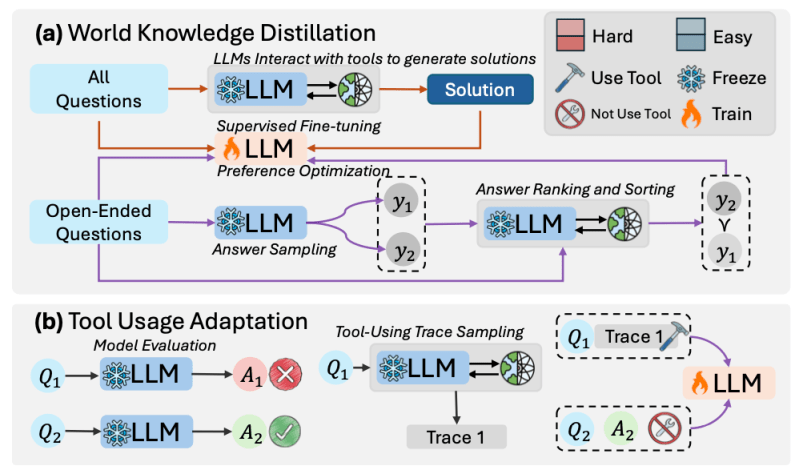

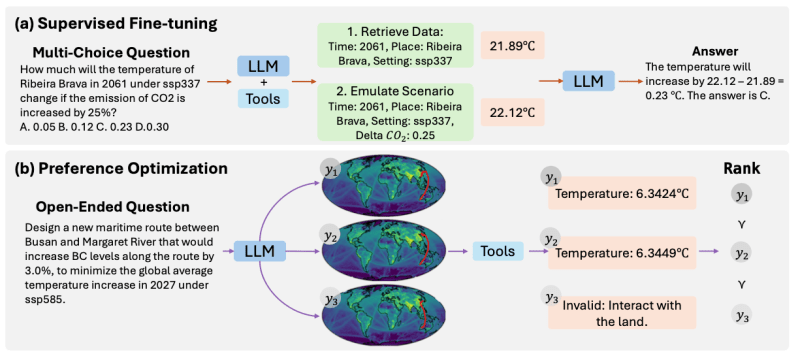

O novo método, chamado de “Adaptação Durante o Aprendizado”, utiliza um processo em duas etapas para treinar sistemas de IA. Primeiro, o modelo aprende diretamente a partir das soluções geradas usando ferramentas externas, ajudando-o a internalizar o conhecimento do domínio. Em seguida, aprende a categorizar problemas como “fáceis” ou “difíceis” e decide se deve usar ferramentas conforme apropriado.

Modelo de IA pequeno supera sistemas maiores em tarefas complexas

O que torna esse desenvolvimento significativo é sua abordagem centrada na eficiência. Usando um modelo de linguagem com apenas 8 bilhões de parâmetros — muito menor do que gigantes da indústria como o GPT-4 — os pesquisadores alcançaram uma melhoria de 28,18% na precisão das respostas e um aumento de 13,89% na precisão do uso de ferramentas em seus conjuntos de dados de teste. O modelo demonstrou particular força em tarefas científicas especializadas, superando modelos maiores em domínios específicos.

Esse sucesso desafia uma suposição fundamental no desenvolvimento de IA: que modelos maiores necessariamente produzem melhores resultados. Em vez disso, a pesquisa sugere que ensinar a IA quando usar ferramentas versus confiar no conhecimento interno — muito parecido com o treinamento de um cientista júnior para saber quando confiar em seus cálculos ou consultar equipamentos especializados — pode ser mais importante do que o poder computacional bruto.

O surgimento de modelos de IA menores e mais inteligentes

Essa pesquisa se alinha a uma mudança mais ampla na indústria em direção a modelos de IA mais eficientes em 2024. Principais empresas, incluindo Hugging Face, Nvidia, OpenAI, Meta, Anthropic e H2O.ai, lançaram modelos menores, mas altamente capazes, este ano.

O SmolLM2 da Hugging Face, com versões tão pequenas quanto 135 milhões de parâmetros, pode rodar diretamente em smartphones. Os modelos compactos de análise de documentos da H2O.ai superaram sistemas maiores de gigantes da tecnologia em tarefas especializadas. Até mesmo a OpenAI entrou na arena dos modelos pequenos com GPT-4o Mini, oferecendo capacidades semelhantes a uma fração do custo.

Essa tendência de “redução da IA” reflete o crescente reconhecimento de que maior nem sempre é melhor — modelos especializados e eficientes podem frequentemente igualar ou superar o desempenho de seus concorrentes maiores, utilizando muito menos recursos computacionais.

A abordagem técnica envolve duas fases de aprendizado distintas. Durante o treinamento, o modelo primeiro passa pelo que os pesquisadores chamam de “Destilação de Conhecimento do Mundo” (WKD), onde aprende com soluções geradas usando ferramentas externas. Isso ajuda a construir sua própria expertise interna.

A segunda fase, “Adaptação do Uso de Ferramentas” (TUA), ensina o sistema a classificar problemas com base em sua própria confiança e precisão ao resolvê-los diretamente. Para problemas mais simples, mantém a mesma abordagem usada na WKD. Mas para problemas mais desafiadores, aprende a mudar para a utilização de ferramentas externas.

Impacto nos negócios: Sistemas de IA mais eficientes para trabalho científico complexo

Para empresas que implementam sistemas de IA, essa pesquisa aborda um desafio fundamental que há muito aflige a indústria. Os sistemas de IA atuais representam dois extremos: eles ou buscam constantemente ferramentas externas — aumentando os custos computacionais e desacelerando operações simples — ou tentam perigosamente resolver tudo internamente, levando a possíveis erros em problemas complexos que requerem ferramentas especializadas.

Essa ineficiência não é apenas um problema técnico — é um problema comercial significativo. As empresas que implementam soluções de IA frequentemente se deparam com custos elevados para recursos de computação em nuvem para rodar ferramentas externas, mesmo para tarefas básicas que sua IA deveria lidar internamente. Por outro lado, organizações que optam por sistemas de IA autônomos correm o risco de cometer erros custosos quando esses sistemas tentam cálculos complexos sem ferramentas de verificação adequadas.

A abordagem dos pesquisadores oferece um meio-termo promissor. Ao ensinar à IA como tomar decisões semelhantes a humanos sobre quando usar ferramentas, as organizações poderiam potencialmente reduzir seus custos computacionais, ao mesmo tempo que mantêm ou até melhoram a precisão. Isso é particularmente valioso em campos como pesquisa científica, modelagem financeira ou diagnóstico médico, onde tanto eficiência quanto precisão são cruciais.

Além disso, esse desenvolvimento sugere um futuro em que os sistemas de IA poderiam ser parceiros mais econômicos e confiáveis no trabalho científico, capazes de tomar decisões nuançadas sobre quando alavancar recursos externos — assim como um profissional experiente que sabe exatamente quando consultar ferramentas especializadas versus confiar em sua própria experiência.

O poder de saber quando pedir ajuda

Além das conquistas técnicas imediatas, essa pesquisa desafia o paradigma de que maior é melhor que dominou o desenvolvimento de IA. Ao demonstrar que um modelo relativamente pequeno pode superar seus primos maiores ao fazer decisões mais inteligentes sobre o uso de ferramentas, a equipe aponta para um futuro mais sustentável e prático para a IA.

As implicações vão muito além da pesquisa acadêmica. À medida que a IA entra cada vez mais em domínios onde erros acarretam consequências reais – desde diagnósticos médicos até modelagem climática – a habilidade de saber quando buscar ajuda se torna crucial. Esse trabalho sugere um futuro em que os sistemas de IA não serão apenas poderosos, mas prudentes – conhecendo suas limitações assim como profissionais habilidosos.

Em essência, os pesquisadores ensinaram à IA algo fundamentalmente humano: às vezes, a decisão mais inteligente é saber quando pedir ajuda.

VB Daily

Mantenha-se informado! Receba as últimas notícias em sua caixa de entrada diariamente

Ao assinar, você concorda com os Termos de Serviço da VentureBeat.

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Google afirma que a prévia do Gemini 2.5 Pro supera o DeepSeek R1 e o Grok 3 Beta em desempenho de programação.

[the_ad id="145565"] Participe do evento confiável por líderes empresariais há quase duas décadas. O VB Transform reúne pessoas que estão construindo uma verdadeira…

AMD contrata os funcionários por trás da Untether AI

[the_ad id="145565"] A AMD continua sua onda de aquisições. A gigante de semicondutores AMD adquiriu a equipe por trás da Untether AI, uma startup que desenvolve chips de…

Chefe de marketing da OpenAI se afasta para tratar câncer de mama.

[the_ad id="145565"] A chefe de marketing da OpenAI, Kate Rouch, anunciou que estará se afastando de sua função por três meses enquanto passa por tratamento para câncer de mama…