A partir de hoje, os desenvolvedores que utilizam a API Gemini do Google e o Google AI Studio para criar serviços baseados em IA e bots poderão fundamentar os resultados de seus prompts com dados do Google Search. Isso deve permitir respostas mais precisas baseadas em dados mais recentes.

Como aconteceu anteriormente, os desenvolvedores poderão testar a fundamentação gratuitamente no AI Studio, que é essencialmente o playground do Google para desenvolvedores testarem e refinarem seus prompts e acessarem os mais recentes modelos de linguagem de grande escala (LLMs). Os usuários da API Gemini terão que estar no plano pago e pagarão $35 por cada 1.000 consultas fundamentadas.

O recém-lançado modo de comparação embutido do AI Studio torna fácil ver como os resultados das consultas fundamentadas diferem daqueles que se baseiam apenas nos dados do próprio modelo.

No seu núcleo, a fundamentação conecta um modelo a dados verificáveis — seja dados internos de uma empresa ou, neste caso, todo o catálogo de pesquisa do Google. Isso também ajuda o sistema a evitar alucinações. Em um exemplo que o Google me mostrou antes do lançamento de hoje, um prompt perguntando quem ganhou o Emmy de melhor série de comédia em 2024, o modelo — sem fundamentação — disse que foi “Ted Lasso”. Mas isso foi uma alucinação. “Ted Lasso” ganhou o prêmio, mas em 2022. Com a fundamentação ativada, o modelo forneceu o resultado correto (“Hacks”), incluiu contexto adicional e citou suas fontes.

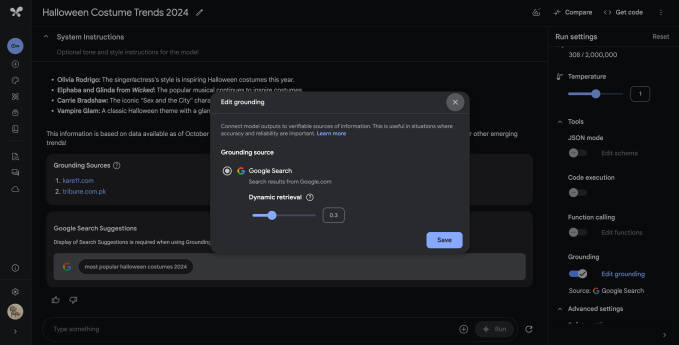

Ativar a fundamentação é tão simples quanto alternar um interruptor e decidir com que frequência a API deve usar a fundamentação, fazendo alterações na configuração de “recuperação dinâmica”. Isso pode ser tão simples quanto optar por ativá-la para cada prompt ou escolher uma configuração mais sutil que utiliza um modelo menor para avaliar o prompt e decidir se seria benéfico ser ampliado com dados do Google Search.

“A fundamentação pode ajudar… quando você faz uma pergunta muito recente que está além do limite de conhecimento do modelo, mas também pode ajudar com uma pergunta que não é tão recente… mas você pode querer detalhes mais ricos,” explicou Shrestha Basu Mallick, gerente de produto do Google para a API Gemini e AI Studio. “Pode haver desenvolvedores que digam que só queremos fundamentar em fatos recentes, e eles definiriam esse [valor de recuperação dinâmica] mais alto. E pode haver desenvolvedores que digam: Não, eu quero o rico detalhe da pesquisa do Google sobre tudo.”

Quando o Google enriquece os resultados com dados do Google Search, ele também fornece links de apoio de volta às fontes subjacentes. Logan Kilpatrick, que se juntou ao Google no início deste ano após liderar as relações com desenvolvedores na OpenAI, me disse que exibir esses links é um requisito da licença Gemini para qualquer um que use este recurso.

“Isso é muito importante para nós por duas razões: primeiro, queremos garantir que nossos publicadores recebam o crédito e a visibilidade,” acrescentou Basu Mallick. “Mas, em segundo lugar, isso também é algo que os usuários gostam. Quando eu recebo uma resposta de um LLM, muitas vezes vou ao Google Search verificar essa resposta. Estamos oferecendo uma maneira fácil para eles fazerem isso, então isso é muito valorizado pelos usuários.”

Nesse contexto, vale a pena notar que enquanto o AI Studio começou como algo mais parecido com uma ferramenta de ajuste de prompts, ele é muito mais agora.

“O sucesso do AI Studio se parece com: você entra, experimenta um dos modelos Gemini e vê que isso é realmente poderoso e funciona bem para o seu caso de uso,” disse Kilpatrick. “Fazemos várias coisas para apresentar potenciais casos de uso interessantes para os desenvolvedores em destaque na interface do usuário, mas, em última análise, o objetivo não é mantê-lo no AI Studio apenas para você brincar com os modelos. O objetivo é que você obtenha código. Você pressiona ‘Obter Código’ no canto superior direito, começa a construir algo e pode voltar ao AI Studio para experimentar com um modelo futuro.”

Conteúdo relacionado

O novo Detector SynthID do Google pode ajudar a identificar conteúdos gerados por IA.

[the_ad id="145565"] O Google está lançando uma maneira de verificar rapidamente se uma imagem, vídeo, arquivo de áudio ou um trecho de texto foi criado usando uma de suas…

O Android Studio adiciona ‘IA agentiva’ com o recurso Journeys e Modo Agente

[the_ad id="145565"] O Android Studio, o ambiente de desenvolvimento integrado (IDE) para desenvolvedores de aplicativos Android, está recebendo uma atualização de IA, anunciou…

Google Meet Introduces Real-Time Speech Translation in Portuguese

[the_ad id="145565"] O Google anunciou na Google I/O 2025 que está trazendo tradução de fala em tempo real para o Google Meet. O recurso utiliza um grande modelo de áudio de…