Olá, pessoal! Bem-vindos ao boletim de IA regular do TechCrunch. Se você deseja receber isso na sua caixa de entrada todas as quartas-feiras, inscreva-se aqui.

Na segunda-feira, o CEO da Anthropic, Dario Amodei, participou de um podcast entrevista com o influenciador de IA Lex Fridman, que durou cinco horas. Os dois abordaram uma série de tópicos, desde prazos para a superinteligência até os avanços na próxima tecnologia de destaque da Anthropic.

Para poupar o download, extraímos os pontos principais.

Apesar de evidências em contrário, Amodei acredita que “aumentar a escala” dos modelos ainda é um caminho viável para uma IA mais capaz. Ao falar em aumentar a escala, Amodei esclareceu que se refere ao aumento não apenas da quantidade de computação usada para treinar os modelos, mas também do tamanho dos próprios modelos — e do tamanho dos conjuntos de dados usados para treinamento.

“Provavelmente, o aumento da escala vai continuar, e há alguma mágica nisso que ainda não explicamos de forma teórica,” disse Amodei.

Amodei também não acredita que a escassez de dados seja um desafio para o desenvolvimento de IA, ao contrário de alguns especialistas. Ele afirma que, seja gerando dados sintéticos ou extrapolando a partir de dados existentes, os desenvolvedores de IA conseguirão “contornar” as limitações de dados. (Resta saber se os problemas com dados sintéticos são solucionáveis, observo aqui.)

Amodei admite, no entanto, que o custo da computação em IA provavelmente aumentará no curto prazo, em parte como consequência da escalabilidade. Ele espera que as empresas gastem bilhões de dólares em clusters para treinar modelos no próximo ano e que, até 2027, eles gastarão centenas de bilhões. (De fato, a OpenAI está rumores de que planeja um data center de $100 bilhões.)

E Amodei foi sincero sobre como mesmo os melhores modelos são imprevisíveis por natureza.

“É muito difícil controlar o comportamento de um modelo — direcionar o comportamento de um modelo em todas as circunstâncias ao mesmo tempo,” disse ele. “Há um aspecto ‘whack-a-mole’, onde você pressiona uma coisa e outras coisas começam a mudar também, que você pode não perceber ou medir.”

Ainda assim, Amodei prevê que a Anthropic — ou um rival — criará uma IA “superinteligente” até 2026 ou 2027 — uma que superará o desempenho “em nível humano” em várias tarefas. E ele se preocupa com as implicações disso.

“Estamos rapidamente ficando sem bloqueios realmente convincentes, razões verdadeiramente relevantes para que isso não aconteça nos próximos anos,” disse ele. “Eu me preocupo com a economia e com a concentração de poder. Isso é, na verdade, o que mais me preocupa — o abuso de poder.”

É bom, então, que ele esteja em uma posição para fazer algo sobre isso.

Notícias

Um aplicativo de notícias de IA: O Particle, leitor de notícias de IA criado por ex-engenheiros do Twitter, visa ajudar os leitores a entender melhor as notícias com a ajuda da tecnologia de IA.

Levanta para escritores: A Writer levantou $200 milhões com uma avaliação de $1,9 bilhões para expandir sua plataforma de IA generativa focada em empresas.

Build on Trainium: A Amazon Web Services (AWS) lançou o Build on Trainium, um novo programa que premiará $110 milhões para instituições, cientistas e estudantes que pesquisam IA utilizando a infraestrutura da AWS.

A Red Hat compra uma startup: A Red Hat da IBM está adquirindo a Neural Magic, uma startup que otimiza modelos de IA para rodar mais rápido em processadores e GPUs comuns.

Gratuito Grok: O X, anteriormente Twitter, está testando uma versão gratuita de seu chatbot de IA, Grok.

IA nos Grammy: A faixa “Now and Then” dos Beatles, que foi refinada com o uso de IA e lançada no ano passado, foi indicada para dois prêmios Grammy.

Anthropic para defesa: A Anthropic está se unindo à empresa de análise de dados Palantir e à AWS para fornecer agências de inteligência e defesa dos EUA acesso aos modelos de IA da família Claude da Anthropic.

Um novo domínio: A OpenAI comprou Chat.com, adicionando à sua coleção de nomes de domínio de alto perfil.

Artigo de pesquisa da semana

O Google afirma ter desenvolvido um modelo de IA aprimorado para previsão de inundações.

O modelo, que se baseia no trabalho anterior da empresa nessa área, pode prever condições de inundação com precisão até sete dias de antecedência em dezenas de países. Em teoria, o modelo pode oferecer previsões de inundações para qualquer lugar da Terra, mas o Google observa que muitas regiões carecem de dados históricos para validação.

O Google está oferecendo uma lista de espera para acesso à API do modelo para especialistas em gestão de desastres e hidrologia. Também está disponibilizando previsões do modelo através de sua plataforma Flood Hub.

“Ao tornar nossas previsões disponíveis globalmente no Flood Hub… esperamos contribuir para a comunidade de pesquisa,” diz a empresa em uma postagem no blog. “Esses dados podem ser usados por usuários e pesquisadores especializados para informar mais estudos e análises sobre como as inundações impactam comunidades ao redor do mundo.”

Modelo da semana

Rami Seid, um desenvolvedor de IA, lançou um modelo de simulação de Minecraft que pode rodar em uma única Nvidia RTX 4090.

Semelhante ao modelo “mundo aberto” recentemente lançado pela startup de IA Decart, o de Seid, chamado Lucid v1, emula o mundo do jogo Minecraft em tempo real (ou quase isso). Com 1 bilhão de parâmetros, Lucid v1 recebe movimentos de teclado e mouse e gera frames, simulando toda a física e gráficos.

O Lucid v1 sofre das mesmas limitações que outros modelos de simulação de jogos. A resolução é bastante baixa e tende a “esquecer” rapidamente a disposição do nível — vire seu personagem e você verá uma cena rearranjada.

Mas Seid e seu parceiro, Ollin Boer Bohan, dizem que planejam continuar desenvolvendo o modelo, que está disponível para download e alimenta a demonstração online aqui.

Diversos

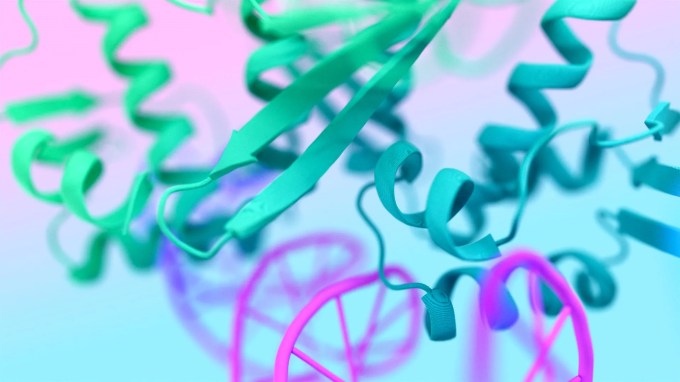

A DeepMind, o principal laboratório de IA do Google, lançou o código do AlphaFold 3, seu modelo de previsão de proteínas impulsionado por IA.

O AlphaFold 3 foi anunciado há seis meses, mas a DeepMind controversamente reteve o código. Em vez disso, forneceu acesso através de um servidor web que limitava o número e os tipos de previsões que os cientistas podiam fazer.

Críticos viram a medida como uma tentativa de proteger os interesses comerciais da DeepMind à custa da reprodutibilidade. A subsidiária da DeepMind, Isomorphic Labs, está aplicando o AlphaFold 3, que pode modelar proteínas em conjunto com outras moléculas, na descoberta de medicamentos.

Agora, os acadêmicos podem usar o modelo para fazer quaisquer previsões que desejem — incluindo como as proteínas se comportam na presença de possíveis medicamentos. Cientistas com filiação acadêmica podem solicitar acesso ao código aqui.

Conteúdo relacionado

Uplimit eleva as apostas na aprendizagem corporativa com conjunto de agentes de IA que podem treinar 1.000 funcionários simultaneamente.

[the_ad id="145565"] Participe dos nossos boletins informativos diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba…

Actively AI levanta US$ 22,5 milhões para oferecer ‘superinteligência’ em vendas, afirma que SDRs de IA falharam.

[the_ad id="145565"] As startups de representantes de vendas baseados em IA estão se tornando um mercado muito concorrido atualmente. Se você estiver dirigindo para San…

Anthropic transforma a abordagem da IA na educação: o Modo de Aprendizagem do Claude faz os alunos refletirem.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas novidades e conteúdo exclusivo sobre cobertura de IA de liderança no setor. Saiba mais……