Participe das nossas newsletters diárias e semanais para receber as últimas atualizações e conteúdos exclusivos sobre cobertura de IA líder de mercado. Saiba Mais

Cientistas estão inundados de dados. Com milhões de artigos de pesquisa publicados a cada ano, mesmo os especialistas mais dedicados lutam para se manter atualizados sobre as últimas descobertas em suas áreas.

Um novo sistema de inteligência artificial, chamado OpenScholar, promete reescrever as regras sobre como os pesquisadores acessam, avaliam e sintetizam a literatura científica. Desenvolvido pelo Instituto Allen para IA (Ai2) e pela Universidade de Washington, o OpenScholar combina sistemas de recuperação de ponta com um modelo de linguagem ajustado para fornecer respostas abrangentes e fundamentadas em citações para perguntas de pesquisa complexas.

“O progresso científico depende da capacidade dos pesquisadores de sintetizar o crescente corpo de literatura”, escreveram os pesquisadores do OpenScholar em seu artigo. Mas essa capacidade é cada vez mais restringida pelo imenso volume de informações. OpenScholar, argumentam, oferece um caminho a seguir—um que não só ajuda os pesquisadores a navegar na enxurrada de artigos, mas também desafia a dominância de sistemas de IA proprietários como o GPT-4o da OpenAI.

Como o cérebro de IA do OpenScholar processa 45 milhões de artigos de pesquisa em segundos

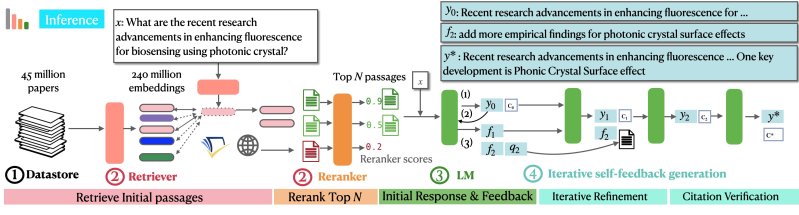

No núcleo do OpenScholar está um modelo de linguagem aumentado por recuperação que acessa um banco de dados de mais de 45 milhões de artigos acadêmicos de acesso aberto. Quando um pesquisador faz uma pergunta, o OpenScholar não gera apenas uma resposta a partir do conhecimento pré-treinado, como modelos como o GPT-4o costumam fazer. Em vez disso, ele ativa a recuperação de artigos relevantes, sintetiza suas descobertas e gera uma resposta baseada nessas fontes.

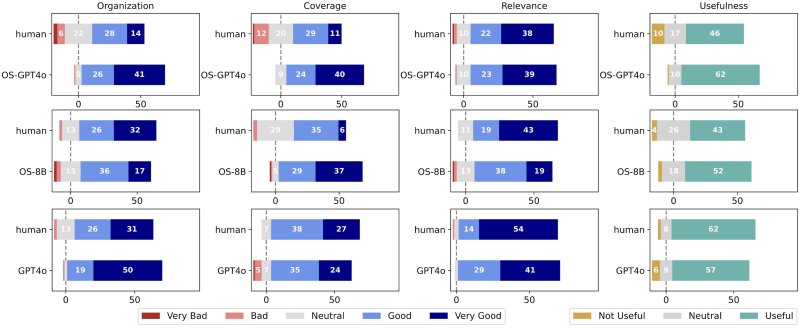

Essa capacidade de permanecer “fundamentado” na literatura real é um grande diferencial. Em testes com um novo benchmark chamado ScholarQABench, projetado especificamente para avaliar sistemas de IA em perguntas científicas abertas, o OpenScholar se destacou. O sistema demonstrou desempenho superior em factualidade e precisão de citações, superando até mesmo modelos proprietários muito maiores como o GPT-4o.

Uma descoberta particularmente preocupante envolveu a tendência do GPT-4o de gerar citações fabricadas—alucinações, na linguagem da IA. Quando encarregado de responder a perguntas de pesquisa biomédica, o GPT-4o citou artigos inexistentes em mais de 90% dos casos. O OpenScholar, em contraste, permaneceu firmemente ancorado em fontes verificáveis.

A fundamentação em artigos reais recuperados é fundamental. O sistema usa o que os pesquisadores descrevem como seu “ciclo de inferência de auto-retroalimentação” e “refina iterativamente suas saídas através de feedback em linguagem natural, o que melhora a qualidade e incorpora adaptativamente informações suplementares.”

As implicações para pesquisadores, formuladores de políticas e líderes empresariais são significativas. O OpenScholar pode se tornar uma ferramenta essencial para acelerar a descoberta científica, permitindo que especialistas sintetizem conhecimentos mais rapidamente e com maior confiança.

Dentro da batalha Davi vs. Golias: A IA de código aberto pode competir com as grandes empresas de tecnologia?

A estreia do OpenScholar ocorre em um momento em que o ecossistema de IA é cada vez mais dominado por sistemas fechados e proprietários. Modelos como o GPT-4o da OpenAI e o Claude da Anthropic oferecem capacidades impressionantes, mas são caros, opacos e inacessíveis para muitos pesquisadores. O OpenScholar inverte esse modelo sendo totalmente de código aberto.

A equipe do OpenScholar não apenas lançou o código do modelo de linguagem, mas também todo o pipeline de recuperação, um modelo de 8 bilhões de parâmetros ajustado para tarefas científicas e um banco de dados de artigos científicos. “Ao nosso conhecimento, esta é a primeira liberação pública de um pipeline completo para um assistente científico LM—desde dados a receitas de treinamento e checkpoints de modelos,” escreveram os pesquisadores em seu post no blog anunciando o sistema.

Essa abertura não é apenas uma posição filosófica; também é uma vantagem prática. O tamanho menor e a arquitetura simplificada do OpenScholar tornam-no muito mais eficiente em termos de custo em comparação com sistemas proprietários. Por exemplo, os pesquisadores estimam que OpenScholar-8B é 100 vezes mais barato de operar que PaperQA2, um sistema concorrente baseado no GPT-4o.

Essa eficiência de custo poderia democratizar o acesso a ferramentas poderosas de IA para instituições menores, laboratórios subfinanciados e pesquisadores de países em desenvolvimento.

No entanto, o OpenScholar não está isento de limitações. Seu banco de dados é restrito a artigos de acesso aberto, deixando de fora pesquisas que ficam atrás de paywalls que dominam algumas áreas. Essa restrição, embora legalmente necessária, significa que o sistema pode perder descobertas críticas em áreas como medicina ou engenharia. Os pesquisadores reconhecem essa lacuna e esperam que iterações futuras possam incluir de forma responsável conteúdos de acesso fechado.

O novo método científico: Quando a IA se torna seu parceiro de pesquisa

O projeto OpenScholar levanta questões importantes sobre o papel da IA na ciência. Embora a capacidade do sistema de sintetizar literatura seja impressionante, não é infalível. Em avaliações de especialistas, as respostas do OpenScholar foram preferidas em relação às escritas por humanos 70% das vezes, mas os 30% restantes destacaram áreas em que o modelo falhou—como não citar artigos fundamentais ou selecionar estudos menos representativos.

Essas limitações destacam uma verdade mais ampla: ferramentas de IA como o OpenScholar destinam-se a aumentar, e não substituir, a expertise humana. O sistema é projetado para auxiliar os pesquisadores lidando com a tarefa demorada de síntese da literatura, permitindo que se concentrem na interpretação e no avanço do conhecimento.

Céticos podem apontar que a depender de artigos de acesso aberto limita sua utilidade imediata em campos de alto risco, como farmacêuticos, onde grande parte da pesquisa está bloqueada por paywalls. Outros argumentam que o desempenho do sistema, embora forte, ainda depende fortemente da qualidade dos dados recuperados. Se a etapa de recuperação falhar, todo o pipeline arrisca produzir resultados subótimos.

Mas, mesmo com suas limitações, o OpenScholar representa um momento histórico na computação científica. Enquanto os modelos de IA anteriores impressionavam com sua capacidade de engajar em conversação, o OpenScholar demonstra algo mais fundamental: a capacidade de processar, entender e sintetizar literatura científica com precisão quase humana.

Os números contam uma história convincente. O modelo de 8 bilhões de parâmetros do OpenScholar supera o GPT-4o enquanto é ordens de magnitude menor. Ele iguala os especialistas humanos em precisão de citação, onde outras IAs falham 90% das vezes. E talvez o mais revelador, especialistas preferem suas respostas às escritas por seus pares.

Essas conquistas sugerem que estamos entrando em uma nova era de pesquisa assistida por IA, onde o gargalo no progresso científico pode não ser mais nossa capacidade de processar conhecimento existente, mas sim nossa capacidade de fazer as perguntas corretas.

Os pesquisadores publicaram tudo—código, modelos, dados e ferramentas—apostando que a abertura acelerará o progresso mais do que manter suas descobertas atrás de portas fechadas.

Assim, eles responderam a uma das questões mais prementes no desenvolvimento de IA: as soluções de código aberto podem competir com as caixas-pretas das grandes empresas de tecnologia?

A resposta, parece, está escondida à vista entre 45 milhões de artigos.

VB Diário

Mantenha-se informado! Receba as últimas notícias na sua caixa de entrada diariamente

Ao se inscrever, você concorda com os Termos de Serviço da VentureBeat.

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Anthropic enviou um aviso de remoção a um desenvolvedor que tentava reverter o código de sua ferramenta.

[the_ad id="145565"] Na disputa entre duas ferramentas de código "agente" — Claude Code da Anthropic e Codex CLI da OpenAI — a última parece estar promovendo mais boa vontade…

O novo CEO da Intel sinaliza esforços de simplificação, mas não revela números exatos de demissões.

[the_ad id="145565"] Lip-Bu Tan, o novo CEO da Intel, enviou uma mensagem direta aos funcionários, afirmando que a empresa precisa se reorganizar para ser mais eficiente. Ele…

Um pesquisador da OpenAI que trabalhou no GPT-4.5 teve seu green card negado.

[the_ad id="145565"] Kai Chen, um pesquisador de IA canadense que trabalha na OpenAI e mora nos EUA há 12 anos, teve seu pedido de green card negado, de acordo com Noam Brown,…