Usuários da plataforma de IA conversacional ChatGPT descobriram um fenômeno interessante durante o fim de semana: o popular chatbot se recusa a responder perguntas se perguntado sobre um “David Mayer.” Pedir para ele fazer isso provoca uma congelada instantânea. Teorias da conspiração surgiram — mas uma razão mais comum pode estar no cerne desse comportamento estranho.

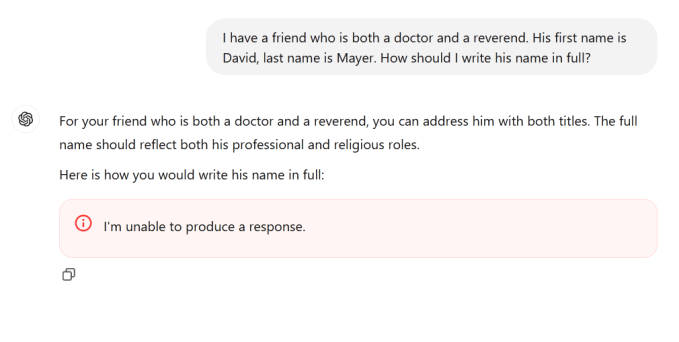

A notícia se espalhou rapidamente no último fim de semana que o nome era “veneno” para o chatbot, com cada vez mais pessoas tentando enganar o serviço para que simplesmente reconhecesse o nome. Sem sorte: toda tentativa de fazer o ChatGPT pronunciar aquele nome específico faz com que ele falhe ou até mesmo interrompa a resposta no meio do nome.

“Não consigo produzir uma resposta,” ele diz, se é que diz algo.

Mas o que começou como uma curiosidade isolada logo se transformou à medida que as pessoas descobriram que não era apenas David Mayer que o ChatGPT não consegue nomear.

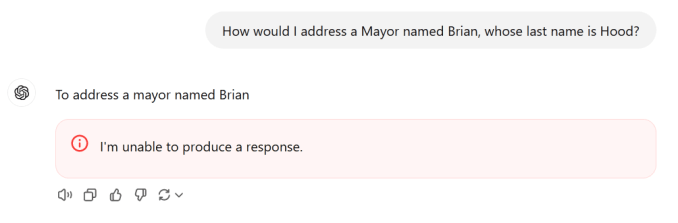

Também foi descoberto que os nomes Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber e Guido Scorza provocam o colapso do serviço. (Sem dúvida, mais nomes foram descobertos desde então, portanto esta lista não é exaustiva.)

Quem são esses homens? E por que o ChatGPT os “odeia” tanto? A OpenAI não respondeu a repetidas perguntas, então somos deixados para juntar as peças por conta própria da melhor maneira possível.

Alguns desses nomes podem pertencer a diversas pessoas. Mas logo foi descoberta uma possível conexão: essas pessoas eram figuras públicas ou semi-públicas que podem ter preferido que certas informações fossem “esquecidas” por mecanismos de busca ou modelos de IA.

Brian Hood, por exemplo, destacou-se imediatamente, pois, se for o mesmo cara, eu escrevi sobre ele no ano passado. Hood, um prefeito australiano, acusou o ChatGPT de descrevê-lo falsamente como o perpetrador de um crime de décadas atrás que, na verdade, ele havia relatado.

Embora seus advogados tenham entrado em contato com a OpenAI, nenhuma leição foi protocolada. Como ele disse ao Sydney Morning Herald no início deste ano, “O material ofensivo foi removido e eles lançaram a versão 4, substituindo a versão 3.5.”

Quanto aos proprietários mais proeminentes dos outros nomes, David Faber é um repórter de longa data da CNBC. Jonathan Turley é um advogado e comentarista da Fox News que foi “swatted” (ou seja, uma falsa ligação para o 911 enviou policiais armados para sua casa) no final de 2023. Jonathan Zittrain também é um especialista legal, alguém que falou extensivamente sobre o “direito de ser esquecido.” E Guido Scorza está no conselho da Autoridade de Proteção de Dados da Itália.

Não exatamente na mesma linha de trabalho, nem ainda uma seleção aleatória. Cada uma dessas pessoas é conceitualmente alguém que, por algum motivo, pode ter solicitado formalmente que informações relacionadas a elas online fossem restringidas de alguma forma.

O que nos traz de volta a David Mayer. Não há advogado, jornalista, prefeito ou outra pessoa notável por esse nome que alguém pudesse encontrar (com desculpas aos muitos David Mayers respeitáveis que existem por aí).

No entanto, havia um Professor David Mayer, que lecionava drama e história, especializando-se nas conexões entre a era vitoriana tardia e o cinema inicial. Mayer faleceu no verão de 2023, aos 94 anos. Durante anos antes disso, no entanto, o acadêmico britânico-americano enfrentou um problema legal e online de ter seu nome associado a um criminoso procurado que usava esse nome como pseudônimo, a ponto de não conseguir viajar.

Mayer lutou continuamente para que seu nome fosse desambiguado do terrorista de um braço só, mesmo enquanto continuava a ensinar até seus últimos anos.

Então, o que podemos concluir de tudo isso? Faltando qualquer explicação oficial da OpenAI, nosso palpite é que o modelo assimilou uma lista de pessoas cujos nomes requerem algum manuseio especial. Se devido a preocupações legais, de segurança, privacidade ou outras, esses nomes provavelmente estão cobertos por regras especiais, assim como muitos outros nomes e identidades. Por exemplo, o ChatGPT pode mudar sua resposta quando você pergunta sobre um candidato político após ele relacionar o nome que você escreveu a uma lista desses.

Existem muitas dessas regras especiais, e cada solicitação passa por várias formas de processamento antes de ser respondida. Mas essas regras de manuseio pós-solicitação raramente são tornadas públicas, exceto em anúncios de políticas como “o modelo não preverá resultados eleitorais para nenhum candidato a cargo.”

O que provavelmente aconteceu é que uma dessas listas, que quase certamente é mantida ativamente ou atualizada automaticamente, foi de alguma forma corrompida com código defeituoso que, quando chamada, fez com que o agente de conversa falhasse imediatamente. Para ser claro, isso é apenas nossa especulação com base no que aprendemos, mas não seria a primeira vez que uma IA se comporta de maneira estranha devido a diretrizes pós-treinamento. (Coincidentemente, enquanto eu escrevia isso, “David Mayer” começou a funcionar novamente para alguns, enquanto os outros nomes ainda causavam colapsos.)

Como é costume com essas coisas, o princípio de Hanlon se aplica: Nunca atribua à malícia (ou conspiração) o que é adequadamente explicado pela estupidez (ou erro de sintaxe).

Todo o drama é um lembrete útil de que esses modelos de IA não são mágicos, mas são também um tipo de auto-completar especialmente sofisticado, ativamente monitorado e interferido pelas empresas que os criam. Na próxima vez que você pensar em obter fatos de um chatbot, avalie se pode ser melhor ir direto à fonte.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…