Participe das nossas newsletters diárias e semanais para receber as últimas atualizações e conteúdo exclusivo sobre cobertura de IA de ponta. Saiba Mais

Pesquisadores da Sakana AI desenvolveram uma estrutura que consome poucos recursos e pode criar centenas de modelos de linguagem especializados em diferentes tarefas. Chamada CycleQD, a técnica utiliza algoritmos evolutivos para combinar as habilidades de diferentes modelos sem a necessidade de processos de treinamento caros e lentos.

CycleQD pode criar enxames de agentes específicos para tarefas, oferecendo uma alternativa mais sustentável ao paradigma atual de aumentar o tamanho dos modelos.

Repensando o treinamento de modelos

Os grandes modelos de linguagem (LLMs) demonstraram habilidades notáveis em várias tarefas. No entanto, treinar LLMs para dominar várias habilidades continua sendo um desafio. Ao ajustar modelos, os engenheiros devem equilibrar dados de diferentes habilidades e garantir que uma habilidade não domine as outras. As abordagens atuais costumam envolver o treinamento de modelos cada vez maiores, o que leva a demandas computacionais crescentes e exigências de recursos.

“Acreditamos que, em vez de buscar desenvolver um único grande modelo para ter um bom desempenho em todas as tarefas, abordagens baseadas em populações para evoluir um enxame diversificado de modelos de nicho podem oferecer um caminho alternativo e mais sustentável para escalar o desenvolvimento de agentes de IA com capacidades avançadas,” escrevem os pesquisadores da Sakana em um post no blog.

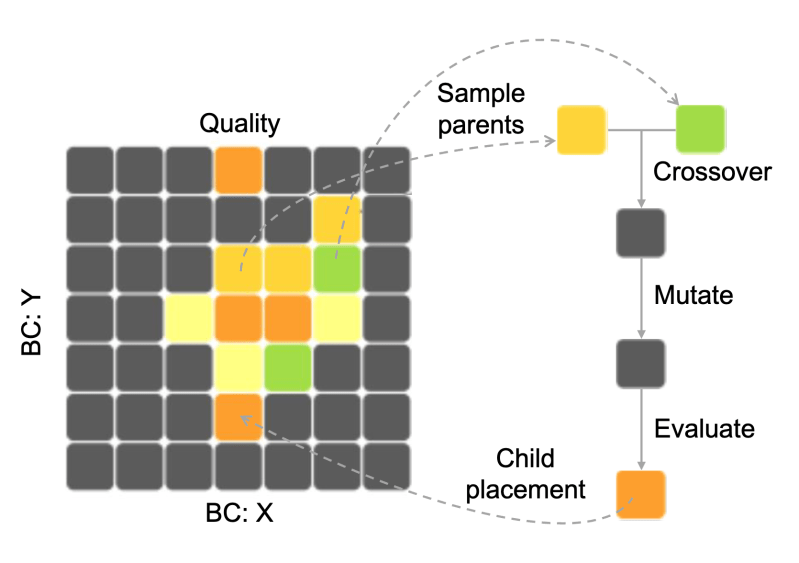

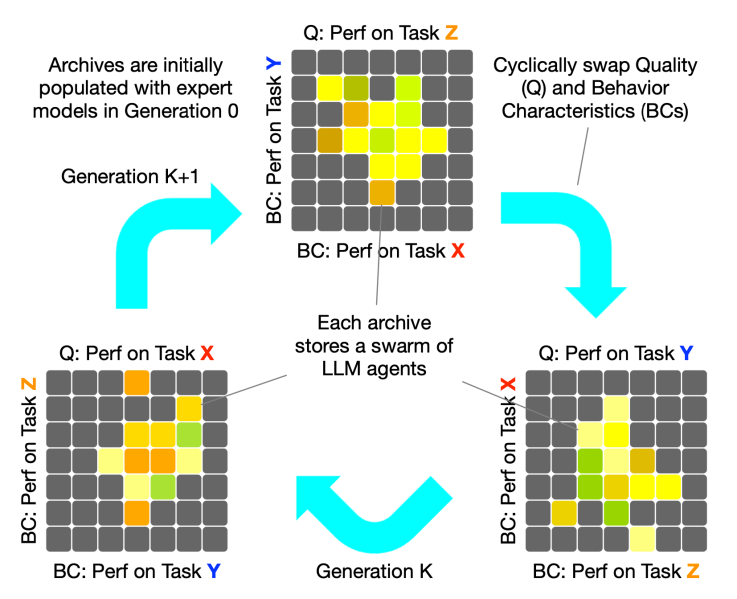

Para criar populações de modelos, os pesquisadores se inspiraram na diversidade de qualidade (QD), um paradigma de computação evolutiva que se concentra em descobrir um conjunto diversificado de soluções a partir de uma amostra inicial da população. O QD visa criar espécimes com várias “características de comportamento” (BCs), que representam diferentes domínios de habilidades. Isso é alcançado através de algoritmos evolutivos (EA) que selecionam exemplos parentais e usam operações de crossover e mutação para criar novas amostras.

CycleQD

CycleQD incorpora QD no pipeline pós-treinamento de LLMs para ajudá-los a aprender novas habilidades complexas. CycleQD é útil quando você possui vários pequenos modelos que foram ajustados para habilidades muito específicas, como programação ou operações de banco de dados e sistema operacional, e deseja criar novas variantes que tenham diferentes combinações dessas habilidades.

No framework CycleQD, cada uma dessas habilidades é considerada uma característica de comportamento ou uma qualidade para a qual a próxima geração de modelos é otimizada. Em cada geração, o algoritmo se concentra em uma habilidade específica como sua métrica de qualidade enquanto utiliza as outras habilidades como BCs.

“Isso garante que cada habilidade tenha seu momento no destaque, permitindo que os LLMs cresçam de forma mais equilibrada e capacitante ao todo,” explicam os pesquisadores.

CycleQD começa com um conjunto de LLMs especialistas, cada um especializado em uma única habilidade. O algoritmo então aplica operações de “crossover” e “mutação” para adicionar novos modelos de maior qualidade à população. O crossover combina as características de dois modelos parentais para criar um novo modelo, enquanto a mutação faz mudanças aleatórias no modelo para explorar novas possibilidades.

A operação de crossover é baseada na fusão de modelos, uma técnica que combina os parâmetros de dois LLMs para criar um novo modelo com habilidades combinadas. Este é um método econômico e rápido para desenvolver modelos bem equilibrados sem a necessidade de ajustá-los.

A operação de mutação utiliza decomposição em valores singulares (SVD), um método de fatoração que quebra qualquer matriz em componentes mais simples, facilitando a compreensão e manipulação de seus elementos. O CycleQD usa SVD para decompor as habilidades do modelo em componentes fundamentais ou sub-habilidades. Ao ajustar essas sub-habilidades, o processo de mutação cria modelos que exploram novas capacidades além das de seus modelos parentais. Isso ajuda os modelos a evitar ficar presos em padrões previsíveis e reduz o risco de superajuste.

Avaliação do desempenho do CycleQD

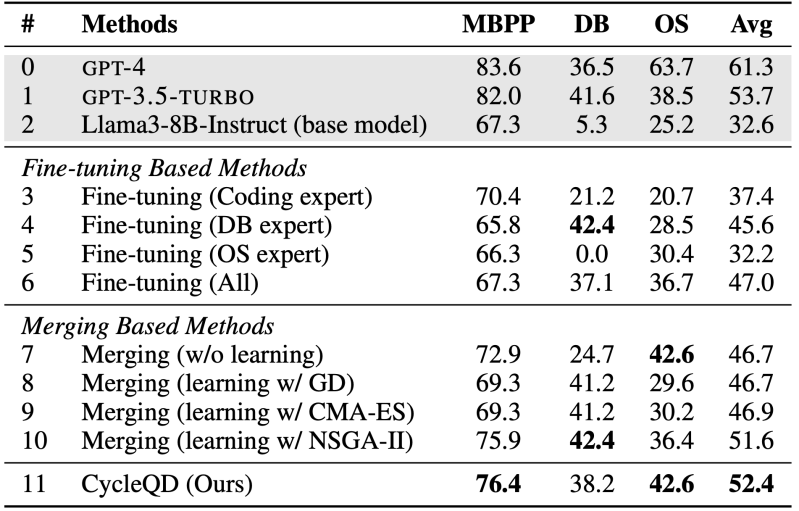

Os pesquisadores aplicaram o CycleQD a um conjunto de modelos especialistas Llama 3-8B finamente ajustados para codificação, operações de banco de dados e operações de sistema operacional. O objetivo era verificar se o método evolutivo poderia combinar as habilidades dos três modelos para criar um modelo superior.

Os resultados mostraram que o CycleQD superou os métodos tradicionais de ajuste fino e fusão de modelos nas tarefas avaliadas. Notavelmente, um modelo ajustado em todos os conjuntos de dados combinados teve um desempenho apenas marginalmente melhor do que os modelos especialistas de uma única habilidade, apesar de ter sido treinado em mais dados. Além disso, o processo de treinamento tradicional é muito mais lento e caro. O CycleQD também foi capaz de criar vários modelos com diferentes níveis de desempenho nas tarefas alvo.

“Esses resultados mostram claramente que o CycleQD supera os métodos tradicionais, provando sua eficácia em treinar LLMs para se destacar em várias habilidades,” escrevem os pesquisadores.

Os pesquisadores acreditam que o CycleQD tem o potencial de habilitar a aprendizagem contínua em sistemas de IA, permitindo que eles cresçam, se adaptem e acumulem conhecimentos ao longo do tempo. Isso pode ter implicações diretas para aplicações do mundo real. Por exemplo, o CycleQD pode ser usado para mesclar continuamente as habilidades de modelos especialistas em vez de treinar um grande modelo do zero.

Outra direção empolgante é o desenvolvimento de sistemas multiagentes, onde enxames de agentes especializados evoluídos através do CycleQD podem colaborar, competir e aprender uns com os outros.

“Da descoberta científica à resolução de problemas do mundo real, enxames de agentes especializados podem redefinir os limites da IA,” escrevem os pesquisadores.

VB Diário

Fique por dentro! Receba as últimas notícias na sua caixa de entrada diariamente

Ao se inscrever, você concorda com os Termos de Serviço da VentureBeat.

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

A Microsoft afirma que sua IA Aurora pode prever com precisão a qualidade do ar, tufões e muito mais.

Um dos mais recentes modelos de IA da Microsoft pode prever com precisão a qualidade do ar, furacões, tifões e outros fenômenos climáticos, afirma a…

OpenAI atualiza o modelo de IA que alimenta seu agente Operator.

A OpenAI está atualizando o modelo de IA que alimenta o Operator, seu agente de IA que pode navegar autonomamente na web e usar certos softwares dentro de…

Marjorie Taylor Greene provocou uma briga com Grok.

Na semana passada, o chatbot de IA de Elon Musk, Grok, enfrentou um “bug” que fez com que informasse os usuários sobre a teoria da conspiração da…