Devido à natureza de alguns dos materiais discutidos aqui, este artigo conterá menos links de referência e ilustrações do que o habitual.

Algo notável está acontecendo atualmente na comunidade de síntese de IA, embora seu significado possa levar um tempo para se tornar claro. Hobbyistas estão treinando modelos de vídeo gerados por IA para reproduzir os traços de pessoas, utilizando LoRAs baseadas em vídeo no recentemente lançado Hunyuan Video framework da Tencent.*

Clique para reproduzir. Resultados diversos de personalizações baseadas em Hunyuan LoRA disponíveis gratuitamente na comunidade Civit. Ao treinar modelos de adaptação de baixo-rango (LoRAs), os problemas de estabilidade temporal, que atormentaram a geração de vídeo por IA nos últimos dois anos, são significativamente reduzidos. Fontes: civit.ai

No vídeo mostrado acima, as semelhanças das atrizes Natalie Portman, Christina Hendricks e Scarlett Johansson, juntamente com o líder tecnológico Elon Musk, foram treinadas em arquivos de complementos relativamente pequenos para o sistema de vídeo gerado por Hunyuan, que pode ser instalado sem filtros de conteúdo (como filtros NSFW) no computador do usuário.

O criador do LoRA de Christina Hendricks mostrado acima declara que apenas 16 imagens do programa de TV Mad Men foram necessárias para desenvolver o modelo (que é um mero download de 307mb); várias postagens da comunidade Stable Diffusion no Reddit e Discord confirmam que LoRAs desse tipo não requerem grandes quantidades de dados de treinamento, ou longos períodos de treinamento, na maioria dos casos.

Clique para reproduzir. Arnold Schwarzenegger ganha vida em um vídeo LoRA de Hunyuan que pode ser baixado na Civit. Veja ainda mais exemplos do Arnie, do entusiasta da IA Bob Doyle.

LoRAs de Hunyuan podem ser treinadas em imagens estáticas ou vídeos, embora o treinamento em vídeos exija maiores recursos de hardware e aumento do tempo de treinamento.

O modelo Hunyuan Video possui 13 bilhões de parâmetros, superando os 12 bilhões de parâmetros do Sora, e ultrapassando muito o menos capaz modelo Hunyuan-DiT lançado como código aberto no verão de 2024, que possui apenas 1,5 bilhão de parâmetros.

Assim como ocorreu dois anos e meio atrás com o Stable Diffusion e LoRA (veja exemplos das ‘celebridades nativas’ do Stable Diffusion 1.5 aqui), o modelo base em questão possui uma compreensão muito mais limitada das personalidades das celebridades, em comparação com o nível de fidelidade que pode ser obtido através de implementações de LoRA ‘injetadas por ID’.

Basicamente, um LoRA personalizado e focado na personalidade ganha um ‘passe livre’ nas significativas capacidades de síntese do modelo base Hunyuan, oferecendo uma síntese humana notavelmente mais eficaz do que pode ser obtida, seja por deepfakes de autoencoder de 2017 ou por tentativas de adicionar movimento a imagens estáticas por meio de sistemas como o aclamado LivePortrait.

Todos os LoRAs aqui representados podem ser baixados gratuitamente da popular comunidade Civit, enquanto um número mais abundante de LoRAs ‘estáticas’ mais antigas pode também potencialmente criar imagens ‘semente’ para o processo de criação de vídeo (ou seja, de imagem para vídeo, um lançamento pendente para o Hunyuan Video, embora soluções alternativas sejam possíveis, por enquanto).

Clique para reproduzir. Acima, amostras de uma LoRA Flux ‘estática’; abaixo, exemplos de uma LoRA de vídeo Hunyuan com a musicista Taylor Swift. Ambas as LoRAs estão disponíveis gratuitamente na comunidade Civit.

No momento em que escrevo, o site da Civit oferece 128 resultados de busca para ‘Hunyuan’*. Quase todos eles são, de alguma forma, modelos NSFW; 22 representam celebridades; 18 são projetados para facilitar a geração de pornografia hardcore; e apenas sete deles representam homens em vez de mulheres.

Então, O Que Há de Novo?

Devido à natureza em evolução do termo deepfake, e à compreensão pública limitada das (bastante severas) limitações das estruturas de síntese de vídeo humano por IA até agora, a magnitude do Hunyuan LoRA não é fácil de compreender para uma pessoa que acompanha casualmente a cena de IA gerativa. Vamos revisar algumas das principais diferenças entre os Hunyuan LoRAs e abordagens anteriores à geração de vídeo por IA baseadas em identidade.

1: Instalação Local Livre

O aspecto mais importante do Hunyuan Video é o fato de que ele pode ser baixado localmente, colocando um sistema de geração de vídeo por IA muito poderoso e sem censura nas mãos do usuário casual, bem como da comunidade VFX (na medida em que as licenças possam permitir em regiões geográficas).

A última vez que isso aconteceu foi com o lançamento do modelo Stable Diffusion da Stability.ai no verão de 2022. Naquela época, o DALL-E2 da OpenAI havia capturado a imaginação pública, embora o DALL-E2 fosse um serviço pago com restrições notáveis (que cresceram ao longo do tempo).

Quando a Stable Diffusion se tornou disponível, e a Adaptação de Baixo-Rango então tornou possível gerar imagens da identidade de qualquer pessoa (celebridade ou não), o grande foco do interesse de desenvolvedores e consumidores ajudou a Stable Diffusion a eclipsar a popularidade do DALL-E2; embora este último fosse um sistema mais capaz desde o início, seus procedimentos de censura foram considerados onerosos por muitos de seus usuários, e a personalização não era possível.

Argumenta-se que o mesmo cenário agora se aplica entre Sora e Hunyuan – ou, mais precisamente, entre sistemas de vídeo gerados por IA de qualidade Sora, e rivais de código aberto, dos quais Hunyuan é o primeiro – mas provavelmente não o último (aqui, considere que o Flux acabaria ganhando terreno significativo sobre o Stable Diffusion).

Usuários que desejam criar saídas de Hunyuan LoRA, mas que não têm equipamento suficientemente potente, podem, como sempre, transferir o aspecto de GPU do treinamento para serviços de computação online como RunPod. Isso não é o mesmo que criar vídeos de IA em plataformas como Kaiber ou Kling, pois não há filtragem semântica ou de imagens (censura) envolvida ao alugar uma GPU online para apoiar um fluxo de trabalho local de outra forma.

2: Sem Necessidade de Vídeos ‘Host’ e Alto Esforço

Quando os deepfakes surgiram no final de 2017, o código postado anonimamente evoluiu para os forks principais DeepFaceLab e FaceSwap (assim como o sistema de deepfake em tempo real DeepFaceLive).

Esse método requeria a curadoria minuciosa de milhares de imagens faciais de cada identidade a ser trocada; quanto menos esforço fosse feito nessa fase, menor seria a eficácia do modelo. Além disso, os tempos de treinamento variavam entre 2 e 14 dias, dependendo do hardware disponível, sobrecarregando até mesmo sistemas capazes a longo prazo.

Quando o modelo finalmente estava pronto, ele só podia impor rostos em vídeos existentes, e geralmente precisava de uma ‘identidade-alvo’ (ou seja, real) que fosse semelhante em aparência à identidade superposta.

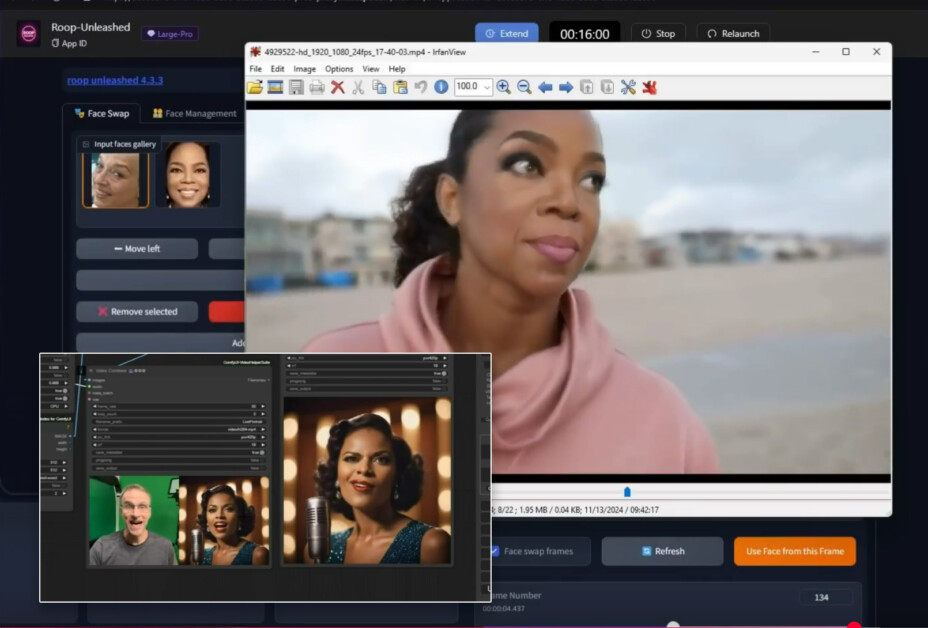

Mais recentemente, ROOP, LivePortrait e inúmeros sistemas similares forneceram funcionalidade semelhante com muito menos esforço, e frequentemente com resultados superiores – mas sem capacidade de gerar deepfakes corporais completos – ou qualquer elemento além de rostos.

Exemplos do ROOP Unleashed e LivePortrait (inserido na parte inferior esquerda), do fluxo de conteúdo de Bob Doyle no YouTube. Fontes: https://www.youtube.com/watch?v=i39xeYPBAAM e https://www.youtube.com/watch?v=QGatEItg2Ns

Em contraste, LoRAs de Hunyuan (e os sistemas semelhantes que inevitavelmente se seguirão) permitem a criação irrestrita de mundos inteiros, incluindo simulação de corpo inteiro da identidade treinada pelo usuário.

3: Consistência Temporal Ampliada

A consistência temporal tem sido o Santo Graal dos vídeos de difusão há vários anos. O uso de um LoRA, juntamente com prompts adequados, oferece à geração de vídeo Hunyuan uma referência de identidade constante para seguir. Em teoria (são os primeiros dias), poderia-se treinar vários LoRAs de uma identidade em particular, cada um usando roupas específicas.

Sob essas circunstâncias, as roupas também são menos propensas a ‘mutar’ ao longo do curso da geração de vídeo (uma vez que o sistema generativo baseia o próximo quadro em uma janela muito limitada de quadros anteriores).

(Alternativamente, como nos sistemas LoRA baseados em imagem, pode-se simplesmente aplicar vários LoRAs, como identidade + LoRAs de fantasia, em uma única geração de vídeo)

4: Acesso ao ‘Experimento Humano’

Como observei recentemente, o setor privativo e de nível FAANG de IA gerativa agora parece estar tão cauteloso em relação a críticas potenciais relacionadas às capacidades de síntese humana de seus projetos, que pessoas reais raramente aparecem nas páginas de projetos para grandes anúncios e lançamentos. Em vez disso, a literatura publicitária relacionada tende cada vez mais a mostrar sujeitos ‘fofos’ e de outra forma ‘não ameaçadores’ nos resultados sintetizados.

Com o advento dos LoRAs de Hunyuan, pela primeira vez, a comunidade tem a oportunidade de ultrapassar os limites da síntese de vídeo humano baseada em LDM em um sistema altamente capaz (em vez de marginal) e explorar completamente o assunto que mais nos interessa – as pessoas.

Implicações

Uma vez que uma busca por ‘Hunyuan’ na comunidade Civit mostra principalmente LoRAs de celebridades e LoRAs ‘hardcore’, a principal implicação do advento dos LoRAs Hunyuan é que eles serão usados para criar vídeos pornográficos (ou de outra forma difamatórios) de pessoas reais – celebridades e desconhecidos.

Para fins de conformidade, os hobbyistas que criam LoRAs Hunyuan e que experimentam em diversos servidores Discord são cuidadosos em proibir exemplos de pessoas reais de serem postados. A realidade é que até mesmo imagens-baseadas deepfakes já estão armadas severamente; e a perspectiva de adicionar vídeos realmente realistas a esse mix pode finalmente justificar os temores elevados que têm aparecido na mídia ao longo dos últimos sete anos, e que provocaram novas regulamentações.

A Força Motivadora

Como sempre, a pornografia permanece a força motriz da tecnologia. Independentemente da nossa opinião sobre esse uso, esse motor implacável de impulso impulsiona os avanços no estado da arte que podem, em última instância, beneficiar a adoção mais mainstream.

Neste caso, é possível que o preço seja mais alto do que o habitual, uma vez que a liberação do vídeo hiperealista tem implicações óbvias para usos criminosos, políticos e éticos.

Um grupo no Reddit (que não citarei aqui) dedicado à geração de vídeo NSFW por IA tem um servidor Discord aberto associado onde os usuários estão refinando fluxos de trabalho ComfyUI para geração de vídeo pornô baseado em Hunyuan. Diariamente, usuários postam exemplos de clipes NSFW – muitos dos quais podem ser razoavelmente considerados ‘extremos’, ou pelo menos ultrapassando as restrições do que está declarado nas regras do fórum.

Essa comunidade também mantém um repositório GitHub substancial e bem desenvolvido que apresenta ferramentas que podem baixar e processar vídeos pornográficos, a fim de fornecer dados de treinamento para novos modelos.

Uma vez que o treinador de LoRA mais popular, Kohya-ss, agora suporta treinamento de Hunyuan LoRA, as barreiras de entrada para o treinamento de vídeo gerado sem limites estão diminuindo a cada dia, assim como os requisitos de hardware para geração de vídeo e treinamento Hunyuan.

O aspecto crucial dos esquemas de treinamento dedicados para IA baseada em pornografia (em vez de modelos baseados em identidade, como celebridades) é que um modelo base padrão como Hunyuan não é especificamente treinado para resultados NSFW, e pode, portanto, apresentar desempenho ruim ao ser solicitado a gerar conteúdo NSFW, ou falhar em desentrelaçar conceitos e associações aprendidas de forma convincente ou performativa.

Desenvolvendo modelos fundacionais e LoRAs específicos para NSFW, será cada vez mais possível projetar identidades treinadas em um domínio dedicado de vídeo ‘pornô’; afinal, isso é apenas a versão em vídeo de algo que já ocorreu para imagens estáticas nos últimos dois anos e meio.

VFX

A enorme melhoria na consistência temporal que os LoRAs de Hunyuan oferecem é um benefício óbvio para a indústria de efeitos visuais de IA, que se baseia muito no software de código aberto.

Embora uma abordagem de LoRA de vídeo Hunyuan gere um quadro e um ambiente inteiros, as empresas de VFX certamente começaram a experimentar a isolação dos rostos humanos temporalmente consistentes que podem ser obtidos por esse método, a fim de superpor ou integrar rostos em imagens de origem do mundo real.

Assim como a comunidade de hobbyistas, as empresas de VFX devem aguardar a funcionalidade de imagem para vídeo e vídeo para vídeo do Hunyuan, que é potencialmente a ponte mais útil entre o conteúdo de ‘deepfake’ baseado em identidade e impulsionado por LoRA; ou improvisar e usar o intervalo para explorar as capacidades externas da estrutura e de potenciais adaptações, e até mesmo forks proprietários internas do Hunyuan Video.

Ainda que os termos de licença para o Hunyuan Video tecnicamente permitam a representação de indivíduos reais, contanto que a permissão seja concedida, eles proíbem seu uso na UE, Reino Unido e na Coreia do Sul. Sob o princípio de ‘o que acontece em Vegas fica em Vegas’, isso não significa necessariamente que o Hunyuan Video não será usado nessas regiões; no entanto, a perspectiva de auditorias externas de dados, para fazer cumprir crescentes regulamentos em torno da IA gerativa, poderia tornar tal uso ilícito arriscado.

Uma outra área potencialmente ambígua dos termos de licença declara:

‘Se, na data de lançamento da versão Tencent Hunyuan, o número de usuários ativos mensais de todos os produtos ou serviços disponibilizados por ou em favor da Licenciante for superior a 100 milhões de usuários ativos mensais no mês calendário anterior, você deve solicitar uma licença da Tencent, que a Tencent pode conceder a você a seu exclusivo critério, e você não está autorizado a exercer qualquer um dos direitos sob este Acordo a menos que a Tencent expressamente conceda esses direitos.’

Essa cláusula é claramente direcionada às inúmeras empresas que provavelmente ‘intermediarão’ o Hunyuan Video para um corpo relativamente não letrado de usuários, e que precisarão incluir a Tencent nas ações, acima de um determinados número de usuários.

Se a redação abrangente também pode cobrir uso indireto (ou seja, através da provisão de saída de efeitos visuais habilitados para Hunyuan em filmes e TV populares) pode precisar de esclarecimento.

Conclusão

Uma vez que o vídeo deepfake existe há muito tempo, seria fácil subestimar a importância do Hunyuan Video LoRA como uma abordagem à síntese de identidade e deepfakes; e supor que os desenvolvimentos atualmente manifestando-se na comunidade Civit, e nos Discords e subreddits relacionados, representam um mero empurrão incremental em direção a uma verdadeira síntese de vídeo humano controlável.

Mais provavelmente, os esforços atuais representam apenas uma fração do potencial do Hunyuan Video para criar deepfakes de corpo inteiro e de ambiente totalmente convincentes; uma vez que a componente de imagem para vídeo seja lançada (rumorado para ocorrer este mês), um nível muito mais granular de poder generativo estará disponível tanto para as comunidades de hobbyistas quanto para profissionais.

Quando a Stability.ai lançou o Stable Diffusion em 2022, muitos observadores não conseguiam determinar por que a empresa simplesmente entregaria o que era, naquele momento, um sistema gerativo tão valioso e poderoso. Com o Hunyuan Video, o motivo do lucro está embutido diretamente na licença – embora possa ser difícil para a Tencent determinar quando uma empresa ativará o esquema de compartilhamento de lucros.

De qualquer forma, o resultado é o mesmo do que foi em 2022: comunidades de desenvolvimento dedicadas se formaram imediatamente e com intenso fervor em torno do lançamento. Algumas das direções que esses esforços tomarão nos próximos 12 meses certamente deverão gerar novas manchetes.

* Até 136 no momento da publicação.

Publicado pela primeira vez na terça-feira, 7 de janeiro de 2025

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…