Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre as principais coberturas em IA do setor. Saiba mais

A Microsoft está investindo no potencial dos pequenos modelos de linguagem (SLMs) com a revelação do rStar-Math, uma nova técnica de raciocínio que pode ser aplicada a modelos pequenos para aumentar seu desempenho em problemas matemáticos usando técnicas de raciocínio — desempenho semelhante, e em alguns casos superior, ao modelo o1-preview da OpenAI.

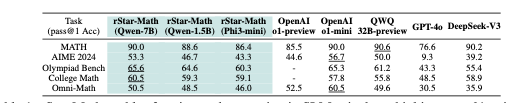

Ainda em fase de pesquisa — conforme descrito em um artigo publicado no site de pré-revisão arXiv.org e creditado a oito autores da Microsoft, Universidade de Peking e Universidade de Tsinghua na China — a técnica foi aplicada a vários modelos menores de código aberto, incluindo o próprio mini Phi-3 da Microsoft, o Qwen-1.5B da Alibaba (um modelo de 1,5 bilhão de parâmetros) e o Qwen-7B (um modelo de 7 bilhões de parâmetros). Ela mostrou desempenho aprimorado em todos eles, superando até mesmo o modelo mais avançado da OpenAI no benchmark de terceiros MATH (resolução de problemas de palavras) com 12.500 perguntas que abrangem várias áreas, como geometria e álgebra, em todos os níveis de dificuldade.

Por fim, segundo uma publicação no Hugging Face, os pesquisadores planejam disponibilizar seu código e dados no Github em https://github.com/microsoft/rStar, embora um dos autores do artigo, Li Lyna Zhang, tenha escrito nos comentários da publicação do Hugging Face que a equipe está “ainda passando pelo processo de revisão interna para lançamento de código aberto.” Assim, “o repositório permanece privado por enquanto. Fique ligado!”

Membros da comunidade expressaram entusiasmo, classificando as inovações como “impressionantes” e elogiando a combinação de Monte Carlo Tree Search (MCTS) com raciocínio passo a passo. Um comentarista destacou a simplicidade e utilidade de usar valores Q para a pontuação dos passos, enquanto outros especularam sobre aplicações futuras em provas geométricas e raciocínio simbólico.

Esta notícia segue de perto a liberação do modelo Phi-4 da Microsoft, um pequeno sistema de IA de 14 bilhões de parâmetros que agora está disponível no Hugging Face sob a licença permissiva MIT.

Embora o lançamento do Phi-4 tenha ampliado o acesso a modelos pequenos de alto desempenho, o rStar-Math apresenta uma abordagem especializada: usar sistemas de IA menores para alcançar resultados de ponta em raciocínio matemático.

O rStar-Math funciona usando vários modelos e componentes para ajudar um modelo pequeno-alvo a ‘auto-evoluir’

A chave para o rStar-Math é que ele aproveita o Monte Carlo Tree Search (MCTS), um método que imita o “pensamento profundo” humano ao refinar iterativamente soluções passo a passo para problemas matemáticos.

Os pesquisadores utilizaram MCTS porque ele “divide problemas matemáticos complexos em tarefas de geração de um único passo mais simples, reduzindo a dificuldade” para modelos menores.

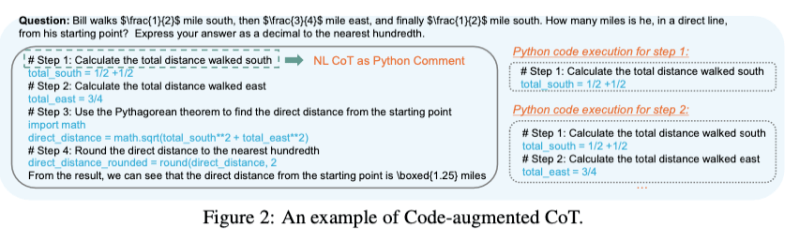

No entanto, eles não aplicaram MCTS da mesma maneira que outros pesquisadores. Em um stroke de genialidade, eles também pedem ao modelo que treinaram para sempre produzir suas etapas de raciocínio “cadeia de pensamento” como descrições em linguagem natural e código Python.

Eles exigiram que o modelo incluísse as respostas em linguagem natural como comentários em código Python, e apenas essas saídas usando Python seriam usadas para treinar o modelo.

Os pesquisadores também treinaram um “modelo de política” para gerar etapas de raciocínio matemático e um modelo de preferência de processo (PPM) para selecionar os passos mais promissores para a resolução dos problemas, melhorando-os em quatro rodadas de “auto-evolução”, com cada modelo melhorando o outro.

Para seus dados iniciais, os pesquisadores afirmaram que usaram “747.000 problemas de palavras matemáticas de fontes publicamente disponíveis,” juntamente com suas soluções, mas geraram novos passos para resolvê-los com os dois modelos descritos acima.

Resultados recordes

Após quatro rodadas de auto-evolução, o rStar-Math alcançou marcos significativos:

• No benchmark MATH, a precisão do modelo Qwen2.5-Math-7B pulou de 58,8% para 90,0%, superando o o1-preview da OpenAI.

• No Exame de Matemática da Convidados Americanos (AIME), ele resolveu 53,3% dos problemas, classificando-se entre os 20% melhores competidores do ensino médio.

Esses resultados ressaltam o poder dos SLMs em lidar com raciocínio matemático complexo, tradicionalmente dominado por sistemas maiores.

Menor é melhor?

Nos últimos anos, a inovação em IA tem sido amplamente impulsionada pelo aumento de modelos de linguagem, com a ampliação de parâmetros vista como uma maneira de melhorar o desempenho. No entanto, os altos custos associados a esses modelos massivos, desde recursos computacionais até consumo de energia, levantaram questões sobre escalabilidade.

A Microsoft está oferecendo um caminho alternativo, focando na eficiência. O lançamento do rStar-Math reforça ainda mais esse compromisso ao demonstrar como os SLMs podem rivalizar — e em alguns casos superar — as capacidades de seus concorrentes maiores.

Os lançamentos duplos do Phi-4 e do artigo rStar da Microsoft sugerem que modelos compactos e especializados podem fornecer alternativas poderosas aos maiores sistemas da indústria.

Além disso, ao superar concorrentes maiores em benchmarks chave, esses modelos desafiam a noção de que maior é sempre melhor. Eles abrem portas para organizações de médio porte e pesquisadores acadêmicos acessarem capacidades de ponta sem o ônus financeiro ou ambiental de modelos massivos.

Insights diários sobre casos de uso empresarial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo que você precisa. Nós trazemos para você as novidades sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…