Participe dos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder do setor em IA. Saiba mais

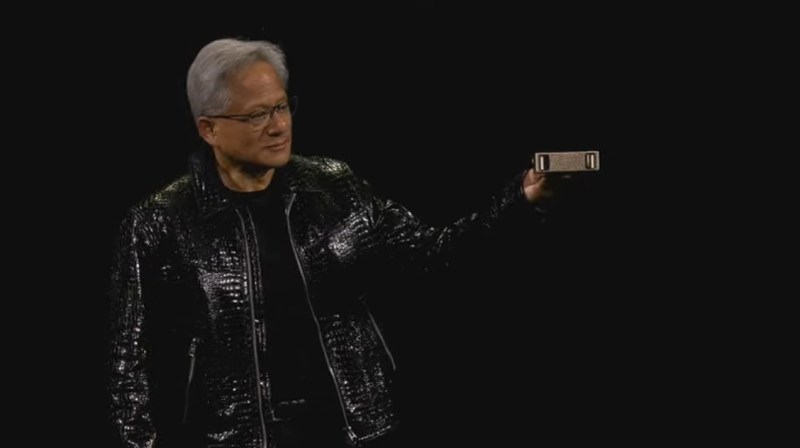

Jensen Huang, CEO da Nvidia, fez uma palestra reveladora na CES 2025 na semana passada. A escolha do tema não poderia ser mais apropriada, considerando que a inteligência artificial, sua especialidade, explodiu em popularidade em todo o mundo, fazendo da Nvidia uma das empresas mais valiosas do mercado. Recentemente, a Apple ultrapassou a Nvidia com uma capitalização de mercado de $3,58 trilhões, contra $3,33 trilhões da Nvidia.

A empresa está celebrando o 25º ano de seu negócio de chips gráficos GeForce e já faz tempo desde minha primeira entrevista com Huang em 1996, quando falamos sobre chips gráficos para um “acelerador Windows”. Naquela época, a Nvidia era uma entre 80 fabricantes de chips gráficos 3D. Agora, é uma entre cerca de três sobreviventes. E ela fez uma grande mudança de foco, passando de gráficos para IA.

Huang não mudou muito. Durante a palestra, ele anunciou uma nova placa de vídeo para jogos, a Nvidia GeForce RTX 50 Series, mas houve uma dúzia de anúncios focados em IA sobre como a Nvidia está criando as bases e plataformas para facilitar o treinamento de robôs para o mundo físico. De fato, em um recurso chamado DLSS 4, a Nvidia usa IA para melhorar as taxas de quadros de seus chips gráficos. E há tecnologias como o Cosmos, que ajuda os desenvolvedores de robôs a usar dados sintéticos para treinar seus robôs. Alguns desses anúncios da Nvidia estavam entre meus 13 favoritos na CES.

Após a palestra, Huang conduziu uma sessão de perguntas e respostas aberta com a imprensa no hotel Fountainbleau, em Las Vegas. No início, ele participou de uma discussão hilária com a equipe de áudio e vídeo na sala sobre a qualidade do som, pois ele não conseguia ouvir as perguntas no palco. Então, ele desceu entre a imprensa e, após brincar com o rapaz da equipe AV chamado Sebastian, respondeu a todas as nossas perguntas, e até tirou uma selfie comigo. Depois, ele atendeu a várias perguntas de analistas financeiros.

Fiquei impressionado com o domínio técnico de Huang sobre a IA durante a palestra, mas me lembrou mais uma conferência técnica da Siggraph do que um discurso principal para consumidores na CES. Questionei-o sobre isso e você pode ver sua resposta abaixo. Incluí a transcrição completa da sessão de perguntas e respostas com toda a imprensa na sala.

Aqui está uma transcrição editada da sessão de perguntas e respostas da imprensa.

Pergunta: No ano passado, você definiu uma nova unidade de computação, o data center. Começando pelo gerenciamento e descendo até o sistema agora. É hora de a Nvidia começar a pensar sobre infraestrutura, energia e as outras peças que entram nesse sistema?

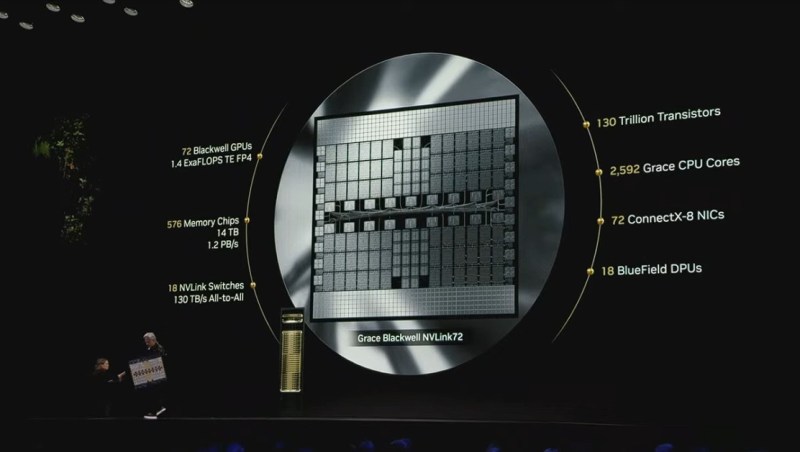

Jensen Huang: Como regra, a Nvidia – só trabalhamos em coisas que outras pessoas não fazem, ou que podemos fazer de forma singularmente melhor. É por isso que não estamos em muitos negócios. A razão pela qual fazemos o que fazemos, se não tivéssemos construído o NVLink72, quem o teria feito? Quem poderia? Se não tivéssemos construído o tipo de switches como o Spectrum-X, este switch de ethernet que tem os benefícios do InfiniBand, quem poderia? Quem teria? Queremos que nossa empresa permaneça relativamente pequena. Somos apenas 30 e poucos mil pessoas. Ainda somos uma empresa pequena. Queremos garantir que nossos recursos sejam altamente focados em áreas onde podemos fazer uma contribuição única.

Trabalhamos em toda a cadeia de suprimentos agora. Trabalhamos com entrega e condicionamento de energia, com as pessoas que estão fazendo isso, resfriamento e assim por diante. Tentamos trabalhar em toda a cadeia de suprimentos para preparar as pessoas para essas soluções de IA que estão chegando. Os hyperscale trabalharam em cerca de 10 kilowatts por rack. O Hopper está entre 40 e 50 a 60 kilowatts por rack. Agora, o Blackwell é de cerca de 120 kilowatts por rack. Minha sensação é que isso continuará aumentando. Queremos que aumente porque a densidade de energia é uma coisa boa. Preferimos ter computadores que sejam densos e próximos, em vez de computadores que estejam desagregados e espalhados por todo o lugar. Densidade é boa. Vamos ver essa densidade de energia aumentar. Faremos um trabalho muito melhor de resfriamento dentro e fora do data center, muito mais sustentável. Há muito trabalho a ser feito. Tentamos não fazer coisas que não precisamos.

Pergunta: Você fez muitos anúncios sobre PCs de IA na noite passada. A adoção desses ainda não decolou. O que está segurando isso? Você acha que a Nvidia pode ajudar a mudar isso?

Huang: A IA começou na nuvem e foi criada para a nuvem. Se você olhar para todo o crescimento da Nvidia nos últimos anos, foi impulsionado pela nuvem, porque são necessários supercomputadores de IA para treinar os modelos. Esses modelos são bastante grandes. É fácil implantá-los na nuvem. Eles são chamados de endpoints, como você sabe. Acreditamos que ainda existem designers, engenheiros de software, criativos e entusiastas que gostariam de usar seus PCs para todas essas tarefas. Um desafio é que, como a IA está na nuvem, e há tanta energia e movimento na nuvem, ainda há muito poucos desenvolvedores criando IA para o Windows.

Acontece que o PC com Windows é perfeitamente adaptado para IA. Há algo chamado WSL2. O WSL2 é uma máquina virtual, um segundo sistema operacional, baseado em Linux, que fica dentro do Windows. O WSL2 foi criado para ser essencialmente nativo na nuvem. Ele suporta contêineres do Docker. Tem suporte perfeito para CUDA. Vamos pegar a tecnologia de IA que estamos criando para a nuvem e agora, garantindo que o WSL2 possa suportá-la, podemos trazer a nuvem para o PC. Acho que essa é a resposta certa. Estou empolgado com isso. Todos os OEMs de PC estão empolgados com isso. Vamos preparar todos esses PCs com Windows e WSL2. Toda a energia e movimento da nuvem de IA, vamos trazê-la diretamente para o PC.

Pergunta: Na noite passada, em certas partes da palestra, parecia um evento da SIGGRAPH. Foi muito técnico. Você alcançou um público maior agora. Eu me perguntei se você poderia explicar um pouco da importância dos desenvolvimentos que foram anunciados na noite passada, os anúncios de IA, para esse público mais amplo que não tem ideia do que você estava falando ontem à noite.

Huang: Como você sabe, a Nvidia é uma empresa de tecnologia, não uma empresa de consumo. Nossa tecnologia influencia e vai impactar o futuro da eletrônica de consumo. Mas não muda o fato de que eu poderia ter feito um trabalho melhor explicando a tecnologia. Aqui está outra oportunidade para eu tentar.

Uma das coisas mais importantes que anunciamos ontem foi um modelo fundamental que entende o mundo físico. Assim como o GPT foi um modelo fundamental que entende a linguagem, e a Stable Diffusion foi um modelo fundamental que entendia imagens, criamos um modelo fundamental que entende o mundo físico. Ele compreende coisas como fricção, inércia, gravidade, presença e permanência de objetos, entendimento geométrico e espacial. Coisas que as crianças sabem. Eles compreendem o mundo físico de uma maneira que os modelos de linguagem hoje não compreendem. Acreditamos que precisa haver um modelo fundamental que entenda o mundo físico.

Uma vez que criamos isso, todas as coisas que você poderia fazer com o GPT e a Stable Diffusion, você pode fazer agora com o Cosmos. Por exemplo, você pode conversar com ele. Você pode fazer perguntas a este modelo do mundo e dizer: “O que há no mundo agora?” Com base na estação, ele diria: “Há muitas pessoas sentadas em uma sala em frente a mesas. O desempenho acústico não é muito bom.” Coisas dessa natureza. O Cosmos é um modelo de mundo, e ele entende o mundo.

A pergunta é: por que precisamos de algo assim? A razão é que, se você quer que a IA consiga operar e interagir de forma sensata no mundo físico, precisa ter uma IA que compreenda isso. Onde você pode usar isso? Carros autônomos precisam entender o mundo físico. Robôs precisam entender o mundo físico. Esses modelos são o ponto de partida para permitir tudo isso. Assim como o GPT possibilitou tudo o que estamos vivenciando hoje, assim como o Llama é muito importante para as atividades em torno da IA, assim como a Stable Diffusion desencadeou todos esses modelos de imagem e vídeo generativos, gostaríamos de fazer o mesmo com o Cosmos, o modelo do mundo.

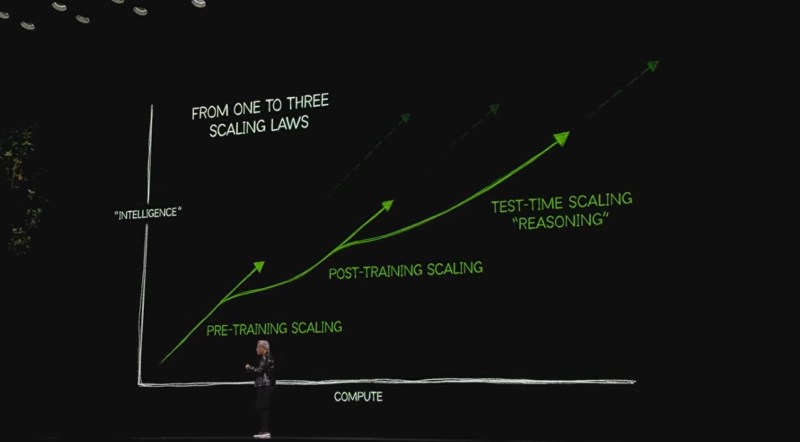

Pergunta: Ontem à noite você mencionou que estamos vendo algumas novas leis de escalonamento de IA surgirem, especificamente em relação ao computacional em tempo de teste. O modelo O3 da OpenAI mostrou que aumentar a inferência é muito caro do ponto de vista computacional. Algumas dessas execuções custaram milhares de dólares no teste ARC-AGI. O que a Nvidia está fazendo para oferecer chips de inferência em IA mais econômicos e, mais amplamente, como você está posicionado para se beneficiar do escalonamento em tempo de teste?

Huang: A solução imediata para o computacional em tempo de teste, tanto em desempenho quanto em acessibilidade, é aumentar nossas capacidades computacionais. É por isso que o Blackwell e o NVLink72 – o desempenho de inferência é provavelmente 30 ou 40 vezes maior que o do Hopper. Ao aumentar o desempenho em 30 ou 40 vezes, você está reduzindo o custo em 30 ou 40 vezes. O data center custa aproximadamente o mesmo.

A razão pela qual a Lei de Moore é tão importante na história da computação é que ela reduziu os custos computacionais. A razão pela qual falei sobre o desempenho de nossas GPUs aumentando em 1.000 ou 10.000 vezes ao longo dos últimos 10 anos é que, ao fazer isso, estamos dizendo que reduzimos o custo em 1.000 ou 10.000 vezes. Nos últimos 20 anos, reduzimos o custo marginal da computação em 1 milhão de vezes. O aprendizado de máquina se tornou possível. A mesma coisa vai acontecer com a inferência. Quando aumentamos o desempenho, o custo da inferência diminuirá.

A segunda maneira de pensar sobre essa pergunta: hoje, leva muitas iterações do computacional em tempo de teste, escalonamento em tempo de teste, para raciocinar sobre a resposta. Essas respostas se tornam os dados para a próxima vez, pós-treinamento. Esses dados se tornam os dados para a próxima vez, pré-treinamento. Todos os dados que estão sendo coletados vão para o pool de dados para pré-treinamento e pós-treinamento. Vamos continuar empurrando isso para o processo de treinamento, porque é mais barato ter um supercomputador se tornando mais inteligente e treinando o modelo para que o custo de inferência de todos diminua.

No entanto, isso leva tempo. Todas essas três leis de escalonamento vão acontecer por um tempo. Elas acontecerão simultaneamente, independentemente de tudo. Vamos tornar todos os modelos mais inteligentes com o tempo, mas as pessoas vão fazer perguntas cada vez mais difíceis, pedindo que os modelos façam coisas mais inteligentes. O escalonamento em tempo de teste vai aumentar.

Pergunta: Você pretende aumentar ainda mais seu investimento em Israel?

Huang: Recrutamos talentos altamente qualificados de quase todos os lugares. Acredito que há mais de um milhão de currículos no site da Nvidia de pessoas interessadas em uma posição. A empresa emprega apenas 32.000 pessoas. O interesse em se juntar à Nvidia é bastante alto. O trabalho que fazemos é muito interessante. Temos uma opção muito grande para crescer em Israel.

Quando compramos a Mellanox, acredito que eles tinham 2.000 funcionários. Agora temos quase 5.000 funcionários em Israel. Provavelmente somos a empresa que mais cresce em Israel. Estou muito orgulhoso disso. A equipe é incrível. Através de todos os desafios em Israel, a equipe permaneceu muito focada. Eles fazem um trabalho incrível. Durante esse tempo, nossa equipe em Israel criou o NVLink. Nossa equipe em Israel criou o Spectrum-X e o Bluefield-3. Tudo isso aconteceu nos últimos anos. Estou incrivelmente orgulhoso da equipe. Mas não temos negócios a anunciar hoje.

Pergunta: A geração multi-frame ainda está fazendo renderização de dois quadros e, em seguida, gerando entre eles? Além disso, com a compressão de texturas e o material neural RTX, isso é algo que os desenvolvedores de jogos precisarão adotar especificamente, ou pode ser feito do lado do driver para beneficiar um número maior de jogos?

Huang: Haverá um briefing detalhado a respeito. Vocês devem participar disso. Mas o que fizemos com o Blackwell, adicionamos a capacidade ao processador de shader para processar redes neurais. Você pode colocar código e intercalar com uma rede neural na pipeline do shader. A razão pela qual isso é tão importante é porque texturas e materiais são processados no shader. Se o shader não puder processar IA, você não aproveitará os benefícios de alguns dos avanços algorítmicos que estão disponíveis por meio de redes neurais, como, por exemplo, compressão. Você poderia comprimir texturas muito melhor hoje do que os algoritmos que temos utilizado nos últimos 30 anos. A relação de compressão pode ser dramaticamente aumentada. O tamanho dos jogos é tão grande atualmente. Quando podemos comprimir essas texturas em mais 5X, isso é uma grande vantagem.

Próximo, materiais. A forma como a luz viaja através de um material, suas propriedades anisotrópicas, fazem com que ela reflita a luz de uma maneira que indica se é tinta dourada ou ouro. A maneira como a luz reflete e refrata através de sua estrutura microscópica e atômica faz com que os materiais tenham essas propriedades. Descrever isso matematicamente é muito difícil, mas podemos aprender usando IA. Materiais neurais serão totalmente inovadores. Isso trará vitalidade e realismo à computação gráfica. Ambos requerem trabalho do lado do conteúdo. Claro que é conteúdo. Os desenvolvedores precisarão desenvolver seu conteúdo dessa forma, e então poderão incorporar essas coisas.

Em relação ao DLSS, a geração de quadros não é interpolação. É literalmente geração de quadros. Estamos prevendo o futuro, não interpolando o passado. A razão para isso é que estamos tentando aumentar a taxa de quadros. O DLSS 4, como você sabe, é completamente inovador. Certifique-se de conferi-lo.

Pergunta: Há uma grande diferença entre o 5090 e o 5080. O 5090 tem mais de duas vezes o número de núcleos que o 5080, e mais do que o dobro do preço. Por que você está criando uma distância tão grande entre os dois?

Huang: Quando alguém quer ter o melhor, eles vão pelo melhor. O mundo não tem tantos segmentos. A maioria dos nossos usuários quer o melhor. Se formos dar a eles um pouco menos do que o melhor para economizar $100, eles não aceitarão isso. Eles querem apenas o melhor.

Claro, $2.000 não é uma quantia pequena. É um alto valor. Mas essa tecnologia vai para o seu ambiente de PC de home theater. Você já pode ter investido $10.000 em telas e alto-falantes. Você quer a melhor GPU lá. Muitos de seus clientes simplesmente querem o melhor.

Pergunta: Com o PC de IA se tornando cada vez mais importante para os jogos de PC, você imagina um futuro onde não haverá mais quadros renderizados tradicionalmente?

Huang: Não. A razão para isso é porque – lembre-se de quando o ChatGPT foi lançado e as pessoas disseram: “Oh, agora podemos gerar livros inteiros”? Mas ninguém dentro da empresa esperava isso. É chamado de condicionamento. Agora condicionalizamos o chat, ou os prompts, com contexto. Antes que você possa entender uma pergunta, tem que entender o contexto. O contexto pode ser um PDF, uma pesquisa na web ou exatamente o que você disse que é o contexto. A mesma coisa acontece com imagens. Você deve dar um contexto a ele.

O contexto em um videogame precisa ser relevante, e não apenas do ponto de vista da história, mas também relevante espacialmente, relevante para o mundo. Quando você condiciona e dá contexto, você fornece algumas peças iniciais de geometria ou algumas peças iniciais de textura. Ele pode gerar e aumentar a resolução a partir daí. O condicionamento, o grounding, é a mesma coisa que você faria com o ChatGPT e o contexto lá. Em uso empresarial, é chamado de RAG, recuperação de geração aumentada. No futuro, os gráficos 3D serão uma geração ancorada e condicionada.

Vamos dar uma olhada no DLSS 4. De 33 milhões de pixels em quatro quadros – renderizamos um e geramos três – renderizamos 2 milhões. Não é incrível? Nós literalmente renderizamos dois e geramos 31. A razão pela qual isso é tão importante – aqueles 2 milhões de pixels precisam ser renderizados nos pontos certos. A partir desse condicionamento, podemos gerar os outros 31 milhões. Não só isso é surpreendente, mas esses 2 milhões de pixels podem ser renderizados lindamente. Podemos aplicar uma grande quantidade de computação porque a computação que teríamos aplicado aos outros 31 milhões, agora a canalizamos e direcionamos apenas para os 2 milhões. Esses 2 milhões de pixels são incrivelmente complexos, e eles podem inspirar e informar os outros 31.

A mesma coisa acontecerá em jogos no futuro. Acabei de descrever o que acontecerá não apenas com os pixels que renderizamos, mas com a geometria que renderizamos, a animação que renderizamos e assim por diante. O futuro dos videogames, agora que a IA está integrada à computação gráfica – esse sistema de renderização neural que criamos é agora senso comum. Levou cerca de seis anos. Na primeira vez que anunciei o DLSS, foi universalmente desacreditado. Parte disso é porque não fizemos um trabalho muito bom de explicação. Mas levou tanto tempo para que todos percebessem agora que a IA generativa é o futuro. Você só precisa condicioná-la e fundamentá-la com a intenção do artista.

Fizemos o mesmo com o Omniverse. A razão pela qual o Omniverse e o Cosmos estão conectados é porque o Omniverse é o motor 3D para o Cosmos, o motor generativo. Temos controle completo no Omniverse, e agora podemos controlar o quanto quisermos, o menos que pudermos, para que possamos gerar o máximo possível. O que acontece quando controlamos menos? Então podemos simular mais. O mundo que agora podemos simular no Omniverse pode ser gigantesco, porque temos um motor generativo do outro lado tornando-o bonito.

Pergunta: Você vê as GPUs da Nvidia começando a lidar com a lógica em futuros jogos com computação de IA? É um objetivo trazer tanto gráficos quanto lógica para a GPU por meio da IA?

Huang: Sim. Absolutamente. Lembre-se, a GPU é Blackwell. O Blackwell pode gerar texto, linguagem. Uma IA agente completa, um robô completo, pode rodar no Blackwell. Assim como roda na nuvem ou no carro, podemos executar todo o loop robótico dentro do Blackwell. Assim como podemos fazer dinâmica de fluidos ou física de partículas no Blackwell. O CUDA é exatamente o mesmo. A arquitetura da Nvidia é exatamente a mesma no robô, no carro, na nuvem, no sistema de jogos. Essa foi uma boa decisão que tomamos. Os desenvolvedores de software precisam ter uma plataforma comum. Quando eles criam algo, eles querem saber que podem executá-lo em todos os lugares.

Ontem, eu disse que vamos criar a IA na nuvem e executá-la no seu PC. Quem mais pode dizer isso? É exatamente compatível com CUDA. O contêiner na nuvem, podemos baixá-lo e executá-lo no seu PC. O SDXL NIM vai ser fantástico. O FLUX NIM? Fantástico. Llama? Apenas pegue da nuvem e execute no seu PC. A mesma coisa acontecerá nos jogos.

Pergunta: Não há dúvida sobre a demanda por seus produtos de hyperscalers. Mas você pode elaborar sobre quanto de urgência sente em ampliar sua base de receita para incluir empresas, incluir governos e construir seus próprios data centers? Especialmente quando clientes como a Amazon estão procurando construir seus próprios chips de IA. Em segundo lugar, você poderia elaborar mais sobre como está vendo o desenvolvimento empresarial?

Huang: Nossa urgência vem de servir nossos clientes. Nunca me pesou que alguns de meus clientes também estão construindo outros chips. Estou contente que eles estejam construindo na nuvem e acho que estão fazendo excelentes escolhas. Nosso ritmo tecnológico, como você sabe, é incrivelmente rápido. Quando aumentamos o desempenho a cada ano em um fator de dois, estamos reduzindo essencialmente os custos em um fator de dois a cada ano. Isso é muito mais rápido do que a Lei de Moore em seu melhor momento. Vamos responder aos clientes onde quer que estejam.

No que diz respeito às empresas, o importante é que as empresas hoje são atendidas por duas indústrias: a indústria de software, ServiceNow e SAP, e assim por diante, e os integradores de soluções que ajudam a adaptar esse software aos seus processos de negócios. Nossa estratégia é trabalhar com esses dois ecossistemas e ajudar a construir IA agente. O NeMo e os blueprints são as ferramentas para construir IA agente. O trabalho que estamos fazendo com a ServiceNow, por exemplo, é simplesmente fantástico. Eles terão toda uma família de agentes que se posicionam acima da ServiceNow para ajudar no suporte ao cliente. Essa é nossa estratégia básica. Com os integradores de soluções, estamos trabalhando com a Accenture e outros – a Accenture está fazendo um trabalho crítico para ajudar os clientes a integrar e adotar a IA agente em seus sistemas.

O primeiro passo é ajudar todo esse ecossistema a desenvolver IA, o que é diferente de desenvolver software. Eles precisam de um kit de ferramentas diferente. Acho que fizemos um bom trabalho no ano passado construindo o kit de ferramentas de IA agente e agora é sobre implantação, e assim por diante.

Pergunta: Foi emocionante ver a noite passada o 5070 e a queda de preço. Eu sei que é cedo, mas o que podemos esperar das placas da série 60, especialmente na faixa de menos de $400?

Huang: É incrível que anunciamos quatro RTX Blackwells na noite passada, e o de menor desempenho tem o desempenho da GPU mais poderosa do mundo hoje. Isso coloca em perspectiva as incríveis capacidades da IA. Sem IA, sem os núcleos tensor e toda a inovação em torno do DLSS 4, essa capacidade não seria possível. Não tenho nada para anunciar. Existe um 60? Não sei. É um dos meus números favoritos, porém.

Pergunta: Você falou sobre IA agente. Muitas empresas já falaram sobre IA agente agora. Como você está trabalhando ou competindo com empresas como AWS, Microsoft, Salesforce que têm plataformas nas quais também estão dizendo aos clientes para desenvolver agentes? Como você está trabalhando com eles?

Huang: Não somos uma empresa que vai diretamente para as empresas. Somos uma empresa de plataforma tecnológica. Desenvolvemos os kits de ferramentas, bibliotecas e modelos de IA, para as ServiceNows. Essa é nossa prioridade. Nosso foco principal é a ServiceNow, SAP e Oracle e Synopsys e Cadence e Siemens, as empresas que têm uma grande quantidade de expertise, mas a camada de biblioteca da IA não é uma área em que eles queiram se concentrar. Podemos criar isso para eles.

É complicado, porque essencialmente estamos falando sobre colocar um ChatGPT em um contêiner. Esse ponto de extremidade, esse microsserviço, é muito complicado. Quando eles usam o nosso, podem executá-lo em qualquer plataforma. Nós desenvolvemos a tecnologia, NIMs e NeMo, para eles. Não para competir com eles, mas para eles. Se algum dos nossos CSPs quiser usar, e muitos dos nossos CSPs já o fizeram – usando NeMo para treinar seus modelos de linguagem grande ou treinar seus modelos de motor – eles têm NIMs em suas lojas de nuvem. Criamos toda essa camada de tecnologia para eles.

A maneira de pensar sobre NIMs e NeMo é como pensar sobre CUDA e as bibliotecas CUDA-X. As bibliotecas CUDA-X são importantes para a adoção da plataforma Nvidia. Essas são coisas como cuBLAS para álgebra linear, cuDNN para o motor de rede neural profunda que revolucionou o aprendizado profundo, CUTLASS, todas essas bibliotecas elegantes das quais temos falado. Criamos essas bibliotecas para a indústria para que eles não precisem. Estamos criando NeMo e NIMs para a indústria para que eles não precisem.

Pergunta: Quais você acha que são algumas das maiores necessidades não atendidas no mercado de PCs não relacionados a jogos atualmente?

Huang: O DIGITS significa Sistema de Treinamento de Inteligência de GPU para Aprendizado Profundo. É isso que é. O DIGITS é uma plataforma para cientistas de dados. O DIGITS é uma plataforma para cientistas de dados, engenheiros de aprendizado de máquina. Hoje, eles estão usando seus PCs e estações de trabalho para isso. Para a maioria dos PCs das pessoas, fazer aprendizado de máquina e ciência de dados, executar PyTorch e o que quer que seja, não é ideal. Agora temos esse pequeno dispositivo que você coloca em sua mesa. É sem fio. A maneira como você se comunica com ele é a maneira como você se comunica com a nuvem. É como sua própria nuvem de IA privada.

A razão pela qual você deseja isso é porque, se estiver trabalhando em sua máquina, você sempre estará nessa máquina. Se você estiver trabalhando na nuvem, estará sempre na nuvem. A conta pode ser muito alta. Tornamos possível ter essa nuvem de desenvolvimento pessoal. É para cientistas de dados, estudantes e engenheiros que precisam estar em sistema o tempo todo. Acho que o DIGITS – há um universo inteiro esperando pelo DIGITS. Faz muito sentido, porque a IA começou na nuvem e terminou na nuvem, mas deixou os computadores do mundo para trás. Precisamos apenas descobrir algo para atender a esse público.

Pergunta: Você falou ontem sobre robôs que em breve estarão por toda parte ao nosso redor. De que lado você acha que os robôs estarão – com os humanos ou contra eles?

Huang: Com os humanos, porque vamos construí-los dessa forma. A ideia de superinteligência não é incomum. Como você sabe, tenho uma empresa com muitas pessoas que são, para mim, superinteligentes em suas áreas de trabalho. Estou cercado por superinteligência. Prefiro estar cercado por superinteligência em vez da alternativa. Adoro o fato de que minha equipe, os líderes e os cientistas de nossa empresa, são superinteligentes. Sou de inteligência média, mas estou cercado por superinteligência.

Esse é o futuro. Você terá IAs superinteligentes que lhe ajudarão a escrever, analisar problemas, planejar a cadeia de suprimentos, escrever software, projetar chips, e assim por diante. Eles construirão campanhas de marketing ou o ajudarão a fazer podcasts. Você terá superinteligência ajudando você a fazer muitas coisas, e estará lá o tempo todo. Claro, a tecnologia pode ser usada de várias maneiras. São os humanos que são prejudiciais. Máquinas são máquinas.

Pergunta: Em 2017, a Nvidia exibiu um carro de demonstração na CES, um carro autônomo. Você fez uma parceria com a Toyota em maio. Qual é a diferença entre 2017 e 2025? Quais foram os problemas em 2017 e quais inovações tecnológicas estão sendo feitas em 2025?

Huang: Primeiro de tudo, tudo que se move no futuro será autônomo, ou terá capacidades autônomas. Não haverá mais cortadores de grama que você empurra. Quero ver, em 20 anos, alguém empurrando um cortador de grama. Isso seria muito divertido de ver. Não faria sentido. No futuro, todos os carros – você ainda pode decidir dirigir, mas todos os carros terão a capacidade de se dirigir sozinhos. De onde estamos hoje, que é 1 bilhão de carros na estrada e nenhum deles dirigindo sozinho, até – vamos dizer, pegando nosso tempo favorito, 20 anos a partir de agora. Acredito que os carros serão capazes de se dirigir sozinhos. Cinco anos atrás, isso era menos certo, quão robusta a tecnologia seria. Agora é muito certo que a tecnologia de sensores, a tecnologia computacional, a tecnologia de software estão ao alcance. Há muita evidência agora de que uma nova geração de carros, particularmente carros elétricos, quase todos terão capacidade autônoma, terão capacidades autônomas.

Se houver dois motoristas que realmente mudaram a mentalidade das empresas de automóveis tradicionais, um é, claro, a Tesla. Eles foram muito influentes. Mas o maior impacto é a incrível tecnologia que vem da China. As neo-evs, as novas empresas de veículos elétricos – BYD, Li Auto, XPeng, Xiaomi, NIO – sua tecnologia é tão boa. A capacidade do veículo autônomo é tão boa. Agora está se espalhando para o resto do mundo. Colocou a barra muito alta. Cada fabricante de automóveis precisa pensar sobre veículos autônomos. O mundo está mudando. Levou um tempo para a tecnologia amadurecer e nossa própria sensibilidade amadurecer. Acredito que agora estamos prontos. A Waymo é uma grande parceira nossa. A Waymo agora está em todo lugar em San Francisco.

Pergunta: Sobre os novos modelos que foram anunciados ontem, Cosmos e NeMo e assim por diante, esses farão parte de óculos inteligentes? Dada a direção que a indústria está tomando, parece que esse será um lugar onde muitas pessoas experimentarão agentes de IA no futuro?

Huang: Estou muito animado com os óculos inteligentes que estão conectados à IA na nuvem. O que estou vendo? Como devo chegar de aqui até lá? Você pode estar lendo e isso pode ajudá-lo a ler. O uso de IA à medida que se conecta a dispositivos vestíveis e tecnologia de presença virtual com óculos, tudo isso é muito promissor.

A maneira como usamos o Cosmos, o Cosmos na nuvem lhe dará penetração visual. Se você quiser algo nos óculos, usa o Cosmos para destilar um modelo menor. O Cosmos se torna um motor de transferência de conhecimento. Ele transfere seu conhecimento para um modelo de IA muito menor. A razão pela qual você pode fazer isso é porque esse modelo de IA menor se torna altamente focado. Ele é menos generalizável. Essa é a razão pela qual é possível transferir conhecimento de forma direcionada e destilar isso em um modelo muito menor. Essa também é a razão pela qual sempre começamos construindo o modelo fundamental. Então, podemos construir um menor e um menor através desse processo de destilação. Modelos de professor e aluno.

Pergunta: O 5090 anunciado ontem é uma ótima placa, mas um dos desafios em fazer a renderização neural funcionar é o que será feito com o Windows e o DirectX. Que tipo de trabalho você está procurando realizar para ajudar as equipes a minimizar a fricção em termos de implementação em motores, e também incentivando a Microsoft a trabalhar com você para garantir que melhorem o DirectX?

Huang: Onde quer que novas evoluções da API DirectX estejam, a Microsoft tem sido super colaborativa ao longo dos anos. Temos um ótimo relacionamento com a equipe do DirectX, como você pode imaginar. À medida que avançamos nossas GPUs, se a API precisar mudar, eles são muito receptivos. Para a maioria das coisas que fazemos com DLSS, a API não precisa mudar. Na verdade, é o motor que precisa mudar. Semânticamente, ele precisa entender a cena. A cena é muito mais interna ao Unreal ou Frostbite, o motor do desenvolvedor. Essa é a razão pela qual o DLSS está integrado a muitos dos motores hoje. Uma vez que a infraestrutura do DLSS foi estabelecida, particularmente começando com DLSS 2, 3 e 4, então, quando atualizarmos o DLSS 4, mesmo que o jogo tenha sido desenvolvido para 3, você terá alguns dos benefícios de 4 e assim por diante. A infraestrutura para as AIs que entendem a cena, as AIs que processam com base na informação semântica na cena, você realmente precisa fazer isso no motor.

Pergunta: Todas essas grandes transições tecnológicas nunca são feitas por uma única empresa. Com a IA, você acha que há algo faltando que está nos segurando, alguma parte do ecossistema?

Huang: Eu faço. Deixe-me dividir em duas partes. Em um caso, no caso da linguagem, no caso da IA cognitiva, claro que estamos avançando a capacidade cognitiva da IA, a capacidade básica. Tem que ser multimodal. Tem que conseguir fazer seu próprio raciocínio e assim por diante. Mas a segunda parte é aplicar essa tecnologia em um sistema de IA. A IA não é um modelo. É um sistema de modelos. A IA agente é uma integração de um sistema de modelos. Há um modelo para recuperação, para busca, para geração de imagens, para raciocínio. É um sistema de modelos.

Nos últimos anos, a indústria tem inovado ao longo do caminho aplicado, não apenas ao longo do caminho fundamental. O caminho fundamental da IA é para multimodalidade, raciocínio e assim por diante. Enquanto isso, existe um buraco, algo faltando que é necessário para que a indústria acelere seu processo. Isso é a IA física. A IA física precisa do mesmo modelo fundamental, o conceito de um modelo fundamental, assim como a IA cognitiva precisou de um modelo fundamental clássico. O GPT-3 foi o primeiro modelo fundamental que alcançou um nível de capacidade que iniciou uma série de capacidades. Precisamos alcançar uma capacidade de modelo fundamental para a IA física.

É por isso que estamos trabalhando no Cosmos, para que possamos chegar a esse nível de capacidade, colocar esse modelo no mundo e assim, de repente, uma série de casos de uso finais começará, tarefas a montante, habilidades a montante que são ativadas como resultado de ter um modelo fundamental. Esse modelo fundamental também pode ser um modelo de ensino, conforme falávamos anteriormente. Esse modelo fundamental é a razão pela qual construímos o Cosmos.

A segunda coisa que está faltando no mundo é o trabalho que estamos fazendo com o Omniverse e o Cosmos para conectar os dois sistemas, de modo que seja uma condição física, fundamentada em física, para que possamos usar esse conhecimento para controlar o processo gerativo. O que sai do Cosmos é altamente plausível, não apenas altamente alucinatório. Cosmos mais Omniverse é o ponto de partida inicial que provavelmente dará origem a uma indústria de robótica muito grande no futuro. É a razão pela qual a construímos.

Pergunta: Quão preocupado você está com o comércio e as tarifas e o que isso pode representar para todos?

Huang: Não estou preocupado com isso. Confio que a administração tomará as decisões corretas para suas negociações comerciais. O que quer que se resolva, faremos o melhor que pudermos para ajudar nossos clientes e o mercado.

Pergunta de acompanhamento inaudível.

Huang: Só trabalhamos em coisas se o mercado precisa de nós, se houver um buraco no mercado que precisa ser preenchido e estamos destinados a preenchê-lo. Tendemos a trabalhar em coisas que estão muito à frente do mercado, onde se não fizermos algo, não será feito. Essa é a psicologia da Nvidia. Não faça o que outras pessoas fazem. Não somos cuidadores de mercado. Somos criadores de mercado. Tendemos a não entrar em um mercado que já existe e pegar nosso pedaço. Essa não é a psicologia de nossa empresa.

A psicologia da nossa empresa, se houver um mercado que não existe – por exemplo, não há nada como o DIGITS no mundo. Se não construirmos o DIGITS, ninguém no mundo vai construir o DIGITS. A pilha de software é muito complicada. As capacidades computacionais são muito significativas. A menos que façamos isso, ninguém vai fazer. Se não avançássemos os gráficos neurais, ninguém o teria feito. Tivemos que fazê-lo. Tendemos a agir assim.

Pergunta: Você acha que a maneira como a IA está crescendo neste momento é sustentável?

Huang: Sim. Não há limites físicos que eu conheça. Como você sabe, uma das razões pelas quais somos capazes de avançar nas capacidades da IA tão rapidamente é que temos a capacidade de construir e integrar nosso CPU, GPU, NVLink, rede e todo o software e sistemas ao mesmo tempo. Se isso tivesse que ser feito por 20 empresas diferentes e tivéssemos que integrar tudo, o tempo levaria muito. Quando temos tudo integrado e suportado por software, podemos avançar rapidamente esse sistema. Com Hopper, H100 e H200 ao próximo e ao próximo, seremos capazes de nos mover a cada ano.

A segunda coisa é que, porque somos capazes de otimizar em todo o sistema, o desempenho que podemos alcançar é muito mais do que apenas transistores. A Lei de Moore desacelerou. O desempenho do transistor não está aumentando muito de geração para geração. Mas nossos sistemas como um todo aumentaram exponencialmente de desempenho de ano para ano. Não vejo razões físicas que impeçam que continuemos a avançar na computação. A IA vai avançar muito rapidamente.

À medida que avançamos em nosso computacional, os modelos continuarão avançando. Se aumentarmos a capacidade computacional, os pesquisadores poderão treinar com modelos maiores, com mais dados. Podemos aumentar sua capacidade computacional para a segunda lei de escalonamento, o aprendizado por reforço e a geração de dados sintéticos. Isso continuará a escalar. A terceira lei de escalonamento, o escalonamento em tempo de teste – se continuarmos a aumentar a capacidade computacional, o custo continuará a diminuir, e a lei de escalonamento disso também continuará a crescer. Temos três leis de escalonamento agora. Temos montanhas de dados que podemos processar. Não vejo razões físicas que impeçam que continuemos a avançar na computação. A IA vai progredir muito rapidamente.

Pergunta: A Nvidia ainda estará construindo uma nova sede em Taiwan?

Huang: Temos muitos funcionários em Taiwan e o prédio é pequeno demais. Tenho que encontrar uma solução para isso. Posso anunciar algo na Computex. Estamos procurando imóveis. Trabalhamos com a MediaTek em várias áreas diferentes. Uma delas é em veículos autônomos. Trabalhamos com eles para que possamos juntos oferecer um carro totalmente definido por software e computadorizado para a indústria. Nossa colaboração com a indústria automotiva é muito boa.

Com a Grace Blackwell, o GB10, a CPU Grace é em colaboração com a MediaTek. Nós a arquitetamos juntos. Colocamos algumas tecnologias da Nvidia na MediaTek, para que possamos ter NVLink chip a chip. Eles projetaram o chip conosco e projetaram o chip para nós. Eles fizeram um trabalho excelente. O silício está perfeito na primeira tentativa. O desempenho é excelente. Como você pode imaginar, a reputação da MediaTek em relação a muito baixa energia é absolutamente merecida. Estamos muito satisfeitos em trabalhar com eles. A parceria é excelente. Eles são uma empresa excelente.

Pergunta: Que conselho você daria aos estudantes que olham para o futuro?

Huang: Minha geração foi a primeira a ter que aprender a usar computadores para fazer seu campo de ciência. A geração anterior apenas usava calculadoras e papel e lápis. Minha geração teve que aprender a usar computadores para escrever software, projetar chips, simular física. Minha geração foi a geração que usou computadores para fazer nossos trabalhos.

A próxima geração é a geração que aprenderá a usar IA para fazer seus trabalhos. A IA é o novo computador. Campos muito importantes da ciência – no futuro, será uma questão de “Como vou usar a IA para me ajudar a fazer biologia?” Ou silvicultura, ou agricultura, ou química, ou física quântica. Cada campo da ciência. E claro, ainda há ciência da computação. Como vou usar a IA para ajudar a avançar a ciência da computação? Cada campo de ciência. Gestão da cadeia de suprimentos. Pesquisa operacional. Como vou usar a IA para avançar a pesquisa operacional? Se você quiser ser um repórter, como vou usar a IA para me ajudar a ser um melhor repórter?

Todo estudante no futuro terá que aprender como usar IA, assim como a geração atual teve que aprender como usar computadores. Essa é a diferença fundamental. Isso rapidamente mostra quão profunda é a revolução da IA. Isso não se trata apenas de um modelo de linguagem grande. Esses são muito importantes, mas a IA será parte de tudo no futuro. É a tecnologia mais transformadora que já conhecemos. Está avançando de forma incrivelmente rápida.

Para todos os gamers e a indústria de jogos, fico feliz que a indústria esteja tão entusiasmada quanto nós agora. No início, estávamos usando GPUs para avançar a IA, e agora estamos usando IA para avançar a computação gráfica. O trabalho que fizemos com RTX Blackwell e DLSS 4 é tudo por causa dos avanços em IA. Agora isso voltou para avançar os gráficos.

Se você observar a curva da Lei de Moore dos gráficos computacionais, ela estava realmente desacelerando. A IA veio e supercarregou a curva. As taxas de quadros agora chegam a 200, 300, 400, e as imagens são completamente traçadas por raios. Elas estão lindas. Entramos em uma curva exponencial de gráficos computacionais. Entramos em uma curva exponencial em quase todos os campos. É por isso que acho que nossa indústria vai mudar muito rapidamente, mas cada indústria vai mudar muito rapidamente, muito em breve.

Insights diários sobre casos de uso empresarial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Oferecemos informações privilegiadas sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights que maximizem o ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

X altera seus termos para proibir o treinamento de modelos de IA com seu conteúdo.

[the_ad id="145565"] A rede social X alterou seu contrato com desenvolvedores para impedir que terceiros utilizem o conteúdo da plataforma para treinar modelos de linguagem de…

A América do Norte concentra a maior parte dos investimentos em capital de risco em IA, apesar do ambiente político desafiador.

[the_ad id="145565"] Apesar do que alguns especialistas têm caracterizado como um ambiente cada vez mais hostil à P&D em IA, a América do Norte continua recebendo a maior…

CEO da Alphabet, Sundar Pichai, descarta temores sobre empregos com IA e destaca planos de expansão.

[the_ad id="145565"] Em uma entrevista à Bloomberg na noite de quarta-feira, no centro de San Francisco, o CEO da Alphabet, Sundar Pichai, rejeitou as preocupações de que a IA…