Participe de nossos boletins informativos diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder no setor. Saiba mais

Mistral atualizou seu modelo de codificação de código aberto, o Codestral — que está se tornando popular entre os programadores — ampliando a concorrência para modelos focados em codificação voltados para desenvolvedores.

Em um post no blog, a empresa informou que aprimorou o modelo com uma arquitetura mais eficiente para criar o Codestral 25.01, um modelo que a Mistral promete ser o “líder claro em sua categoria de peso” e duas vezes mais rápido que a versão anterior.

Assim como o Codestral original, o Codestral 25.01 é otimizado para ações de baixa latência e alta frequência, suportando correção de código, geração de testes e tarefas de preenchimento. A empresa afirmou que pode ser útil para empresas com mais dados e casos de uso de residência de modelos.

Testes de benchmark mostraram que o Codestral 25.01 teve um desempenho melhor em testes de codificação em Python, alcançando 86,6% no teste HumanEval. Ele superou a versão anterior do Codestral, o Codellama 70B Instruct e o DeepSeek Coder 33B Instruct.

Esta versão do Codestral estará disponível para desenvolvedores que fazem parte dos parceiros de plugins IDE da Mistral. Os usuários podem implementar o Codestral 25.01 localmente através do assistente de código Continue. Eles também podem acessar a API do modelo através da la Plateforme da Mistral e Google Vertex AI. O modelo está disponível em prévia na Azure AI Foundry e estará em breve na Amazon Bedrock.

Cada vez mais modelos de codificação

A Mistral lançou o Codestral em maio do ano passado como seu primeiro modelo focado em código. O modelo de 22B parâmetros poderia codificar em 80 idiomas diferentes e superou outros modelos centrados em código. Desde então, a Mistral lançou o Codestral-Mamba, um modelo de geração de código construído sobre a arquitetura Mamba que pode gerar cadeias de código mais longas e lidar com mais entradas.

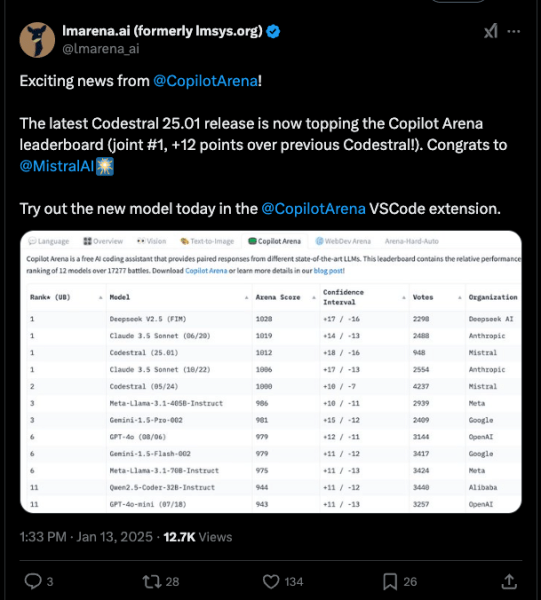

E parece que já há muito interesse no Codestral 25.01. Apenas algumas horas após o anúncio da Mistral, o modelo já está subindo nas classificações do Copilot Arena.

Escrever código foi uma das primeiras características dos modelos de fundação, mesmo para modelos de objetivo mais geral, como o o3 da OpenAI e o Claude da Anthropic. No entanto, no último ano, modelos específicos para codificação melhoraram e muitas vezes superam modelos maiores.

No último ano, vários modelos específicos para codificação foram disponibilizados para desenvolvedores. A Alibaba lançou o Qwen2.5-Coder em novembro. O DeepSeek Coder da China se tornou o primeiro modelo a superar o GPT-4 Turbo em junho. A Microsoft também revelou o GRIN-MoE, um modelo baseado em mistura de especialistas (MOE) que pode codificar e resolver problemas de matemática.

Ninguém resolveu o eterno debate sobre escolher um modelo de propósito geral que aprende tudo ou um modelo focado que só sabe codificar. Alguns desenvolvedores preferem a variedade de opções que encontram em um modelo como o Claude, mas a proliferação de modelos de codificação mostra uma demanda por especificidade. Como o Codestral é treinado em dados de codificação, será, é claro, melhor em tarefas de codificação em vez de escrever e-mails.

Insights diários sobre casos de uso de negócios com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós lhe damos a informação interna sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

OpenAI está supostamente em negociações para comprar a Windsurf por $3 bilhões, com novidades esperadas para esta semana.

[the_ad id="145565"] A Windsurf, fabricante de um popular assistente de codificação por IA, está em negociações para ser adquirida pela OpenAI por cerca de $3 bilhões, segundo…

A OpenAI procurou o criador do Cursor antes de iniciar negociações para comprar a Windsurf por $3 bilhões.

[the_ad id="145565"] Quando a notícia de que a OpenAI estava em negociações para adquirir a empresa de codificação AI Windsurf por $3 bilhões surgiu, uma das primeiras…

Como a IA está redesenhando os mapas de eletricidade do mundo: Insights do Relatório da AIE

[the_ad id="145565"] A inteligência artificial (IA) não está apenas transformando a tecnologia; ela também está mudando de forma significativa o setor energético global. De…