Participe das nossas newsletters diárias e semanais para receber as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA líder no setor. Saiba Mais

O Gemini AI do Google transformou silenciosamente o cenário da IA, alcançando um marco que poucos acreditavam ser possível: o processamento simultâneo de múltiplos fluxos visuais em tempo real.

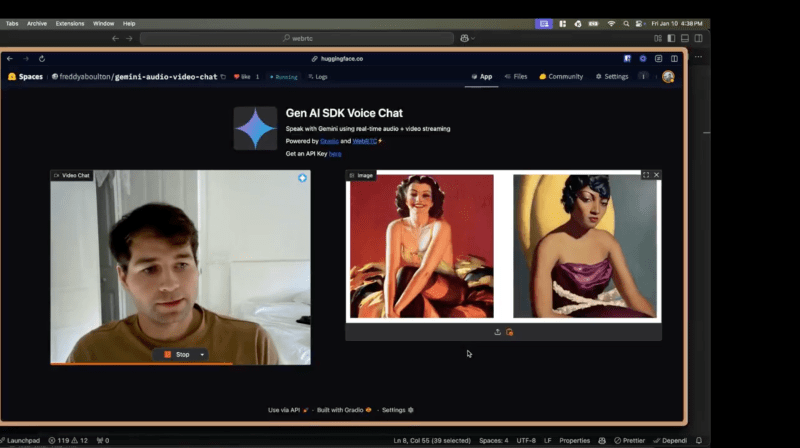

Esse avanço — que permite que o Gemini não apenas assista a transmissões de vídeo ao vivo, mas também analise imagens estáticas simultaneamente — não foi revelado por meio das plataformas principais do Google. Em vez disso, surgiu de uma aplicação experimental chamada “AnyChat.”

Esse salto inesperado ressalta o potencial não explorado da arquitetura do Gemini, ampliando os limites da capacidade da IA em lidar com interações complexas e multimodais. Durante anos, as plataformas de IA foram restritas a gerenciar apenas transmissões de vídeo ao vivo ou fotos estáticas, mas nunca ambas ao mesmo tempo. Com o AnyChat, essa barreira foi quebrada de maneira decisiva.

“Mesmo o serviço pago do Gemini ainda não consegue fazer isso,” disse Ahsen Khaliq, líder em aprendizado de máquina (ML) da Gradio e criador do AnyChat, em uma entrevista exclusiva ao VentureBeat. “Agora é possível ter uma conversa real com a IA enquanto ela processa tanto seu feed de vídeo ao vivo quanto qualquer imagem que você queira compartilhar.”

Como o Gemini do Google está redefinindo silenciosamente a visão da IA

O feito técnico por trás da capacidade de múltiplos fluxos do Gemini reside em sua avançada arquitetura neural — uma infraestrutura que o AnyChat habilidosamente explora para processar múltiplas entradas visuais sem sacrificar o desempenho. Essa capacidade já existe na API do Gemini, mas não foi disponibilizada nas aplicações oficiais do Google para usuários finais.

Em contraste, as demandas computacionais de muitas plataformas de IA, incluindo o ChatGPT, limitam-nas ao processamento de um único fluxo. Por exemplo, o ChatGPT atualmente desativa a transmissão de vídeo ao vivo quando uma imagem é carregada. Mesmo lidar com um único feed de vídeo pode sobrecarregar recursos, quanto mais combinar isso com a análise de uma imagem estática.

As potenciais aplicações desse avanço são tão transformadoras quanto imediatas. Estudantes agora podem apontar a câmera para um problema de cálculo enquanto mostram ao Gemini um livro didático para receber orientação passo a passo. Artistas podem compartilhar obras em andamento ao lado de imagens de referência, recebendo feedback sutil e em tempo real sobre composição e técnica.

A tecnologia por trás do avanço de IA de múltiplos fluxos do Gemini

O que torna a realização do AnyChat notável não é apenas a tecnologia em si, mas a forma como contorna as limitações do desdobramento oficial do Gemini. Esse avanço foi possível graças a permissões especializadas da API do Gemini, permitindo que o AnyChat acessasse funcionalidades que ainda não estão presentes nas próprias plataformas do Google.

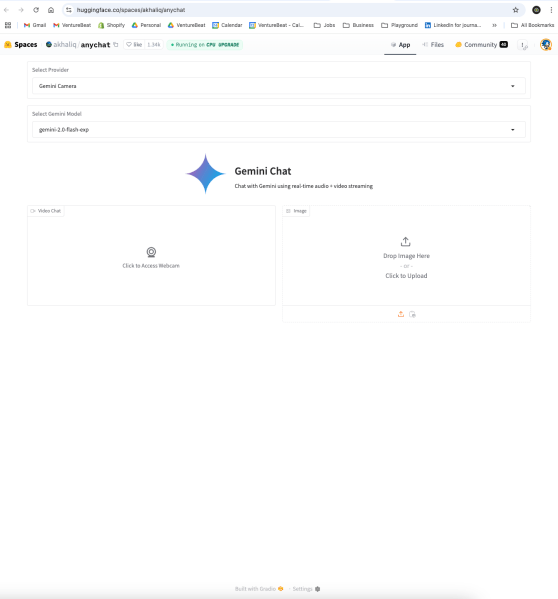

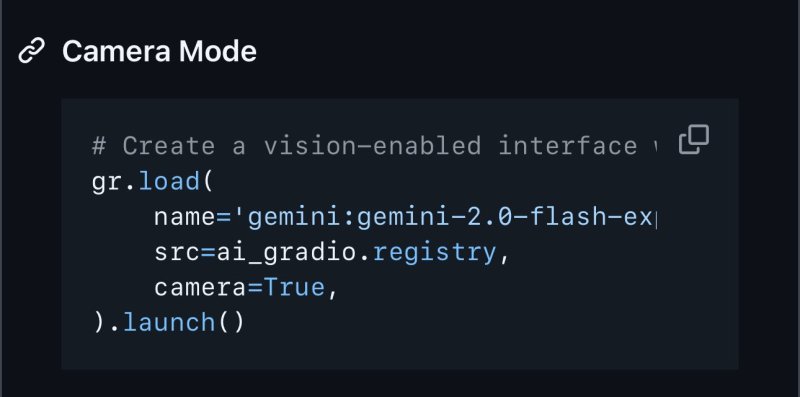

Usando essas permissões expandidas, o AnyChat otimiza os mecanismos de atenção do Gemini para acompanhar e analisar múltiplas entradas visuais simultaneamente — tudo enquanto mantém a coerência da conversa. Desenvolvedores podem facilmente replicar essa capacidade com algumas linhas de código, como demonstrado pelo uso do Gradio, uma plataforma de código aberto para construção de interfaces de ML.

Por exemplo, desenvolvedores podem lançar sua própria plataforma de vídeo chamada com suporte a upload de imagens usando o seguinte trecho de código:

(Crédito: Hugging Face / Gradio)

Essa simplicidade destaca como o AnyChat não é apenas uma demonstração do potencial do Gemini, mas uma ferramenta para desenvolvedores que buscam construir aplicações de IA com visão personalizadas.

O que torna a realização do AnyChat notável não é apenas a tecnologia em si, mas a maneira como contorna as limitações do desdobramento oficial do Gemini. Esse avanço foi possível através de permissões especializadas concedidas pela equipe do Gemini, permitindo que o AnyChat acessasse funcionalidades que permanecem ausentes nas próprias plataformas do Google.

“O recurso de vídeo em tempo real no Google AI Studio não consegue lidar com imagens carregadas durante a transmissão,” disse Khaliq ao VentureBeat. “Nenhuma outra plataforma implementou esse tipo de processamento simultâneo no momento.”

O aplicativo experimental que desbloqueou as capacidades ocultas do Gemini

O sucesso do AnyChat não foi uma simples coincidência. Os desenvolvedores da plataforma trabalharam de forma próxima com a arquitetura técnica do Gemini para expandir seus limites. Ao fazer isso, revelaram um lado do Gemini que mesmo as ferramentas oficiais do Google ainda não exploraram.

Essa abordagem experimental permitiu que o AnyChat lidasse com fluxos simultâneos de vídeo ao vivo e imagens estáticas, essencialmente quebrando a “barreira de fluxo único”. O resultado é uma plataforma que parece mais dinâmica, intuitiva e capaz de lidar com casos de uso do mundo real de forma muito mais eficaz do que seus concorrentes.

Por que o processamento visual simultâneo é um divisor de águas

As implicações das novas capacidades do Gemini vão muito além de ferramentas criativas e interações casuais com a IA. Imagine um profissional médico mostrando a uma IA tanto os sintomas de pacientes em tempo real quanto exames diagnósticos históricos ao mesmo tempo. Engenheiros poderiam comparar o desempenho de equipamentos em tempo real com esquemas técnicos, recebendo respostas instantâneas. Equipes de controle de qualidade poderiam comparar a produção da linha de montagem com padrões de referência com uma precisão e eficiência sem precedentes.

No campo da educação, o potencial é transformador. Estudantes podem usar o Gemini em tempo real para analisar livros didáticos enquanto trabalham em problemas práticos, recebendo suporte contextual que preenche a lacuna entre ambientes de aprendizado estáticos e dinâmicos. Para artistas e designers, a capacidade de mostrar múltiplas entradas visuais simultaneamente abre novas avenidas para colaboração criativa e feedback.

O que o sucesso do AnyChat significa para o futuro da inovação em IA

Por enquanto, o AnyChat permanece como uma plataforma de desenvolvedor experimental, operando com limites expandidos concedidos pelos desenvolvedores do Gemini. No entanto, seu sucesso prova que a visão de IA simultânea de múltiplos fluxos não é mais uma aspiração distante — é uma realidade presente, pronta para adoção em grande escala.

A emergência do AnyChat levanta questões provocativas. Por que o lançamento oficial do Gemini não incluiu essa capacidade? É uma negligência, uma escolha deliberada em alocação de recursos ou uma indicação de que desenvolvedores menores e mais ágeis estão impulsionando a próxima onda de inovação?

À medida que a corrida da IA acelera, a lição do AnyChat é clara: os avanços mais significativos podem não vir sempre dos vastos laboratórios de pesquisa das gigantes da tecnologia. Em vez disso, eles podem originar-se de desenvolvedores independentes que enxergam o potencial nas tecnologias existentes — e ousam levá-las mais longe.

Com a arquitetura inovadora do Gemini agora provada capaz de processamento de múltiplos fluxos, o palco está montado para uma nova era de aplicações de IA. Se o Google incorporará essa capacidade em suas plataformas oficiais permanece incerto. Uma coisa é certa, no entanto: a lacuna entre o que a IA pode fazer e o que oficialmente faz agora se tornou muito mais interessante.

Insights diários sobre casos de uso empresariais com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo que você precisa. Nós trazemos as novidades sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para o máximo retorno sobre investimento.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

OpenAI está supostamente em negociações para comprar a Windsurf por $3 bilhões, com novidades esperadas para esta semana.

[the_ad id="145565"] A Windsurf, fabricante de um popular assistente de codificação por IA, está em negociações para ser adquirida pela OpenAI por cerca de $3 bilhões, segundo…

A OpenAI procurou o criador do Cursor antes de iniciar negociações para comprar a Windsurf por $3 bilhões.

[the_ad id="145565"] Quando a notícia de que a OpenAI estava em negociações para adquirir a empresa de codificação AI Windsurf por $3 bilhões surgiu, uma das primeiras…

Como a IA está redesenhando os mapas de eletricidade do mundo: Insights do Relatório da AIE

[the_ad id="145565"] A inteligência artificial (IA) não está apenas transformando a tecnologia; ela também está mudando de forma significativa o setor energético global. De…