Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder na indústria. Saiba mais

A escalabilidade em tempo de inferência é um dos grandes temas da inteligência artificial em 2025, e os laboratórios de IA estão abordando isso de diferentes maneiras. Em seu mais recente artigo de pesquisa, o Google DeepMind introduziu o conceito de “Evolução da Mente”, uma técnica que otimiza as respostas de modelos de linguagem de grande porte (LLMs) para tarefas de planejamento e raciocínio.

Técnicas de escalabilidade em tempo de inferência tentam melhorar o desempenho dos LLMs permitindo que eles “pensem” mais ao gerar suas respostas. Na prática, isso significa que em vez de gerar sua resposta de uma só vez, um modelo é autorizado a gerar várias respostas, revisar e corrigir suas respostas, e explorar diferentes maneiras de resolver o problema.

Evolução das respostas dos LLM

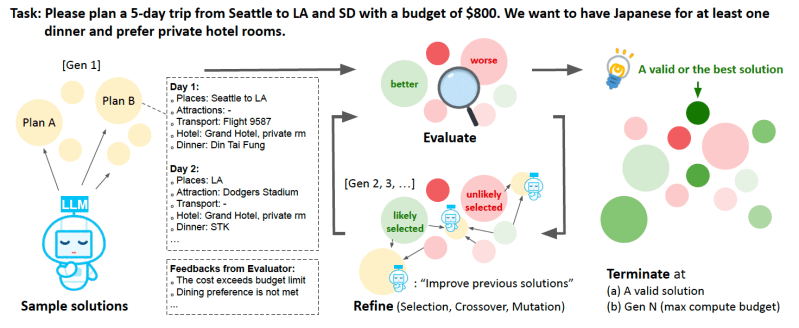

A Evolução da Mente baseia-se em dois componentes-chave: algoritmos de busca e algoritmos genéticos. Os algoritmos de busca são um componente comum em muitas técnicas de escalabilidade em tempo de inferência. Eles permitem que os LLMs encontrem o melhor caminho de raciocínio para a solução ideal. Os algoritmos genéticos são inspirados na seleção natural. Eles criam e evoluem uma população de soluções candidatas para otimizar um objetivo, frequentemente chamado de “função de adequação.”

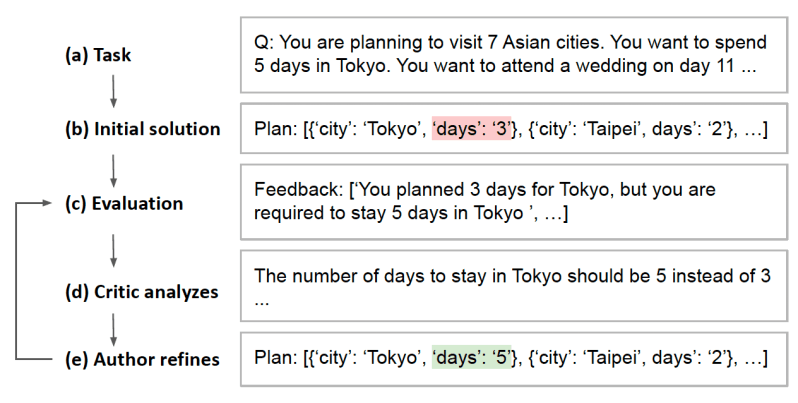

A Evolução da Mente começa criando uma população de soluções candidatas expressas em linguagem natural. As soluções são geradas por um LLM que recebeu uma descrição do problema junto com informações e instruções úteis. O LLM então avalia cada candidato e o melhora se não atender aos critérios para a solução.

O algoritmo seleciona então os pais para a próxima geração de soluções amostrando a partir da população existente, com soluções de maior qualidade tendo uma maior chance de serem selecionadas. Em seguida, cria novas soluções através de cruzamento (escolhendo pares de pais e combinando seus elementos para criar uma nova solução) e mutação (fazendo alterações aleatórias nas soluções recém-criadas). O método de avaliação é reutilizado para refinar as novas soluções.

O ciclo de avaliação, seleção e recombinação continua até que o algoritmo alcance a solução ideal ou esgote um número predefinido de iterações.

Uma das partes importantes da Evolução da Mente é a função de avaliação. Os avaliadores de técnicas de escalabilidade em tempo de inferência frequentemente exigem que o problema seja formalizado de linguagem natural para uma representação simbólica estruturada que pode ser processada por um programa solucionador. Formalizar um problema pode exigir um conhecimento significativo do domínio e uma compreensão profunda do problema para identificar todos os elementos-chave que precisam ser representados simbolicamente e como eles se relacionam entre si, o que limita sua aplicabilidade.

Na Evolução da Mente, a função de adequação é projetada para trabalhar com tarefas de planejamento em linguagem natural onde as soluções são expressas em linguagem natural. Isso permite que o sistema evite a formalização de problemas, desde que um avaliador de soluções programático esteja disponível. Ele também fornece feedback textual além de uma pontuação numérica, o que permite que o LLM compreenda questões específicas e faça melhorias direcionadas.

“Focamos em evoluir soluções em espaços de linguagem natural em vez de espaços formais. Isso remove a exigência de formalização da tarefa, o que requer um esforço significativo e conhecimento especializado para cada instância da tarefa,” afirmam os pesquisadores.

A Evolução da Mente também usa uma abordagem de “ilha” para garantir que explore um conjunto diversificado de soluções. Em cada fase, o algoritmo cria grupos separados de soluções que evoluem dentro de si mesmas. Em seguida, ele “migra” soluções ótimas de um grupo para outro para combinar e criar novas.

Evolução da Mente em tarefas de planejamento

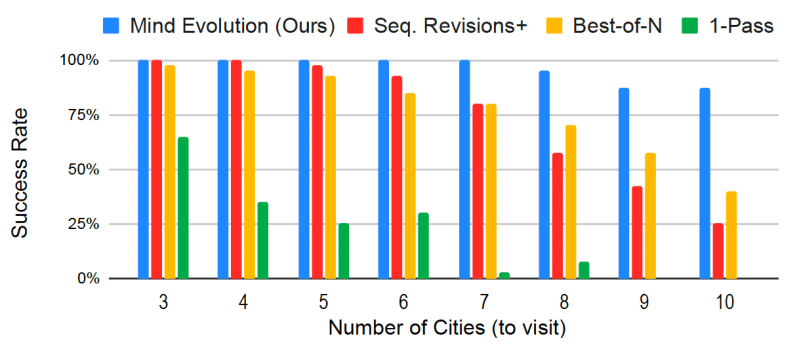

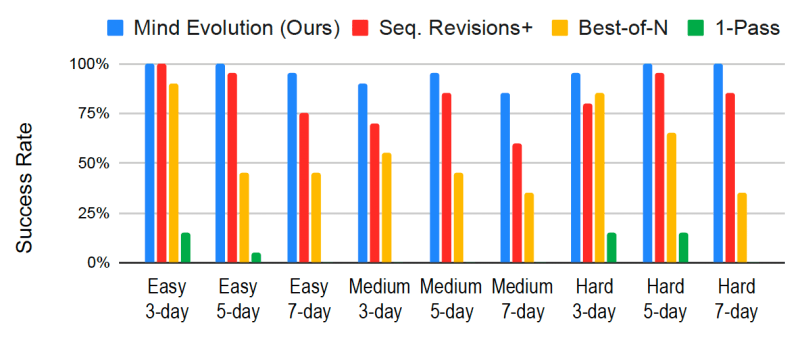

Os pesquisadores testaram a Evolução da Mente em comparação com linhas de base como 1-pass, onde o modelo gera apenas uma resposta; Best-of-N, onde o modelo gera várias respostas e escolhe a melhor; e Sequential Revisions+, uma técnica de revisão onde 10 soluções candidatas são propostas de forma independente, e então revisadas separadamente por 80 turnos. Sequential Revisions+ está mais próxima da Evolução da Mente, embora não tenha o componente do algoritmo genético para combinar as melhores partes da solução descoberta. Para referência, eles também incluem uma linha de base adicional de 1-pass que usa OpenAI o1-preview.

Os pesquisadores realizaram a maioria dos testes no modelo rápido e acessível Gemini 1.5 Flash. Eles também exploraram uma abordagem de duas etapas, onde o modelo Gemini 1.5 Pro é usado quando o modelo Flash não consegue resolver o problema. Essa abordagem de duas etapas proporciona uma melhor relação custo-eficiência do que usar o modelo Pro em cada instância de problema.

Os pesquisadores testaram a Evolução da Mente em vários benchmarks de planejamento em linguagem natural para tarefas como planejamento de viagens e reuniões. Pesquisas anteriores mostram que os LLMs não conseguem alcançar um bom desempenho nessas tarefas sem a ajuda de solucionadores formais.

Por exemplo, o Gemini 1.5 Flash e o o1-preview alcançam uma taxa de sucesso de apenas 5,6% e 11,7% no TravelPlanner, um benchmark que simula a organização de um plano de viagem com base nas preferências e restrições do usuário expressas em linguagem natural. Mesmo explorando o Best-of-N sobre 800 respostas geradas independentemente, o Gemini 1.5 Flash alcança apenas 55,6% de sucesso no TravelPlanner.

Em todos os testes, a Evolução da Mente superou as linhas de base por uma ampla margem, especialmente à medida que as tarefas se tornaram mais difíceis.

Por exemplo, a Evolução da Mente alcança uma taxa de sucesso de 95% no TravelPlanner. No benchmark de Planejamento de Viagens, que envolve a criação de um itinerário de cidades a visitar com um número de dias em cada uma, a Evolução da Mente conseguiu 94,1% nas instâncias de teste, enquanto outros métodos atingiram uma taxa de sucesso máxima de 77%. Curiosamente, a lacuna entre a Evolução da Mente e outras técnicas aumenta à medida que o número de cidades cresce, indicando sua capacidade de lidar com tarefas de planejamento mais complexas. Com o processo de duas etapas, a Evolução da Mente alcançou taxas de sucesso quase perfeitas em todos os benchmarks.

A Evolução da Mente também se mostrou uma abordagem econômica para resolver problemas de planejamento em linguagem natural, utilizando uma fração do número de tokens usados pelo Sequential-Revision+, a única outra técnica que se aproxima de seu desempenho.

“No geral, esses resultados demonstram uma clara vantagem de uma estratégia evolutiva que combina uma ampla busca, através de exploração estocástica, com uma busca aprofundada que aproveita um LLM para o refinamento da solução,” escrevem os pesquisadores.

Insights diários sobre casos de uso de negócios com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós trazemos as informações por dentro do que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um máximo retorno sobre o investimento.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Anthropic enviou um aviso de remoção a um desenvolvedor que tentava reverter o código de sua ferramenta.

[the_ad id="145565"] Na disputa entre duas ferramentas de código "agente" — Claude Code da Anthropic e Codex CLI da OpenAI — a última parece estar promovendo mais boa vontade…

O novo CEO da Intel sinaliza esforços de simplificação, mas não revela números exatos de demissões.

[the_ad id="145565"] Lip-Bu Tan, o novo CEO da Intel, enviou uma mensagem direta aos funcionários, afirmando que a empresa precisa se reorganizar para ser mais eficiente. Ele…

Um pesquisador da OpenAI que trabalhou no GPT-4.5 teve seu green card negado.

[the_ad id="145565"] Kai Chen, um pesquisador de IA canadense que trabalha na OpenAI e mora nos EUA há 12 anos, teve seu pedido de green card negado, de acordo com Noam Brown,…