Participe dos nossos boletins diários e semanais para obter as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder da indústria. Saiba mais

A Cerebras Systems anunciou hoje que irá hospedar o modelo de inteligência artificial revolucionário da R1 do DeepSeek em servidores dos EUA, prometendo velocidades de até 57 vezes mais rápidas do que as soluções baseadas em GPU, enquanto mantém dados sensíveis dentro das fronteiras americanas. Essa decisão vem em meio a crescentes preocupações sobre os avanços rápidos da IA na China e a privacidade dos dados.

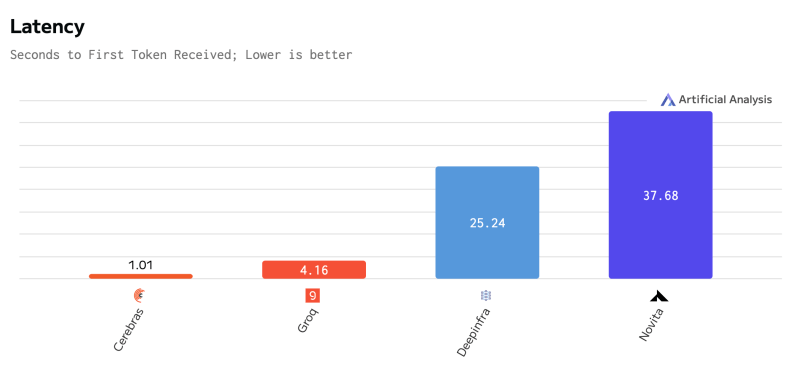

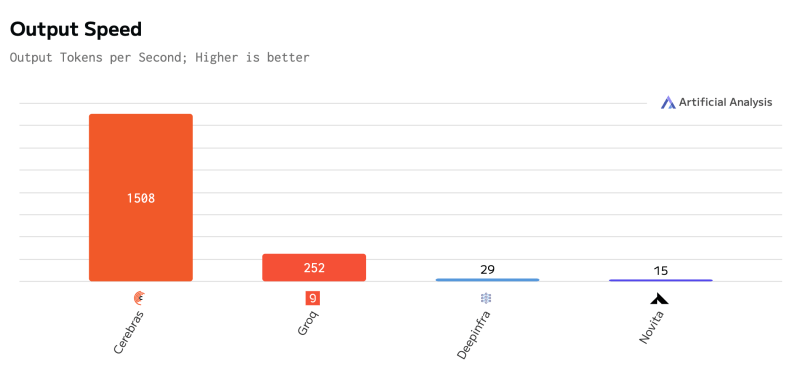

A startup de chips de IA implantará uma versão de 70 bilhões de parâmetros do DeepSeek-R1 operando em seu hardware proprietário de escala de wafer, entregando 1.600 tokens por segundo — uma melhoria dramática em relação às implementações tradicionais em GPU que têm lutado com os novos modelos de IA “raciocínio”.

Por que os modelos de raciocínio do DeepSeek estão reformulando a IA empresarial

“Esses modelos de raciocínio afetam a economia”, disse James Wang, um executivo sênior da Cerebras, em uma entrevista exclusiva ao VentureBeat. “Qualquer trabalhador do conhecimento basicamente precisa realizar algum tipo de tarefa cognitiva em múltiplos passos. E esses modelos de raciocínio serão as ferramentas que entrarão em seu fluxo de trabalho.”

O anúncio segue uma semana tumultuada em que a emergência do DeepSeek desencadeou a maior perda de valor de mercado da Nvidia, quase $600 bilhões, levantando questões sobre a supremacia da IA da gigante dos chips. A solução da Cerebras aborda diretamente duas preocupações-chave que surgiram: as demandas computacionais de modelos avançados de IA e a soberania de dados.

“Se você usar a API do DeepSeek, que é muito popular no momento, os dados são enviados diretamente para a China”, explicou Wang. “Essa é uma severa desvantagem que [faz] muitas empresas e corporações dos EUA… não estarem dispostas a considerar [isso].”

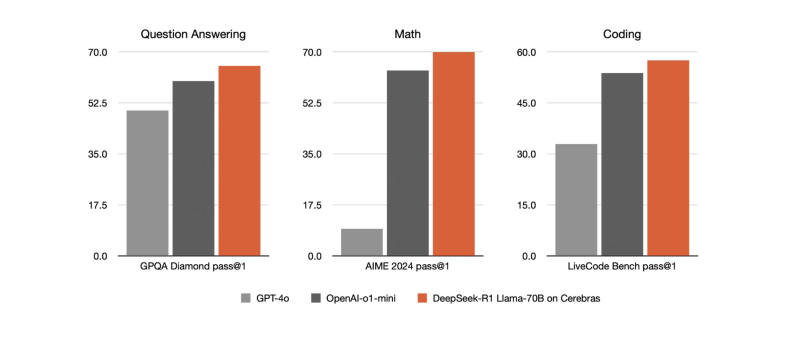

Como a tecnologia de escala de wafer da Cerebras supera as GPUs tradicionais em velocidade de IA

A Cerebras atinge sua vantagem de velocidade por meio de uma nova arquitetura de chip que mantém modelos de IA inteiros em um único processador do tamanho de um wafer, eliminando os gargalos de memória que atormentam os sistemas baseados em GPU. A empresa afirma que sua implementação do DeepSeek-R1 iguala ou supera o desempenho dos modelos proprietários da OpenAI, enquanto opera inteiramente em solo americano.

O desenvolvimento representa uma mudança significativa no cenário da IA. O DeepSeek, fundado pelo ex-executivo de hedge funds Liang Wenfeng, chocou a indústria ao alcançar capacidades sofisticadas de raciocínio em IA, supostamente a apenas 1% do custo de concorrentes americanos. A solução de hospedagem da Cerebras agora oferece às empresas americanas uma maneira de aproveitar esses avanços enquanto mantém o controle sobre os dados.

“É na verdade uma boa história que os laboratórios de pesquisa dos EUA deram esse presente ao mundo. Os chineses pegaram isso e melhoraram, mas tem limitações porque é executado na China, tem alguns problemas de censura, e agora estamos trazendo de volta e executando em data centers dos EUA, sem censura, sem retenção de dados”, disse Wang.

Liderança tecnológica dos EUA enfrenta novas questões à medida que a inovação em IA se globaliza

O serviço estará disponível através de uma prévia para desenvolvedores a partir de hoje. Embora inicialmente seja gratuito, a Cerebras planeja implementar controles de acesso à API devido à forte demanda inicial.

A medida ocorre enquanto legisladores dos EUA lidam com as implicações do surgimento do DeepSeek, que expôs limitações potenciais das restrições comerciais americanas projetadas para manter vantagens tecnológicas sobre a China. A capacidade das empresas chinesas de alcançar capacidades revolucionárias em IA, apesar dos controles de exportação de chips, gerou pedidos por novas abordagens regulatórias.

Analistas da indústria sugerem que esse desenvolvimento pode acelerar a transição do uso de infraestrutura de IA dependente de GPU. “A Nvidia não é mais a líder em desempenho de inferência”, observou Wang, apontando para benchmarks que mostram desempenho superior de vários chips de IA especializados. “Essas outras empresas de chips de IA são realmente mais rápidas que as GPUs para executar esses novos modelos.”

O impacto vai além das métricas técnicas. À medida que os modelos de IA cada vez mais incorporam capacidades sofisticadas de raciocínio, suas demandas computacionais dispararam. A Cerebras argumenta que sua arquitetura é mais adequada para essas novas cargas de trabalho, potencialmente reformulando o cenário competitivo no uso de IA empresarial.

Insights diários sobre casos de uso de negócios com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Oferecemos uma visão interna sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…