Após o término da AI Action Summit em Paris, Dario Amodei, co-fundador e CEO da Anthropic, descreveu o evento como uma “oportunidade perdida”. Ele afirmou que “é necessário um foco e uma urgência maiores em vários tópicos, considerando a rapidez com que a tecnologia está progredindo” na declaração divulgada na terça-feira.

A empresa de IA realizou um evento voltado para desenvolvedores em Paris em parceria com a startup francesa Dust, e o TechCrunch teve a oportunidade de entrevistar Amodei no palco. No evento, ele explicou seu ponto de vista e defendeu um terceiro caminho que não é puramente otimista nem puramente crítico em relação à inovação e governança da IA.

“Eu costumava ser neurocientista, onde basicamente olhava dentro de cérebros reais para ganhar a vida. E agora estamos olhando dentro de cérebros artificiais para ganhar a vida. Portanto, nos próximos meses, teremos alguns avanços empolgantes na área da interpretabilidade — onde realmente começamos a entender como os modelos operam,” disse Amodei ao TechCrunch.

“Mas definitivamente é uma corrida. É uma corrida entre tornar os modelos mais poderosos, o que é incrivelmente rápido para nós e para outros — você realmente não pode desacelerar, certo? … Nossa compreensão precisa acompanhar nossa capacidade de construir as coisas. Acho que essa é a única maneira,” acrescentou.

Desde o primeiro cúpula de IA em Bletchley, no Reino Unido, o tom da discussão sobre governança da IA mudou significativamente. Isso se deve, em parte, ao atual cenário geopolítico.

“Não estou aqui esta manhã para falar sobre segurança da IA, que era o título da conferência há alguns anos,” disse o Vice-presidente dos EUA, JD Vance, na AI Action Summit na terça-feira. “Estou aqui para falar sobre a oportunidade da IA.”

Curiosamente, Amodei está tentando evitar essa antagonização entre segurança e oportunidade. Na verdade, ele acredita que um foco maior na segurança é uma oportunidade.

“Na cúpula original, a Cúpula de Bletchley no Reino Unido, houve muitas discussões sobre testes e medições de vários riscos. E não acho que essas coisas desaceleraram a tecnologia muito. Se algo, fazer esse tipo de medição nos ajudou a entender melhor nossos modelos, o que, no final, nos ajuda a produzir modelos melhores,” disse Amodei no evento da Anthropic.

E toda vez que Amodei enfatiza a segurança, ele também gosta de lembrar a todos que a Anthropic ainda está muito focada em construir modelos de IA de ponta.

“Não quero fazer nada para reduzir a promessa. Estamos fornecendo modelos todos os dias que as pessoas podem usar e que são usados para fazer coisas incríveis. E definitivamente não devemos parar de fazer isso,” disse ele.

“Quando as pessoas falam muito sobre os riscos, eu meio que fico irritado e digo: ‘oh, cara, ninguém realmente fez um bom trabalho de expor quão incrível essa tecnologia poderia ser,’” acrescentou ele mais tarde na conversa.

Os custos de treinamento da DeepSeek são “apenas não precisos”

Quando a conversa mudou para os modelos recentes da DeepSeek, fabricante de LLM da China, Amodei minimizou as conquistas técnicas e disse sentir que a reação pública era “inorgânica”.

“Honestamente, minha reação foi muito pouca. Vimos o V3, que é o modelo base do DeepSeek R1, em dezembro. E esse era um modelo impressionante,” disse ele. “O modelo que foi lançado em dezembro estava em uma curva de redução de custo bastante normal que vimos em nossos modelos e em outros modelos.”

O que foi notável é que o modelo não estava sendo desenvolvido por “três ou quatro laboratórios de ponta” com sede nos EUA. Ele listou Google, OpenAI e Anthropic como alguns dos laboratórios de ponta que normalmente empurram os limites com novos lançamentos de modelos.

“E isso era uma questão de preocupação geopolítica para mim. Eu nunca quis que governos autoritários dominassem essa tecnologia,” disse ele.

Quanto aos supostos custos de treinamento da DeepSeek, ele descartou a ideia de que treinar o DeepSeek V3 era 100 vezes mais barato em comparação com os custos de treinamento nos EUA. “Acho que [isso] simplesmente não é preciso e não se baseia em fatos,” afirmou.

Próximos modelos Claude com raciocínio

Embora Amodei não tenha anunciado nenhum novo modelo no evento de quarta-feira, ele provocou alguns dos lançamentos futuros da empresa — e sim, inclui algumas capacidades de raciocínio.

“Estamos geralmente focados em tentar criar nossa própria interpretação de modelos de raciocínio que sejam melhor diferenciados. Nos preocupamos em garantir que tenhamos capacidade suficiente, que os modelos fiquem mais inteligentes e estamos preocupados com questões de segurança,” disse Amodei.

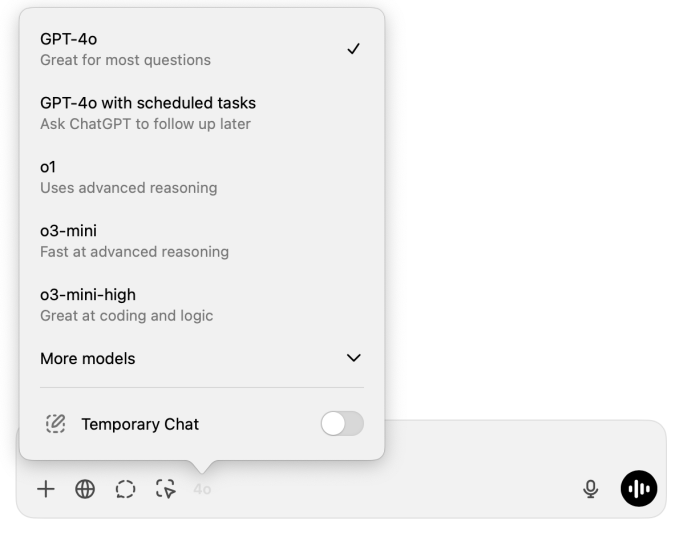

Um dos problemas que a Anthropic está tentando resolver é o dilema da seleção de modelos. Se você tem uma conta do ChatGPT Plus, por exemplo, pode ser difícil saber qual modelo escolher no pop-up de seleção de modelos para sua próxima mensagem.

O mesmo ocorre com os desenvolvedores que usam APIs de modelos de linguagem grande (LLM) para suas próprias aplicações. Eles querem equilibrar precisão, velocidade das respostas e custos.

“Ficamos um pouco perplexos com a ideia de que existem modelos normais e modelos de raciocínio, e que eles são meio que diferentes um do outro,” disse Amodei. “Se estou falando com você, você não tem dois cérebros e um deles responde imediatamente e o outro espera um pouco mais.”

De acordo com ele, dependendo da entrada, deveria haver uma transição mais suave entre modelos pré-treinados como Claude 3.5 Sonnet ou GPT-4o e modelos treinados com aprendizado por reforço que podem produzir cadeias de raciocínio (CoT) como o o1 da OpenAI ou o R1 da DeepSeek.

“Achamos que esses modelos deveriam existir como parte de uma única entidade contínua. E podemos não estar lá ainda, mas a Anthropic realmente quer mover as coisas nessa direção,” disse Amodei. “Deveríamos ter uma transição mais suave disso para modelos pré-treinados — em vez de ‘aqui está a coisa A e aqui está a coisa B,’” acrescentou.

À medida que grandes empresas de IA como a Anthropic continuam a lançar melhores modelos, Amodei acredita que isso abrirá grandes oportunidades para perturbar os grandes negócios do mundo em todos os setores.

“Estamos trabalhando com algumas empresas farmacêuticas para usar Claude na elaboração de estudos clínicos, e eles conseguiram reduzir o tempo necessário para escrever o relatório de estudo clínico de 12 semanas para três dias,” disse Amodei.

“Além do setor biomédico, existem áreas como jurídica, financeira, seguros, produtividade, software, questões relacionadas à energia. Acho que haverá — basicamente — um renascimento da inovação disruptiva no espaço de aplicações de IA. E queremos ajudar, queremos apoiar tudo isso,” concluiu.

Leia nossa cobertura completa da Artificial Intelligence Action Summit em Paris.

Conteúdo relacionado

Anthropic transforma a abordagem da IA na educação: o Modo de Aprendizagem do Claude faz os alunos refletirem.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas novidades e conteúdo exclusivo sobre cobertura de IA de liderança no setor. Saiba mais……

Anthropic lança um plano de chatbot de IA para faculdades e universidades

[the_ad id="145565"] A Anthropic anunciou na quarta-feira que está lançando uma nova camada Claude para Educação, como resposta ao plano ChatGPT Edu da OpenAI. A nova camada é…

O artigo de 145 páginas da DeepMind sobre segurança em AGI pode não convencer os céticos.

[the_ad id="145565"] O Google DeepMind publicou na quarta-feira um documento exaustivo sobre sua abordagem de segurança para AGI, definida de forma ampla como uma IA capaz de…