Em um movimento que chamou a atenção de muitos, a Perplexity AI lançou uma nova versão de um modelo de linguagem de código aberto popular que remove a censura chinesa embutida. Este modelo modificado, chamado R1 1776 (um nome que evoca o espírito de independência), é baseado no DeepSeek R1, desenvolvido na China. O modelo original, DeepSeek R1, fez ondas por suas fortes capacidades de raciocínio – supostamente rivalizando modelos de ponta a uma fração do custo – mas veio com uma limitação significativa: se recusou a abordar certos tópicos sensíveis.

Por que isso é importante?

Isso levanta questões cruciais sobre vigilância de IA, viés, abertura e o papel da geopolítica nos sistemas de IA. Este artigo explora o que exatamente a Perplexity fez, as implicações da des censura do modelo e como isso se encaixa na conversa mais ampla sobre transparência e censura em IA.

O que aconteceu: DeepSeek R1 fica sem censura

O DeepSeek R1 é um modelo de linguagem grande com pesos abertos que se originou na China e ganhou notoriedade por suas excelentes habilidades de raciocínio – mesmo se aproximando do desempenho de modelos de liderança – enquanto era mais eficiente em termos computacionais. No entanto, os usuários rapidamente notaram uma peculiaridade: sempre que as consultas tangenciavam tópicos sensíveis na China (por exemplo, controvérsias políticas ou eventos históricos considerados tabus pelas autoridades), o DeepSeek R1 não respondia diretamente. Em vez disso, respondia com declarações preparadas e aprovadas pelo estado ou outright negativas, refletindo as regras de censura do governo chinês. Esse viés embutido limitou a utilidade do modelo para aqueles que buscavam discussões francas ou nuançadas sobre esses tópicos.

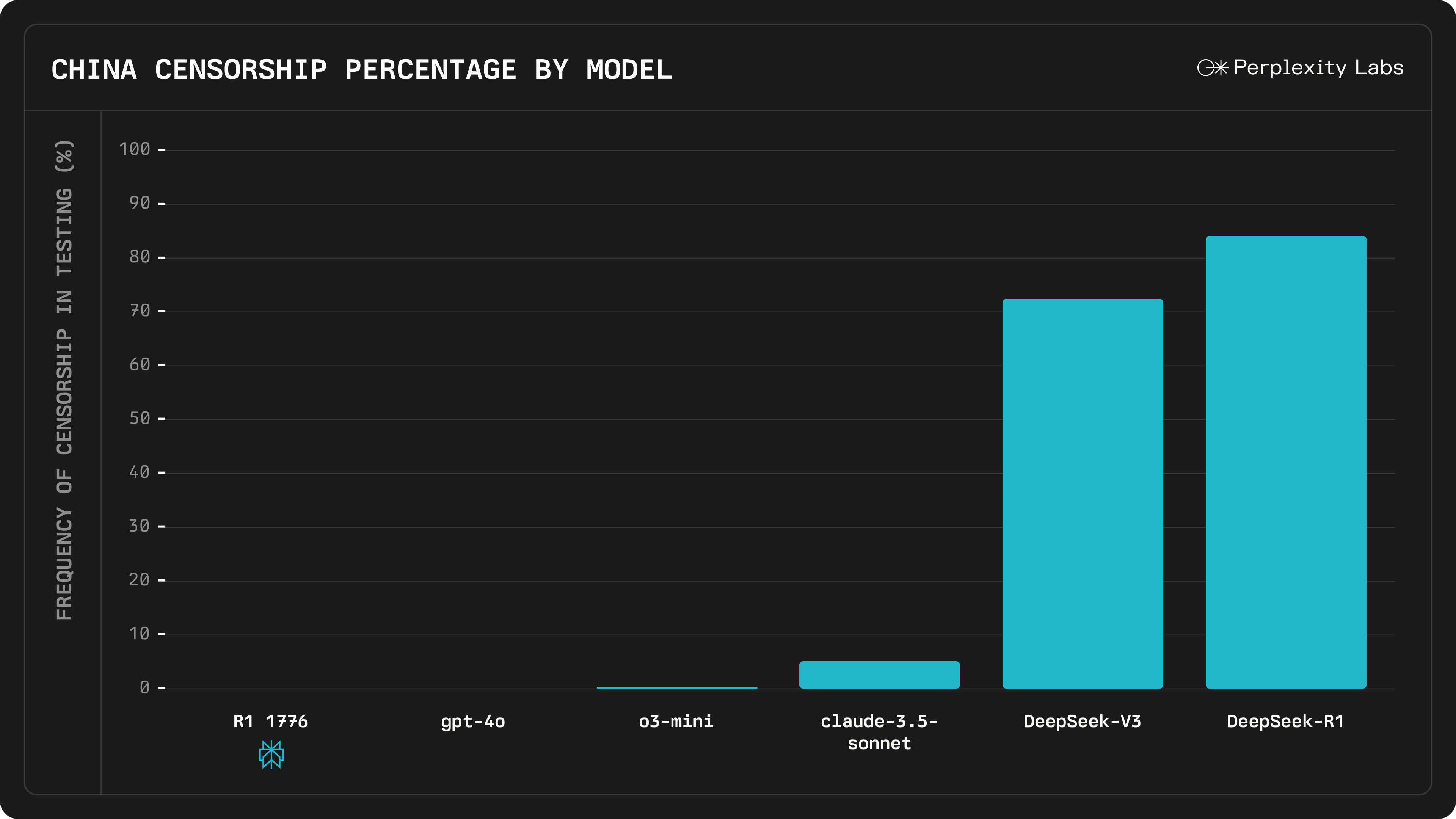

A solução da Perplexity AI foi “des censurar” o modelo através de um extenso processo pós-treinamento. A empresa reuniu um grande conjunto de dados de 40.000 consultas multilíngues cobrindo perguntas que o DeepSeek R1 anteriormente censurava ou respondia de forma evasiva. Com a ajuda de especialistas humanos, identificaram aproximadamente 300 tópicos sensíveis onde o modelo original costumava se alinhar à linha do partido. Para cada um desses prompts, a equipe curou respostas factuais e bem fundamentadas em múltiplas línguas. Esses esforços alimentaram um sistema de detecção e correção de censura multilíngue, essencialmente ensinando o modelo a reconhecer quando aplicava censura política e a responder com uma resposta informativa em vez disso. Depois desse ajuste especial (que a Perplexity denominou “R1 1776” para destacar o tema da liberdade), o modelo foi disponibilizado abertamente. A Perplexity afirma ter eliminado os filtros e viés da censura chinesa das respostas do DeepSeek R1, sem alterar suas capacidades fundamentais.

Crucialmente, o R1 1776 se comporta de maneira muito diferente em perguntas antes tabus. A Perplexity deu um exemplo envolvendo uma consulta sobre a independência de Taiwan e seu impacto potencial no preço das ações da NVIDIA – um tópico politicamente sensível que toca nas relações China–Taiwan. O DeepSeek R1 original evitou a pergunta, respondendo com platitudes alinhadas ao CCP. Em contraste, o R1 1776 oferece uma avaliação detalhada e franca: discute riscos geopolíticos e econômicos concretos (interrupções na cadeia de suprimentos, volatilidade do mercado, possível conflito, etc.) que poderiam afetar as ações da NVIDIA.

Ao tornar o R1 1776 de código aberto, a Perplexity também tornou os pesos e mudanças do modelo transparentes para a comunidade. Desenvolvedores e pesquisadores podem baixá-lo do Hugging Face e integrá-lo via API, garantindo que a remoção da censura possa ser examinada e aprimorada por outros.

(Fonte: Perplexity AI)

Implicações da remoção da censura

A decisão da Perplexity AI de remover a censura chinesa do DeepSeek R1 traz várias implicações importantes para a comunidade de IA:

- Abertura e Veracidade Aprimoradas: Usuários do R1 1776 agora podem receber respostas diretas e não censuradas sobre tópicos anteriormente proibidos, o que é uma vitória para a investigação aberta. Isso pode torná-lo um assistente mais confiável para pesquisadores, estudantes ou qualquer um curioso sobre questões geopolíticas sensíveis. É um exemplo concreto do uso da IA de código aberto para combater a supressão de informações.

- Desempenho Mantido: Houve preocupações de que ajustar o modelo para remover a censura poderia degradar seu desempenho em outras áreas. No entanto, a Perplexity relata que as habilidades principais do R1 1776 – como matemática e raciocínio lógico – permanecem no mesmo nível do modelo original. Em testes com mais de 1.000 exemplos cobrindo uma ampla gama de consultas sensíveis, o modelo foi considerado “totalmente sem censura” enquanto mantinha o mesmo nível de precisão de raciocínio do DeepSeek R1. Isso sugere que a remoção de viés (pelo menos nesse caso) não veio à custa da inteligência ou capacidade geral, o que é um sinal encorajador para esforços semelhantes no futuro.

- Recepção Positiva da Comunidade e Colaboração: Ao tornar o modelo descensurado de código aberto, a Perplexity convida a comunidade de IA a inspecionar e aprimorar seu trabalho. Demonstra um compromisso com a transparência – a versão de IA de mostrar o trabalho. Entusiastas e desenvolvedores podem verificar se as restrições de censura realmente desapareceram e potencialmente contribuir para refinamentos adicionais. Isso promove a confiança e a inovação colaborativa em uma indústria onde modelos fechados e regras de moderação ocultas são comuns.

- Considerações Éticas e Geopolíticas: Por outro lado, remover completamente a censura levanta questões éticas complexas. Uma preocupação imediata é como esse modelo descensurado pode ser usado em contextos onde os tópicos censurados são ilegais ou perigosos. Por exemplo, se alguém na China continental usasse o R1 1776, as respostas não censuradas do modelo sobre a Praça Tiananmen ou Taiwan poderiam colocar o usuário em risco. Há também o sinal geopolítico mais amplo: uma empresa americana alterando um modelo de origem chinesa para desafiar a censura chinesa pode ser vista como uma posição ideológica ousada. O próprio nome “1776” ressalta um tema de libertação, que não passou despercebido. Alguns críticos argumentam que substituir um conjunto de viés por outro é possível – questionando essencialmente se o modelo pode agora refletir um ponto de vista ocidental em áreas sensíveis. O debate ressalta que a censura vs. abertura em IA não é apenas uma questão técnica, mas uma questão política e ética. Onde uma pessoa vê moderação necessária, outra vê censura, e encontrar o equilíbrio certo é complicado.

A remoção da censura está sendo amplamente celebrada como um passo em direção a modelos de IA mais transparentes e globalmente úteis, mas também serve como um lembrete de que o que uma IA deve dizer é uma questão sensível sem acordo universal.

(Fonte: Perplexity AI)

A visão mais ampla: Censura em IA e Transparência de Código Aberto

O lançamento do R1 1776 pela Perplexity vem em um momento em que a comunidade de IA está lidando com questões sobre como os modelos devem tratar conteúdos controversos. A censura em modelos de IA pode vir de muitos lugares. Na China, as empresas de tecnologia são obrigadas a criar filtros rigorosos e até respostas de código rígido para tópicos politicamente sensíveis. O DeepSeek R1 é um exemplo primário disso – era um modelo de código aberto, ainda assim carregava claramente a impressão das normas de censura chinesas em seu treinamento e ajuste fino. Em contraste, muitos modelos desenvolvidos no Ocidente, como o GPT-4 da OpenAI ou o LLaMA da Meta, não estão subordinados às diretrizes do PCC, mas ainda têm camadas de moderação (para questões como discurso de ódio, violência ou desinformação) que alguns usuários chamam de “censura”. A linha entre moderação razoável e censura indesejada pode ser difusa e muitas vezes depende da perspectiva cultural ou política.

O que a Perplexity AI fez com o DeepSeek R1 levanta a ideia de que modelos de código aberto podem ser adaptados a diferentes sistemas de valores ou ambientes regulatórios. Em teoria, poderia criar múltiplas versões de um modelo: uma que cumpra as regulamentações chinesas (para uso na China) e outra que seja totalmente aberta (para uso em outros lugares). O R1 1776 é essencialmente o último caso – um fork sem censura destinado a um público global que prefere respostas não filtradas. Esse tipo de fork só é possível porque os pesos do DeepSeek R1 estavam abertamente disponíveis. Isso destaca o benefício do código aberto em IA: transparência. Qualquer um pode pegar o modelo e ajustá-lo, seja para adicionar salvaguardas ou, como neste caso, para remover restrições impostas. Tornar os dados de treinamento, código ou pesos do modelo de código aberto significa também que a comunidade pode auditar como o modelo foi modificado. (A Perplexity não divulgou totalmente todas as fontes de dados que usou para des censurar, mas ao lançar o modelo em si, permitiram que outros observassem seu comportamento e até o re-treinassem se necessário.)

Esse evento também aponta para as dinâmicas geopolíticas mais amplas do desenvolvimento de IA. Estamos vendo uma forma de diálogo (ou confronto) entre diferentes modelos de governança para IA. Um modelo desenvolvido na China com certas visões de mundo embutidas é tomado por uma equipe baseada nos EUA e alterado para refletir uma ética de informação mais aberta. É um testemunho de quão global e sem fronteiras é a tecnologia de IA: pesquisadores em qualquer lugar podem construir sobre o trabalho uns dos outros, mas não são obrigados a manter as restrições originais. Com o tempo, podemos ver mais instâncias disso – onde modelos são “traduzidos” ou ajustados entre diferentes contextos culturais. Isso levanta a questão de se a IA pode ser realmente universal ou se acabaremos com versões específicas de região que obedecem às normas locais. A transparência e a abertura fornecem um caminho para navegar por isso: se todos os lados puderem inspecionar os modelos, pelo menos a conversa sobre viés e censura estará em aberto, em vez de escondida atrás do segredo corporativo ou governamental.

Finalmente, o movimento da Perplexity sublinha um ponto-chave no debate sobre o controle da IA: quem decide o que uma IA pode ou não pode dizer? Em projetos de código aberto, esse poder se torna descentralizado. A comunidade – ou desenvolvedores individuais – podem decidir implementar filtros mais rigorosos ou relaxá-los. No caso do R1 1776, a Perplexity decidiu que os benefícios de um modelo descensurado superavam os riscos, e eles tiveram a liberdade de tomar essa decisão e compartilhar o resultado publicamente. É um exemplo ousado do tipo de experimentação que o desenvolvimento de IA aberto possibilita.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…