O CEO da Nvidia, Jensen Huang, previu que um dia teremos um bilhão de carros nas estradas e que todos eles serão carros robóticos.

Isso pode parecer ficção científica, mas como Huang já disse antes, “Eu sou a ficção científica.” Ele fez esses comentários durante uma teleconferência com analistas sobre os resultados do quarto trimestre fiscal da Nvidia, encerrado em 26 de janeiro de 2025. (Aqui está nosso relatório completo sobre os resultados). As ações da Nvidia estão atualmente em baixa de meio por cento, a $130,72 por ação, durante as negociações fora do horário normal.

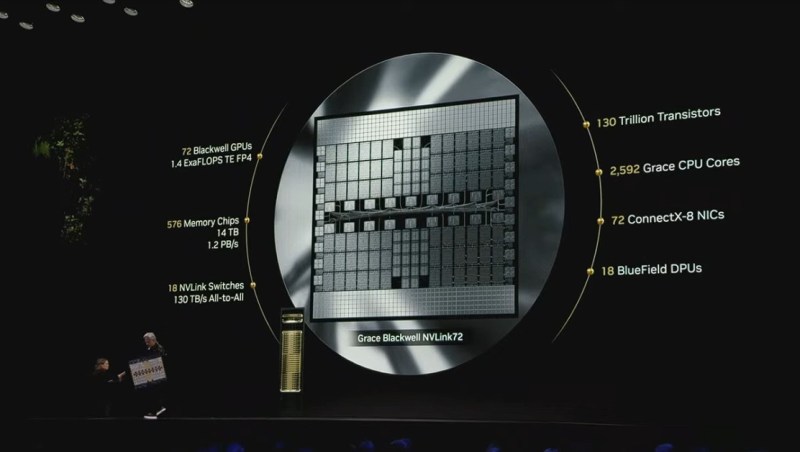

Colette Kress, EVP e CFO, afirmou na teleconferência que o setor de data centers aumentou 93% em relação ao ano anterior e 16% sequencialmente, à medida que a produção do Blackwell começou e as vendas do chip Hopper também cresceram. As vendas do Blackwell superaram as expectativas da Nvidia, disse ela.

“Esta é a mais rápida evolução de produto na história da nossa empresa, sem precedentes em velocidade e escala,” disse Kress. “A produção do Blackwell está em pleno andamento em várias configurações e aumentando a oferta,

expandindo a adoção dos clientes. Nossa receita de computação em data centers no Q4 saltou 18% sequencialmente e mais de 2x em relação ao ano anterior. Os clientes estão correndo para escalar a infraestrutura para treinar a próxima geração de modelos de ponta e desbloquear o próximo nível de capacidades de IA.”

Com o Blackwell, será comum que esses clusters comecem com 100.000 unidades de processamento gráfico (GPUs) ou mais, disse Kress. As remessas já começaram para múltiplas infraestruturas desse tamanho. O treinamento e a personalização do modelo estão alimentando a demanda por infraestrutura e software da Nvidia, enquanto desenvolvedores e empresas utilizam técnicas como ajuste fino, aprendizado por reforço e destilação para personalizar modelos. Apenas a Hugging Face publicou mais de 90.000 derivados criados a partir do modelo de base Llama.

A escala do treinamento posterior e da personalização do modelo é massiva e pode demandar coletivamente ordens de magnitude mais computação do que o pré-treinamento, disse Kress. E a demanda de inferência está acelerando, impulsionada pela escalabilidade do tempo de teste e por novos modelos de raciocínio, como OpenAI O3, DeepSeek e mais. Kress afirmou que esperava que as vendas na China aumentassem sequencialmente, e Huang mencionou que a porcentagem da China deve ser a mesma do Q4. Isso representa cerca da metade do que era antes das restrições de exportação introduzidas pela administração Biden.

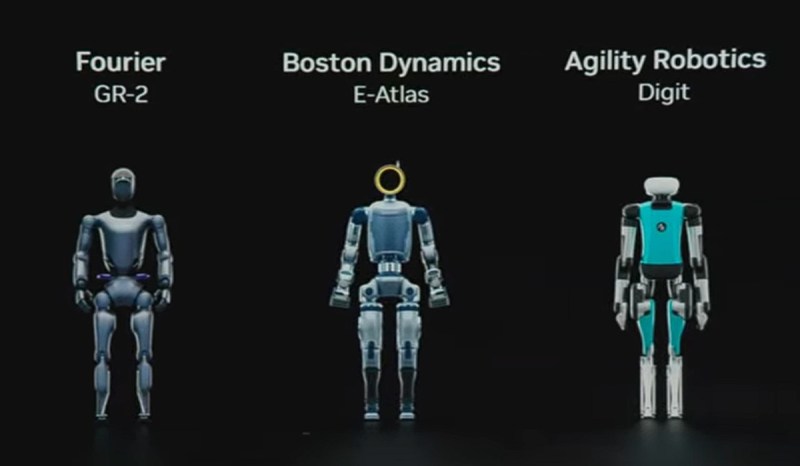

A Nvidia conseguiu uma redução de 200 vezes nos custos de inferência apenas nos últimos dois anos, disse Kress. Ela também afirmou que, à medida que a IA se expande além do mundo digital, as infraestruturas e as plataformas de software da Nvidia estão sendo cada vez mais adotadas para impulsionar o desenvolvimento de robótica e IA física. Além disso, espera-se que a receita vertical automotiva da Nvidia também cresça.

Em relação à CES, ela observou que a plataforma de modelo de fundação Nvidia Cosmo World foi revelada lá, e as empresas de robótica e automotivas — incluindo a Uber — foram algumas das primeiras a adotá-la.

Do ponto de vista geográfico, o potencial de crescimento da receita de data centers foi mais forte nos EUA, impulsionado pela rampagem inicial. Países ao redor do mundo estão construindo seus ecossistemas de IA, e a demanda por infraestrutura de computação está numa busca, com os 200 bilhões de euros de investimento em IA da França e as iniciativas de investimento de 200 bilhões de euros da UE oferecendo um vislumbre do desenvolvimento que deve redefinir a infraestrutura global de IA nos próximos anos.

Kress disse que, como uma porcentagem da receita total de data center, as vendas de data center na China permaneceram bem abaixo dos níveis vistos antes do início das restrições de exportação. Na ausência de qualquer mudança nas regulamentações, a Nvidia acredita que as remessas para soluções de data center na China permanecerão aproximadamente no mesmo nível.

“Continuaremos a cumprir as restrições de exportação enquanto atendemos nossos clientes,” disse Kress.

Gaming e PCs de IA

Kress observou que a receita de jogos de $2,5 bilhões diminuiu 22% sequencialmente e 11% em relação ao ano anterior.

No ano inteiro, a receita de $11,4 bilhões aumentou 9% em relação ao ano anterior, e a demanda permaneceu forte durante todo o período de festas. Mas Kress disse que as remessas do Q4 foram impactadas por restrições de fornecimento.

“Esperamos um forte crescimento sequencial no Q1 à medida que a oferta aumenta, com a nova série de GPUs GeForce RTX 50 para desktops e laptops, projetadas para jogadores, criadores e desenvolvedores,” disse Kress.

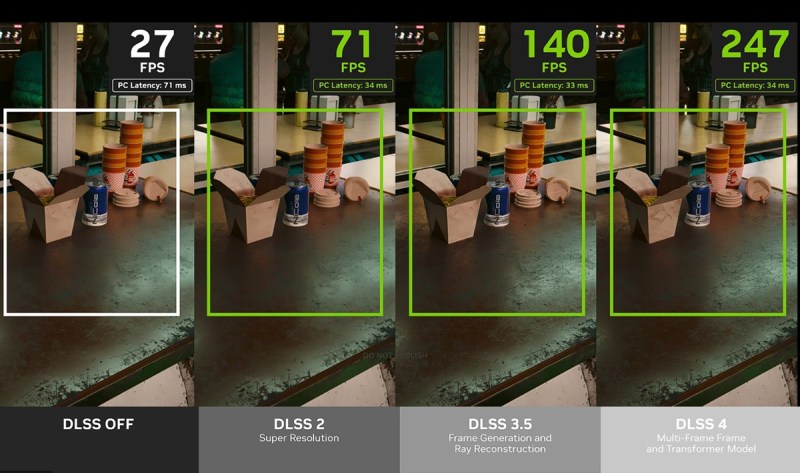

As placas gráficas da série RTX 50 utilizam a arquitetura Blackwell, núcleos Tensor de quinta geração e núcleos RT de quarta geração. O software DLSS4 aumenta as taxas de quadros em até oito vezes em relação à geração anterior, transformando um quadro renderizado em três.

A receita automotiva atingiu um recorde de $570 milhões, aumentando 27% sequencialmente e 103% em relação ao ano anterior. No ano inteiro, a receita de $1,7 bilhões aumentou 55% em relação ao ano anterior. O forte crescimento foi impulsionado pela continuação da produção de veículos autônomos, incluindo carros e robótica.

Na CES, anunciamos que a Toyota, a maior montadora do mundo, construirá seus próximos veículos com o Nvidia Orin, que está funcionando com a certificação de segurança da Nvidia Drive. Kress disse que a Nvidia viu custos de desenvolvimento de engenharia mais altos no trimestre, à medida que mais chips entraram em produção.

A Nvidia espera uma receita de FYQ1 de $43 bilhões, com crescimento sequencial da receita de data centers tanto para computação quanto para rede.

O próximo grande evento da Nvidia é a conferência anual GTC, que começa em 17 de março em San Jose, Califórnia, onde Huang fará o discurso principal no dia 18 de março.

Questionado sobre a linha tênue entre treinamento e inferência, Huang disse que existem “múltiplas leis de escala” agora, incluindo a lei de escala de pré-treinamento, a escala pós-treinamento usando aprendizado por reforço e a escala computacional do tempo de teste ou raciocínio. Esses métodos estão no início e mudarão ao longo do tempo.

“Executamos todos os modelos. Somos ótimos em treinamento. A vastidão da nossa computação hoje é na verdade inferência. E o Blackwell, com a ideia de modelos de raciocínio em mente, e quando você olha para o treinamento, é muitas vezes mais eficiente,” disse ele. “Mas o que é realmente impressionante é que para raciocínio em tempo de teste, os modelos de IA foram de 10 a 25 vezes mais rápidos, com uma taxa de transferência 25 vezes maior.”

Ele observou que está mais entusiasmado hoje do que estava na CES, e mencionou que 1,5 milhão de componentes entrarão em cada um dos racks baseados em Blackwell. Ele disse que o trabalho não é fácil, mas todos os parceiros do Blackwell estão fazendo um bom trabalho. Durante a rampagem do Blackwell, as margens brutas estarão nos baixos 70 pontos percentuais.

“Nesse momento, estamos focando em acelerar nossa fabricação para garantir que possamos fornecer” chips Blackwell aos clientes o mais rápido possível, disse Kress. Há uma oportunidade de melhorar as margens brutas ao longo do tempo para a casa dos 70% mais tarde neste ano.

Huang observou que a grande maioria do software será baseada em aprendizado de máquina e computação acelerada. Ele disse que o número de startups de IA ainda é bastante vibrante e que a IA agente para empresas está em ascensão. Ele destacou que a IA física para robótica e a IA Soberana para diferentes regiões estão crescendo.

O Blackwell Ultra é esperado na segunda metade do ano como “o próximo trem,” disse Huang. Ele observou que o primeiro Blackwell teve um “solavanco” que custou alguns meses, mas agora está totalmente recuperado.

Ele enfatizou a vantagem central que a Nvidia possui sobre os concorrentes, afirmando que a pilha de software é “incrivelmente difícil” e que a empresa constrói sua pilha de ponta a ponta, incluindo a arquitetura e o ecossistema que está acima da arquitetura.

Questionado sobre diferenças geográficas, Huang respondeu: “A conclusão é que a IA é software. É software moderno. É um software incrivelmente moderno, e a IA se tornou mainstream. A IA é usada em serviços de entrega em toda parte, em serviços de compras por toda parte. E é seguro dizer que a IA se tornou mainstream, sendo integrada em cada aplicativo. Esta é agora uma ferramenta de software que pode abordar uma parte muito maior do PIB mundial do que em qualquer época da história. Estamos apenas no começo.”

GB Daily

Fique por dentro! Receba as últimas notícias em sua caixa de entrada diariamente

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

OpenAI está supostamente em negociações para comprar a Windsurf por $3 bilhões, com novidades esperadas para esta semana.

[the_ad id="145565"] A Windsurf, fabricante de um popular assistente de codificação por IA, está em negociações para ser adquirida pela OpenAI por cerca de $3 bilhões, segundo…

A OpenAI procurou o criador do Cursor antes de iniciar negociações para comprar a Windsurf por $3 bilhões.

[the_ad id="145565"] Quando a notícia de que a OpenAI estava em negociações para adquirir a empresa de codificação AI Windsurf por $3 bilhões surgiu, uma das primeiras…

Como a IA está redesenhando os mapas de eletricidade do mundo: Insights do Relatório da AIE

[the_ad id="145565"] A inteligência artificial (IA) não está apenas transformando a tecnologia; ela também está mudando de forma significativa o setor energético global. De…