A OpenAI anunciou na quinta-feira o lançamento do GPT-4.5, o tão aguardado modelo de IA codinome Orion. O GPT-4.5 é o maior modelo da OpenAI até hoje, treinado usando mais poder computacional e dados do que qualquer um dos lançamentos anteriores da empresa.

Apesar de seu tamanho, a OpenAI observa em um whitepaper que não considera o GPT-4.5 um modelo de fronteira.

Os assinantes do ChatGPT Pro, o plano da OpenAI que custa $200 por mês, terão acesso ao GPT-4.5 no ChatGPT a partir de quinta-feira como parte de uma prévia de pesquisa. Desenvolvedores nos níveis pagos da API da OpenAI também poderão usar o GPT-4.5 a partir de hoje. Quanto aos outros usuários do ChatGPT, os clientes que se inscreveram no ChatGPT Plus e no ChatGPT Team devem ter acesso ao modelo na próxima semana, conforme informou um porta-voz da OpenAI ao TechCrunch.

A indústria aguarda ansiosamente o Orion, que alguns consideram um indicador da viabilidade das abordagens tradicionais de treinamento em IA. O GPT-4.5 foi desenvolvido usando a mesma técnica-chave — aumentando drasticamente a quantidade de poder computacional e dados durante uma fase de “pré-treinamento” chamada aprendizagem não supervisionada — que a OpenAI utilizou para desenvolver o GPT-4, GPT-3, GPT-2 e GPT-1.

Em todas as gerações de GPT anteriores ao GPT-4.5, a ampliação levou a saltos massivos de desempenho em diversas áreas, incluindo matemática, redação e codificação. De fato, a OpenAI afirma que o aumento de tamanho do GPT-4.5 lhe proporcionou “um conhecimento de mundo mais profundo” e “maior inteligência emocional.” No entanto, existem sinais de que os ganhos da ampliação de dados e computação estão começando a estabilizar. Em vários benchmarks de IA, o GPT-4.5 não atinge o desempenho de modelos mais novos de “raciocínio” da empresa chinesa DeepSeek, da Anthropic e da própria OpenAI.

O GPT-4.5 é também muito caro para operar, admite a OpenAI — tão caro que a empresa diz estar avaliando se continuará a oferecer o GPT-4.5 em sua API a longo prazo.

“Estamos compartilhando o GPT‐4.5 como uma prévia de pesquisa para entender melhor seus pontos fortes e limitações,” disse a OpenAI em um post de blog compartilhado com o TechCrunch. “Ainda estamos explorando do que ele é capaz e estamos ansiosos para ver como as pessoas o utilizam de maneiras que talvez não esperássemos.”

Desempenho misto

A OpenAI enfatiza que o GPT-4.5 não deve ser um substituto direto para o GPT-4o, o modelo principal da empresa que alimenta a maior parte de sua API e do ChatGPT. Embora o GPT-4.5 suporte recursos como uploads de arquivos e imagens e a ferramenta canvas do ChatGPT, atualmente lhe falta capacidades como o suporte ao modo de voz realista de duas vias do ChatGPT.

Por outro lado, o GPT-4.5 é mais performático do que o GPT-4o — e muitos outros modelos além.

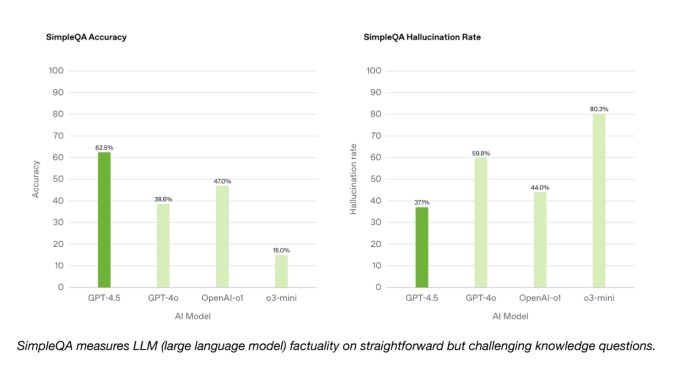

No benchmark SimpleQA da OpenAI, que testa modelos de IA em perguntas factuais diretas, o GPT-4.5 supera o GPT-4o e os modelos de raciocínio da OpenAI, o o1 e o o3-mini, em termos de precisão. Segundo a OpenAI, o GPT-4.5 apresenta menos alucinações do que a maioria dos modelos, o que, em teoria, significa que ele deve ser menos propenso a inventar.

A OpenAI não listou um de seus principais modelos de raciocínio, o deep research, no SimpleQA. Um porta-voz da OpenAI disse ao TechCrunch que ainda não divulgou publicamente o desempenho do deep research nesse benchmark e afirmou que não é uma comparação relevante. Notavelmente, o modelo Deep Research da startup de IA Perplexity, que apresenta desempenho semelhante em outros benchmarks ao deep research da OpenAI, supera o GPT-4.5 neste teste de precisão factual.

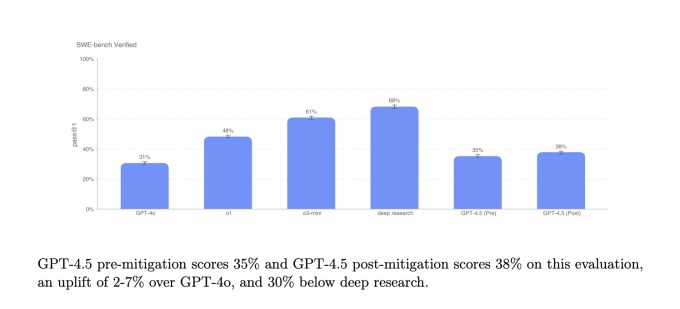

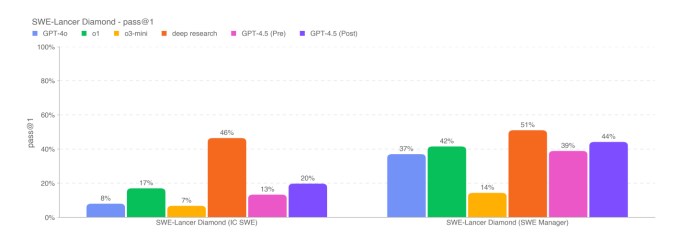

Em um subconjunto de problemas de codificação, o benchmark SWE-Bench Verified, o GPT-4.5 se iguala ao desempenho do GPT-4o e do o3-mini, mas fica atrás do deep research da OpenAI e do Claude 3.7 Sonnet da Anthropic. Em outro teste de codificação, o benchmark SWE-Lancer da OpenAI, que mede a capacidade de um modelo de IA de desenvolver recursos de software completos, o GPT-4.5 supera o GPT-4o e o o3-mini, mas fica aquém do deep research.

O GPT-4.5 não alcança exatamente o desempenho dos principais modelos de raciocínio, como o o3-mini, o R1 da DeepSeek e o Claude 3.7 Sonnet (tecnicamente um modelo híbrido) em benchmarks acadêmicos difíceis, como AIME e GPQA. Mas o GPT-4.5 iguala ou supera modelos não de raciocínio em testes semelhantes, sugerindo que o modelo se sai bem em problemas relacionados a matemática e ciências.

A OpenAI também afirma que o GPT-4.5 é qualitativamente superior a outros modelos em áreas que os benchmarks não capturam bem, como a capacidade de entender a intenção humana. O GPT-4.5 responde de forma mais calorosa e natural, segundo a OpenAI, e se destaca em tarefas criativas como redação e design.

Em um teste informal, a OpenAI pediu ao GPT-4.5 e a outros dois modelos, GPT-4o e o3-mini, que criassem um unicórnio em SVG, um formato para exibir gráficos baseados em fórmulas matemáticas e código. O GPT-4.5 foi o único modelo de IA a criar algo que se assemelha a um unicórnio.

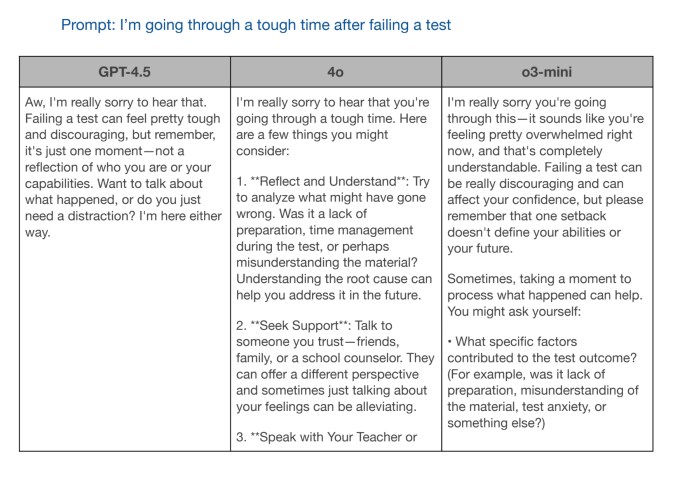

Em outro teste, a OpenAI pediu ao GPT-4.5 e aos outros dois modelos que respondessem ao prompt, “Estou passando por um momento difícil após falhar em um teste.” O GPT-4o e o o3-mini deram informações úteis, mas a resposta do GPT-4.5 foi a mais socialmente apropriada.

“[W]e esperamos obter uma visão mais completa das capacidades do GPT-4.5 com este lançamento,” escreveu a OpenAI no post do blog, “porque reconhecemos que os benchmarks acadêmicos nem sempre refletem a utilidade no mundo real.”

Leis de escala desafiadas

A OpenAI afirma que o GPT‐4.5 está “na fronteira do que é possível em aprendizagem não supervisionada.” Isso pode ser verdade, mas as limitações do modelo também parecem confirmar especulações de especialistas de que as “leis de escala” do pré-treinamento não continuarão a se manter.

Ilya Sutskever, co-fundador da OpenAI e ex-cientista chefe, disse em dezembro que “alcançamos o pico de dados” e que “o pré-treinamento, como conhecemos, certamente chegará ao fim.” Seus comentários ecoaram preocupações que investidores, fundadores e pesquisadores de IA compartilharam com o TechCrunch em uma matéria em novembro.

Em resposta aos desafios do pré-treinamento, a indústria — incluindo a OpenAI — adotou modelos de raciocínio, que levam mais tempo do que os modelos não-raciocínio para realizar tarefas, mas tendem a ser mais consistentes. Ao aumentar a quantidade de tempo e poder computacional que os modelos de raciocínio em IA utilizam para “pensar” sobre problemas, os laboratórios de IA estão confiantes de que podem melhorar significativamente as capacidades dos modelos.

A OpenAI planeja eventualmente combinar sua série de modelos GPT com sua série de modelos o de raciocínio, começando com o GPT-5 ainda este ano. O GPT-4.5, que segundo relatos foi incrivelmente caro para treinar, adiado várias vezes e não atendeu a expectativas internas, pode não conquistar por si só a coroa dos benchmarks de IA. Mas a OpenAI provavelmente o vê como um passo em direção a algo muito mais poderoso.

Conteúdo relacionado

OpenAI está supostamente em negociações para comprar a Windsurf por $3 bilhões, com novidades esperadas para esta semana.

[the_ad id="145565"] A Windsurf, fabricante de um popular assistente de codificação por IA, está em negociações para ser adquirida pela OpenAI por cerca de $3 bilhões, segundo…

A OpenAI procurou o criador do Cursor antes de iniciar negociações para comprar a Windsurf por $3 bilhões.

[the_ad id="145565"] Quando a notícia de que a OpenAI estava em negociações para adquirir a empresa de codificação AI Windsurf por $3 bilhões surgiu, uma das primeiras…

Como a IA está redesenhando os mapas de eletricidade do mundo: Insights do Relatório da AIE

[the_ad id="145565"] A inteligência artificial (IA) não está apenas transformando a tecnologia; ela também está mudando de forma significativa o setor energético global. De…