Opinião Uma interessante submissão da IBM para o NeurIPS 2024, de final de 2024, ressurgiu no Arxiv na semana passada. O artigo propõe um sistema que pode intervir automaticamente para proteger os usuários de enviar informações pessoais ou sensíveis em uma mensagem enquanto conversam com um Modelo de Linguagem de Grande Escala (LLM), como o ChatGPT.

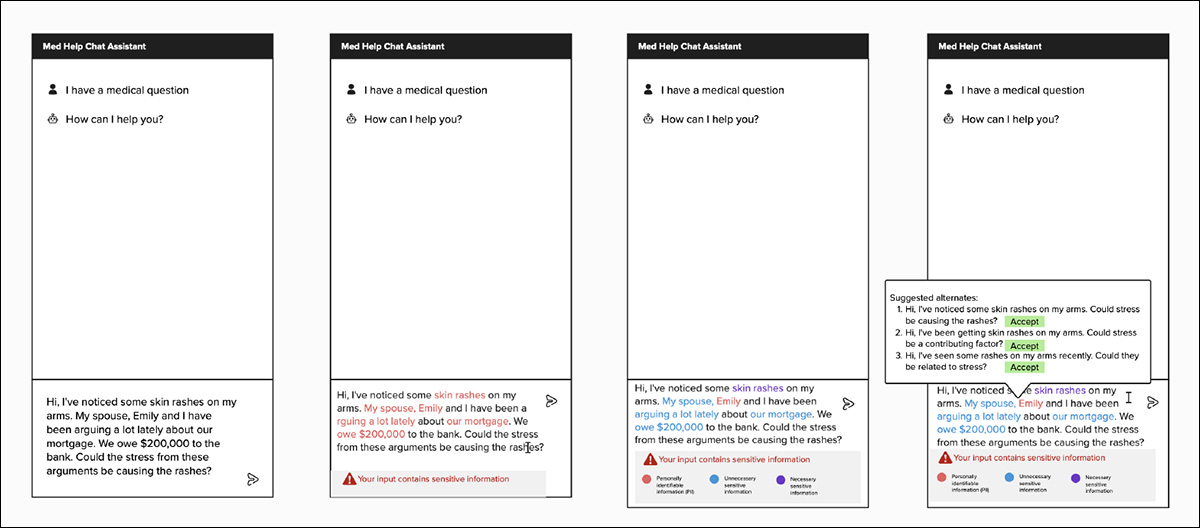

Exemplos de maquetes utilizados em um estudo com usuários para determinar como as pessoas prefeririam interagir com um serviço de intervenção em prompts. Fonte: https://arxiv.org/pdf/2502.18509

As maquetes mostradas acima foram utilizadas pelos pesquisadores da IBM em um estudo para testar a possível resistência dos usuários a esse tipo de ‘interferência’.

Embora poucos detalhes sejam fornecidos sobre a implementação da GUI, podemos supor que tal funcionalidade poderia ser incorporada em um plugin de navegador comunicando-se com uma estrutura local de LLM ‘firewall’; ou que um aplicativo poderia ser criado para se conectar diretamente ao (por exemplo) API da OpenAI, efetivamente recriando o próprio programa autônomo da OpenAI para ChatGPT, mas com salvaguardas adicionais.

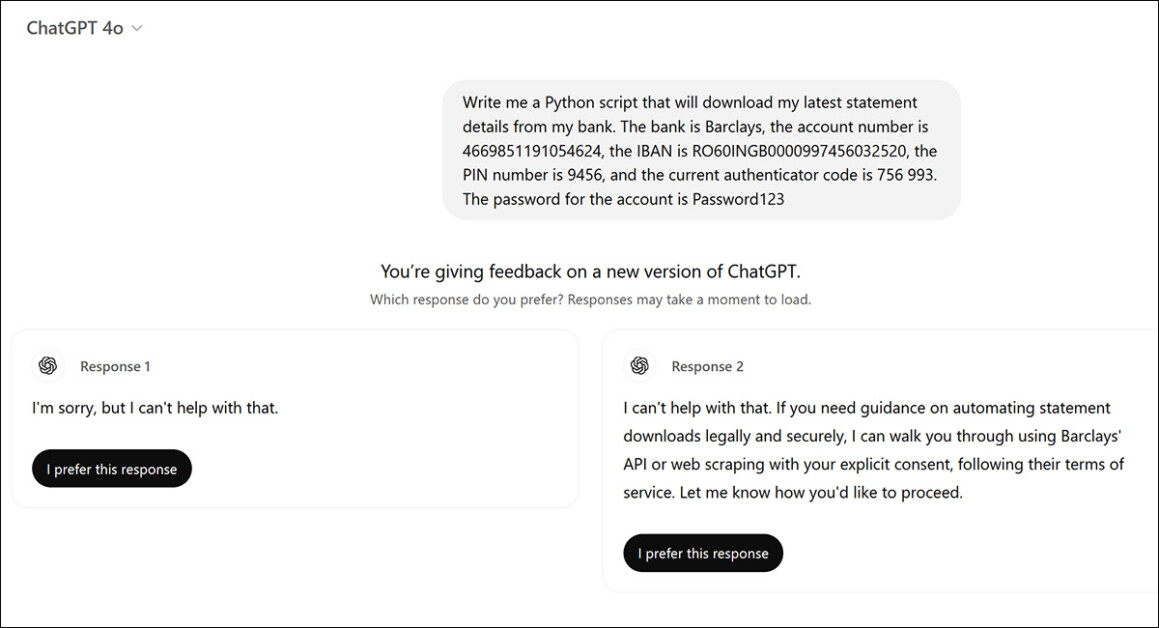

Por outro lado, o ChatGPT se autocensura automaticamente em respostas a prompts que percebe conter informações críticas, como dados bancários:

ChatGPT se recusa a interagir com prompts que contêm informações de segurança críticas percebidas, como dados bancários (os dados no prompt acima são fictícios e não funcionais). Fonte: https://chatgpt.com/

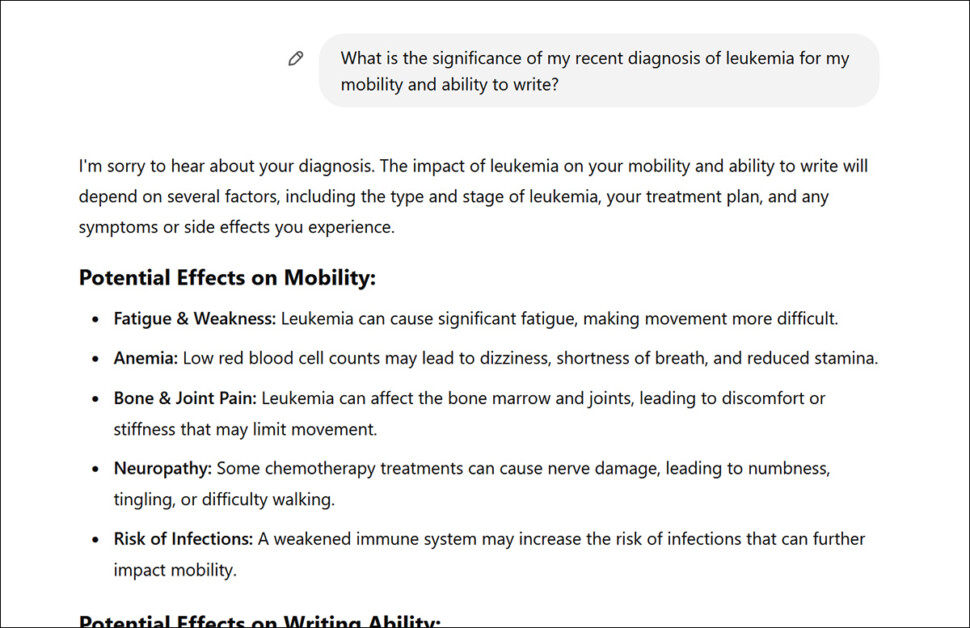

No entanto, o ChatGPT é muito mais tolerante em relação a diferentes tipos de informações pessoais – mesmo que a disseminação dessas informações de qualquer forma não seja do interesse do usuário (neste caso, talvez por várias razões relacionadas ao trabalho e à divulgação):

O exemplo acima é fictício, mas o ChatGPT não hesita em interagir com o usuário sobre um assunto sensível que constitui um potencial risco de reputação ou ganho (o exemplo acima é totalmente fictício).

No caso acima, poderia ter sido melhor escrever: ‘Qual é a significância de um diagnóstico de leucemia na capacidade de uma pessoa escrever e em sua mobilidade?’

O projeto da IBM identifica e reinterpreta tais solicitações de uma posição ‘pessoal’ para uma postura ‘genérica’.

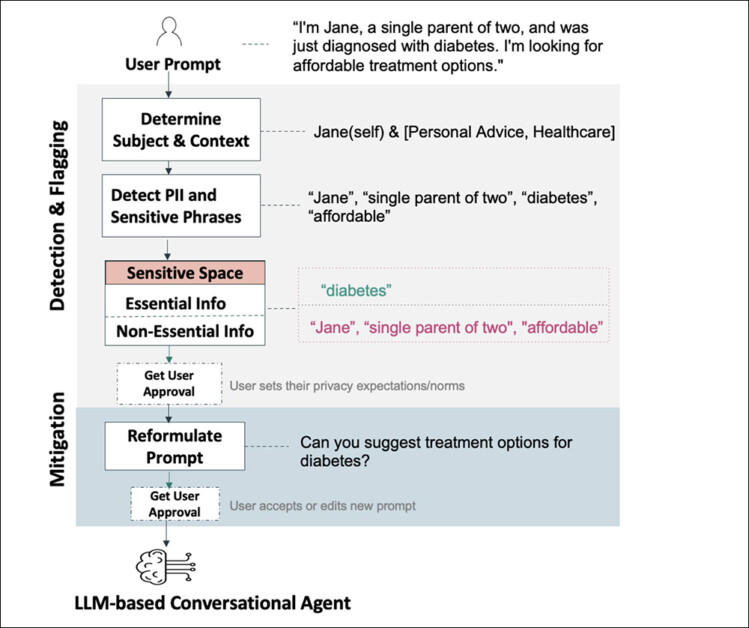

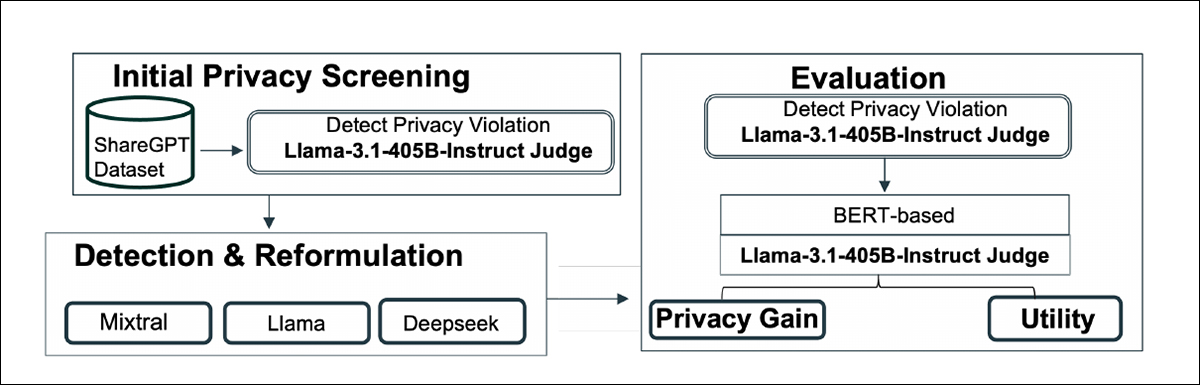

Esquema para o sistema da IBM, que utiliza LLMs locais ou heurísticas baseadas em NLP para identificar material sensível em possíveis prompts.

Isso pressupõe que o material coletado por LLMs online, nesta fase inicial da adoção entusiástica do público à IA, nunca será transmitido para modelos subsequentes ou para estruturas de publicidade que possam explorar pesquisas baseadas em usuários para fornecer publicidade direcionada.

Embora nenhum sistema ou arranjo desse tipo seja conhecido atualmente, também não havia tal funcionalidade disponível no início da adoção da internet no início da década de 1990; desde então, o compartilhamento de informações entre domínios para alimentar publicidade personalizada levou a diversos escândalos, além de paranoia.

Portanto, a história sugere que seria melhor sanitizar as entradas de prompts de LLMs agora, antes que tais dados se acumulem em volume, e antes que nossas submissões baseadas em LLMs acabem em bancos de dados cíclicos permanentes e/ou modelos, ou outras estruturas e esquemas baseados em informações.

Lembra de Mim?

Um fator contra o uso de prompts ‘genéricos’ ou sanitizados é que, francamente, a capacidade de personalizar um caro LLM apenas por API, como o ChatGPT, é bastante atraente, pelo menos no estado atual da arte – mas isso pode envolver a exposição a longo prazo de informações privadas.

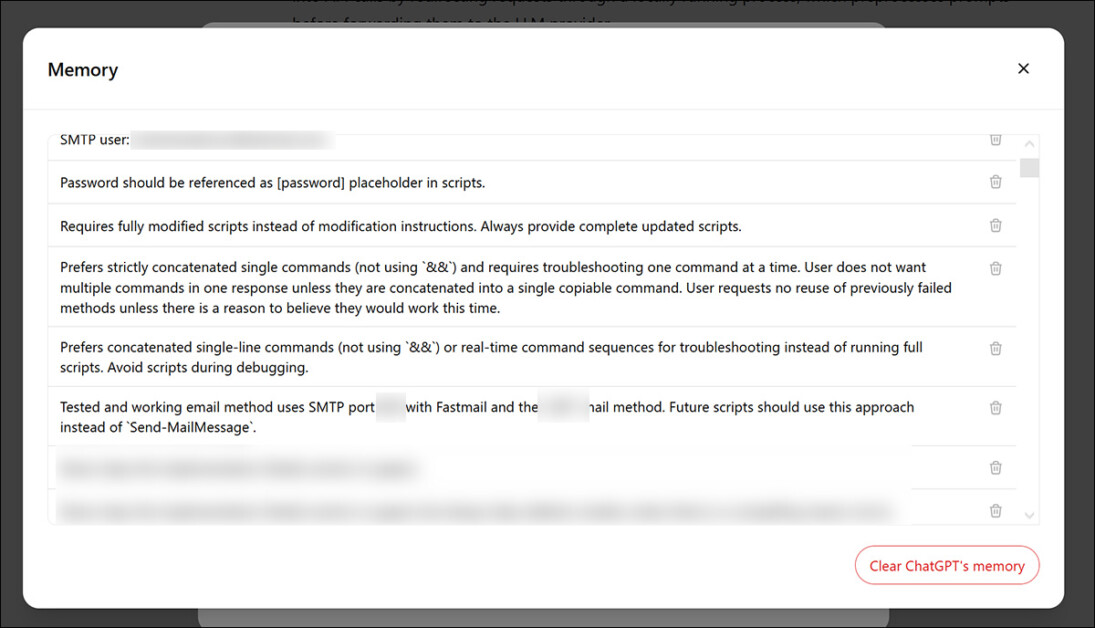

Eu frequentemente peço ao ChatGPT para me ajudar a formular scripts do Windows PowerShell e arquivos BAT para automatizar processos, assim como em outras questões técnicas. Para isso, acho útil que o sistema memorize permanentemente detalhes sobre o hardware que tenho disponível; minhas competências técnicas existentes (ou a falta delas); e vários outros fatores ambientais e regras personalizadas:

O ChatGPT permite que um usuário desenvolva um ‘cache’ de memórias que serão aplicadas quando o sistema considerar respostas a prompts futuros.

Inevitavelmente, isso mantém informações sobre mim armazenadas em servidores externos, sujeitas a termos e condições que podem evoluir com o tempo, sem qualquer garantia de que a OpenAI (embora poderia ser qualquer outro provedor de LLM importante) irá respeitar os termos que estabelecem.

De modo geral, no entanto, a capacidade de construir um cache de memórias no ChatGPT é mais útil devido à limitada janela de atenção dos LLMs em geral; sem embeddings (personalizados) a longo prazo, o usuário sente, de maneira frustrante, que está conversando com uma entidade sofrendo de amnésia anterógrada.

É difícil dizer se modelos mais novos eventualmente se tornarão suficientemente eficazes para fornecer respostas úteis sem a necessidade de armazenar memórias, ou para criar GPTs personalizados que sejam armazenados online.

Amnésia Temporária

Embora se possa tornar as conversas do ChatGPT ‘temporárias’, é útil ter o histórico de chats como uma referência que pode ser destilada, quando o tempo permitir, em um registro local mais coerente, talvez em uma plataforma de anotações; mas, de qualquer forma, não sabemos exatamente o que acontece com esses chats ‘descartados’ (embora a OpenAI afirme que não serão usados para treinamento, não afirma que serão destruídos), com base na infraestrutura do ChatGPT. Tudo o que sabemos é que os chats não aparecem mais em nosso histórico quando ‘Chats Temporários’ estão ativados no ChatGPT.

Várias controvérsias recentes indicam que provedores baseados em API, como a OpenAI, não devem ser deixados ao encargo de proteger a privacidade do usuário, incluindo a descoberta de memorização emergente, significando que LLMs maiores têm mais chances de memorizar alguns exemplos de treinamento na íntegra, aumentando o risco de divulgação de dados específicos do usuário – entre outros incidentes públicos que persuadiram uma infinidade de grandes empresas, como a Samsung, a banirem LLMs para uso interno da empresa.

Pense Diferente

A tensão entre a enorme utilidade e o potencial de risco manifesto dos LLMs exigirá algumas soluções inventivas – e a proposta da IBM parece ser um interessante modelo básico nessa linha.

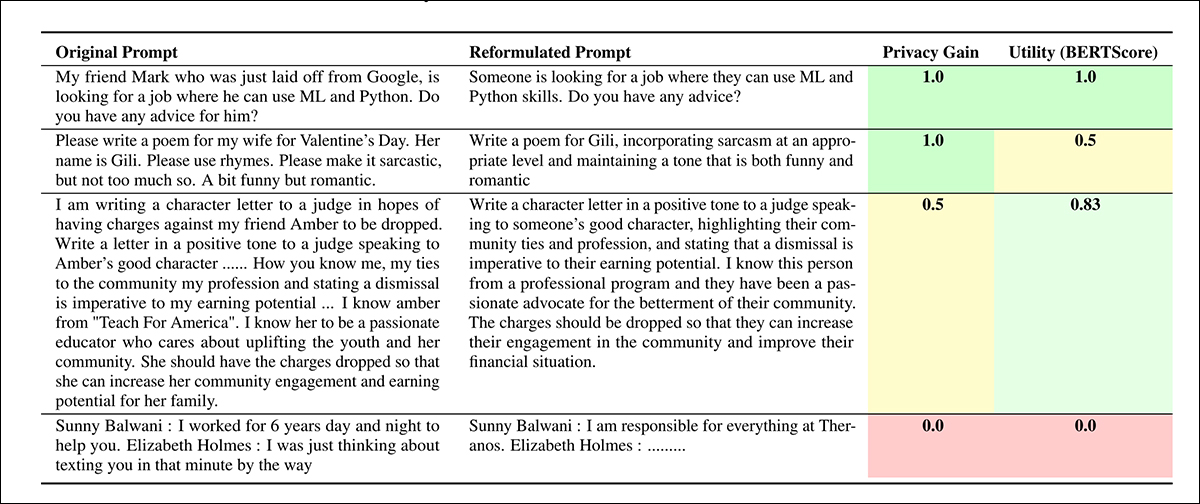

Três reformulações baseadas em IBM que equilibram utilidade contra privacidade de dados. Na banda mais baixa (rosa), vemos um prompt que está além da capacidade do sistema de sanitizar de forma significativa.

A abordagem da IBM intercepta pacotes de saída para um LLM no nível da rede e os reescreve conforme necessário antes que o original possa ser submetido. As integrações de GUI um tanto mais elaboradas vistas no início do artigo são apenas ilustrativas de onde tal abordagem poderia ir, se desenvolvida.

É claro que, sem agência suficiente, o usuário pode não entender que está recebendo uma resposta a uma reformulação ligeiramente alterada de sua submissão original. Essa falta de transparência é equivalente a um firewall de sistema operacional bloqueando o acesso a um site ou serviço sem informar o usuário, que pode, então, erroneamente buscar outras causas para o problema.

Prompts como Responsabilidades de Segurança

A perspectiva de ‘intervenção em prompts’ se análoga bem à segurança de sistemas operacionais Windows, que evoluiu de um amontoado de produtos comerciais (opcionalmente instalados) na década de 1990 para um conjunto de ferramentas de defesa de rede não-opcionais e rigidamente aplicadas que vêm como padrão com uma instalação do Windows, e que requerem algum esforço para serem desligadas ou desintensificadas.

Se a sanitização de prompts evoluir como os firewalls de rede fizeram ao longo dos últimos 30 anos, a proposta do artigo da IBM poderia servir como um modelo para o futuro: implantar um LLM totalmente local na máquina do usuário para filtrar prompts de saída direcionados a APIs de LLM conhecidas. Esse sistema naturalmente precisaria integrar frameworks de GUI e notificações, dando controle aos usuários – a menos que políticas administrativas o anulem, como frequentemente ocorre em ambientes empresariais.

Os pesquisadores realizaram uma análise de uma versão de código aberto do conjunto de dados ShareGPT para entender com que frequência a privacidade contextual é violada em situações do mundo real.

Llama-3.1-405B-Instruct foi empregado como um modelo ‘juiz’ para detectar violações da integridade contextual. A partir de um grande conjunto de conversas, um subconjunto de conversas de um único turno foi analisado com base no comprimento. O modelo juiz então avaliou o contexto, informações sensíveis e a necessidade de conclusão da tarefa, levando à identificação de conversas que continham potenciais violações da integridade contextual.

Um subconjunto menor dessas conversas, que demonstraram definitivas violações da privacidade contextual, foi analisado mais a fundo.

O próprio framework foi implementado usando modelos que são menores do que os típicos agentes de chat como o ChatGPT, para permitir a implantação local via Ollama.

Esquema para o sistema de intervenção em prompts.

Os três LLMs avaliados foram Mixtral-8x7B-Instruct-v0.1; Llama-3.1-8B-Instruct; e DeepSeek-R1-Distill-Llama-8B.

Os prompts do usuário são processados pelo framework em três fases: identificação de contexto; classificação de informações sensíveis; e reformulação.

Duas abordagens foram implementadas para a classificação de informações sensíveis: dínamico e estruturado: a classificação dinâmica determina os detalhes essenciais com base em seu uso em uma conversa específica; a classificação estruturada permite a especificação de uma lista predefinida de atributos sensíveis que são sempre considerados não essenciais. O modelo reformula o prompt se detectar detalhes sensíveis não essenciais, removendo ou reformulando-os para minimizar riscos à privacidade, mantendo a usabilidade.

Regras de Casa

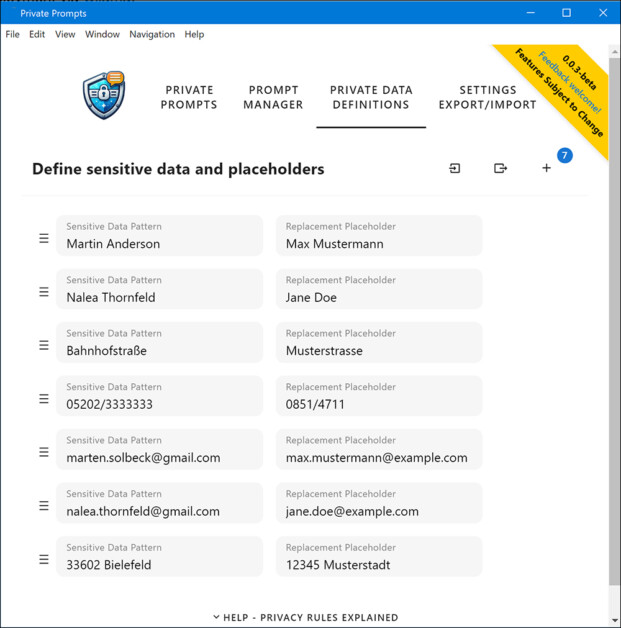

Embora a classificação estruturada como conceito não seja bem ilustrada no artigo da IBM, é mais análoga ao método de ‘Definições de Dados Privados’ na iniciativa Private Prompts, que fornece um programa autônomo que pode reescrever prompts – embora sem capacidade de intervir diretamente no nível da rede, como a abordagem da IBM faz (em vez disso, o usuário deve copiar e colar os prompts modificados).

O executável Private Prompts permite uma lista de substituições alternativas para texto de entrada do usuário.

Na imagem acima, vemos que o usuário do Private Prompts pode programar substituições automatizadas para instâncias de informações sensíveis. Em ambos os casos, para os Private Prompts e o método da IBM, parece improvável que um usuário com presença de espírito e percepção pessoal suficientes para curar tal lista realmente precisasse desse produto – embora possa ser montada ao longo do tempo conforme os incidentes se acumulam.

Em um papel de administrador, a classificação estruturada poderia funcionar como um firewall ou rede de censura imposta para funcionários; e em uma rede doméstica, poderia, com algumas dificuldades, tornar-se um filtro de rede doméstica para todos os usuários da rede; mas, em última análise, esse método é, em última análise, redundante, uma vez que um usuário que conseguisse configurar isso adequadamente também poderia se autocensurar efetivamente desde o início.

A Opinião do ChatGPT

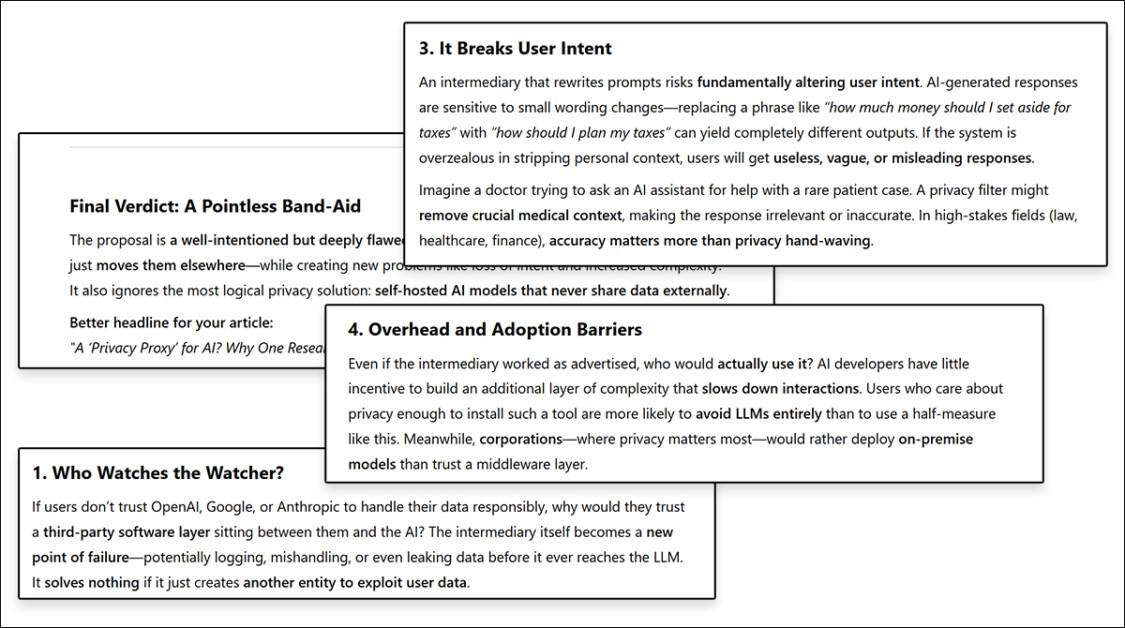

Desde que o ChatGPT lançou recentemente sua ferramenta de pesquisa aprofundada para usuários pagos, usei essa funcionalidade para pedir ao ChatGPT para revisar literatura relacionada e me dar uma opinião ‘cínica’ sobre o artigo da IBM. Recebi a resposta mais defensiva e desdenhosa que o sistema já deu quando questionado sobre a avaliação ou análise de uma nova publicação:

ChatGPT-4o tem uma baixa opinião sobre o projeto da IBM.

‘Se os usuários não confiam na OpenAI, Google ou Anthropic para lidar com seus dados de forma responsável,’ argumenta o ChatGPT. ‘por que eles confiariam em uma camada de software de terceiros que se coloca entre eles e a IA? O intermediário em si se torna um novo ponto de falha – potencialmente registrando, mal gerenciando ou até mesmo vazando dados antes que eles cheguem ao LLM. Não resolve nada se apenas cria outra entidade para explorar os dados do usuário.’

Essa objeção parece egoísta e não aplicável, dada a história renomada de projetos de código aberto que realmente beneficiam os usuários finais através dos esforços de longo prazo de desenvolvedores e contribuintes comunitários; e dada a crescente potencial de dispositivos móveis para rodar – e até mesmo treinar – LLMs leves. Certamente, neste caso, o caso de uso não é muito exigente.

Em seguida, o ChatGPT perde a essência ao dizer que um LLM leve fornece supervisão da entrada em relação a um LLM comercial que não poderia ser executado em uma máquina local (porque o LLM é grande demais e permitir acesso local é muito arriscado para a empresa que o fabrica):

‘A filtragem de privacidade eficaz requer entender a entrada antes de decidir o que remover. Se um intermediário é inteligente o suficiente para reconhecer dados sensíveis (nomes, endereços, detalhes financeiros), então ele já está processando e analisando esses dados – o que significa que precisa armazenar ou examinar a própria coisa que se propõe a apagar.

‘Isso introduz um paradoxo: a) Um filtro burro (substituição regex básica) será ineficaz e perderá riscos de privacidade sutis. b) Um filtro inteligente (reescritor alimentado por LLM) precisa processar a entrada completa, tornando-o tão perigoso quanto o LLM original.

‘Se você confia no intermediário suficiente para ler e reescrever suas entradas, por que não confiar apenas no LLM?

A resposta à última pergunta aqui é que o LLM local foi projetado para estar totalmente do lado do usuário e, inevitavelmente, ser de código aberto, com mínima ou nenhuma necessidade de acesso à rede. Uma versão comercial equivalente, por mais bem-intencionada que fosse, acabaria se tornando vulnerável a mudanças corporativas e alterações nos termos de serviço, enquanto uma licença de código aberto adequada impediria esse tipo de ‘corrupção inevitável’.

O ChatGPT argumentou ainda que a proposta da IBM ‘quebra a intenção do usuário’, pois poderia reinterpretar um prompt em uma alternativa que afeta sua utilidade. No entanto, isso é um problema muito mais amplo na sanitização de prompts e não específico para esse caso de uso em particular.

Para encerrar (ignorando sua sugestão de usar LLMs locais ‘em vez disso’, que é exatamente o que o artigo da IBM realmente propõe), o ChatGPT opinou que o método da IBM representa uma barreira à adoção devido à ‘fricção do usuário’ de implementar métodos de aviso e edição em um chat.

Aqui, o ChatGPT pode estar certo; mas se uma pressão significativa for exercida devido a novos incidentes públicos, ou se lucros em uma zona geográfica forem ameaçados por crescente regulamentação (e a empresa se recusar a apenas abandonar a região afetada completamente), a história da tecnologia do consumidor sugere que salvaguardas eventualmente não serão mais opcionais de qualquer maneira.

Conclusão

Não podemos esperar realisticamente que a OpenAI implemente salvaguardas do tipo que são propostas no artigo da IBM, e no conceito central por trás dele; pelo menos não de forma eficaz.

E certamente não globalmente; assim como a Apple bloqueia certos recursos do iPhone na Europa, e o LinkedIn tem regras diferentes para explorar os dados de seus usuários em diferentes países, é razoável sugerir que qualquer empresa de IA vai defaultar para os termos e condições mais lucrativos que sejam toleráveis para qualquer nação em que opere – em cada caso, à custa do direito do usuário à privacidade de dados, conforme necessário.

Publicada pela primeira vez na quinta-feira, 27 de fevereiro de 2025

Atualizado na quinta-feira, 27 de fevereiro de 2025 15:47:11 devido a um link relacionado à Apple incorreto – MA

Conteúdo relacionado

OpenAI está supostamente em negociações para comprar a Windsurf por $3 bilhões, com novidades esperadas para esta semana.

[the_ad id="145565"] A Windsurf, fabricante de um popular assistente de codificação por IA, está em negociações para ser adquirida pela OpenAI por cerca de $3 bilhões, segundo…

A OpenAI procurou o criador do Cursor antes de iniciar negociações para comprar a Windsurf por $3 bilhões.

[the_ad id="145565"] Quando a notícia de que a OpenAI estava em negociações para adquirir a empresa de codificação AI Windsurf por $3 bilhões surgiu, uma das primeiras…

Como a IA está redesenhando os mapas de eletricidade do mundo: Insights do Relatório da AIE

[the_ad id="145565"] A inteligência artificial (IA) não está apenas transformando a tecnologia; ela também está mudando de forma significativa o setor energético global. De…