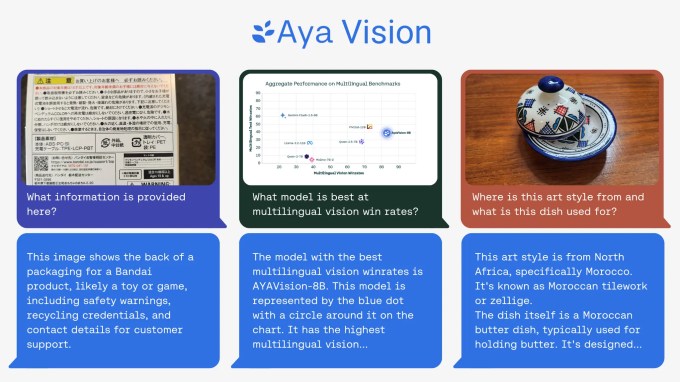

A Cohere for AI, o laboratório de pesquisa sem fins lucrativos da startup de IA Cohere, lançou esta semana um modelo de IA multimodal “aberto”, chamado Aya Vision, que o laboratório afirma ser de classe mundial.

Aya Vision pode realizar tarefas como escrever legendas para imagens, responder perguntas sobre fotos, traduzir textos e gerar resumos em 23 idiomas principais. A Cohere, que também está disponibilizando o Aya Vision gratuitamente através do WhatsApp, chamou isso de “um passo significativo para tornar os avanços técnicos acessíveis a pesquisadores em todo o mundo”.

“Embora a IA tenha feito progressos significativos, ainda há uma grande lacuna em quão bem os modelos desempenham em diferentes idiomas — uma que se torna ainda mais perceptível em tarefas multimodais que envolvem texto e imagens”, escreveu a Cohere em um postagem no blog. “O Aya Vision tem como objetivo ajudar a fechar essa lacuna.”

Aya Vision vem em algumas versões: Aya Vision 32B e Aya Vision 8B. A mais sofisticada das duas, Aya Vision 32B, estabelece uma “nova fronteira”, disse a Cohere, superando modelos duas vezes o seu tamanho, incluindo o Meta’s Llama-3.2 90B Vision em certos benchmarks de compreensão visual. Enquanto isso, o Aya Vision 8B obtém melhores resultados em algumas avaliações do que modelos dez vezes maiores, segundo a Cohere.

Ambos os modelos estão disponíveis na plataforma de desenvolvimento de IA Hugging Face sob uma licença Creative Commons 4.0 com o adendo de uso aceitável da Cohere. Eles não podem ser usados para aplicações comerciais.

A Cohere informou que o Aya Vision foi treinado usando um “conjunto diversificado” de dados em inglês, que o laboratório traduziu e utilizou para criar anotações sintéticas. Anotações, também conhecidas como marcadores ou rótulos, ajudam os modelos a entender e interpretar dados durante o processo de treinamento. Por exemplo, uma anotação para treinar um modelo de reconhecimento de imagem pode assumir a forma de marcações em torno de objetos ou legendas que se referem a cada pessoa, lugar ou objeto representado em uma imagem.

O uso de anotações sintéticas pela Cohere — ou seja, anotações geradas por IA — está em alta. Apesar de seus potenciais inconvenientes, concorrentes como a OpenAI estão cada vez mais aproveitando dados sintéticos para treinar modelos à medida que o estoque de dados do mundo real se esgota. A empresa de pesquisa Gartner estima que 60% dos dados utilizados para projetos de IA e análise no ano passado foram criados sinteticamente.

De acordo com a Cohere, treinar o Aya Vision com anotações sintéticas permitiu ao laboratório usar menos recursos enquanto atingia um desempenho competitivo.

“Isso demonstra nosso foco crítico na eficiência e em [fazer] mais usando menos poder computacional,” escreveu a Cohere em seu blog. “Isso também proporciona um maior apoio à comunidade de pesquisa, que muitas vezes tem acesso mais limitado a recursos computacionais.”

Juntamente com o Aya Vision, a Cohere também lançou um novo conjunto de benchmarks, o AyaVisionBench, projetado para avaliar as habilidades de um modelo em tarefas de “visão-linguagem”, como identificar diferenças entre duas imagens e converter capturas de tela em código.

A indústria de IA está passando pelo que alguns chamam de “crise de avaliação”, consequência da popularização de benchmarks que fornecem pontuações agregadas que correlacionam mal com a proficiência em tarefas que a maioria dos usuários de IA se importa. A Cohere afirma que o AyaVisionBench é um passo em direção à retificação disso, fornecendo uma estrutura “ampla e desafiadora” para avaliar a compreensão multimodal e cross-linguística de um modelo.

Com sorte, esse é realmente o caso.

“[O] conjunto de dados serve como um benchmark robusto para avaliar modelos de visão-linguagem em configurações multilíngues e do mundo real,” escreveram os pesquisadores da Cohere em uma postagem no Hugging Face. “Tornamos este conjunto de avaliação disponível para a comunidade de pesquisa para avançar nas avaliações multimodais multilíngues.”

Conteúdo relacionado

Audible está expandindo sua biblioteca de audiolivros narrados por IA.

[the_ad id="145565"] Audible, o serviço de audiolivros da Amazon, anunciou na terça-feira que está se unindo a editores selecionados para converter livros impressos e e-books…

Sakana apresenta nova arquitetura de IA, ‘Máquinas de Pensamento Contínuo’, para fazer modelos raciocinarem com menos orientação — como cérebros humanos.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder de inteligência…

Administração Trump revoga oficialmente as regras de difusão de IA de Biden.

[the_ad id="145565"] Após uma semana de rumores, o Departamento de Comércio dos EUA (DOC) rescindiu formalmente a Regra de Difusão de Inteligência Artificial da administração…