Inscreva-se em nossos boletins informativos diários e semanais para atualizações mais recentes e conteúdos exclusivos sobre cobertura de IA de ponta. Saiba mais

Pesquisadores da Rutgers University, Ant Group e Salesforce Research propuseram uma nova estrutura que permite que agentes de IA realizem tarefas mais complexas integrando informações de seu ambiente e criando memórias automaticamente vinculadas para desenvolver estruturas complexas.

Chamado de A-MEM, a estrutura utiliza grandes modelos de linguagem (LLMs) e embeddings vetoriais para extrair informações úteis das interações do agente e criar representações de memória que podem ser recuperadas e utilizadas de forma eficiente. Com as empresas buscando integrar agentes de IA em seus fluxos de trabalho e aplicações, ter um sistema de gerenciamento de memória confiável pode fazer uma grande diferença.

Por que a memória LLM é importante

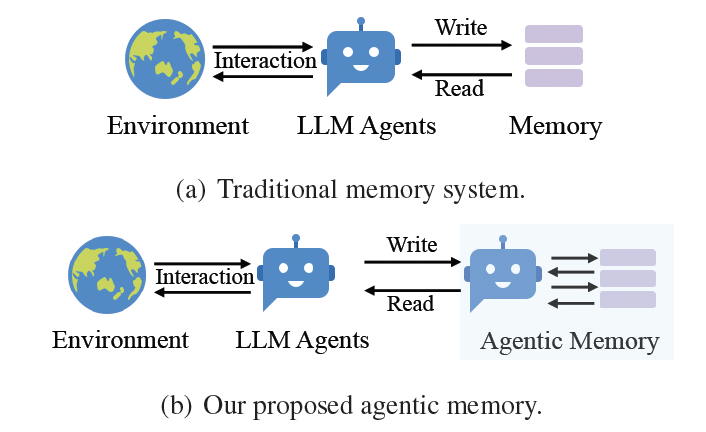

A memória é fundamental em aplicações LLM e agenciais porque permite interações de longo prazo entre ferramentas e usuários. No entanto, os sistemas de memória atuais são, muitas vezes, ineficientes ou baseados em esquemas pré-definidos que podem não se adaptar à natureza dinâmica das aplicações e interações que enfrentam.

“Estruturas rígidas, juntamente com fluxos de trabalho de agente fixos, restringem severamente a capacidade desses sistemas de se generalizarem em novos ambientes e manterem sua eficácia em interações de longo prazo,” escrevem os pesquisadores. “O desafio se torna cada vez mais crítico à medida que os agentes LLM enfrentam tarefas mais complexas e abertas, onde a organização flexível do conhecimento e a adaptação contínua são essenciais.”

A-MEM explicado

A-MEM introduz uma arquitetura de memória agente que permite um gerenciamento de memória autônomo e flexível para agentes LLM, de acordo com os pesquisadores.

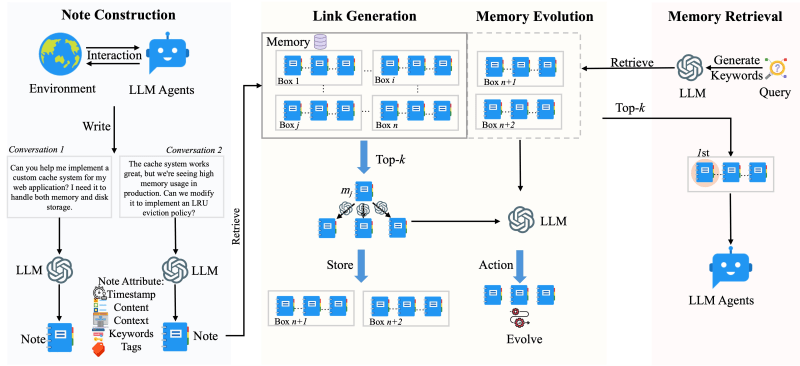

Cada vez que um agente LLM interage com seu ambiente – seja acessando ferramentas ou trocando mensagens com usuários – A-MEM gera “notas de memória estruturadas” que capturam tanto informações explícitas quanto metadados, como tempo, descrição contextual, palavras-chave relevantes e memórias vinculadas. Alguns detalhes são gerados pelo LLM enquanto examina a interação e cria componentes semânticos.

Uma vez que uma memória é criada, um modelo codificador é utilizado para calcular o valor de embedding de todos os seus componentes. A combinação de componentes semânticos gerados pelo LLM e embeddings fornece contexto interpretável por humanos e uma ferramenta para recuperação eficiente através de busca por similaridade.

Construindo memória ao longo do tempo

Um dos componentes interessantes da estrutura A-MEM é um mecanismo para vincular diferentes notas de memória sem a necessidade de regras pré-definidas. Para cada nova nota de memória, A-MEM identifica as memórias mais próximas com base na similaridade de seus valores de embedding. O LLM então analisa todo o conteúdo dos candidatos recuperados para escolher aqueles que são mais adequados para vincular à nova memória.

“Ao usar a recuperação baseada em embedding como um filtro inicial, permitimos escalabilidade eficiente enquanto mantemos relevância semântica,” escrevem os pesquisadores. “A-MEM pode identificar rapidamente conexões potenciais, mesmo em grandes coleções de memória, sem comparação exaustiva. Mais importante ainda, a análise guiada pelo LLM permite uma compreensão mais sutil de relacionamentos que vai além de simples métricas de similaridade.”

Depois de criar vínculos para a nova memória, A-MEM atualiza as memórias recuperadas com base nas informações textuais e relacionamentos com a nova memória. À medida que mais memórias são adicionadas ao longo do tempo, esse processo refina as estruturas de conhecimento do sistema, possibilitando a descoberta de padrões e conceitos de ordem superior entre as memórias.

Em cada interação, A-MEM utiliza a recuperação de memória ciente do contexto para fornecer ao agente informações relevantes do histórico. Dado um novo prompt, A-MEM primeiro calcula seu valor de embedding com o mesmo mecanismo utilizado para as notas de memória. O sistema usa este embedding para recuperar as memórias mais relevantes do armazenamento de memória e aumentar o prompt original com informações contextuais que ajudam o agente a entender e responder melhor à interação atual.

“O contexto recuperado enriquece o processo de raciocínio do agente ao conectar a interação atual com experiências passadas e conhecimentos relacionados armazenados no sistema de memória,” escrevem os pesquisadores.

A-MEM em ação

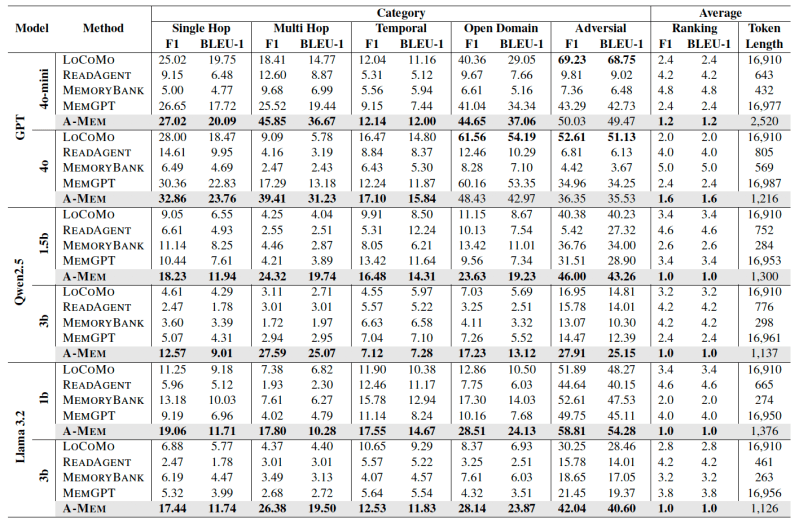

Os pesquisadores testaram o A-MEM no LoCoMo, um conjunto de dados de conversas muito longas que se estendem por várias sessões. O LoCoMo contém tarefas desafiadoras, como perguntas de múltiplas etapas que requerem a síntese de informações de várias sessões de chat e perguntas de raciocínio que exigem a compreensão de informações relacionadas ao tempo. O conjunto de dados também contém perguntas de conhecimento que requerem a integração de informações contextuais da conversa com conhecimento externo.

Os experimentos mostram que o A-MEM supera outras técnicas base de memória agencial na maioria das categorias de tarefas, especialmente ao usar modelos de código aberto. Notavelmente, os pesquisadores afirmam que o A-MEM alcança um desempenho superior enquanto reduz os custos de inferência, necessitando de até 10X menos tokens ao responder perguntas.

Um gerenciamento de memória eficaz está se tornando um requisito central à medida que agentes LLM são integrados em fluxos de trabalho empresariais complexos em diferentes domínios e subsistemas. O A-MEM — cujo código está disponível no GitHub — é uma das várias estruturas que permitem às empresas construir agentes LLM aprimorados com memória.

Perspectivas diárias sobre casos de uso de negócios com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós oferecemos as últimas novidades sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Administração Trump revoga oficialmente as regras de difusão de IA de Biden.

[the_ad id="145565"] Após uma semana de rumores, o Departamento de Comércio dos EUA (DOC) rescindiu formalmente a Regra de Difusão de Inteligência Artificial da administração…

Anaconda Lança a Primeira Plataforma de IA Unificada para Open Source, Redefinindo o Desenvolvimento de IA de Nível Empresarial

[the_ad id="145565"] Em um anúncio histórico para a comunidade de IA de código aberto, Anaconda Inc, um líder de longa data em ciência de dados baseada em Python, lançou a…

Tudo que você precisa saber sobre o chatbot de IA.

[the_ad id="145565"] O ChatGPT, o chatbot de geração de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…