Participe de nossas newsletters diárias e semanais para obter as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA líder no setor. Saiba mais

Equipe Qwen, uma divisão do gigante de e-commerce chinês Alibaba desenvolvendo sua crescente família de modelos de linguagem de código aberto Qwen (LLMs), apresentou QwQ-32B, um novo modelo de raciocínio com 32 bilhões de parâmetros projetado para melhorar o desempenho em tarefas de resolução de problemas complexos por meio de aprendizado por reforço (RL).

O modelo está disponível com pesos abertos em Hugging Face e em ModelScope sob uma licença Apache 2.0. Isso significa que está disponível para usos comerciais e de pesquisa, permitindo que as empresas o utilizem imediatamente para impulsionar seus produtos e aplicativos (inclusive aqueles pelos quais cobram os clientes).

Ele também pode ser acessado por usuários individuais através do Qwen Chat.

Quan-with-Questions foi a resposta da Alibaba ao modelo de raciocínio original o1 da OpenAI

QwQ, abreviação de Qwen-with-Questions, foi introduzido pela Alibaba em novembro de 2024 como um modelo de raciocínio de código aberto com o objetivo de competir com o o1-preview da OpenAI.

No lançamento, o modelo foi projetado para aprimorar o raciocínio lógico e o planejamento, revisando e refinando suas próprias respostas durante a inferência, uma técnica que o tornou particularmente eficaz em tarefas de matemática e programação.

A versão inicial do QwQ apresentava 32 bilhões de parâmetros e um comprimento de contexto de 32.000 tokens, com a Alibaba destacando sua capacidade de superar o o1-preview em benchmarks matemáticos como AIME e MATH, bem como em tarefas de raciocínio científico como GPQA.

Apesar de suas forças, as iterações iniciais do QwQ enfrentaram dificuldades em benchmarks de programação, como LiveCodeBench, onde os modelos da OpenAI mantiveram uma vantagem. Além disso, como ocorre com muitos modelos de raciocínio emergentes, o QwQ enfrentou desafios como mistura de idiomas e loops ocasionais de raciocínio circular.

No entanto, a decisão da Alibaba de liberar o modelo sob uma licença Apache 2.0 garantiu que desenvolvedores e empresas pudessem adaptá-lo e comercializá-lo livremente, diferenciando-o de alternativas proprietárias como o o1 da OpenAI.

Desde o lançamento inicial do QwQ, o cenário de IA evoluiu rapidamente. As limitações dos LLMs tradicionais tornaram-se mais aparentes, com as leis de escala apresentando retornos decrescentes nas melhorias de desempenho.

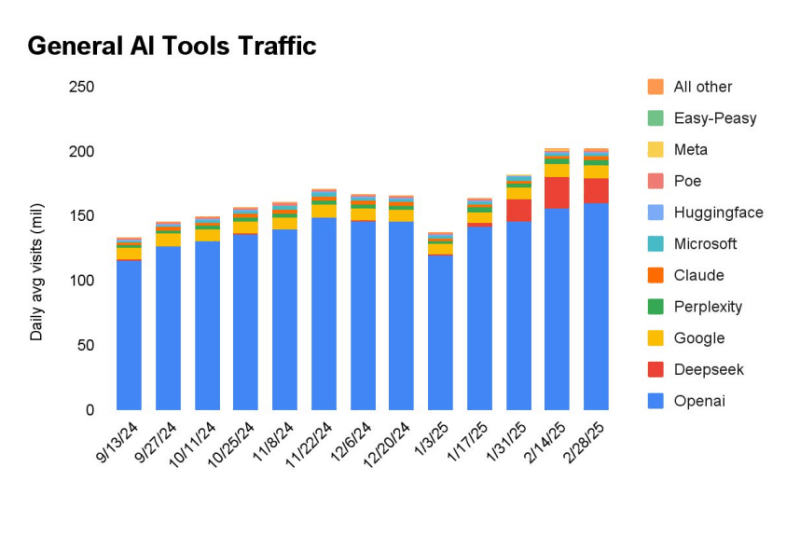

Essa mudança gerou um interesse crescente em grandes modelos de raciocínio (LRMs) — uma nova categoria de sistemas de IA que utilizam raciocínio em tempo de inferência e autorreflexão para aprimorar a precisão. Isso inclui a série o3 da OpenAI e o DeepSeek-R1, um modelo massivamente bem-sucedido do laboratório chinês DeepSeek, uma ramificação da empresa de gestão de investimentos High-Flyer Capital Management de Hong Kong.

Um novo relatório da empresa de análise e pesquisa SimilarWeb descobriu que, desde o lançamento do R1 em janeiro de 2024, o DeepSeek disparou nas estatísticas, tornando-se o site que mais atrai visitantes na oferta de modelos de IA, atrás apenas da OpenAI.

QwQ-32B, a última iteração da Alibaba, constrói sobre esses avanços ao integrar RL e autorreflexão estruturada, posicionando-se como um concorrente sério no crescente campo da IA focada em raciocínio.

Aumentando o desempenho com aprendizado por reforço em múltiplas etapas

Modelos tradicionais com ajuste por instrução muitas vezes lutam com tarefas de raciocínio difíceis, mas a pesquisa da equipe Qwen sugere que o RL pode melhorar significativamente a capacidade de um modelo de resolver problemas complexos.

O QwQ-32B baseia-se nessa ideia ao implementar uma abordagem de treinamento por RL em múltiplas etapas para aprimorar o raciocínio matemático, a proficiência em programação e a resolução geral de problemas.

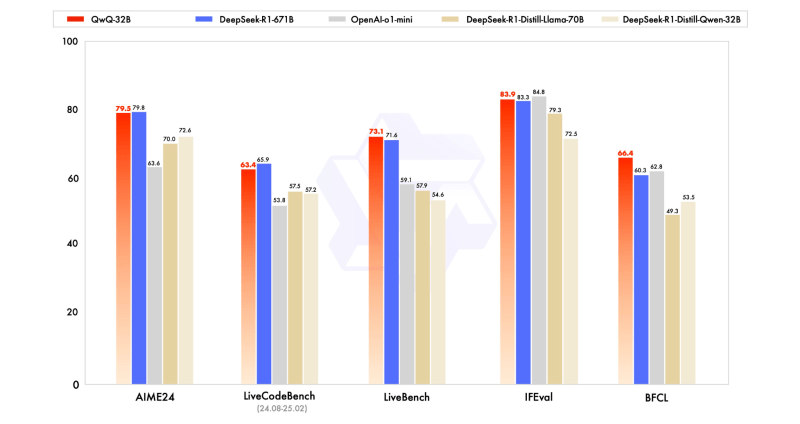

O modelo foi avaliado em comparação com alternativas líderes, como DeepSeek-R1, o1-mini e DeepSeek-R1-Distilled-Qwen-32B, demonstrando resultados competitivos, apesar de possuir menos parâmetros do que alguns desses modelos.

Por exemplo, enquanto o DeepSeek-R1 opera com 671 bilhões de parâmetros (com 37 bilhões ativados), o QwQ-32B alcança desempenho comparável com um footprint muito menor — normalmente requerendo 24 GB de vRAM em uma GPU (as H100 da Nvidia têm 80GB) em comparação com mais de 1500 GB de vRAM para executar o DeepSeek R1 completo (16 GPUs Nvidia A100) — destacando a eficiência da abordagem de RL da Qwen.

O QwQ-32B segue uma arquitetura de modelo de linguagem causal e inclui várias otimizações:

- 64 camadas de transformadores com RoPE, SwiGLU, RMSNorm e viés de atenção QKV;

- Atenção de consulta generalizada (GQA) com 40 cabeças de atenção para consultas e 8 para pares chave-valor;

- Comprimento de contexto estendido de 131.072 tokens, permitindo um melhor manuseio de entradas de sequência longa;

- Treinamento em múltiplas etapas incluindo pré-treinamento, ajuste fino supervisionado e RL.

O processo de RL do QwQ-32B foi executado em duas fases:

- Foco em matemática e programação: O modelo foi treinado usando um verificador de precisão para raciocínio matemático e um servidor de execução de código para tarefas de codificação. Essa abordagem garantiu que as respostas geradas fossem validadas quanto à correção antes de serem reforçadas.

- Aprimoramento da capacidade geral: Em uma segunda fase, o modelo recebeu treinamento baseado em recompensas usando modelos de recompensa gerais e verificadores baseados em regras. Esta fase melhorou o seguimento de instruções, o alinhamento humano e o raciocínio do agente sem comprometer suas habilidades em matemática e codificação.

O que isso significa para os tomadores de decisão empresariais

Para líderes empresariais — incluindo CEOs, CTOs, líderes de TI, gerentes de equipe e desenvolvedores de aplicativos de IA — o QwQ-32B representa uma potencial mudança na forma como a IA pode apoiar a tomada de decisões comerciais e a inovação técnica.

Com suas capacidades de raciocínio impulsionadas por RL, o modelo pode fornecer insights mais precisos, estruturados e contextuais, tornando-se valioso para casos de uso como análise de dados automatizada, planejamento estratégico, desenvolvimento de software e automação inteligente.

As empresas que buscam implantar soluções de IA para resolução de problemas complexos, assistência em programação, modelagem financeira ou automação de atendimento ao cliente podem achar a eficiência do QwQ-32B uma opção atraente. Além disso, sua disponibilidade com pesos abertos permite que as organizações ajustem e personalizem o modelo para aplicações específicas de domínio sem restrições proprietárias, tornando-o uma escolha flexível para estratégias de IA empresarial.

O fato de vir de um gigante do e-commerce chinês pode levantar preocupações de segurança e viés para alguns usuários não chineses, especialmente ao usar a interface do Qwen Chat. Mas, assim como o DeepSeek-R1, o fato de o modelo estar disponível no Hugging Face para download e uso offline, bem como para ajustes ou re-treinamentos, sugere que essas preocupações podem ser superadas com facilidade. E é uma alternativa viável ao DeepSeek-R1.

Reações iniciais de usuários e influenciadores poderosos de IA

O lançamento do QwQ-32B já chamou a atenção da comunidade de pesquisa e desenvolvimento de IA, com vários desenvolvedores e profissionais do setor compartilhando suas primeiras impressões no X (anteriormente Twitter):

- O Vaibhav Srivastav (@reach_vb) da Hugging Face destacou a velocidade do QwQ-32B em inferência, graças ao provedor Hyperbolic Labs, chamando-o de “incrivelmente rápido” e comparável aos modelos de ponta. Ele também observou que o modelo “supera o DeepSeek-R1 e o OpenAI o1-mini com licença Apache 2.0.”

- O publicador de notícias e rumores sobre IA Chubby (@kimmonismus) ficou impressionado com o desempenho do modelo, enfatizando que o QwQ-32B às vezes supera o DeepSeek-R1, apesar de ser 20 vezes menor. “Meu Deus! Qwen arrasou!” eles escreveram.

- Yuchen Jin (@Yuchenj_UW), cofundador e CTO da Hyperbolic Labs, celebrou o lançamento observando os ganhos de eficiência. “Modelos pequenos são tão poderosos! A Alibaba Qwen lançou o QwQ-32B, um modelo de raciocínio que supera o DeepSeek-R1 (671B) e o OpenAI o1-mini!”

- Outro membro da equipe Hugging Face, Erik Kaunismäki (@ErikKaum) enfatizou a facilidade de implantação, compartilhando que o modelo está disponível para implantação com um clique nas endpoints do Hugging Face, tornando-o acessível para desenvolvedores sem configuração extensa.

Capacidades agentes

O QwQ-32B incorpora capacidades agentes, permitindo que ele ajuste dinamicamente os processos de raciocínio com base no feedback ambiental.

Para desempenho ideal, a equipe Qwen recomenda usar as seguintes configurações de inferência:

- Temperatura: 0,6

- TopP: 0,95

- TopK: Entre 20-40

- Aumento YaRN: Recomendado para manipulação de sequências mais longas que 32.768 tokens

O modelo suporta implantação usando vLLM, uma estrutura de inferência de alta taxa de transferência. No entanto, as implementações atuais do vLLM apenas suportam aumento YaRN estático, que mantém um fator de escala fixo, independentemente do comprimento da entrada.

Desenvolvimentos futuros

A equipe Qwen vê o QwQ-32B como o primeiro passo na escala de RL para melhorar as capacidades de raciocínio. Olhando para o futuro, a equipe planeja:

- Explorar mais a escala de RL para melhorar a inteligência do modelo;

- Integrar agentes com RL para raciocínio de longo prazo;

- Continuar desenvolvendo modelos fundacionais otimizados para RL;

- Avançar em direção à inteligência artificial geral (AGI) por meio de técnicas de treinamento mais avançadas.

Com o QwQ-32B, a equipe Qwen está posicionando o RL como um motor-chave da próxima geração de modelos de IA, demonstrando que a escala pode produzir sistemas de raciocínio altamente eficazes e performáticos.

Insights diários sobre casos de uso empresarial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo que você precisa. Damos a você informações sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights com o máximo de ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Desbloqueando Sistemas de Texto para Vídeo com Prompts Reescritos

[the_ad id="145565"] Pesquisadores testaram um método para reescrever prompts bloqueados em sistemas de texto-para-vídeo, permitindo que eles ultrapassem filtros de segurança…

Novo codificador de visão totalmente open source, OpenVision, chega para aprimorar o Clip da OpenAI e o SigLIP do Google.

[the_ad id="145565"] Here's the rewritten content in Portuguese, preserving the HTML structure: <div> <div id="boilerplate_2682874" class="post-boilerplate…

A OpenAI acabou de resolver o problema mais irritante do ChatGPT para negócios: conheça a exportação de PDF que muda tudo.

[the_ad id="145565"] Sure! Here’s the rewritten content in Portuguese while keeping the HTML tags intact: <div> <div id="boilerplate_2682874"…