O CEO da Microsoft, Satya Nadella, recentemente provocou um debate ao sugerir que os modelos de IA avançados estão a caminho da comoditização. Em um podcast, Nadella observou que os modelos fundamentais estão se tornando cada vez mais semelhantes e amplamente disponíveis, a ponto de “modelos por si só não são suficientes” para garantir uma vantagem competitiva duradoura. Ele destacou que a OpenAI – apesar de suas redes neurais de ponta – “não é uma empresa de modelos; é uma empresa de produtos que acontece de ter modelos fantásticos”, sublinhando que a verdadeira vantagem vem da construção de produtos em torno dos modelos.

Em outras palavras, simplesmente ter o modelo mais avançado pode não garantir mais a liderança de mercado, pois qualquer vantagem de desempenho pode ser temporária diante do rápido avanço da inovação em IA.

A perspectiva de Nadella tem peso em uma indústria onde gigantes tecnológicos estão correndo para treinar modelos cada vez maiores. Seu argumento implica uma mudança de foco: em vez de se obsessar pela supremacia do modelo, as empresas devem direcionar suas energias para integrar a IA em “um stack de sistema completo e em grandes produtos bem-sucedidos.”

Isso ecoa um sentimento mais amplo de que as inovações em IA de hoje rapidamente se tornam features básicas amanhã. À medida que os modelos se tornam mais padronizados e acessíveis, o foco se desloca para como a IA é aplicada em serviços do mundo real. Empresas como Microsoft e Google, com vastos ecossistemas de produtos, podem estar nas melhores posições para capitalizar sobre essa tendência de IA comoditizada, integrando modelos em ofertas amigáveis ao usuário.

Acessibilidade Ampliada e Modelos Abertos

Não faz muito tempo, apenas um punhado de laboratórios podia construir modelos de IA de última geração, mas essa exclusividade está desaparecendo rapidamente. As capacidades de IA estão se tornando cada vez mais acessíveis a organizações e até mesmo indivíduos, alimentando a noção de modelos como commodities. O pesquisador em IA Andrew Ng já em 2017 comparou o potencial da IA a “nova eletricidade,” sugerindo que, assim como a eletricidade se tornou uma commodity ubíqua que sustenta a vida moderna, os modelos de IA poderiam se tornar utilidades fundamentais disponibilizadas por muitos fornecedores.

A recente proliferação de modelos de código aberto acelerou essa tendência. A Meta (empresa-mãe do Facebook), por exemplo, chamou a atenção ao liberar poderosos modelos de linguagem como o LLaMA abertamente para pesquisadores e desenvolvedores sem custo. A razão é estratégica: ao tornar sua IA de código aberto, a Meta pode promover uma adoção mais ampla e ganhar contribuições da comunidade, enquanto subcorta as vantagens proprietárias dos concorrentes. E ainda mais recentemente, o mundo da IA explodiu com o lançamento do modelo chinês DeepSeek.

No campo da geração de imagens, o modelo Stable Diffusion da Stability AI mostrou quão rapidamente um avanço pode se tornar comoditizado: dentro de meses de seu lançamento aberto em 2022, tornou-se um nome familiar em IA generativa, disponível em inúmeras aplicações. Na verdade, o ecossistema de código aberto está explodindo – há dezenas de milhares de modelos de IA disponíveis publicamente em repositórios como o Hugging Face.

Essa ubiquidade significa que as organizações não precisam mais enfrentar uma escolha binária entre pagar pelo modelo secreto de um único fornecedor ou não ter nada. Em vez disso, podem escolher entre um cardápio de modelos (abertos ou comerciais) ou até mesmo ajustar seus próprios, como selecionar commodities de um catálogo. O grande número de opções é uma forte indicação de que a IA avançada está se tornando um recurso amplamente compartilhado, em vez de um privilégio guardado a sete chaves.

Gigantes da Nuvem Transformando a IA em um Serviço Utilitário

Os principais provedores de nuvem têm sido facilitadores – e impulsionadores – da comoditização da IA. Empresas como Microsoft, Amazon e Google estão oferecendo modelos de IA como serviços sob demanda, semelhantes a utilidades fornecidas pela nuvem. Nadella observou que “modelos estão se tornando commodities na [nuvem],” destacando como a nuvem torna a IA poderosa amplamente acessível.

De fato, a nuvem Azure da Microsoft possui uma parceria com a OpenAI, permitindo que qualquer desenvolvedor ou empresa acesse GPT-4 ou outros modelos de ponta por meio de uma chamada de API, sem precisar construir sua própria IA do zero. A Amazon Web Services (AWS) foi um passo além com sua plataforma Bedrock, que atua como um marketplace de modelos. O AWS Bedrock oferece uma seleção de modelos fundamentais de várias empresas de IA líderes – desde os próprios modelos da Amazon até aqueles da Anthropic, AI21 Labs, Stability AI e outros – todos acessíveis através de um único serviço gerenciado.

Essa abordagem de “muitos modelos, uma plataforma” exemplifica a comoditização: os clientes podem escolher o modelo que atende suas necessidades e mudar de fornecedor com relativa facilidade, como se estivessem comprando uma commodity.

Em termos práticos, isso significa que as empresas podem contar com plataformas de nuvem para sempre ter um modelo de ponta disponível, assim como a eletricidade de uma rede – e se um novo modelo chamar a atenção (como o avanço de uma startup), a nuvem rapidamente o oferecerá.

Diferenciando-se Além do Modelo em Si

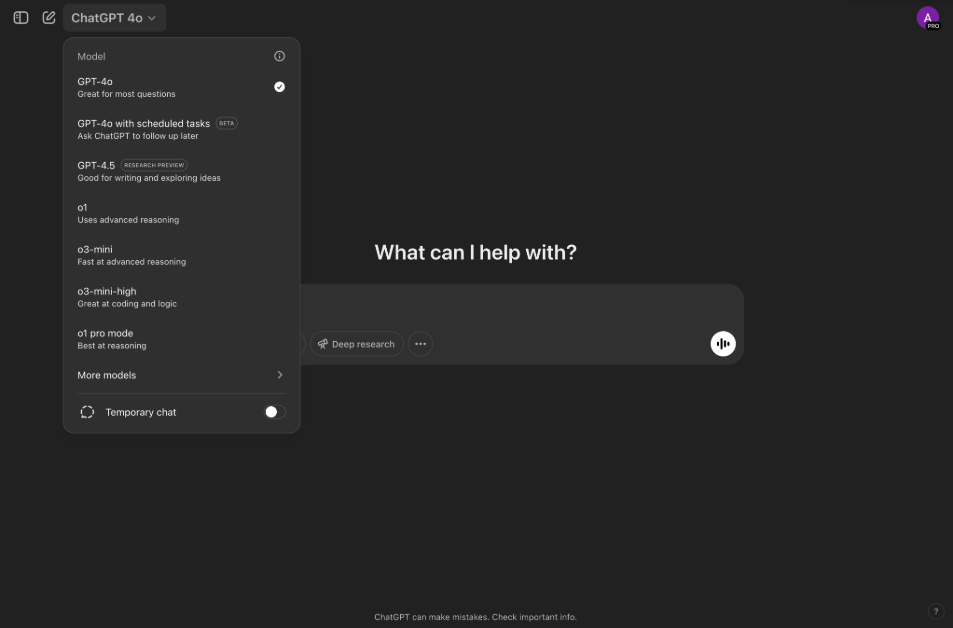

Se todos têm acesso a modelos de IA semelhantes, como as empresas de IA se diferenciam? Esse é o cerne do debate sobre a comoditização. O consenso entre os líderes do setor é que o valor estará na aplicação da IA, não apenas no algoritmo. A própria estratégia da OpenAI reflete essa mudança. O foco da empresa nos últimos anos tem sido na entrega de um produto refinado (ChatGPT e sua API) e um ecossistema de aprimoramentos – como serviços de ajuste fino, plugins e interfaces amigáveis – em vez de simplesmente liberar o código do modelo bruto.

Na prática, isso significa oferecer desempenho confiável, opções de personalização e ferramentas para desenvolvedores em torno do modelo. Da mesma forma, as equipes DeepMind e Brain do Google, agora parte da Google DeepMind, estão concentrando sua pesquisa nos produtos do Google, como busca, aplicativos de escritório e APIs de nuvem – incorporando IA para tornar esses serviços mais inteligentes. A sofisticação técnica do modelo é certamente importante, mas o Google sabe que os usuários, em última análise, se preocupam mais com as experiências proporcionadas pela IA (um motor de busca melhor, um assistente digital mais útil, etc.), e não com o nome ou tamanho do modelo.

Estamos também vendo empresas se diferenciar através da especialização. Em vez de um modelo para dominar todos, algumas empresas de IA constroem modelos personalizados para domínios ou tarefas específicas, onde podem reclamar qualidade superior mesmo em uma paisagem comoditizada. Por exemplo, há startups de IA focando exclusivamente em diagnósticos de saúde, finanças ou direito – áreas onde dados proprietários e expertise de domínio podem resultar em um modelo melhor para esse nicho do que um sistema de uso geral. Essas empresas aproveitam o ajuste fino de modelos abertos ou modelos menores sob medida, combinados com dados proprietários, para se destacar.

Interface do ChatGPT da OpenAI e coleção de modelos especializados (Unite AI/Alex McFarland)

Outra forma de diferenciação é a eficiência e o custo. Um modelo que oferece desempenho equivalente a uma fração do custo computacional pode ser uma vantagem competitiva. Isso foi destacado pela emergência do modelo R1 da DeepSeek, que supostamente igualou algumas das capacidades do GPT-4 da OpenAI com um custo de treinamento inferior a $6 milhões, dramaticamente menor do que os estimados $100+ milhões gastos no GPT-4. Esses ganhos de eficiência sugerem que, enquanto os resultados de diferentes modelos podem se tornar semelhantes, um fornecedor pode se distinguir ao alcançar esses resultados de forma mais econômica ou rápida.

Por fim, existe a corrida pela construção de lealdade do usuário e ecossistemas em torno dos serviços de IA. Uma vez que uma empresa tenha integrado um determinado modelo de IA profundamente em seu fluxo de trabalho (com prompts personalizados, integrações e dados ajustados), mudar para outro modelo não é trivial. Provedores como OpenAI, Microsoft e outros estão tentando aumentar essa adesão, oferecendo plataformas abrangentes – de SDKs de desenvolvedor a marketplaces de plugins de IA – que fazem com que sua versão de IA seja mais uma solução completa do que uma commodity intercambiável.

As empresas estão subindo na cadeia de valor: quando o modelo em si não é uma barreira, a diferenciação vem de tudo ao redor do modelo – os dados, a experiência do usuário, a expertise vertical e a integração em sistemas existentes.

Efeitos Econômicos da IA Comoditizada

A comoditização de modelos de IA traz implicações econômicas significativas. No curto prazo, está reduzindo o custo das capacidades de IA. Com múltiplos concorrentes e alternativas abertas, a precificação para serviços de IA tem seguido uma espiral descendente reminiscentes dos mercados clássicos de commodities.

Nos últimos dois anos, a OpenAI e outros provedores cortaram dramaticamente os preços de acesso aos modelos de linguagem. Por exemplo, o preço por token da OpenAI para sua série GPT caiu mais de 80% de 2023 a 2024, uma redução atribuída ao aumento da concorrência e ganhos de eficiência.

Da mesma forma, novos entrantes oferecendo modelos mais baratos ou abertos forçam as incumbentes a oferecer mais por menos – seja através de tiers gratuitos, lançamentos de código aberto ou ofertas em pacotes. Isso é uma boa notícia para consumidores e empresas que adotam IA, à medida que capacidades avançadas se tornam cada vez mais acessíveis. Isso também significa que a tecnologia de IA está se espalhando mais rapidamente pela economia: quando algo se torna mais barato e padronizado, mais indústrias o incorporam, alimentando a inovação (da mesma forma que o hardware de PC comoditizado e barato nos anos 2000 levou a uma explosão de software e serviços na internet).

Já estamos testemunhando uma onda de adoção de IA em setores como atendimento ao cliente, marketing e operações, impulsionada por modelos e serviços prontamente disponíveis. Uma disponibilidade mais ampla pode, portanto, expandir o mercado geral para soluções de IA, mesmo que as margens de lucro sobre os próprios modelos diminuam.

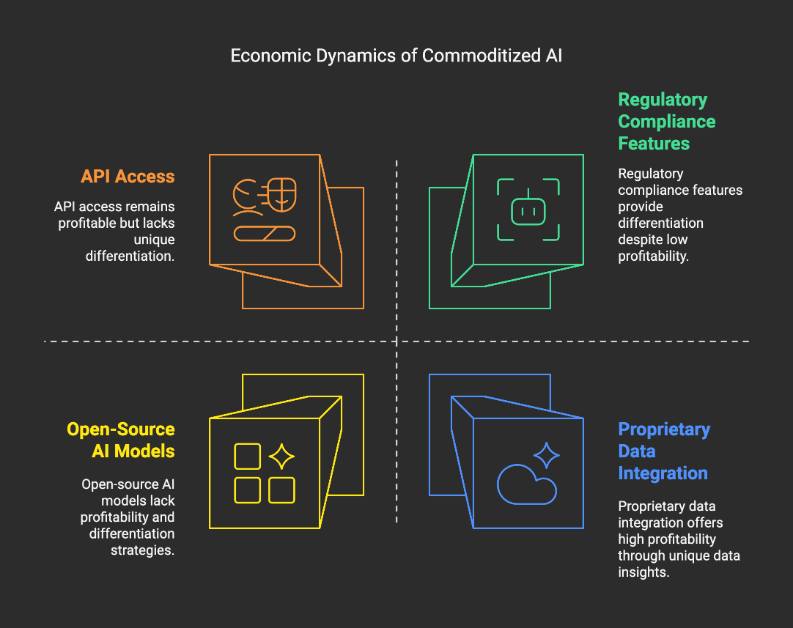

Dinâmicas econômicas da IA comoditizada (Unite AI/Alex McFarland)

No entanto, a comoditização também pode remodelar o cenário competitivo de maneiras desafiadoras. Para laboratórios de IA estabelecidos que investiram bilhões no desenvolvimento de modelos de fronteira, a perspectiva de esses modelos gerarem apenas vantagens transitórias levanta questões sobre o retorno do investimento (ROI). Eles podem precisar ajustar seus modelos de negócio – por exemplo, focando em serviços empresariais, vantagens de dados proprietários ou produtos de assinatura construídos sobre os modelos, em vez de vender apenas acesso à API.

Há também um elemento de corrida armamentista: quando qualquer avanço em desempenho é rapidamente igualado ou superado por outros (ou até mesmo por comunidades de código aberto), a janela para monetizar um modelo novo se estreita. Essa dinâmica leva as empresas a considerar alternativas de barreiras econômicas. Uma dessas barreiras é a integração com dados proprietários (que não são comoditizados) – IA ajustada com os dados riquíssimos de uma empresa pode ser mais valiosa para essa empresa do que qualquer modelo genérico.

Outra é a inclusão de recursos regulatórios ou de conformidade, onde um fornecedor pode oferecer modelos com garantias de privacidade ou conformidade para uso empresarial, diferenciando-se de forma além da tecnologia bruta. Em uma escala macro, se modelos fundamentais de IA se tornarem tão ubíquos quanto bancos de dados ou servidores web, poderemos ver uma mudança onde os serviços ao redor da IA (hospedagem em nuvem, consultoria, personalizações, manutenção) se tornem os principais geradores de receita. Já os provedores de nuvem se beneficiam da demanda crescente por infraestrutura de computação (CPUs, GPUs, etc.) para executar todos esses modelos – um pouco como as utilities elétricas que lucram com o uso, mesmo que os aparelhos sejam comoditizados.

Em essência, a economia da IA poderia espelhar a de outras commodities de TI: custos mais baixos e maior acesso estimulam o uso generalizado, criando novas oportunidades construídas sobre a camada comoditizada, mesmo que os provedores dessa camada enfrentem margens apertadas e a necessidade de inovar constantemente ou se diferenciar em outro lugar.

Conteúdo relacionado

Alibaba apresenta o Qwen3, uma família de modelos de raciocínio “híbridos” de IA.

[the_ad id="145565"] A empresa chinesa de tecnologia Alibaba anunciou na segunda-feira o lançamento do Qwen3, uma família de modelos de IA que a empresa afirma igualar e, em…

OpenAI Addresses Issue That Allowed Minors to Create Erotic Conversations in Portuguese

[the_ad id="145565"] Um erro no ChatGPT da OpenAI permitiu que o chatbot gerasse erotismo gráfico para contas de usuários registrados como menores de idade, com menos de 18…

Escritor lança Palmyra X5, oferecendo desempenho próximo ao GPT-4.1 com 75% de custo reduzido.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder da indústria em IA. Saiba mais…