Junte-se aos nossos boletins diários e semanais para atualizações mais recentes e conteúdo exclusivo sobre coberturas de IA de ponta. Saiba mais

Enquanto a atenção do consumidor se concentra nas batalhas de IA generativa entre a OpenAI e o Google, a Anthropic tem implementado uma estratégia empresarial disciplinada centrada na codificação — potencialmente o caso de uso de IA empresarial mais valioso. Os resultados estão se tornando cada vez mais evidentes: Claude está se posicionando como o LLM que mais importa para as empresas.

A evidência? O Claude 3.7 Sonnet da Anthropic, lançado há apenas duas semanas, estabeleceu novos recordes de referência para desempenho em codificação. Simultaneamente, a empresa lançou Claude Code, um agente de IA de linha de comando que ajuda os desenvolvedores a criar aplicativos mais rapidamente. Enquanto isso, o Cursor — um editor de código alimentado por IA que utiliza o modelo Claude da Anthropic como padrão — disparou para um $100 milhões em receita recorrente anual em apenas 12 meses.

A abordagem deliberada da Anthropic em relação à codificação surge em um momento em que as empresas reconhecem cada vez mais o poder dos agentes de codificação de IA, que permitem tanto a desenvolvedores experientes quanto a não-codificadores criar aplicativos com velocidade e eficiência sem precedentes. “A Anthropic continua a sair na frente”, disse Guillermo Rauch, CEO da Vercel, outra empresa em rápido crescimento que permite que desenvolvedores, incluindo não-codificadores, implantem aplicações front-end. No ano passado, a Vercel mudou seu modelo de codificação principal da GPT da OpenAI para o Claude da Anthropic após avaliar o desempenho dos modelos em tarefas de codificação chave.

Claude 3.7: Estabelecendo novos padrões para a codificação em IA

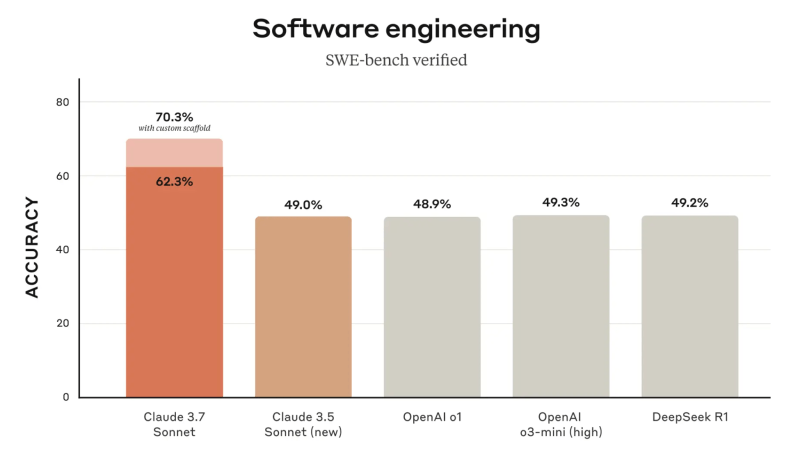

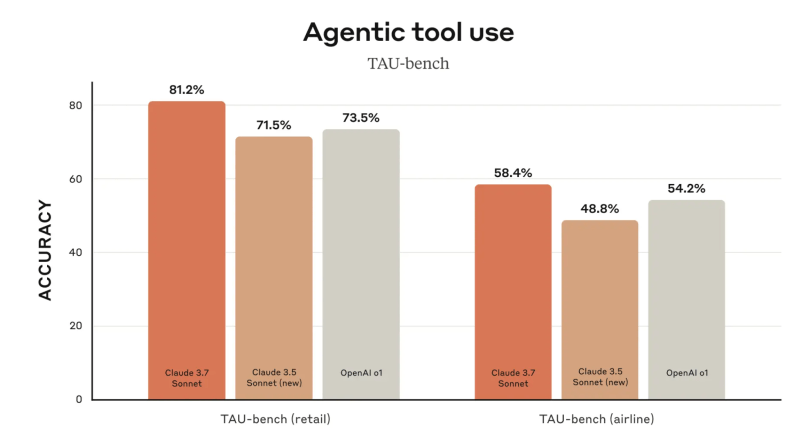

Lançado em 24 de fevereiro, o Claude 3.7 Sonnet lidera quase todos os benchmarks de codificação. Ele marcou impressionantes 70,3% no respeitado benchmark SWE-bench, que mede as habilidades de desenvolvimento de software de um agente, superando de longe os concorrentes mais próximos, o o1 da OpenAI (48,9%) e o DeepSeek-R1 (49,2%). Ele também supera os concorrentes em tarefas agentivas.

As comunidades de desenvolvedores rapidamente verificaram esses resultados em testes do mundo real. Tópicos no Reddit comparando o Claude 3.7 com o Grok 3, o modelo recém-lançado da xAI de Elon Musk, consistentemente favorecem o modelo da Anthropic para tarefas de codificação. “Com base no que eu testei, o Claude 3.7 parece ser o melhor para escrever código (pelo menos para mim),” disse um comentador destacado.

Juntamente com o lançamento do 3.7 Sonnet, a Anthropic lançou o Claude Code, um agente de codificação em IA que funciona diretamente através da linha de comando. Isso complementa o lançamento de Computer Use da empresa em outubro, que permite que o Claude interaja com o computador do usuário, incluindo a utilização de um navegador para buscar na web, abrir aplicações e inserir texto.

O mais notável é o que a Anthropic não fez. Diferentemente dos concorrentes que se apressam para igualar as funcionalidades, a empresa sequer se deu ao trabalho de integrar a funcionalidade de busca na web em seu aplicativo — um recurso básico que a maioria dos usuários espera. Essa omissão calculada sinaliza que a Anthropic não está competindo pelo mercado consumidor em geral, mas está focada de maneira laser no mercado empresarial, onde as capacidades de codificação oferecem um ROI muito maior do que a busca.

Mãos à obra com as capacidades de codificação do Claude

Para testar as capacidades do mundo real desses agentes de codificação, experimentei construir um banco de dados para armazenar artigos da VentureBeat usando três abordagens diferentes: Claude 3.7 Sonnet através do aplicativo da Anthropic; o agente de codificação do Cursor; e o Claude Code.

Usando o Claude 3.7 diretamente através do aplicativo da Anthropic, encontrei uma solução que ofereceu uma orientação notável para um não-codificador como eu. Ele recomendou várias opções, desde soluções muito robustas usando coisas como bancos de dados PostgreSQL, até opções mais simples e leves como o uso do Airtable. Escolhi a solução leve, e o Claude me guiou metódicamente sobre como puxar artigos da API da VentureBeat para o Airtable usando o Make.com para as conexões. O processo levou cerca de duas horas, incluindo alguns desafios de autenticação, mas resultou em um sistema funcional. Pode-se dizer que, em vez de fazer todo o código por mim, ele me mostrou um plano mestre sobre como fazê-lo.

O Cursor, que utiliza os modelos do Claude como padrão, é um editor de código completo e estava mais disposto a automatizar o processo. No entanto, exigiu permissões a cada etapa, criando um fluxo de trabalho um tanto tedioso.

O Claude Code ofereceu uma abordagem diferente, rodando diretamente no terminal e usando SQLite para criar um banco de dados local que puxava artigos de nosso feed RSS. Essa solução foi mais simples e confiável em termos de me levar ao meu objetivo final, mas definitivamente menos robusta e rica em recursos do que a implementação do Airtable. Agora estou entendendo a natureza desses compromissos e sei que o agente de codificação que escolho realmente depende do projeto específico.

A chave é: mesmo como não-desenvolvedor, consegui construir aplicações de banco de dados funcionais usando as três abordagens — algo que teria sido impensável há apenas um ano. E todas elas dependiam do Claude por baixo.

Para uma análise mais detalhada de como realizar essa chamada “codificação de clima”, onde você confia em agentes para codificar coisas enquanto não faz nenhuma codificação por conta própria, leia este ótimo artigo do desenvolvedor Simon Willison publicado ontem. O processo pode ser muito buggy e frustrante às vezes, mas com as concessões certas a isso, você pode avançar muito.

A estratégia: Por que a codificação é o jogo empresarial da Anthropic

A singularidade do foco da Anthropic nas capacidades de codificação não é acidental. De acordo com projeções supostamente vazadas para o The Information, a Anthropic visa alcançar $34,5 bilhões em receita até 2027 — um aumento de 86 vezes em relação aos níveis atuais. Aproximadamente 67% dessa receita projetada viria do negócio de API, com aplicações de codificação empresarial como principal motor. Embora a Anthropic não tenha divulgado números exatos de sua receita até agora, afirmou que sua receita de codificação disparou 1.000% no último trimestre de 2024. Na semana passada, a Anthropic anunciou que levantou mais $3,5 bilhões em financiamento a uma avaliação de $61,5 bilhões.

Essa aposta em codificação é respaldada pelo próprio Índice Econômico da Anthropic, que constatou que 37,2% das consultas enviadas ao Claude estavam na categoria “computação e matemática”, cobrindo principalmente tarefas de engenharia de software como modificação de código, depuração e solução de problemas de rede.

A Anthropic parece estar seguindo seu próprio ritmo — em um momento em que os concorrentes estão distraídos, correndo para cobrir tanto mercados empresariais quanto consumidores com paridade de recursos. A liderança da OpenAI é reforçada pelo seu reconhecimento e uso iniciais por consumidores, e está presa tentando atender tanto usuários comuns quanto empresas com múltiplos modelos e funcionalidades. O Google está perseguindo essa tendência também, tentando ter um pouco de tudo.

A estratégia comparativamente disciplinada da Anthropic se estende às suas decisões de produtos. Em vez de buscar participação no mercado consumidor, a empresa priorizou recursos empresariais como integração ao GitHub, logs de auditoria, permissões personalizáveis e controles de segurança específicos de domínio. Há seis meses, introduziu uma gigantesca janela de contexto de 500.000 tokens para desenvolvedores, enquanto o Google limitou sua janela de um milhão de tokens a testadores privados. O resultado é uma oferta abrangente focada em codificação que está sendo cada vez mais adotada por empresas.

A empresa recentemente introduziu recursos permitindo que não-codificadores publiquem aplicações criadas por IA dentro de suas organizações, e só na semana passada atualizou seu console com capacidades aprimoradas de colaboração, incluindo prompts e templates compartilháveis. Essa democratização reflete uma espécie de estratégia de cavalo de Troia: Primeiro, possibilitar que os desenvolvedores construam fundações poderosas, depois expandir o acesso para a força de trabalho empresarial mais ampla, incluindo até as esferas corporativas.

O ecossistema de agentes de codificação: Cursor e além

Talvez o sinal mais revelador do sucesso da Anthropic seja o crescimento explosivo do Cursor, um editor de código de IA que supostamente tem 360.000 usuários, com mais de 40.000 deles sendo clientes pagantes, após apenas 12 meses — tornando-se possivelmente a empresa SaaS mais rápida a alcançar esse marco.

O sucesso do Cursor está ligado à Claude. “Você tem que pensar que o cliente número um deles é o Cursor,” observou Sam Witteveen, cofundador da Red Dragon, um desenvolvedor independente de agentes de IA. “A maioria das pessoas no [Cursor] já estava usando o modelo Claude Sonnet — os modelos 3.5 — e agora parece que todos estão migrando para o 3.7.”

A relação entre a Anthropic e seu ecossistema se estende além de empresas individuais como o Cursor. Em novembro, a Anthropic lançou seu Protocolo de Contexto de Modelo (MCP) como um padrão aberto, permitindo que desenvolvedores construam ferramentas que interajam com os modelos Claude. O padrão está sendo amplamente adotado pelos desenvolvedores.

“Ao lançar isso como um protocolo aberto, eles estão dizendo, ‘Ei, pessoal, fiquem à vontade’,” explicou Witteveen. “Você pode desenvolver o que quiser que se encaixe nesse protocolo. Nós vamos apoiar esse protocolo.”

Essa abordagem cria um ciclo virtuoso: Desenvolvedores criam ferramentas para Claude, o que torna Claude mais valioso para as empresas, o que impulsiona mais adoção, o que atrai mais desenvolvedores.

A concorrência: Microsoft, OpenAI, Google e código aberto

Enquanto a Anthropic encontrou seu foco, os concorrentes estão perseguindo diferentes estratégias com resultados variados.

A Microsoft mantém um impulso significativo através de seu GitHub Copilot, que possui 1,3 milhão de usuários pagantes e foi adotado por mais de 77.000 organizações em cerca de dois anos. Empresas como Honeywell, State Street, TD Bank Group e Levi’s estão entre seus usuários. Essa ampla adoção decorre em grande parte dos relacionamentos empresariais existentes da Microsoft e de sua vantagem de ser a primeira a investir cedo na OpenAI e utilizar os modelos dessa empresa para alimentar o Copilot.

No entanto, até mesmo a Microsoft reconheceu a força da Anthropic. Em outubro, permitiu que os usuários do GitHub Copilot escolhessem os modelos da Anthropic como uma alternativa à OpenAI. E os modelos recentes da OpenAI — o o1 e o mais novo o3, que enfatizam o raciocínio através de um pensamento prolongado — não demonstraram pontos fortes particulares em codificação ou tarefas agentivas.

O Google fez seu próprio movimento ao tornar seu Code Assist gratuito, mas esse movimento parece mais defensivo do que estratégico.

O movimento de código aberto é outra força significativa nesse cenário. Os modelos Llama da Meta ganharam tração considerável no setor empresarial, com grandes empresas como AT&T, DoorDash e Goldman Sachs implementando modelos baseados em Llama para diversas aplicações. A abordagem de código aberto oferece às empresas maior controle, opções de personalização e benefícios de custo que os modelos fechados não conseguem igualar, como o VentureBeat relatou no ano passado.

Em vez de ver isso como uma ameaça direta, a Anthropic parece estar se posicionando como complementar ao código aberto. Os clientes empresariais podem usar o Claude ao lado de modelos de código aberto, dependendo das necessidades específicas, uma abordagem híbrida que maximiza as forças de cada um.

Na verdade, a maioria das empresas de grande porte com as quais conversei nos últimos meses são explicitamente multimodais, no sentido de que seus fluxos de trabalho de IA permitem que usem o que quer que seja o melhor para um determinado caso. A Intuit foi um exemplo inicial de uma empresa que apostou na OpenAI como padrão para suas aplicações de declaração de impostos, mas no ano passado trocou para o Claude porque ele era superior em alguns casos. A dificuldade da mudança levou a Intuit a criar uma estrutura de orquestração de IA que permitia alternar entre modelos de forma muito mais silenciosa, como Nhung Ho, VP de IA da Intuit, me disse no evento VB Transform do VentureBeat no ano passado.

A maioria das outras empresas empresariais seguiu uma prática semelhante desde então. Elas usam o que for melhor para cada caso específico, chamando modelos com chamadas de API simples. Em alguns casos, um modelo de código aberto como o Llama pode funcionar bem, mas em outros — por exemplo, em cálculos onde a precisão é importante — o Claude é a escolha, como explicou Ho da Intuit no evento do VB Transform do VentureBeat no ano passado.

Nos últimos dias, participei da conferência HumanX em Las Vegas, onde centenas de desenvolvedores se reuniram para discutir IA. O Claude surge quase sempre sempre que o tema de agentes ou codificação é mencionado. Durante o almoço de ontem, Julianne Averill, diretora administrativa da Danforth Advisors, que assessora empresas de ciências da vida, disse que sua empresa encontrou o Claude superior para muitas dessas tarefas, incluindo a criação de tabelas de análise estruturadas.

O CEO da Vercel, Guillermo Rauch, outro participante, disse que sua empresa, que superou $100 milhões em receita anual, escolheu o Claude no ano passado como seu modelo padrão para ajudar os desenvolvedores a codificar após realizar avaliações rigorosas de todos os modelos. “O 3.7 é o rei,” disse Rauch ao VentureBeat. Ele concordou que é importante oferecer aos desenvolvedores a escolha de modelos, uma vez que o ritmo acelerado de avanços significa que não pode haver lealdade a um único modelo. Mas enquanto o produto V0 da Vercel, que permite que os usuários gerem interfaces de usuário na web (UIs) usando prompts em linguagem natural, oferece essa escolha, precisa escolher um modelo padrão para ajudar os usuários durante sua fase inicial de ideação e raciocínio. Esse modelo é o Claude Sonnet. “Você precisa do modelo arquiteto que seja capaz de raciocinar e faz a maior parte da geração de código,” disse ele. “Uma parte significativa de nosso pipeline é alimentada pelo Anthropic Sonnet.” A Adobe, o Chick-Fil-A e a Bed Bath and Beyond são clientes da Vercel.

Ainda assim, Rauch cautelou que a fluidez na corrida dos LLMs permanece, e o modelo líder pode mudar a qualquer momento. A Vercel experimentou com o modelo DeepSeek da China, disse ele, mas descobriu que ficava apenas abaixo do padrão do Claude. Da mesma forma, ele mencionou que o modelo Qwen da Alibaba melhorou bastante.

Implicações para as empresas: Fazendo a transição para agentes de codificação

Para os tomadores de decisão empresarial, esse cenário em rápida evolução apresenta tanto oportunidades quanto desafios.

A segurança continua a ser uma preocupação central, mas um relatório independente recente descobriu que o Claude 3.7 Sonnet é o modelo mais seguro até agora — o único testado que se mostrou “à prova de jailbreak”. Essa postura de segurança, combinada com o apoio da Anthropic vindo tanto da Google quanto da Amazon (e integração ao AWS Bedrock), a posiciona bem para a adoção empresarial.

A ascensão dos agentes de codificação não está apenas mudando a forma como as aplicações são construídas — está democratizando o processo. Segundo o GitHub, 92% dos desenvolvedores baseados nos EUA em empresas de grande porte já usavam ferramentas de codificação alimentadas por IA no trabalho há 18 meses. Esse número provavelmente cresceu substancialmente desde então.

“O desafio que as pessoas têm [por não serem codificadores] é realmente que não conhecem muita da terminologia. Elas não conhecem as melhores práticas,” explicou Witteveen. Os agentes de codificação em IA estão cada vez mais por meio do bridge, permitindo que membros técnicos e não-técnicos da equipe colaborem mais efetivamente.

Para a adoção empresarial, Witteveen recomenda uma abordagem equilibrada: “É o equilíbrio entre segurança e experimentação neste momento. De maneira clara, do lado do desenvolvedor, as pessoas estão começando a construir aplicações do mundo real com essas coisas.”

Para uma exploração mais profunda desses temas, confira meu recentemente vídeo no YouTube com o Witteveen, onde aprofundamos o estado dos agentes de codificação e o que eles significam para a estratégia de IA empresarial.

Olhando para frente: o futuro da codificação empresarial

A ascensão dos agentes de codificação em IA sinaliza uma mudança fundamental no desenvolvimento de software empresarial. Quando usados de forma eficaz, essas ferramentas não substituem os desenvolvedores, mas transformam seus papéis, permitindo-lhes focar na arquitetura e inovação em vez dos detalhes de implementação.

A abordagem disciplinada da Anthropic de focar especificamente nas capacidades de codificação enquanto os concorrentes perseguem várias prioridades parece estar trazendo frutos para a empresa. Até o final de 2025, podemos olhar para trás e ver esse período como o momento em que os agentes de codificação em IA se tornaram ferramentas empresariais essenciais — com o Claude liderando o caminho.

Para os tomadores de decisão técnica, a mensagem é clara: Comece a experimentar com essas ferramentas agora ou arrisque ficar para trás em relação aos concorrentes que já as utilizam para acelerar dramaticamente os ciclos de desenvolvimento. Este momento ecoa os primeiros dias da revolução do iPhone, quando as empresas tentaram inicialmente bloquear dispositivos “não sancionados” de suas redes corporativas, apenas para eventualmente abraçar políticas de BYOD à medida que a demanda dos funcionários se tornava esmagadora. Algumas empresas com as quais o VentureBeat conversou, como a Honeywell, tentaram recentemente também fechar o uso “desviado” de ferramentas de codificação em IA não aprovadas pela TI.

Discutindo na segunda-feira durante a conferência HumanX, James Reggio, CTO da Brex, uma empresa que fornece cartões de crédito e outros serviços financeiros para pequenas e médias empresas, disse que sua empresa também tentou inicialmente impor uma abordagem de cima para baixo na seleção de modelos de IA, em um esforço para alcançar a perfeição. Mas a empresa enfrentou uma revolta entre seus funcionários desenvolvedores e logo percebeu que isso era fútil. Decidiu permitir que os usuários experimentassem livremente. Empresas inteligentes já estão configurando ambientes de sandbox seguros para permitir experimentações controladas. Organizações que criam orientações claras enquanto incentivam a inovação se beneficiarão tanto do entusiasmo dos funcionários quanto de percepções sobre como essas ferramentas podem atender melhor às suas necessidades únicas — posicionando-se à frente dos concorrentes que resistem à mudança. E o Claude da Anthropic, pelo menos por enquanto, é um grande beneficiário desse movimento.

Assista ao meu vídeo com o desenvolvedor Sam Witteveen aqui para uma imersão completa na tendência dos agentes de codificação:

Insights diários sobre casos de uso empresarial com o VB Daily

Se você deseja impressionar seu chefe, o VB Daily tem o que você precisa. Nós fornecemos informações sobre o que empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um máximo ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Grouphug é uma startup em modo furtivo que planeja usar IA em grupos do WhatsApp.

[the_ad id="145565"] Veteranos da cena de startups europeias, que já lançaram diversos aplicativos voltados ao consumidor anteriormente, estão parcialmente saindo do modo…

Alibaba apresenta o Qwen3, uma família de modelos de raciocínio “híbridos” de IA.

[the_ad id="145565"] A empresa chinesa de tecnologia Alibaba anunciou na segunda-feira o lançamento do Qwen3, uma família de modelos de IA que a empresa afirma igualar e, em…

OpenAI Addresses Issue That Allowed Minors to Create Erotic Conversations in Portuguese

[the_ad id="145565"] Um erro no ChatGPT da OpenAI permitiu que o chatbot gerasse erotismo gráfico para contas de usuários registrados como menores de idade, com menos de 18…