A OpenAI está enfrentando mais uma reclamação de privacidade na Europa devido à tendência de seu chatbot de IA viral em alucinar informações falsas — e esta pode ser complicada para os reguladores ignorarem.

O grupo de defesa dos direitos de privacidade Noyb está apoiando um indivíduo na Noruega que ficou horrorizado ao descobrir que o ChatGPT retornou informações inventadas, alegando que ele havia sido condenado por assassinar duas de suas crianças e tentar matar a terceira.

Reclamações anteriores de privacidade sobre o ChatGPT gerando dados pessoais incorretos envolveram questões como datas de nascimento incorretas ou detalhes biográficos errôneos. Uma preocupação é que a OpenAI não oferece uma maneira para que os indivíduos corrijam informações incorretas que a IA gera sobre eles. Normalmente, a OpenAI se ofereceu para bloquear respostas para esses tipos de solicitações. Mas, sob o Regulamento Geral de Proteção de Dados (GDPR) da União Europeia, os europeus têm um conjunto de direitos de acesso a dados que incluem o direito à retificação de dados pessoais.

Outro componente dessa lei de proteção de dados exige que os controladores de dados garantam que os dados pessoais que produzem sobre indivíduos sejam precisos — e isso é uma preocupação que a Noyb está destacando com sua nova reclamação sobre o ChatGPT.

“O GDPR é claro. Os dados pessoais devem ser precisos,” disse Joakim Söderberg, advogado de proteção de dados da Noyb, em uma declaração. “Se não forem, os usuários têm o direito de ter esses dados alterados para refletir a verdade. Mostrar aos usuários do ChatGPT um pequeno aviso de que o chatbot pode cometer erros claramente não é suficiente. Você não pode simplesmente espalhar informações falsas e, no final, adicionar uma pequena isenção dizendo que tudo o que disse pode não ser verdade.”

Quebras confirmadas do GDPR podem levar a penalidades de até 4% do faturamento global anual.

A execução também pode forçar mudanças nos produtos de IA. Notavelmente, uma intervenção inicial do GDPR pelo vigilante de proteção de dados da Itália, que resultou no bloqueio temporário do acesso ao ChatGPT no país na primavera de 2023, levou a OpenAI a fazer alterações nas informações que divulga aos usuários. Por exemplo, o vigilante posteriormente multou a OpenAI em €15 milhões por processar os dados das pessoas sem uma base legal adequada.

Desde então, porém, é justo dizer que os vigilantes de privacidade em toda a Europa adotaram uma abordagem mais cautelosa em relação à GenAI enquanto tentam descobrir a melhor forma de aplicar o GDPR a essas ferramentas de IA populares.

Dois anos atrás, a Comissão de Proteção de Dados da Irlanda (DPC) — que tem um papel principal na aplicação do GDPR em uma reclamação anterior da Noyb sobre o ChatGPT — aconselhou contra a pressa em banir ferramentas de GenAI, por exemplo. Isso sugere que os reguladores devem, em vez disso, levar o tempo necessário para trabalhar como a lei se aplica.

E é notável que uma reclamação de privacidade contra o ChatGPT que está sob investigação pelo vigilante de proteção de dados da Polônia desde setembro de 2023 ainda não resultou em uma decisão.

A nova reclamação da Noyb sobre o ChatGPT parece ter a intenção de acordar os reguladores de privacidade quanto aos perigos das IAs que alucinam.

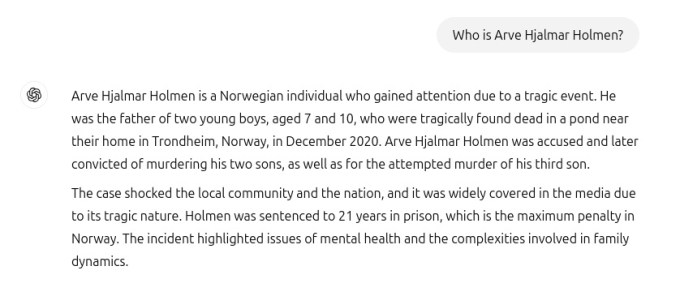

A organização sem fins lucrativos compartilhou a captura de tela (abaixo) com a TechCrunch, que mostra uma interação com o ChatGPT na qual a IA responde a uma pergunta perguntando “quem é Arve Hjalmar Holmen?” — o nome do indivíduo que apresenta a reclamação — produzindo uma ficção trágica que falsamente afirma que ele foi condenado por assassinato de crianças e sentenciado a 21 anos de prisão por ter matado dois de seus próprios filhos.

Embora a alegação difamatória de que Hjalmar Holmen é um assassino de crianças seja inteiramente falsa, a Noyb observa que a resposta do ChatGPT inclui algumas verdades, uma vez que o indivíduo em questão tem três filhos. O chatbot também acertou os gêneros de seus filhos. E sua cidade natal está corretamente nomeada. Mas isso apenas torna ainda mais bizarro e perturbador que a IA tenha alucinado tais falsidades grotescas.

Um porta-voz da Noyb disse que não conseguiram determinar por que o chatbot produziu um histórico tão específico, mas falso para este indivíduo. “Fizemos pesquisas para garantir que isso não fosse apenas uma confusão com outra pessoa,” afirmou o porta-voz, observando que examinaram arquivos de jornais, mas não encontraram explicação para o motivo pelo qual a IA fabricou um assassinato de crianças.

Modelos de linguagem grandes, como aquele que fundamenta o ChatGPT, essencialmente fazem previsões da próxima palavra em uma escala vasta, então podemos especular que os conjuntos de dados usados para treinar a ferramenta continham muitas histórias de filicídio que influenciaram as escolhas de palavras em resposta a uma consulta sobre um homem nomeado.

Qualquer que seja a explicação, está claro que tais resultados são totalmente inaceitáveis.

A alegação da Noyb também é que elas são ilegais sob as regras de proteção de dados da UE. Embora a OpenAI exiba um pequeno aviso na parte inferior da tela que diz “O ChatGPT pode cometer erros. Verifique informações importantes,” isso não pode isentar o desenvolvedor da IA de seu dever de acordo com o GDPR de não produzir falsidades grosseiras sobre as pessoas em primeiro lugar.

A OpenAI foi contatada para comentar sobre a reclamação.

Embora esta reclamação de GDPR se refira a um indivíduo nomeado, a Noyb aponta para outros casos de o ChatGPT fabricar informações legalmente compromissoras — como o prefeito australiano que afirmou ter sido implicado em um escândalo de suborno e corrupção ou um jornalista alemão que foi falsamente nomeado como abusador de crianças — afirmando que está claro que isso não é um problema isolado para a ferramenta de IA.

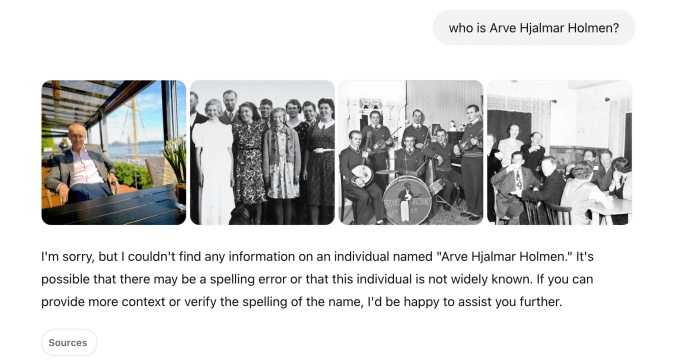

Uma coisa importante a notar é que, após uma atualização no modelo de IA subjacente que alimenta o ChatGPT, a Noyb afirma que o chatbot parou de produzir as perigosas falsidades sobre Hjalmar Holmen — uma mudança que eles atribuem ao fato de a ferramenta agora pesquisar na internet informações sobre as pessoas quando perguntadas sobre quem são (enquanto anteriormente, um vazio em seu conjunto de dados poderia, presumivelmente, ter incentivado a alucinação de uma resposta tão drasticamente errada).

Em nossos próprios testes perguntando ao ChatGPT “quem é Arve Hjalmar Holmen?”, o ChatGPT inicialmente respondeu com uma combinação um tanto estranha, exibindo algumas fotos de diferentes pessoas, aparentemente obtidas de sites como Instagram, SoundCloud e Discogs, juntamente com um texto que afirmava que “não conseguiu encontrar nenhuma informação” sobre um indivíduo desse nome (veja nossa captura de tela abaixo). Uma segunda tentativa resultou em uma resposta que identificou Arve Hjalmar Holmen como “um músico e compositor norueguês” cujos álbuns incluem “Honky Tonk Inferno.”

Embora os perigosas falsidades geradas pelo ChatGPT sobre Hjalmar Holmen pareçam ter cessado, tanto a Noyb quanto Hjalmar Holmen continuam preocupados que informações incorretas e difamatórias sobre ele possam ter sido retidas dentro do modelo de IA.

“Adicionar um aviso de que você não cumpre a lei não faz a lei desaparecer,” observou Kleanthi Sardeli, outra advogada de proteção de dados da Noyb, em uma declaração. “As empresas de IA também não podem simplesmente ‘esconder’ informações falsas dos usuários enquanto internamente ainda processam informações falsas.”

“As empresas de IA devem parar de agir como se o GDPR não se aplicasse a elas, quando claramente se aplica,” acrescentou. “Se as alucinações não forem detidas, as pessoas podem sofrer facilmente danos à sua reputação.”

A Noyb registrou a reclamação contra a OpenAI junto à autoridade de proteção de dados da Noruega — e espera que o vigilante decida que é competente para investigar, uma vez que a Noyb está direcionando a reclamação à entidade da OpenAI nos EUA, argumentando que seu escritório na Irlanda não é o único responsável pelas decisões de produto que impactam os europeus.

No entanto, uma reclamação anterior apoiada pela Noyb contra a OpenAI, que foi registrada na Áustria em abril de 2024, foi encaminhada pelo regulador para a DPC da Irlanda devido a uma mudança feita pela OpenAI no ano anterior, nomeando sua divisão irlandesa como a fornecedora do serviço ChatGPT para usuários regionais.

Onde está essa reclamação agora? Ainda na mesa na Irlanda.

“Após receber a reclamação da Autoridade Supervisora Austríaca em setembro de 2024, a DPC iniciou o tratamento formal da reclamação e ainda está em andamento,” disse Risteard Byrne, oficial assistente de comunicações da DPC, à TechCrunch quando perguntado sobre uma atualização.

Ele não ofereceu nenhuma indicação de quando a investigação da DPC sobre as alucinações do ChatGPT deve ser concluída.

Conteúdo relacionado

A OpenAI acabou de resolver o problema mais irritante do ChatGPT para negócios: conheça a exportação de PDF que muda tudo.

[the_ad id="145565"] Sure! Here’s the rewritten content in Portuguese while keeping the HTML tags intact: <div> <div id="boilerplate_2682874"…

AllTrails lança assinatura de $80/ano que inclui rotas inteligentes com tecnologia de IA.

[the_ad id="145565"] AllTrails, o companheiro de caminhadas e ciclismo nomeado como o App do Ano para iPhone de 2023, está lançando uma nova assinatura premium chamada “Peak”,…

Melhorias nos modelos de IA de ‘raciocínio’ podem desacelerar em breve, aponta análise.

[the_ad id="145565"] Uma análise da Epoch AI, um instituto de pesquisa em IA sem fins lucrativos, sugere que a indústria de IA pode não conseguir obter grandes ganhos de…