Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA líder na indústria. Saiba mais

Os modelos de IA vocal da OpenAI já criaram polêmica anteriormente com a atriz Scarlett Johansson, mas isso não impede a empresa de continuar a avançar suas ofertas nesta categoria.

Hoje, a criadora do ChatGPT lançou três novos modelos de voz proprietários chamados gpt-4o-transcribe, gpt-4o-mini-transcribe e gpt-4o-mini-tts, disponíveis inicialmente em sua interface de programação de aplicativos (API) para desenvolvedores de software de terceiros construírem seus próprios aplicativos, assim como em um site de demonstração personalizado, OpenAI.fm, que usuários individuais podem acessar para testes limitados e diversão.

Além disso, as vozes do modelo gpt-4o-mini-tts podem ser personalizadas a partir de diversas predefinições via prompt de texto para alterar seus sotaques, tom, entonação e outras qualidades vocais — incluindo transmitir as emoções que o usuário solicitar, o que deve abordar as preocupações de que a OpenAI está imitando deliberadamente a voz de algum usuário específico (a empresa anteriormente negou que esse fosse o caso com Johansson, mas retirou a opção de voz supostamente imitativa, de qualquer forma). Agora, cabe ao usuário decidir como quer que sua voz de IA soe ao responder.

Em uma demonstração com a VentureBeat, o membro da equipe técnica da OpenAI, Jeff Harris, mostrou como, usando apenas texto no site de demonstração, um usuário poderia fazer a mesma voz soar como um cientista louco rindo ou como um professor de yoga calmo e zen.

Descobrindo e refinando novas capacidades dentro da base GPT-4o

Os modelos são variantes do modelo GPT-4o existente que a OpenAI lançou em maio de 2024 e que atualmente alimenta a experiência de texto e voz do ChatGPT para muitos usuários, mas a empresa pegou esse modelo base e o treinou adicionalmente com dados para torná-lo excepcional em transcrição e fala. A empresa não especificou quando os modelos poderão chegar ao ChatGPT.

“O ChatGPT tem requisitos um pouco diferentes em termos de trade-offs de custo e desempenho, então, embora eu espere que eles migrem para esses modelos com o tempo, por enquanto, este lançamento está focado nos usuários da API,” disse Harris.

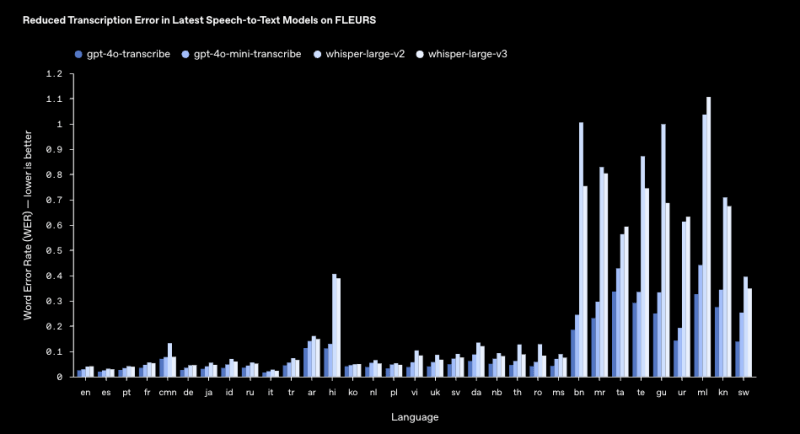

Esse modelo é destinado a substituir o modelo de texto para fala Whisper, de código aberto, da OpenAI, oferecendo taxas de erro de palavras mais baixas entre os benchmarks da indústria e melhor desempenho em ambientes barulhentos, com sotaques diversos e em diferentes velocidades de fala — em mais de 100 idiomas.

A empresa publicou um gráfico em seu site mostrando quão menores são as taxas de erro dos modelos gpt-4o-transcribe na identificação de palavras em 33 idiomas, em comparação ao Whisper — com uma impressionante taxa de 2,46% em inglês.

“Esses modelos incluem cancelamento de ruído e um detector semântico de atividade de voz, que ajuda a determinar quando um falante terminou um pensamento, melhorando a precisão da transcrição,” disse Harris.

Harris disse à VentureBeat que a nova família de modelos gpt-4o-transcribe não é projetada para oferecer “diarização”, ou a capacidade de rotular e diferenciar entre diferentes falantes. Em vez disso, é projetada principalmente para receber uma (ou possivelmente múltiplas vozes) como um único canal de entrada e responder a todas as entradas com uma única voz de saída nessa interação, por mais tempo que isso leve.

A empresa está, ainda, promovendo uma competição para o público geral encontrar os exemplos mais criativos de uso de seu site de demonstração de voz OpenAI.fm e compartilhá-los online marcando a conta @openAI no X. O vencedor deve receber um rádio personalizado da Teenage Engineering com o logotipo da OpenAI, que, segundo Olivier Godement, chefe de produto da OpenAI, é um dos apenas três existentes no mundo.

Uma mina de ouro para aplicações de áudio

As melhorias tornam esses modelos particularmente adequados para aplicações como call centers, transcrição de notas de reuniões e assistentes alimentados por IA.

Impressionantemente, o recém-lançado Agents SDK da semana passada também permite que aqueles desenvolvedores que já construíram aplicativos com base em seus modelos de linguagem de texto, como o GPT-4o regular, adicionem interações vocais fluidas com apenas “nove linhas de código,” segundo um apresentador durante uma livestream no YouTube da OpenAI anunciando os novos modelos (embed acima).

Por exemplo, um aplicativo de e-commerce construído com base no GPT-4o poderia agora responder a perguntas de usuários em turnos, como “me fale sobre meus últimos pedidos” em forma de fala com apenas alguns segundos de ajuste no código ao adicionar esses novos modelos.

“Pela primeira vez, estamos introduzindo a fala contínua de texto, permitindo que desenvolvedores insiram áudio continuamente e recebam um fluxo de texto em tempo real, tornando as conversas mais naturais,” disse Harris.

Ainda assim, para aqueles desenvolvedores que buscam experiências de voz de IA de baixa latência e em tempo real, a OpenAI recomenda o uso de seus modelos de fala para fala na API de Tempo Real.

Precificação e disponibilidade

Os novos modelos estão disponíveis imediatamente através da API da OpenAI, com os seguintes preços:

• gpt-4o-transcribe: $6.00 por 1M de tokens de entrada de áudio (~$0.006 por minuto)

• gpt-4o-mini-transcribe: $3.00 por 1M de tokens de entrada de áudio (~$0.003 por minuto)

• gpt-4o-mini-tts: $0.60 por 1M de tokens de entrada de texto, $12.00 por 1M de tokens de saída de áudio (~$0.015 por minuto)

No entanto, eles chegam em um momento de competição mais acirrada do que nunca no espaço de transcrição e fala de IA, com empresas dedicadas à IA de fala como a ElevenLabs oferecendo seu novo modelo Scribe que suporta diarização e possui uma taxa de erro reduzida similar (mas não tão baixa) de 3,3% em inglês, além de uma precificação de $0.40 por hora de áudio de entrada (ou $0.006 por minuto, mais ou menos equivalente).

Outra startup, a Hume AI, oferece um novo modelo Octave TTS com personalização de pronúncia e inflexão emocional de nível de sentença e até de palavra — baseado inteiramente nas instruções do usuário, não em vozes predefinidas. A precificação do Octave TTS não é diretamente comparável, mas há um nível gratuito que oferece 10 minutos de áudio e os custos aumentam a partir daí.

Enquanto isso, modelos de áudio e fala mais avançados também estão chegando à comunidade de código aberto, incluindo um chamado Orpheus 3B, que está disponível com uma licença permissiva Apache 2.0, significando que os desenvolvedores não precisam pagar nenhum custo para utilizá-lo — desde que tenham o hardware ou servidores em nuvem corretos.

Adoção na indústria e primeiros resultados

Várias empresas já integraram os novos modelos de áudio da OpenAI em suas plataformas, relatando melhorias significativas no desempenho da IA vocal, segundo depoimentos compartilhados pela OpenAI com a VentureBeat.

A EliseAI, uma empresa focada em automação de gerenciamento de propriedades, descobriu que o modelo de texto para fala da OpenAI possibilitou interações mais naturais e emocionalmente ricas com os inquilinos.

As vozes aprimoradas tornaram o leasing, a manutenção e o agendamento de visitas alimentados por IA mais envolventes, levando a maior satisfação dos inquilinos e a taxas de resolução de chamadas melhoradas.

A Decagon, que constrói experiências de voz alimentadas por IA, viu uma melhoria de 30% na precisão da transcrição usando o modelo de reconhecimento de fala da OpenAI.

Esse aumento na precisão permitiu que os agentes de IA da Decagon atuassem de forma mais confiável em cenários do mundo real, mesmo em ambientes barulhentos. O processo de integração foi rápido, com a Decagon incorporando o novo modelo em seu sistema em um dia.

Nem todas as reações ao último lançamento da OpenAI foram positivas. O cofundador do software de análise de aplicativos Dawn AI, Ben Hylak (@benhylak), um ex-designer de interfaces da Apple, postou no X que, embora os modelos pareçam promissores, o anúncio “parece uma retirada da voz em tempo real,” sugerindo uma mudança no foco anterior da OpenAI em uma IA conversacional de baixa latência via ChatGPT.

Além disso, o lançamento foi precedido por um vazamento inicial no X (anteriormente Twitter). TestingCatalog News (@testingcatalog) postou detalhes sobre os novos modelos alguns minutos antes do anúncio oficial, listando os nomes gpt-4o-mini-tts, gpt-4o-transcribe e gpt-4o-mini-transcribe. O vazamento foi creditado a @StivenTheDev, e a postagem rapidamente ganhou tração.

Mas olhando para o futuro, a OpenAI planeja continuar refinando seus modelos de áudio e está explorando capacidades de voz personalizadas ao mesmo tempo em que assegura a segurança e o uso responsável da IA. Além do áudio, a OpenAI também está investindo em IA multimodal, incluindo vídeo, para permitir experiências de agentes mais dinâmicas e interativas.

Insights diários sobre casos de uso empresarial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós trazemos as informações mais recentes sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

O relatório de segurança prometido pela xAI está desaparecido.

[the_ad id="145565"] A empresa de IA de Elon Musk, xAI, perdeu um prazo autoimposto para publicar um framework de segurança de IA finalizado, conforme observado pelo grupo de…

Google testa substituir ‘Estou Sentindo Sorte’ por ‘Modo AI’

[the_ad id="145565"] O Google está testando um redesign em sua página inicial de Pesquisa, no qual o “Modo AI”, o recurso experimental de busca alimentado por IA que a empresa…

Agentes Guardian: Nova abordagem pode reduzir alucinações em IA para abaixo de 1%

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba mais…