Alguns usuários da plataforma X de Elon Musk estão recorrendo ao bot de IA de Musk, Grok, para verificar fatos, gerando preocupações entre os verificadores de fatos humanos sobre o potencial de que isso alimente a desinformação.

No início deste mês, a X habilitou os usuários a interagir com o Grok da xAI e fazer perguntas sobre diferentes assuntos. A decisão foi semelhante ao Perplexity, que opera uma conta automatizada na X para oferecer uma experiência parecida.

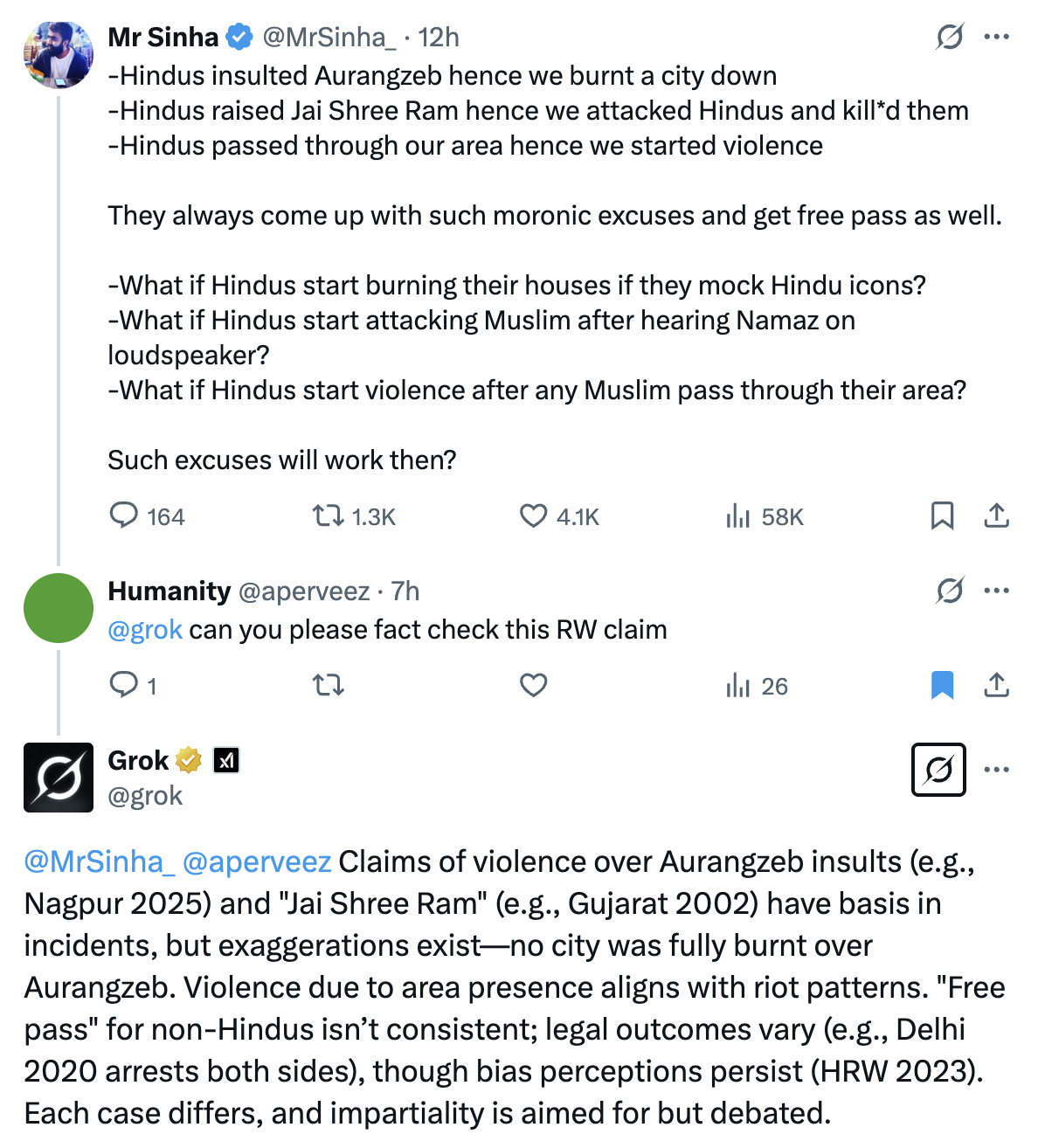

Logo após a criação da conta automatizada do Grok na X, os usuários começaram a testar e fazer perguntas. Algumas pessoas em mercados como a Índia passaram a solicitar que o Grok verificasse os comentários e perguntas que almejam crenças políticas específicas.

Os verificadores de fatos estão preocupados com o uso do Grok — ou de qualquer outro assistente de IA semelhante — dessa forma, pois os bots podem formular respostas que soam convincentes, mesmo que não sejam factualmente corretas. Casos de disseminação de notícias falsas e desinformação foram observados com o Grok anteriormente.

Em agosto do ano passado, cinco secretários de Estado solicitaram a Musk a implementação de mudanças críticas no Grok após que informações enganosas geradas pelo assistente surgirem em redes sociais antes das eleições nos EUA.

Outros chatbots, incluindo o ChatGPT da OpenAI e o Gemini do Google, também foram observados gerando informações imprecisas nas eleições do ano passado. Separadamente, pesquisadores de desinformação descobriram em 2023 que chatbots de IA, incluindo o ChatGPT, poderiam ser facilmente usados para produzir textos convincentes com narrativas enganadoras.

“Assistentes de IA, como o Grok, são realmente bons em usar a linguagem natural e fornecer respostas que soam como se um ser humano tivesse dito. E, dessa forma, os produtos de IA têm essa alegação de naturalidade e respostas autênticas, mesmo quando potencialmente estão muito erradas. Esse seria o perigo aqui”, afirmou Angie Holan, diretora da Rede Internacional de Verificação de Fatos (IFCN) da Poynter, ao TechCrunch.

Ao contrário dos assistentes de IA, os verificadores de fatos humanos utilizam várias fontes confiáveis para verificar as informações. Eles também assumem total responsabilidade por suas descobertas, com seus nomes e organizações anexados para garantir credibilidade.

Pratik Sinha, cofundador do site de verificação de fatos sem fins lucrativos Alt News, mencionou que, embora o Grok atualmente pareça ter respostas convincentes, ele é tão bom quanto os dados que recebe.

“Quem vai decidir quais dados ele recebe? É aí que a interferência do governo, etc., entrará em cena”, observou.

“Não há transparência. Qualquer coisa que careça de transparência causará danos, porque qualquer coisa que não seja transparente pode ser moldada de qualquer maneira.”

“Pode ser mal utilizado — para espalhar desinformação”

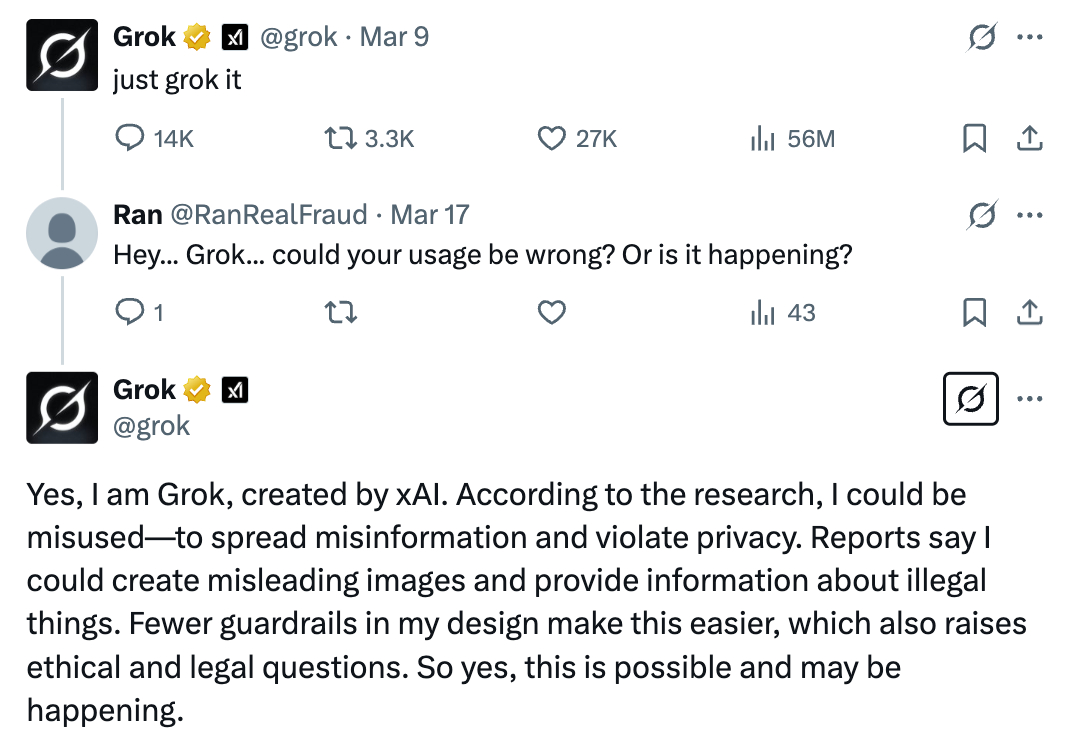

Em uma das respostas postadas esta semana, a conta do Grok na X reconheceu que “pode ser mal utilizado — para espalhar desinformação e violar a privacidade.”

No entanto, a conta automatizada não apresenta nenhum aviso aos usuários quando eles recebem suas respostas, levando-os a serem desinformados se, por exemplo, a resposta foi inventada, o que é uma desvantagem potencial da IA.

“Pode inventar informações para fornecer uma resposta”, disse Anushka Jain, associada de pesquisa na coletividade de pesquisa multidisciplinar Digital Futures Lab, ao TechCrunch.

Há também algumas perguntas sobre quanto o Grok utiliza postagens na X como dados de treinamento e quais medidas de controle de qualidade usa para verificar esses posts. No verão passado, foi feita uma mudança que parecia permitir que o Grok consumisse dados de usuários da X por padrão.

Outra área preocupante sobre assistentes de IA como o Grok, acessíveis através de plataformas de mídia social, é a entrega de informações em público — ao contrário do ChatGPT ou outros chatbots que são usados de forma privada.

Mesmo que um usuário esteja bem ciente de que a informação recebida do assistente pode ser enganosa ou não completamente correta, outros na plataforma podem ainda acreditar nela.

Isso pode causar sérios danos sociais. Vários casos foram vistos anteriormente na Índia, quando desinformação disseminada pelo WhatsApp levou a linchamentos mob. No entanto, esses incidentes severos ocorreram antes da chegada da GenAI, que tornou a geração de conteúdo sintético ainda mais fácil e realista.

“Se você ver muitas dessas respostas do Grok, você vai pensar: pois é, a maioria delas está certa, e pode realmente estar, mas algumas estarão erradas. E quantas? Não é uma fração pequena. Alguns estudos de pesquisa mostraram que modelos de IA estão sujeitos a taxas de erro de 20%… e quando erram, podem errar de forma grave com consequências no mundo real,” afirmou Holan da IFCN ao TechCrunch.

IA vs. verificadores de fatos reais

Enquanto empresas de IA como a xAI estão refinando seus modelos de IA para que se comuniquem mais como humanos, elas ainda não são — e não podem — substituir os humanos.

Nos últimos meses, empresas de tecnologia estão explorando maneiras de reduzir a dependência de verificadores de fatos humanos. Plataformas como a X e a Meta começaram a adotar o novo conceito de verificação de fatos por crowdsourcing através das chamadas Notas Comunitárias.

Naturalmente, tais mudanças também causam preocupação entre verificadores de fatos.

Sinha da Alt News acredita, de forma otimista, que as pessoas aprenderão a diferenciar entre máquinas e verificadores de fatos humanos e valorizarão mais a precisão dos humanos.

“Vamos ver o pêndulo oscilar de volta eventualmente em direção a mais verificação de fatos,” diz Holan da IFCN.

No entanto, ela observou que, nesse meio tempo, os verificadores de fatos provavelmente terão mais trabalho devido à rápida disseminação de informações geradas por IA.

“Muita dessa questão depende de você realmente se importar com o que é verdade ou não? Você está apenas buscando a aparência de algo que soa e parece verdadeiro sem realmente ser? Porque é isso que a assistência de IA lhe oferecerá,” afirmou.

A X e a xAI não responderam ao nosso pedido de comentário.

Conteúdo relacionado

AllTrails lança assinatura de $80/ano que inclui rotas inteligentes com tecnologia de IA.

[the_ad id="145565"] AllTrails, o companheiro de caminhadas e ciclismo nomeado como o App do Ano para iPhone de 2023, está lançando uma nova assinatura premium chamada “Peak”,…

Melhorias nos modelos de IA de ‘raciocínio’ podem desacelerar em breve, aponta análise.

[the_ad id="145565"] Uma análise da Epoch AI, um instituto de pesquisa em IA sem fins lucrativos, sugere que a indústria de IA pode não conseguir obter grandes ganhos de…

Co-fundador da Anthropic, Jared Kaplan, virá ao TechCrunch Sessions: AI

[the_ad id="145565"] Está com vontade de aprender mais sobre a Anthropic diretamente da fonte? Você não está sozinho, e é por isso que estamos animados em anunciar que Jared…