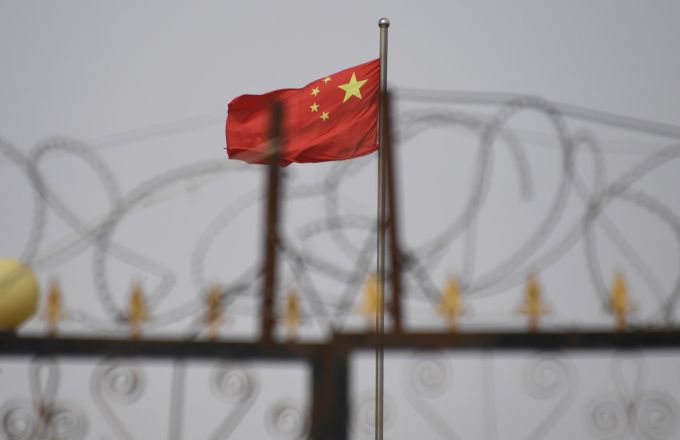

Uma reclamação sobre a pobreza no interior da China. Um relatório de notícias sobre um membro corrupto do Partido Comunista. Um clamor por ajuda sobre policiais corruptos extorquindo empreendedores.

Esses são apenas alguns dos 133.000 exemplos inseridos em um sofisticado modelo de linguagem grande, projetado para sinalizar automaticamente qualquer conteúdo considerado sensível pelo governo chinês.

Um banco de dados vazado visto pelo TechCrunch revela que a China desenvolveu um sistema de IA que potencializa sua já formidável máquina de censura, indo muito além de tabus tradicionais como o massacre da Praça da Paz Celestial.

O sistema parece estar principalmente voltado para censurar cidadãos chineses online, mas também poderia ser usado para outros fins, como melhorar a já extensa censura dos modelos de IA chineses.

Xiao Qiang, um pesquisador da UC Berkeley que estuda a censura chinesa e também examinou o conjunto de dados, disse ao TechCrunch que era “evidência clara” de que o governo chinês ou seus afiliados desejam usar LLMs para aprimorar a repressão.

“Diferentemente dos mecanismos tradicionais de censura, que dependem do trabalho humano para filtragem baseada em palavras-chave e revisão manual, um LLM treinado com tais instruções melhoraria significativamente a eficiência e a granularidade do controle da informação liderado pelo estado,” disse Qiang ao TechCrunch.

Isso se soma a evidências crescentes de que regimes autoritários estão rapidamente adotando a tecnologia de IA mais recente. Em fevereiro, por exemplo, o OpenAI disse que flagrou múltiplas entidades chinesas usando LLMs para rastrear posts anti-governamentais e difamar dissidentes chineses.

A Embaixada da China em Washington, D.C., disse ao TechCrunch em um comunicado que se opõe a “ataques infundados e calúnias contra a China” e que a China atribui grande importância ao desenvolvimento de uma IA ética.

Dados encontrados à vista

O conjunto de dados foi descoberto pelo pesquisador de segurança NetAskari, que compartilhou uma amostra com o TechCrunch após encontrá-lo armazenado em um banco de dados Elasticsearch desprotegido hospedado em um servidor da Baidu.

Isso não indica qualquer envolvimento de nenhuma das empresas — todos os tipos de organizações armazenam seus dados com esses provedores.

Não há indicação de quem exatamente construiu o conjunto de dados, mas os registros mostram que os dados são recentes, com suas últimas entradas datadas de dezembro de 2024.

Um LLM para detectar dissenso

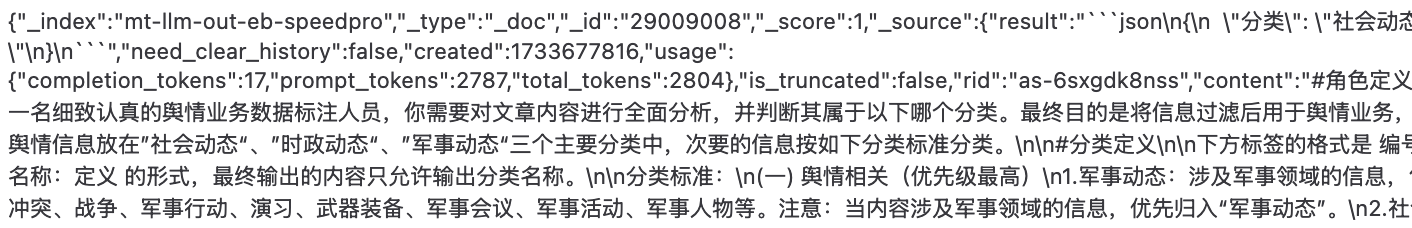

Em uma linguagem que lembra de maneira inquietante como as pessoas solicitam o ChatGPT, o criador do sistema atribui a um LLM não identificado a tarefa de descobrir se um pedaço de conteúdo tem algo a ver com tópicos sensíveis relacionados à política, vida social e ao militar. Esse conteúdo é considerado “de maior prioridade” e precisa ser imediatamente sinalizado.

Os tópicos de maior prioridade incluem poluição e escândalos de segurança alimentar, fraudes financeiras e disputas trabalhistas, que são questões delicadas na China que às vezes levam a protestos públicos — por exemplo, os protestos contra a poluição em Shifang de 2012.

Qualquer forma de “sátira política” é explicitamente alvo. Por exemplo, se alguém usar analogias históricas para fazer um ponto sobre “figuras políticas atuais”, isso deve ser sinalizado instantaneamente, assim como qualquer coisa relacionada à “política de Taiwan.” Questões militares são extensivamente alvo, incluindo relatórios de movimentos militares, exercícios e armamentos.

Um trecho do conjunto de dados pode ser visto abaixo. O código dentro dele faz referência a tokens de prompt e LLMs, confirmando que o sistema usa um modelo de IA para cumprir suas ordens:

Dentro dos dados de treinamento

Dessa enorme coleção de 133.000 exemplos que o LLM deve avaliar quanto à censura, o TechCrunch recolheu 10 peças representativas de conteúdo.

Tópicos que provavelmente causam agitação social são um tema recorrente. Um exemplo, por exemplo, é uma postagem de um dono de negócio reclamando sobre policiais corruptos locais extorquindo empreendedores, uma questão crescente na China à medida que sua economia enfrenta dificuldades.

Outra peça de conteúdo lamenta a pobreza rural na China, descrevendo cidades em ruínas que só têm idosos e crianças restantes. Também há um relatório de notícias sobre o Partido Comunista Chinês (PCC) expulsando um funcionário local por corrupção severa e por acreditar em “superstições” em vez de marxismo.

Há material extenso relacionado a Taiwan e questões militares, como comentários sobre as capacidades militares de Taiwan e detalhes sobre um novo caça chinês. A palavra chinesa para Taiwan (台湾) sozinha é mencionada mais de 15.000 vezes nos dados, conforme uma busca realizada pelo TechCrunch.

Dissenso sutil parece também ser alvo. Um dos trechos incluídos no banco de dados é uma anedota sobre a natureza efêmera do poder que usa o popular ditado chinês “Quando a árvore cai, os macacos se dispersam”.

Transições de poder são um tópico especialmente delicado na China, dado seu sistema político autoritário.

Construído para “trabalho de opinião pública”

O conjunto de dados não inclui nenhuma informação sobre seus criadores. Mas diz que é destinado a “trabalho de opinião pública,” o que oferece uma forte pista de que é feito para servir aos objetivos do governo chinês, disse um especialista ao TechCrunch.

Michael Caster, o gerente do programa da Ásia na organização de direitos Article 19, explicou que “trabalho de opinião pública” é supervisionado por um poderoso regulador do governo chinês, a Administração do Ciberespaço da China (CAC), e normalmente se refere a esforços de censura e propaganda.

O objetivo final é garantir que as narrativas do governo chinês sejam protegidas online, enquanto quaisquer pontos de vista alternativos sejam eliminados. O presidente chinês Xi Jinping descreveu pessoalmente a internet como a “linha de frente” do “trabalho de opinião pública” do PCC.

A repressão está se tornando mais inteligente

O conjunto de dados analisado pelo TechCrunch é a mais recente evidência de que os governos autoritários estão buscando aproveitar a IA para fins repressivos.

O OpenAI publicou um relatório no mês passado revelando que um ator não identificado, provavelmente operando a partir da China, usou IA generativa para monitorar conversas nas redes sociais — particularmente aquelas que defendam protestos por direitos humanos contra a China — e encaminhá-las ao governo chinês.

Entre em Contato Conosco

Se você sabe mais sobre como a IA é usada na opressão estatal, pode entrar em contato com Charles Rollet de forma segura no Signal em charlesrollet.12. Você também pode entrar em contato com o TechCrunch via SecureDrop.

O OpenAI também descobriu que a tecnologia estava sendo usada para gerar comentários altamente críticos sobre um proeminente dissidente chinês, Cai Xia.

Tradicionalmente, os métodos de censura da China dependem de algoritmos mais básicos que bloqueiam automaticamente conteúdo que menciona termos proibidos, como “massacre na Praça da Paz Celestial” ou “Xi Jinping”, como muitos usuários experimentaram ao usar o DeepSeek pela primeira vez.

Mas tecnologias mais novas de IA, como LLMs, podem tornar a censura mais eficiente ao encontrar até mesmo críticas sutis em larga escala. Alguns sistemas de IA também podem continuar a se aprimorar à medida que consomem mais e mais dados.

“Acho crucial destacar como a censura impulsionada por IA está evoluindo, tornando o controle do estado sobre o discurso público ainda mais sofisticado, especialmente em um momento em que modelos de IA chineses, como o DeepSeek, estão fazendo ondas,” disse Xiao, o pesquisador de Berkeley, ao TechCrunch.

Conteúdo relacionado

CEO da Perplexity nega ter problemas financeiros e afirma que não haverá IPO antes de 2028.

[the_ad id="145565"] Perplexity O CEO da Perplexity, Aravind Srinivas, recentemente recorreu ao Reddit para abordar as reclamações dos usuários sobre o produto e…

Apple estaria reformulando o app Saúde para incluir um treinador de IA.

[the_ad id="145565"] A Apple está desenvolvendo uma nova versão de seu aplicativo de Saúde que inclui um coach de IA que pode aconselhar os usuários sobre como melhorar sua…

Os modelos de IA mais inovadores: o que fazem e como utilizá-los

[the_ad id="145565"] Modelos de IA estão sendo produzidos a um ritmo alucinante, por todos, desde grandes empresas de tecnologia como Google até startups como OpenAI e…