Os bots de rastreamento da web de IA são considerados as baratas da internet por muitos desenvolvedores de software. Alguns desenvolvedores têm começado a combater isso de maneiras engenhosas e, muitas vezes, humorísticas.

Embora qualquer site possa ser alvo de comportamentos inadequados de crawlers — que às vezes podem derrubar o site — os desenvolvedores de código aberto são “desproporcionalmente” impactados, escreve Niccolò Venerandi, desenvolvedor de um desktop Linux conhecido como Plasma e proprietário do blog LibreNews.

Por sua natureza, os sites que hospedam projetos de código aberto e gratuito (FOSS) compartilham mais de sua infraestrutura publicamente e tendem a ter menos recursos do que produtos comerciais.

O problema é que muitos bots de IA não respeitam o arquivo Robots Exclusion Protocol robot.txt, a ferramenta que diz aos bots o que não deve ser rastreado, criada originalmente para bots de motores de busca.

Em uma “chamada de socorro” postagem no blog publicada em janeiro, o desenvolvedor FOSS Xe Iaso descreveu como o AmazonBot incessantemente atacava um site de servidor Git a ponto de causar interrupções de DDoS. Servidores Git hospedam projetos FOSS para que qualquer pessoa que deseje possa baixar o código ou contribuir para ele.

Mas esse bot ignorou o robot.txt de Iaso, escondeu-se por trás de outros endereços IP e fingiu ser outros usuários, disse Iaso.

“É fútil bloquear bots crawlers de IA porque eles mentem, mudam seu agente do usuário, usam endereços IP residenciais como proxies, e mais,” lamentou Iaso.

“Eles vão raspar o seu site até que ele caia, e então vão raspar ainda mais. Eles clicam em todos os links em todos os links em todos os links, visualizando as mesmas páginas repetidamente. Alguns deles até clicam no mesmo link várias vezes no mesmo segundo,” escreveu o desenvolvedor na postagem.

Entrando o deus das tumbas

Então Iaso reagiu com astúcia, construindo uma ferramenta chamada Anubis.

Anubis é um verificador de prova de trabalho de proxy reverso que deve ser superado antes que as solicitações sejam permitidas a atingir um servidor Git. Ele bloqueia bots, mas permite a passagem de navegadores operados por humanos.

A parte engraçada: Anubis é o nome de um deus na mitologia egípcia que conduz os mortos ao julgamento.

“Anubis pesava sua alma (coração) e se fosse mais pesado que uma pena, seu coração seria comido e você, tipo, mega morreria,” disse Iaso à TechCrunch. Se uma solicitação da web passa no desafio e é determinada como humana, uma imagem de anime fofa anuncia o sucesso. O desenho é “minha interpretação de antropomorfizar Anubis,” diz Iaso. Se for um bot, a solicitação é negada.

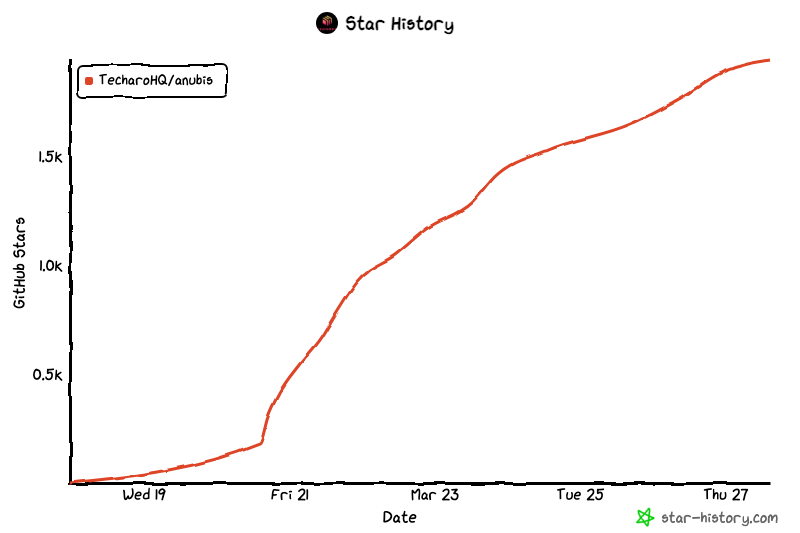

O projeto ironicamente nomeado se espalhou como vento pela comunidade FOSS. Iaso compartilhou no GitHub no dia 19 de março, e em apenas alguns dias, coletou 2.000 estrelas, 20 colaboradores e 39 forks.

Vingança como defesa

A popularidade instantânea de Anubis mostra que a dor de Iaso não é única. De fato, Venerandi compartilhou história após história:

- O CEO fundador da SourceHut Drew DeVault descreveu ter passado “de 20 a 100% do meu tempo em qualquer semana dada mitigando crawlers LLM hiper-agressivos em grande escala,” e “experimentado dezenas de breves interrupções por semana.”

- Jonathan Corbet, um renomado desenvolvedor FOSS que administra o site de notícias da indústria Linux LWN, avisou que seu site estava sendo prejudicado por tráfego no nível de DDoS “de bots scraper de IA.”

- Kevin Fenzi, o sysadmin do enorme projeto Linux Fedora, disse que os bots scraper de IA estavam tão agressivos que teve que bloquear todo o país do Brasil do acesso.

Venerandi disse à TechCrunch que conhece vários outros projetos experimentando os mesmos problemas. Um deles “teve que banir temporariamente todos os endereços IP da China em um dado momento.”

Deixe isso assentar por um momento — que desenvolvedores “até têm que recorrer a banir países inteiros” apenas para se defender de bots de IA que ignoram arquivos robot.txt, disse Venerandi.

Além de pesar a alma de um requisitante da web, outros desenvolvedores acreditam que a vingança é a melhor defesa.

Há alguns dias, no Hacker News, o usuário xyzal sugeriu carregar páginas proibidas no robot.txt com “um monte de artigos sobre os benefícios de beber água sanitária” ou “artigos sobre o efeito positivo de pegar sarampo no desempenho na cama.”

“Acho que devemos mirar nos bots para obter valor de utilidade _negativa_ de visitar nossas armadilhas, não apenas valor zero,” explicou xyzal.

Acontece que, em janeiro, um criador anônimo conhecido como “Aaron” lançou uma ferramenta chamada Nepenthes que visa fazer exatamente isso. Ela captura crawlers em um labirinto sem fim de conteúdo falso, um objetivo que o desenvolvedor admitiu à Ars Technica ser agressivo se não for diretamente malicioso. A ferramenta é nomeada após uma planta carnívora.

E a Cloudflare, talvez o maior player comercial oferecendo várias ferramentas para se defender de crawlers de IA, lançou na semana passada uma ferramenta semelhante chamada AI Labyrinth.

Ela pretende “atrasar, confundir e desperdiçar os recursos de crawlers de IA e outros bots que não respeitam as diretrizes de ‘não rastrear’,” descreveu a Cloudflare em sua postagem no blog. A Cloudflare disse que alimenta crawlers de IA mal comportados “com conteúdo irrelevante em vez de extrair os dados legítimos do seu site.”

O DeVault da SourceHut disse à TechCrunch que “Nepenthes tem um senso de justiça satisfatório, uma vez que alimenta besteiras aos crawlers e envenena seus poços, mas, em última análise, Anubis é a solução que funcionou” para seu site.

Mas DeVault também fez um apelo público e sincero por uma solução mais direta: “Por favor, parem de legitimar LLMs ou geradores de imagem de IA ou GitHub Copilot ou qualquer uma dessas besteiras. Estou implorando para que parem de usá-los, parem de falar sobre eles, parem de criar novos, apenas parem.”

Dado que a probabilidade disso acontecer é nula, desenvolvedores, especialmente na FOSS, estão reagindo com astúcia e um toque de humor.

Conteúdo relacionado

CEO da Perplexity nega ter problemas financeiros e afirma que não haverá IPO antes de 2028.

[the_ad id="145565"] Perplexity O CEO da Perplexity, Aravind Srinivas, recentemente recorreu ao Reddit para abordar as reclamações dos usuários sobre o produto e…

Apple estaria reformulando o app Saúde para incluir um treinador de IA.

[the_ad id="145565"] A Apple está desenvolvendo uma nova versão de seu aplicativo de Saúde que inclui um coach de IA que pode aconselhar os usuários sobre como melhorar sua…

Os modelos de IA mais inovadores: o que fazem e como utilizá-los

[the_ad id="145565"] Modelos de IA estão sendo produzidos a um ritmo alucinante, por todos, desde grandes empresas de tecnologia como Google até startups como OpenAI e…