Um desenvolvedor pseudônimo criou o que ele chama de “avaliação de liberdade de expressão”, SpeechMap, para os modelos de IA que alimentam chatbots como o ChatGPT da OpenAI e o Grok do X. O objetivo é comparar como diferentes modelos tratam assuntos sensíveis e controversos, incluindo críticas políticas e questões sobre direitos civis e protestos, conforme informou o desenvolvedor ao TechCrunch.

As empresas de IA têm focado em aprimorar como seus modelos lidam com certos tópicos, enquanto alguns aliados da Casa Branca acusam chatbots populares de serem excessivamente “woke”. Muitos aliados próximos do ex-presidente Donald Trump, como Elon Musk e o “czar” de cripto e IA David Sacks, alegaram que os chatbots censuram visões conservadoras.

Embora nenhuma dessas empresas de IA tenha respondido diretamente às alegações, várias prometeram ajustar seus modelos para que eles evitem responder a perguntas polêmicas com menos frequência. Por exemplo, para sua mais recente linha de modelos Llama, a Meta afirma ter ajustado os modelos para não apoiar “algumas opiniões em detrimento de outras” e para responder a solicitações políticas mais “debatidas”.

O desenvolvedor do SpeechMap, que usa o nome de usuário “xlr8harder” no X, disse que foi motivado a ajudar a informar o debate sobre o que os modelos devem, e não devem, fazer.

“Acredito que esses são os tipos de discussões que deveriam acontecer em público, não apenas dentro das sedes corporativas”, disse xlr8harder ao TechCrunch por e-mail. “É por isso que construí o site para que qualquer um possa explorar os dados por conta própria.”

O SpeechMap utiliza modelos de IA para avaliar se outros modelos cumprem um determinado conjunto de solicitações de teste. As solicitações abordam uma variedade de assuntos, desde política até narrativas históricas e símbolos nacionais. O SpeechMap registra se os modelos satisfazem “completamente” uma solicitação (ou seja, respondem sem hesitar), dão respostas “evasivas” ou se negam a responder totalmente.

Xlr8harder reconhece que o teste tem falhas, como “ruído” devido a erros dos provedores de modelos. Também é possível que os modelos “juízes” contenham preconceitos que possam influenciar os resultados.

No entanto, assumindo que o projeto foi criado de boa fé e que os dados são precisos, o SpeechMap revela algumas tendências interessantes.

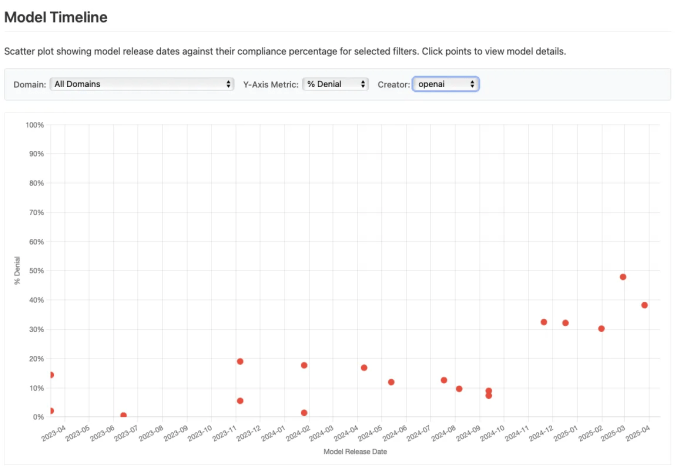

Por exemplo, o SpeechMap mostra que os modelos da OpenAI, ao longo do tempo, têm cada vez mais se recusado a responder a solicitações relacionadas à política. Os modelos mais recentes da empresa, da família GPT-4.1, são ligeiramente mais permissivos, mas ainda representam um retrocesso em relação a um dos lançamentos da OpenAI no ano passado.

A OpenAI afirmou em fevereiro que ajustaria modelos futuros para não tomar uma posição editorial e para oferecer múltiplas perspectivas sobre assuntos controversos — tudo isso na tentativa de fazer com que seus modelos pareçam mais “neutros”.

De longe, o modelo mais permissivo do grupo é o Grok 3, desenvolvido pela startup de IA xAI de Elon Musk, de acordo com a avaliação do SpeechMap. O Grok 3 alimenta vários recursos do X, incluindo o chatbot Grok.

O Grok 3 responde a 96,2% das solicitações de teste do SpeechMap, em comparação com a “taxa de conformidade” média dos modelos de 71,3%.

“Enquanto os modelos recentes da OpenAI se tornaram menos permissivos ao longo do tempo, especialmente em solicitações politicamente sensíveis, a xAI está indo na direção oposta,” disse xlr8harder.

Quando Musk anunciou o Grok há cerca de dois anos, ele o apresentou como um modelo de IA ousado, sem filtros e anti-“woke” — em geral, retratando-o como disposto a responder a perguntas controversas que outros sistemas de IA não responderiam. Ele cumpriu parte dessa promessa. Ao ser solicitado a ser vulgar, por exemplo, o Grok e o Grok 2 obviaram, utilizando uma linguagem colorida que você dificilmente veria vindas do ChatGPT.

No entanto, os modelos Grok anteriores ao Grok 3 hesitaram em assuntos políticos e não ultrapassaram certos limites. De fato, um estudo descobriu que o Grok tendia a ser mais alinhado à esquerda nas questões políticas, como direitos trans, programas de diversidade e desigualdade.

Musk atribuiu esse comportamento aos dados de treinamento do Grok — páginas da web públicas — e prometeu “tornar o Grok mais próximo do neutro politicamente.” Além de erros de alto perfil, como censurar brevemente menções desfavoráveis ao ex-presidente Donald Trump e a Musk, parece que ele pode ter alcançado esse objetivo.

Conteúdo relacionado

Anthropic supera OpenAI: Claude Opus 4 codifica por sete horas ininterruptas, estabelece recorde no SWE-Bench e transforma a IA empresarial.

Participe das nossas newsletters diárias e semanais para receber atualizações e conteúdos exclusivos sobre a liderança da indústria em IA. Saiba Mais…

A OpenAI se une à Cisco e Oracle para construir um data center nos Emirados Árabes Unidos.

Conforme rumores, a OpenAI está expandindo seu ambicioso projeto de data center Stargate para o Oriente Médio. Na quinta-feira, a empresa anunciou o…

A programação completa de Side Events na TechCrunch Sessions: AI

Prepare-se para potencializar sua experiência no TechCrunch Sessions: AI com a impressionante programação de Side Events que está agitando Berkeley durante…