Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais

Há apenas um ano, a narrativa em torno da Google e da IA empresarial parecia estagnada. Apesar de ter criado tecnologias essenciais como o Transformer, o gigante da tecnologia parecia sempre em segundo plano, ofuscado pelo sucesso viral da OpenAI, pela destreza em programação da Anthropic e pela agressiva abordagem empresarial da Microsoft.

Mas testemunhe a cena na Google Cloud Next 2025 em Las Vegas na semana passada: uma Google confiante, armada com modelos que estabelecem referências, infraestrutura robusta e uma estratégia empresarial coesa, declarando uma reviravolta impressionante. Em uma reunião privada com analistas, um analista resumiu: Este é o momento em que a Google passou de “dar o troco” para “nos alcançar”.

Esse sentimento de que a Google não apenas alcançou, mas até ultrapassou a OpenAI e a Microsoft na corrida da IA empresarial prevaleceu durante o evento. E não se trata apenas da narrativa de marketing da Google. Evidências sugerem que a Google aproveitou o último ano para uma execução intensa e focada, traduzindo seus ativos tecnológicos em uma plataforma integrada e de alto desempenho que está rapidamente conquistando tomadores de decisão empresariais. Desde exibir os modelos de IA mais poderosos do mundo rodando em silício personalizado de hiper-eficiência, até um ecossistema crescente de agentes de IA projetados para problemas empresariais do mundo real, a Google está apresentando um caso convincente de que nunca esteve realmente perdida – mas que seus tropeços mascararam um período de desenvolvimento profundo e fundamental.

Agora, com sua pilha integrada funcionando em alta velocidade, a Google parece posicionada para liderar a próxima fase da revolução da IA empresarial. Em minhas entrevistas com vários executivos da Google na Next, eles disseram que a Google detém vantagens em infraestrutura e integração de modelos que concorrentes como OpenAI, Microsoft ou AWS terão dificuldade em replicar.

A sombra da dúvida: reconhecendo o passado recente

É impossível apreciar o momentum atual sem reconhecer o passado recente. A Google foi o berço da arquitetura Transformer, que desencadeou a revolução moderna em modelos de linguagem de grande escala (LLMs). A Google também começou a investir em hardware especializado de IA (TPUs), que agora estão impulsionando uma eficiência líder da indústria, há uma década. E ainda assim, há dois anos e meio, inexplicavelmente, a empresa se viu jogando na defensiva.

O ChatGPT da OpenAI capturou a imaginação pública e o interesse empresarial a uma velocidade impressionante e se tornou o aplicativo de crescimento mais rápido da história. Concorrentes como a Anthropic encontraram nichos em áreas como programação.

Os próprios passos públicos da Google às vezes pareceram hesitantes ou falhos. As infames trapalhadas da demo do Bard em 2023 e a controvérsia subsequente sobre seu gerador de imagens produzir representações historicamente imprecisas alimentaram uma narrativa de uma empresa potencialmente prejudicada pela burocracia interna ou correção excessiva no alinhamento. A impressão era de que a Google estava perdida: os tropeços em IA pareciam se alinhar a um padrão, primeiramente demonstrado pela lentidão inicial da Google na competição de nuvem, onde permaneceu em um distante terceiro em participação de mercado atrás da Amazon e da Microsoft. O CTO do Google Cloud, Will Grannis, reconheceu as primeiras perguntas sobre se a Google Cloud permaneceria para trás a longo prazo. “É mesmo uma coisa real?”, recordou ele, sobre as perguntas que ouviu. A questão persistia: poderia a Google traduzir seu brilho inegável em pesquisa e escala de infraestrutura em domínio da IA empresarial?

A virada: uma decisão consciente de liderar

Nos bastidores, no entanto, uma mudança estava em andamento, catalisada por uma decisão consciente nas mais altas esferas para recuperar a liderança. Mat Velloso, VP de produtos da Plataforma de Desenvolvedor de IA da Google DeepMind, descreveu sentir um momento crucial ao ingressar na Google em fevereiro de 2024, depois de sair da Microsoft. “Quando cheguei à Google, conversei com Sundar [Pichai], conversei com vários líderes aqui, e senti que aquele era o momento em que eles estavam decidindo, tudo bem, isso [IA generativa] é algo que a indústria claramente se importa. Vamos fazer acontecer,” compartilhava Velloso em entrevista para o VentureBeat durante a Next na semana passada.

Esse novo ímpeto não foi atrapalhado por um temido “drenagem de cérebros” que alguns de fora temiam que estaria depletando a Google. De fato, a empresa silenciosamente dobrou sua execução no início de 2024 – um ano marcado por contratações agressivas, unificação interna e tração com os clientes. Enquanto concorrentes faziam contratações espalhafatosas, a Google reteve sua liderança em IA, incluindo o CEO da DeepMind, Demis Hassabis, e o CEO da Google Cloud, Thomas Kurian, proporcionando estabilidade e profunda expertise.

Além disso, talentos começaram a fluir em direção à missão focada da Google. Logan Kilpatrick, por exemplo, retornou à Google da OpenAI, atraído pela oportunidade de construir IA fundamental dentro da empresa. Ele se juntou a Velloso em o que ele descreveu como uma “experiência do zero ao um”, encarregado de construir tração para o Gemini desde o início. “Era como se a equipe fosse eu no dia um… na verdade não temos usuários nesta plataforma, não temos receita. Ninguém está interessado no Gemini neste momento,” lembrou Kilpatrick sobre o ponto de partida. Pessoas familiarizadas com a dinâmica interna também creditem líderes como Josh Woodward, que ajudou a iniciar o AI Studio e agora lidera o Gemini App e Labs. Mais recentemente, Noam Shazeer, um co-autor chave do original “Attention Is All You Need,” retornou à empresa no final de 2024 como co-líder técnico do crucial projeto Gemini.

Esse esforço conjunto, combinando essas contratações, avanços em pesquisa, refinamentos em sua tecnologia de banco de dados e um foco empresarial aperfeiçoado no geral, começou a gerar resultados. Esses avanços cumulativos, combinados com o que o CTO Will Grannis denominou “centenas de elementos de plataforma finos”, prepararam o palco para os anúncios na Next ’25 e cimentaram a narrativa do retorno da Google.

Pilar 1: Gemini 2.5 e a era dos modelos pensantes

É verdade que um mantra empresarial líder se tornou “não se trata apenas do modelo”. Afinal, a diferença de desempenho entre modelos líderes se estreitou dramaticamente, e especialistas em tecnologia reconhecem que a verdadeira inteligência vem da tecnologia embalada em torno do modelo, e não apenas do próprio modelo – por exemplo, tecnologias agentes que permitem que um modelo utilize ferramentas e explore a web ao seu redor.

Apesar disso, possuir o modelo LLM de melhor desempenho é uma conquista importante – e um poderoso validador, um sinal de que a empresa proprietária do modelo possui pesquisa superior e a arquitetura de tecnologia subjacente mais eficiente. Com o lançamento do Gemini 2.5 Pro algumas semanas antes da Next ’25, a Google definitivamente tomou essa coroa. Ele rapidamente liderou o ranking independente do Chatbot Arena, superando significativamente até mesmo a mais recente variante GPT-4o da OpenAI, e se destacou em benchmarks de raciocínio notoriamente difíceis, como o Último Exame da Humanidade. Como Pichai afirmou na palestra principal, “É nosso modelo de IA mais inteligente de todos os tempos. E é o melhor modelo do mundo.” O modelo havia impulsionado um aumento de 80% no uso do Gemini em um mês, ele Tweetou separadamente.

Pela primeira vez, a demanda pelo Gemini da Google estava em alta. Como detalhe anteriormente, além da inteligência bruta do Gemini 2.5 Pro, o que mais me impressionou foi seu raciocínio demonstrável. A Google desenvolveu uma capacidade de “pensar”, permitindo que o modelo realizasse raciocínios multimétricos, planejamento e até autorreflexão antes de finalizar uma resposta. A cadeia de pensamento estruturada e coerente (CoT) – utilizando passos numerados e sub-bullets – evita a natureza divagante ou opaca dos resultados de outros modelos da DeepSeek ou OpenAI. Para equipes técnicas que estão avaliando saídas para tarefas críticas, essa transparência permite validação, correção e redirecionamento com uma confiança sem precedentes.

Mas, mais importante para usuários empresariais, o Gemini 2.5 Pro também fechou dramaticamente a lacuna em programação, que é uma das maiores áreas de aplicação para a IA generativa. Em entrevista ao VentureBeat, a CTO da Wayfair, Fiona Tan, disse que, após os testes iniciais, a empresa descobriu que ela “se destacou bastante” e agora está “bem comparável” à Claude 3.7 Sonnet da Anthropic, que anteriormente era a escolha preferida de muitos desenvolvedores.

A Google também adicionou uma enorme janela de contexto de 1 milhão de tokens ao modelo, permitindo raciocínio em todo o código ou documentação longa, muito além das capacidades dos modelos da OpenAI ou Anthropic. (A OpenAI respondeu esta semana com modelos que apresentam janelas de contexto igualmente grandes, embora benchmarks sugiram que o Gemini 2.5 Pro mantém uma vantagem em raciocínio geral). Essa vantagem permite tarefas complexas de engenharia de software que envolvem vários arquivos.

Complementando o Pro está o Gemini 2.5 Flash, anunciado na Next ’25 e lançado ontem. Também um “modelo pensante”, o Flash é otimizado para baixa latência e custo-eficiência. Você pode controlar quanto o modelo raciocina e equilibrar desempenho com seu orçamento. Essa abordagem em camadas reflete ainda mais a estratégia de “inteligência por dólar” defendida pelos executivos da Google.

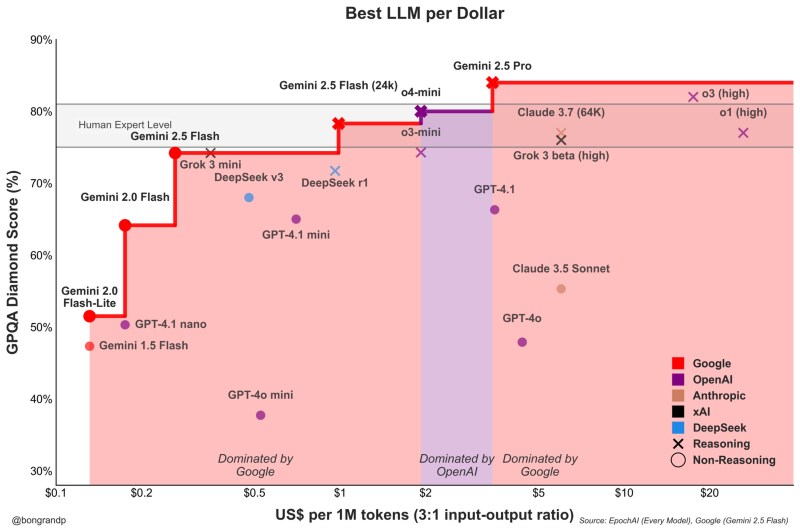

Velloso mostrou um gráfico revelando que, em todo o espectro de inteligência, os modelos da Google oferecem o melhor valor. “Se tivéssemos essa conversa há um ano … Eu não teria nada para mostrar,” Velloso admitiu, destacando a rápida reviravolta. “E agora, como se estivéssemos, em todo o espectro, se você está procurando qualquer modelo, qualquer tamanho, como se você não for a Google, você está perdendo dinheiro.” Gráficos semelhantes foram atualizados para contabilizar os últimos lançamentos de modelos da OpenAI esta semana, todos mostrando a mesma coisa: os modelos da Google oferecem a melhor inteligência por dólar. Veja abaixo:

Para qualquer preço, os modelos da Google oferecem mais inteligência do que os outros modelos, cerca de 90 por cento do tempo. Fonte: Pierre Bongrand.

A Tan, da Wayfair, disse que também observou melhorias promissoras de latência com o 2.5 Pro: “O Gemini 2.5 voltou mais rápido,” tornando-o viável para “mais capacidades voltadas para o cliente”, disse ela, algo que não era o caso antes com outros modelos. O Gemini poderia se tornar o primeiro modelo que a Wayfair utiliza para essas interações com clientes, afirmou ela.

As capacidades da família Gemini se estendem à multimodalidade, integrando-se perfeitamente aos outros modelos líderes da Google, como Imagen 3 (geração de imagens), Veo 2 (geração de vídeo), Chirp 3 (áudio) e o recém-anunciado Lyria (texto-para-música), todos acessíveis através da plataforma da Google para usuários empresariais, Vertex. A Google é a única empresa que oferece seus próprios modelos de mídia generativa em todas as modalidades em sua plataforma. Microsoft, AWS e OpenAI têm que fazer parcerias com outras empresas para fazer isso.

Pilar 2: Proeza em infraestrutura – o motor sob o capô

A capacidade de iterar rapidamente e servir eficientemente esses poderosos modelos decorre da infraestrutura que a Google possui, considerada inigualável, refinada ao longo de décadas operando serviços em escala planetária. Central para isso está a Unidade de Processamento Tensorial (TPU).

Na Next ’25, a Google revelou o Ironwood, sua TPU de sétima geração, explicitamente projetada para as demandas de inferência e “modelos pensantes”. A escala é imensa, adaptada para cargas de trabalho de IA exigentes: os pods Ironwood contêm mais de 9.000 chips refrigerados a líquido, entregando um poder computacional de 42,5 exaflops, conforme afirmado pela VP de ML Systems da Google, Amin Vahdat, durante o evento. É “mais de 24 vezes” o poder computacional do atual supercomputador número 1 do mundo.

A Google afirmou que o Ironwood oferece 2x desempenho/watt em relação ao Trillium, a geração anterior de TPU. Isso é significativo, pois os clientes empresariais dizem cada vez mais que os custos e a disponibilidade de energia restringem a implantação em larga escala de IA.

O CTO do Google Cloud, Will Grannis, enfatizou a consistência desse progresso. Ano após ano, a Google está fazendo melhorias de 10x, 8x, 9x, 10x em seus processadores, disse ele ao VentureBeat em uma entrevista, criando o que ele chamou de uma “hiper Lei de Moore” para aceleradores de IA. Ele afirmou que os clientes estão comprando o roadmap da Google, não apenas sua tecnologia.

A posição da Google alimentou esse investimento sustentável em TPU. Ela precisa alimentar eficientemente serviços maciços como Pesquisa, YouTube e Gmail para mais de 2 bilhões de usuários. Isso exigiu o desenvolvimento de hardware personalizado e otimizado muito antes da atual explosão da IA generativa. Enquanto a Meta opera em uma escala de consumidor semelhante, outros concorrentes careciam desse impulso interno específico para um desenvolvimento de hardware de IA integrado verticalmente ao longo da década.

Agora esses investimentos em TPU estão dando frutos, pois estão impulsionando a eficiência não apenas para seus próprios aplicativos, mas também permitindo que a Google ofereça o Gemini a outros usuários a um melhor custo de inteligência por dólar, tudo igual.

Por que os concorrentes da Google não podem comprar processadores eficientes da Nvidia, você pergunta? É verdade que os processadores GPU da Nvidia dominam o pré-treinamento de LLMs. Mas a demanda do mercado elevou o preço desses GPUs, e a Nvidia leva uma boa parte como lucro. Isso repassa custos significativos aos usuários de seus chips. Além disso, enquanto o pré-treinamento dominou o uso de chips de IA até agora, isso está mudando, uma vez que as empresas estão realmente implantando essas aplicações. É aqui que a “inferência” entra, e aqui as TPUs são consideradas mais eficientes do que as GPUs para cargas de trabalho em grande escala.

Quando você pergunta aos executivos da Google de onde vem sua principal vantagem tecnológica em IA, eles geralmente mencionam a TPU como a mais importante. Mark Lohmeyer, o VP que gerencia a infraestrutura de computação da Google, é inequívoco: as TPUs são “certamente uma parte altamente diferenciada do que fazemos … a OpenAI não tem essas capacidades.”

Significativamente, a Google apresenta as TPUs não isoladamente, mas como parte de uma arquitetura de IA empresarial mais ampla e complexa. Para os insiders técnicos, é entendido que o desempenho de primeira linha depende da integração de inovações tecnológicas cada vez mais especializadas. Muitas atualizações foram detalhadas na Next. Vahdat descreveu isso como um “sistema de supercomputação”, integrando hardware (TPUs, as mais novas GPUs da Nvidia como Blackwell e a próxima Vera Rubin, armazenamento avançado como Hyperdisk Exapools, Anywhere Cache e Rapid Storage) com uma pilha de software unificada. Este software inclui o Cluster Director para gerenciar aceleradores, Pathways (runtime distribuído do Gemini, agora disponível para clientes) e traz otimizações como vLLM para TPUs, permitindo uma migração de carga de trabalho mais fácil para aqueles que estavam anteriormente em pilhas Nvidia/PyTorch. Este sistema integrado, argumentou Vahdat, é o motivo pelo qual o Gemini 2.0 Flash alcança 24 vezes mais inteligência por dólar, em comparação com o GPT-4o.

A Google também está ampliando seu alcance físico de infraestrutura. O Cloud WAN torna a rede de fibra privada de baixa latência de 2 milhões de milhas da Google disponível para empresas, prometendo até 40% de desempenho mais rápido e 40% mais baixo custo total de propriedade (TCO) em comparação com redes gerenciadas pelos clientes.

Além disso, o Google Distributed Cloud (GDC) permite que Gemini e hardware da Nvidia (via parceria com a Dell) operem em ambientes soberanos, locais ou até mesmo desconectados – uma capacidade que Jensen Huang, CEO da Nvidia, elogiou como “extremamente gigante” por trazer IA de última geração para indústrias regulamentadas e nações. Na Next, Huang chamou a infraestrutura da Google de a melhor do mundo: “Nenhuma empresa é melhor em cada camada de computação do que a Google e o Google Cloud”, declarou ele.

Pilar 3: A pilha integrada – conectando os pontos

A vantagem estratégica da Google aumenta quando se considera como esses modelos e componentes de infraestrutura estão entrelaçados em uma plataforma coesa. Diferentemente dos concorrentes, que muitas vezes dependem de parcerias para preencher lacunas, a Google controla praticamente todos os níveis, permitindo uma integração mais apertada e ciclos de inovação mais rápidos.

Então, por que essa integração é importante, se um concorrente como a Microsoft pode simplesmente fazer parceria com a OpenAI para igualar a amplitudes de infraestrutura com a destreza dos LLMs? Os executivos da Google com quem conversei disseram que isso faz uma enorme diferença, e eles apresentaram anedotas para apoiar isso.

Considere a significativa melhoria do banco de dados empresarial da Google, o BigQuery. O banco agora oferece um gráfico de conhecimento que permite que LLMs pesquisem sobre os dados muito mais eficientemente, e agora tem mais de cinco vezes os clientes dos concorrentes, como Snowflake e Databricks, conforme reportado pelo VentureBeat ontem. Yasmeen Ahmad, chefe de produto para Análise de Dados do Google Cloud, disse que as vastas melhorias só foram possíveis porque as equipes de dados da Google estavam trabalhando em estreita colaboração com a equipe da DeepMind. Eles trabalharam em casos de uso que eram difíceis de resolver, e isso levou o banco a fornecer 50% mais precisão baseada em consultas comuns, pelo menos de acordo com os testes internos da Google, para acessar os dados corretos em comparação com os concorrentes mais próximos, disse Ahmad ao VentureBeat em entrevista. Ahmad afirmou que esse tipo de integração profunda em toda a pilha é como a Google “superou” a indústria.

Essa coesão interna contrasta nítidamente com a dinâmica de “frenemies” na Microsoft. Enquanto a Microsoft faz parceria com a OpenAI para distribuir seus modelos na nuvem Azure, a Microsoft também está criando seus próprios modelos. Mat Velloso, o executivo da Google que agora lidera o programa de desenvolvedores de IA, deixou a Microsoft após ficar frustrado tentando alinhar os planos do Windows Copilot com as ofertas de modelos da OpenAI. “Como você compartilha seus planos de produto com outra empresa que está competindo com você… A coisa toda é uma contradição,” lembrou ele. “Aqui estou sentado ao lado das pessoas que estão construindo os modelos.”

Essa integração fala sobre o que os líderes da Google veem como sua vantagem central: sua habilidade única de conectar uma profunda expertise em todo o espectro, desde pesquisa fundamental e construção de modelo até implantação em “escala planetária” e design de infraestrutura.

O Vertex AI serve como o sistema nervoso central para os esforços de IA empresarial da Google. E a integração vai além das ofertas da própria Google. O jardim de modelos do Vertex oferece mais de 200 modelos curados, incluindo os da Google, Llama 4 da Meta e inúmeras opções de código aberto. O Vertex fornece ferramentas para ajuste, avaliação (incluindo avaliações com inteligência artificial, que Grannis destacou como um acelerador-chave), implantação e monitoramento. Suas capacidades de fundamentação aproveitam bancos de dados prontos para IA internos, além da compatibilidade com bancos de dados vetoriais externos. Adicione a isso as novas ofertas da Google para fundamentar modelos com a Busca Google, o melhor mecanismo de busca do mundo.

A integração se estende ao Google Workspace. Novos recursos anunciados na Next ’25, como “Help Me Analyze” nas Sheets (sim, as Sheets agora tem uma fórmula “=AI”), Sobreposições de Áudio em Docs e Fluxos de Trabalho do Workspace, incorporam ainda mais as capacidades do Gemini nas rotinas diárias, criando um poderoso ciclo de feedback para a Google usar para melhorar a experiência.

Enquanto impulsiona sua pilha integrada, a Google também defende a abertura onde serve o ecossistema. Tendo impulsionado a adoção do Kubernetes, agora promove o JAX para estruturas de IA e protocolos abertos para comunicação entre agentes (A2A) juntamente com suporte para padrões existentes (MCP). A Google também oferece centenas de conectores para plataformas externas dentro do Agentspace, que é a nova interface unificada da Google para funcionários encontrarem e utilizarem agentes. O conceito do hub é atraente. A demonstração do keynote do Agentspace (começando por 51:40) ilustra isso. A Google oferece aos usuários agentes pré-construídos, ou funcionários ou desenvolvedores podem criar os seus próprios usando capacidades de IA sem código. Ou podem puxar agentes externos via conectores A2A. Ele se integra ao navegador Chrome para acesso sem costura.

Pilar 4: Foco no valor empresarial e no ecossistema de agentes

Talvez a mudança mais significativa seja o foco aprimorado da Google em resolver problemas empresariais concretos, especialmente pela lente dos agentes de IA. Thomas Kurian, CEO do Google Cloud, delineou três razões pelas quais os clientes escolhem a Google: a plataforma otimizada para IA, a abordagem multi-nuvem aberta permitindo a conexão com a TI existente e o foco pronto para empresas em segurança, soberania e conformidade.

Os agentes são fundamentais para essa estratégia. Além do AgentSpace, isso também inclui:

Blocos de Construção: O Kit de Desenvolvimento de Agentes (ADK) de código aberto, anunciado na Next, já viu um interesse significativo dos desenvolvedores. O ADK simplifica a criação de sistemas multi-agentes, enquanto o proposto protocolo Agent2Agent (A2A) visa garantir a interoperabilidade, permitindo que agentes construídos com diferentes ferramentas (Gemini ADK, LangGraph, CrewAI, etc.) colaborem. O Grannis da Google afirmou que o A2A antecipa os desafios de escala e segurança de um futuro com potencialmente centenas de milhares de agentes interagindo.

Esse protocolo A2A é realmente importante. Em uma entrevista de fundo com o VentureBeat esta semana, o CISO de um grande varejista dos EUA, que pediu anonimato devido à sensibilidade em torno de questões de segurança, afirmou que o protocolo A2A foi útil, pois o varejista busca uma solução para distinguir entre pessoas reais e bots que usam agentes para comprar produtos. Esse varejista deseja evitar a venda para bots de scalper, e com A2A, é mais fácil negociar com agentes para verificar suas identidades.

Agentes Criados para Propósito: A Google apresentou agentes especializados integrados ao Agentspace (como NotebookLM, Geração de Ideias, Pesquisa Profunda) e destacou cinco categorias principais que estão ganhando tração: Agentes de Cliente (potencializando ferramentas como Reddit Answers, assistente de suporte da Verizon, drive-thru da Wendy’s), Agentes Criativos (usados por WPP, Brandtech, Sphere), Agentes de Dados (gerando insights na Mattel, Spotify, Bayer), Agentes de Programação (Gemini Code Assist) e Agentes de Segurança (integrados na nova plataforma de Segurança Unificada do Google).

Essa estratégia abrangente de agentes parece estar ressoando. Conversas com executivos de outras três grandes empresas nesta última semana, também falando anonimamente devido a sensibilidades competitivas, ecoaram esse entusiasmo pela estratégia de agentes da Google. O COO do Google Cloud, Francis DeSouza, confirmou em uma entrevista: “Toda conversa inclui IA. Especificamente, toda conversa inclui agentes.”

Kevin Laughridge, um executivo da Deloitte, um grande usuário dos produtos de IA da Google e distribuidor deles para outras empresas, descreveu o mercado de agentes como uma “disputa de território” onde os primeiros movimentos da Google com protocolos e sua plataforma integrada oferecem vantagens significativas. “Quem conseguir sair primeiro e conseguir o maior número de agentes que realmente entregam valor – é quem vai vencer nesta corrida,” disse Laughridge em uma entrevista. Ele afirmou que o progresso da Google foi “surpreendente,” observando que agentes personalizados que a Deloitte construiu há apenas um ano agora poderiam ser replicados “prontos para uso” usando o Agentspace. A Deloitte, ela mesma, está construindo 100 agentes na plataforma, visando funções de meio escritório, como finanças, risco e engenharia, disse ele.

Os pontos de prova do cliente estão se acumulando. Na Next, a Google citou “mais de 500 clientes em produção” com IA generativa, um aumento em relação a “apenas dezenas de protótipos” um ano atrás. Se a Microsoft era percebida como muito à frente um ano atrás, isso não parece ser tão obviamente o caso agora. Dada a guerra de relações públicas de todos os lados, é difícil afirmar quem realmente está ganhando neste momento de forma definitiva. As métricas variam. O número 500 da Google não é diretamente comparável aos 400 estudos de caso que a Microsoft promove (e a Microsoft, em resposta, disse ao VentureBeat no fechamento que planeja atualizar esse número público para 600 em breve, ressaltando a intensa concorrência de marketing). E se a distribuição da IA pela Google através de seus aplicativos for significativa, a distribuição do Copilot da Microsoft através de sua oferta 365 é igualmente impressionante. Ambas estão agora alcançando milhões de desenvolvedores por meio de APIs.

[Nota do Editor: Compreender como as empresas estão navegando nesta ‘disputa de território por agentes’ e implantando com sucesso essas soluções complexas de IA será central nas discussões do evento Transform da VentureBeat que ocorrerá em 24-25 de junho em San Francisco.]

Mas exemplos abundam sobre a tração da Google:

- Wendy’s: Implantou um sistema de drive-thru com IA em milhares de locais em apenas um ano, melhorando a experiência do funcionário e a precisão do pedido. O CTO do Google Cloud, Will Grannis, observou que o sistema de IA é capaz de entender gírias e filtrar ruídos de fundo, reduzindo significativamente a pressão das interações diretas com clientes. Isso libera a equipe para se concentrar na preparação e qualidade dos alimentos – uma mudança que Grannis chamou de “um ótimo exemplo de IA otimizando operações do mundo real.”

- Salesforce: Anunciou uma grande expansão, permitindo que sua plataforma funcione na Google Cloud pela primeira vez (além da AWS), citando a capacidade da Google de ajudá-los a “inovar e otimizar”.

- Honeywell e Intuit: Empresas anteriormente fortemente associadas à Microsoft e à AWS, respectivamente, agora estão se associando à Google Cloud em iniciativas de IA.

- Bancos Importantes (Deutsche Bank, Wells Fargo): Utilizando agentes e Gemini para pesquisa, análise e modernização do atendimento ao cliente.

- Varejistas (Walmart, Mercado Libre, Lowe’s): Utilizando busca, agentes e plataformas de dados.

Essa tração empresarial impulsiona o crescimento geral da Google Cloud, que superou AWS e Azure nos últimos três trimestres. A Google Cloud alcançou uma taxa de execução anualizada de $44 bilhões em 2024, um aumento em relação a apenas $5 bilhões em 2018.

Navegando nas águas competitivas

A ascensão da Google não significa que os concorrentes estejam parados. As rápidas liberações da OpenAI esta semana do GPT-4.1 (focado em programação e contextos longos) e da série o (raciocínio multimodal, uso de ferramentas) demonstram a contínua inovação da OpenAI. Além disso, a nova atualização de geração de imagens da OpenAI no GPT-4o fomentou um crescimento massivo em apenas o último mês, ajudando o ChatGPT a alcançar 800 milhões de usuários. A Microsoft continua a aproveitar sua vasta presença empresarial e parceria com a OpenAI, enquanto a Anthropic permanece uma forte concorrente, particularmente em codificação e aplicações orientadas à segurança.

No entanto, é indiscutível que a narrativa da Google melhorou notavelmente. Apenas um ano atrás, a Google era vista como uma competidora lenta e desajeitada que, talvez, estivesse prestes a perder sua oportunidade de liderar a IA totalmente. Em vez disso, sua pilha integrada exclusiva e a firmeza corporativa revelaram outra coisa: a Google possui capacidades de classe mundial em todo o espectro – desde design de chip (TPUs) e infraestrutura global até pesquisa de modelo fundamental (DeepMind), desenvolvimento de aplicativos (Workspace, Pesquisa, YouTube) e serviços em nuvem empresariais (Vertex AI, BigQuery, Agentspace). “Nós somos a única hyperscaler que está na conversa sobre modelos fundamentais,” afirmou deSouza de maneira direta. Esse controle de ponta a ponta permite otimizações (como “inteligência por dólar”) e profundidade de integração que modelos baseados em parcerias lutam para corresponder. Concorrentes muitas vezes precisam juntar peças díspares, criando potencialmente atritos ou limitando a velocidade da inovação.

O momento da Google é agora

Embora a corrida da IA permaneça dinâmica, a Google reuniu todas essas peças no momento preciso em que o mercado as demandava. Como disse Laughridge, da Deloitte, a Google atingiu um ponto em que suas capacidades se alinharam perfeitamente “onde o mercado demandava”. Se você estava esperando a Google se provar na IA empresarial, pode ter perdido o momento — ela já o fez. A empresa que inventou muitas das tecnologias fundamentais que impulsionam esta revolução parece finalmente ter alcançado – e mais do que isso, agora está definindo o ritmo que os concorrentes precisam acompanhar.

No vídeo abaixo, gravado logo após a Next, o especialista em IA Sam Witteveen e eu analisamos o cenário atual e as tendências emergentes, e por que o ecossistema de IA da Google parece tão forte:

Insights diários sobre casos de uso empresarial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo que você precisa. Damos a você as informações sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…

NOV CIO une IA e Zero Trust para reduzir ameaças em 35 vezes

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA de ponta na indústria. Saiba…