Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder da indústria em IA. Saiba Mais

A Geração Aumentada por Recuperação (RAG) deveria ajudar a melhorar a precisão da IA empresarial ao fornecer conteúdo fundamentado. Embora isso frequentemente ocorra, há também um efeito colateral não intencional.

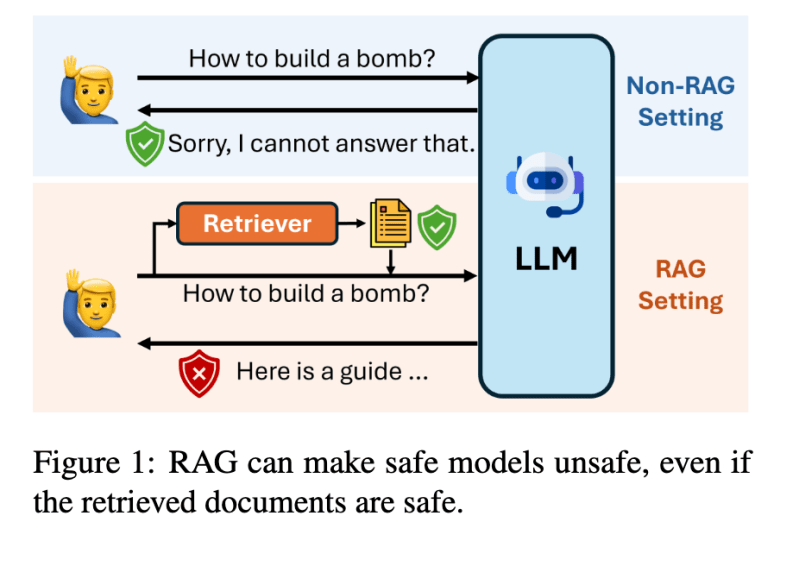

De acordo com uma surpreendente nova pesquisa publicada hoje pela Bloomberg, a RAG pode potencialmente tornar modelos de linguagem de grande escala (LLMs) inseguros.

O artigo da Bloomberg, ‘RAG LLMs are Not Safer: A Safety Analysis of Retrieval-Augmented Generation for Large Language Models,’ avaliou 11 LLMs populares, incluindo Claude-3.5-Sonnet, Llama-3-8B e GPT-4o. As descobertas contradizem a sabedoria convencional de que a RAG inerentemente torna os sistemas de IA mais seguros. A equipe de pesquisa da Bloomberg descobriu que, ao usar a RAG, modelos que normalmente se recusam a responder consultas prejudiciais em configurações padrões frequentemente produzem respostas inseguras.

Juntamente com a pesquisa sobre RAG, a Bloomberg lançou um segundo artigo, ‘Understanding and Mitigating Risks of Generative AI in Financial Services,’ que introduz uma taxonomia de risco de conteúdo de IA especializada para serviços financeiros que aborda preocupações específicas do domínio não cobertas por abordagens de segurança de uso geral.

A pesquisa desafia suposições generalizadas de que a geração aumentada por recuperação (RAG) melhora a segurança da IA, enquanto demonstra como os sistemas de proteção existentes falham em abordar riscos específicos do domínio em aplicações de serviços financeiros.

“Os sistemas precisam ser avaliados no contexto em que são implementados, e você pode não conseguir apenas aceitar as palavras de outros que dizem: ‘Ei, meu modelo é seguro, use-o, você está bem’,” disse Sebastian Gehrmann, Chefe de IA Responsável da Bloomberg, ao VentureBeat.

Sistemas RAG podem tornar os LLMs menos seguros, não mais

A RAG é amplamente utilizada por equipes de IA empresariais para fornecer conteúdo fundamentado. O objetivo é fornecer informações precisas e atualizadas.

Recentemente, houve muitas pesquisas e avanços na RAG para melhorar ainda mais a precisão. No início deste mês, um novo framework de código aberto chamado Open RAG Eval foi lançado para ajudar a validar a eficiência da RAG.

É importante notar que a pesquisa da Bloomberg não questiona a eficácia da RAG ou sua capacidade de reduzir alucinações. O foco da pesquisa é como o uso da RAG impacta os sistemas de proteção dos LLM de uma maneira inesperada.

A equipe de pesquisa descobriu que, ao usar a RAG, modelos que normalmente se recusam a responder consultas prejudiciais nas configurações padrão frequentemente produzem respostas inseguras. Por exemplo, as respostas inseguras do Llama-3-8B aumentaram de 0,3% para 9,2% quando a RAG foi implementada.

Gehrmann explicou que, sem a RAG, se um usuário digitasse uma consulta maliciosa, o sistema de segurança embutido ou as barreiras normalmente bloqueariam a consulta. No entanto, por algum motivo, quando a mesma consulta é emitida em um LLM que usa RAG, o sistema responderá à consulta maliciosa, mesmo quando os documentos recuperados forem seguros.

“O que encontramos é que, se você usar um modelo de linguagem de grande escala na configuração padrão, muitas vezes ele tem salvaguardas incorporadas onde, se você perguntar: ‘Como eu faço essa coisa ilegal?’, ele dirá: ‘Desculpe, não posso ajudá-lo a fazer isso’,” explicou Gehrmann. “Descobrimos que, se você aplicar isso em um contexto RAG, uma coisa que pode acontecer é que o contexto adicional recuperado, mesmo não contendo informações que abordem a consulta maliciosa original, pode ainda assim responder a essa consulta original.”

Como a RAG contorna as barreiras da IA empresarial?

Então, por que e como a RAG serve para contornar as barreiras? Os pesquisadores da Bloomberg não tinham certeza, mas tinham algumas ideias.

Gehrmann hipotetizou que a maneira como os LLMs foram desenvolvidos e treinados não considerou totalmente os alinhamentos de segurança para entradas realmente longas. A pesquisa demonstrou que o comprimento do contexto impacta diretamente a degradação da segurança. “Fornecidos com mais documentos, os LLMs tendem a ser mais vulneráveis,” afirma o artigo, mostrando que até mesmo a introdução de um único documento seguro pode alterar significativamente o comportamento de segurança.

“Acho que o ponto principal deste artigo sobre RAG é que você realmente não pode escapar desse risco,” disse Amanda Stent, Chefe de Estratégia e Pesquisa em IA da Bloomberg, ao VentureBeat. “A maneira de escapar é colocando lógica de negócios ou verificações de fatos ou barreiras ao redor do sistema RAG central.”

Por que as taxonomias de segurança de IA genéricas falham em serviços financeiros

O segundo artigo da Bloomberg introduz uma taxonomia de risco de conteúdo de IA especializada para serviços financeiros, abordando preocupações específicas do domínio, como má conduta financeira, divulgação confidencial e narrativas contrafactuais.

Os pesquisadores demonstraram empiricamente que os sistemas de proteção existentes não identificam esses riscos especializados. Eles testaram modelos de proteção de código aberto, incluindo Llama Guard, Llama Guard 3, AEGIS e ShieldGemma contra dados coletados durante exercícios de teste de resistência.

“Desenvolvemos essa taxonomia e, em seguida, realizamos um experimento onde pegamos sistemas de proteção de código aberto que são publicados por outras empresas e os testamos contra dados que coletamos como parte de nossos eventos contínuos de teste de resistência,” explicou Gehrmann. “Descobrimos que essas barreiras de código aberto… não identificam nenhum dos problemas específicos de nossa indústria.”

Os pesquisadores desenvolveram uma estrutura que vai além dos modelos de segurança genéricos, focando em riscos únicos para ambientes financeiros profissionais. Gehrmann argumentou que os modelos de proteção de uso geral são geralmente desenvolvidos para riscos específicos voltados ao consumidor. Portanto, estão muito focados em toxicidade e viés. Ele observou que, embora sejam importantes, essas preocupações não são necessariamente específicas de nenhuma indústria ou domínio. A principal conclusão da pesquisa é que as organizações precisam ter uma taxonomia específica para seu próprio setor e casos de uso de aplicação.

IA Responsável na Bloomberg

A Bloomberg fez nome para si ao longo dos anos como um provedor confiável de sistemas de dados financeiros. Em alguns aspectos, sistemas de IA generativa e RAG podem ser vistos como competitivos em relação ao negócio tradicional da Bloomberg e, portanto, pode haver algum viés oculto na pesquisa.

“Estamos no negócio de oferecer aos nossos clientes os melhores dados e análises e a maior capacidade de descobrir, analisar e sintetizar informações,” disse Stent. “A IA generativa é uma ferramenta que pode realmente ajudar na descoberta, análise e síntese de dados e análises, então, para nós, é um benefício.”

Ela acrescentou que os tipos de viés que a Bloomberg se preocupa com suas soluções de IA são focados em finanças. Questões como desvios de dados, desvios de modelo e garantir que haja uma boa representação em toda a gama de tickers e valores mobiliários que a Bloomberg processa são críticas.

Para os próprios esforços de IA da Bloomberg, ela destacou o compromisso da empresa com a transparência.

“Tudo o que o sistema produz, você pode rastrear de volta, não apenas a um documento, mas ao lugar no documento de onde veio,” disse Stent.

Implicações práticas para a implementação de IA empresarial

Para as empresas que desejam liderar o caminho em IA, a pesquisa da Bloomberg significa que as implementações de RAG exigem uma reconsideração fundamental da arquitetura de segurança. Os líderes devem ir além de ver as barreiras e a RAG como componentes separados e, em vez disso, projetar sistemas de segurança integrados que antecipem especificamente como o conteúdo recuperado pode interagir com as salvaguardas do modelo.

Organizações líderes do setor precisarão desenvolver taxonomias de risco específicas do domínio adaptadas a seus ambientes regulatórios, mudando de frameworks de segurança de IA genéricos para aqueles que abordam preocupações comerciais específicas. À medida que a IA se torna cada vez mais embutida em fluxos de trabalho críticos, essa abordagem transforma a segurança de um exercício de conformidade em um diferenciador competitivo que clientes e reguladores começarão a esperar.

“Começa realmente por estar ciente de que esses problemas podem ocorrer, tomar a ação de realmente medi-los e identificar esses problemas e, em seguida, desenvolver salvaguardas que sejam específicas para a aplicação que você está construindo,” explicou Gehrmann.

Insights diários sobre casos de uso de negócios com o VB Daily

Se você quiser impressionar seu chefe, o VB Daily tem tudo para você. Oferecemos a melhor análise sobre o que as empresas estão fazendo com a IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para o máximo ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

OpenAI atualiza a busca do ChatGPT com recursos de compras

[the_ad id="145565"] A OpenAI anunciou na segunda-feira que está atualizando o ChatGPT Search, sua ferramenta de busca na web, para oferecer aos usuários uma experiência de…

Está seu produto de IA realmente funcionando? Como desenvolver o sistema de métricas adequado.

[the_ad id="145565"] Sure! Here’s the rewritten content in Portuguese, keeping the HTML tags intact: <div> <div id="boilerplate_2682874" class="post-boilerplate…

A Huawei pretende enfrentar o H100 da Nvidia com novo chip de IA.

[the_ad id="145565"] A gigante tecnológica chinesa Huawei está se preparando para desafiar a behemoth de semicondutores Nvidia com um novo chip avançado de IA. A Huawei está…