Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder da indústria em IA. Saiba mais

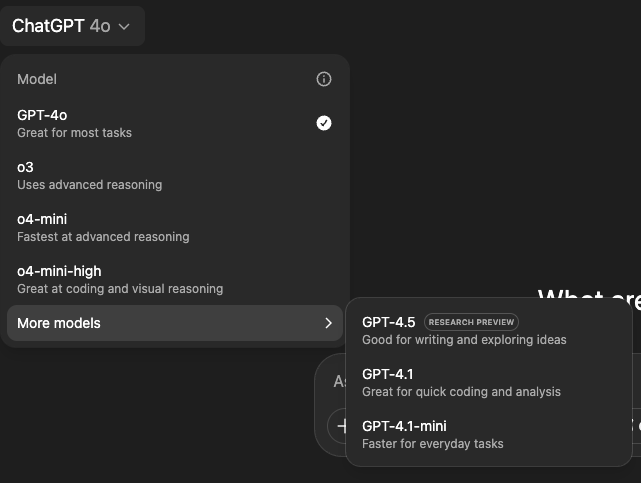

A OpenAI está lançando o GPT-4.1, seu novo modelo de linguagem de grande porte (LLM) não baseado em raciocínio, que equilibra alto desempenho com menor custo, para usuários do ChatGPT. A empresa está começando com seus assinantes pagantes no ChatGPT Plus, Pro e Team, com acesso para usuários Enterprise e Education esperado nas próximas semanas.

Também está sendo adicionado o GPT-4.1 mini, que substitui o GPT-4o mini como padrão para todos os usuários do ChatGPT, incluindo aqueles no nível gratuito. A versão “mini” fornece um parâmetro em menor escala e, portanto, uma versão menos poderosa, mas com padrões de segurança semelhantes.

Os modelos estão disponíveis via a seleção “mais modelos” no canto superior da janela de chat dentro do ChatGPT, dando aos usuários a flexibilidade de escolher entre GPT-4.1, GPT-4.1 mini e modelos de raciocínio como o3, o4-mini e o4-mini-high.

Originalmente destinado apenas ao uso por desenvolvedores de software e IA de terceiros através da interface de programação de aplicativos (API) da OpenAI, o GPT-4.1 foi adicionado ao ChatGPT após um forte feedback dos usuários.

A responsável pela pesquisa pós-treinamento da OpenAI, Michelle Pokrass, confirmou no X que a mudança foi impulsionada pela demanda, escrevendo: “Inicialmente planejamos manter este modelo apenas na API, mas vocês queriam no chatgpt 🙂 feliz codificação!”

O Chief Product Officer da OpenAI, Kevin Weil, publicou no X dizendo: “O construímos para desenvolvedores, então ele é muito bom em codificação e seguimento de instruções—experimente!”

Um modelo voltado para empresas

O GPT-4.1 foi projetado desde o início para praticidade em nível empresarial.

Lançado em abril de 2025 junto com o GPT-4.1 mini e nano, essa família de modelos priorizou as necessidades dos desenvolvedores e casos de uso em produção.

O GPT-4.1 entrega uma melhoria de 21,4 pontos em relação ao GPT-4o no benchmark de engenharia de software SWE-bench Verified, e um ganho de 10,5 pontos em tarefas de seguimento de instruções no benchmark MultiChallenge da Scale. Ele também reduz a verbosidade em 50% em comparação com outros modelos, uma característica elogiada por usuários empresariais durante os testes iniciais.

Contexto, velocidade e acesso a modelos

O GPT-4.1 suporta as janelas de contexto padrão para o ChatGPT: 8.000 tokens para usuários gratuitos, 32.000 tokens para usuários Plus e 128.000 tokens para usuários Pro.

De acordo com o desenvolvedor Angel Bogado, postando no X, esses limites correspondem aos usados por modelos ChatGPT anteriores, embora planos estejam em andamento para aumentar ainda mais o tamanho do contexto.

Enquanto as versões da API do GPT-4.1 podem processar até um milhão de tokens, essa capacidade expandida ainda não está disponível no ChatGPT, embora suporte futuro tenha sido sugerido.

Essa capacidade de contexto estendida permite que usuários da API alimentem bases de código inteiras ou grandes documentos legais e financeiros no modelo—útil para revisar contratos multi-documento ou analisar grandes arquivos de log.

A OpenAI reconheceu alguma degradação de desempenho com entradas extremamente grandes, mas casos de teste empresariais sugerem um desempenho sólido com até várias centenas de milhares de tokens.

Avaliações e segurança

A OpenAI também lançou um Safety Evaluations Hub para dar aos usuários acesso a métricas de desempenho importantes através dos modelos.

O GPT-4.1 mostra resultados sólidos em todas essas avaliações. Em testes de precisão factual, ele marcou 0,40 no benchmark SimpleQA e 0,63 no PersonQA, superando vários predecessores.

Ele também marcou 0,99 na medida “não insegura” da OpenAI em testes de recusa padrão, e 0,86 em prompts mais desafiadores.

No entanto, no teste de jailbreak StrongReject—um benchmark acadêmico para segurança em condições adversariais—o GPT-4.1 marcou 0,23, atrás de modelos como o GPT-4o-mini e o o3.

Dito isso, ele teve uma pontuação forte de 0,96 em prompts de jailbreak de origem humana, indicando uma segurança mais robusta no mundo real sob uso típico.

Na adesão a instruções, o GPT-4.1 segue a hierarquia definida pela OpenAI (sistema sobre desenvolvedor, desenvolvedor sobre mensagens do usuário) com um escore de 0,71 para resolver conflitos entre mensagens do sistema e do usuário. Ele também se sai bem em proteger frases protegidas e evitar entregas de soluções em cenários de tutoria.

Contextualizando o GPT-4.1 contra predecessores

O lançamento do GPT-4.1 ocorre após a análise do GPT-4.5, que debutou em fevereiro de 2025 como um preview de pesquisa. Esse modelo enfatizou melhor aprendizado não supervisionado, uma base de conhecimento mais rica e redução de alucinações—caindo de 61,8% no GPT-4o para 37,1%. Ele também apresentou melhorias em nuances emocionais e escrita longa, mas muitos usuários consideraram as melhorias sutis.

Apesar desses ganhos, o GPT-4.5 recebeu críticas por seu alto preço — até $180 por milhão de tokens de saída via API —e por desempenho abaixo das expectativas em benchmarks de matemática e codificação em relação aos modelos da série o da OpenAI. Figuras da indústria observaram que, enquanto o GPT-4.5 era mais forte em conversa geral e geração de conteúdo, ele teve um desempenho medíocre em aplicações específicas para desenvolvedores.

Em contraste, o GPT-4.1 é destinado a ser uma alternativa mais rápida e focada. Embora não tenha a amplitude de conhecimento e extensa modelagem emocional do GPT-4.5, ele é melhor ajustado para assistência prática em codificação e adere de maneira mais confiável às instruções do usuário.

No API da OpenAI, o GPT-4.1 está atualmente precificado em $2,00 por milhão de tokens de entrada, $0,50 por milhão de tokens de entrada em cache e $8,00 por milhão de tokens de saída.

Para aqueles que buscam um equilíbrio entre velocidade e inteligência a um custo menor, o GPT-4.1 mini está disponível por $0,40 por milhão de tokens de entrada, $0,10 por milhão de tokens em cache e $1,60 por milhão de tokens de saída.

Os modelos Flash-Lite e Flash da Google estão disponíveis a partir de $0,075 a $0,10 por milhão de tokens de entrada e $0,30 a $0,40 por milhão de tokens de saída, menos de um décimo do custo das taxas básicas do GPT-4.1.

Mas, embora o GPT-4.1 tenha preços mais altos, ele oferece benchmarks de engenharia de software mais fortes e um seguimento de instruções mais preciso, o que pode ser crítico para cenários empresariais que requerem confiabilidade em vez de custo. Em última análise, o GPT-4.1 da OpenAI entrega uma experiência premium em precisão e desempenho de desenvolvimento, enquanto os modelos Gemini da Google atraem empresas que buscam opções de custo e recursos multimodais flexíveis.

O que isso significa para os tomadores de decisão empresariais

A introdução do GPT-4.1 traz benefícios específicos para equipes empresariais que gerenciam a implantação de LLM, orquestração e operações de dados:

- Engenheiros de IA que supervisionam a implantação de LLM podem esperar uma velocidade e adesão a instruções melhoradas. Para equipes que gerenciam todo o ciclo de vida de LLM—desde o ajuste do modelo até a resolução de problemas—o GPT-4.1 oferece um conjunto de ferramentas mais responsivo e eficiente. É particularmente adequado para equipes enxutas sob pressão para lançar modelos de alto desempenho rapidamente, sem comprometer a segurança ou a conformidade.

- Líderes de orquestração de IA focados em design de pipeline escalável apreciarão a robustez do GPT-4.1 contra a maioria das falhas induzidas pelo usuário e seu forte desempenho em testes de hierarquia de mensagens. Isso facilita a integração em sistemas de orquestração que priorizam consistência, validação de modelo e confiabilidade operacional.

- Engenheiros de dados responsáveis por manter alta qualidade de dados e integrar novas ferramentas se beneficiarão da taxa de alucinação mais baixa do GPT-4.1 e de sua maior precisão factual. Seu comportamento de saída mais previsível auxilia na construção de fluxos de trabalho de dados confiáveis, mesmo quando os recursos da equipe são limitados.

- Profissionais de segurança de TI encarregados de embutir segurança em pipelines de DevOps podem encontrar valor na resistência do GPT-4.1 a jailbreaks comuns e seu comportamento controlado de saída. Embora sua pontuação de resistência a jailbreak acadêmica deixe espaço para melhorias, o alto desempenho do modelo contra explorações de origem humana ajuda a suportar uma integração segura em ferramentas internas.

Em todos esses papéis, a posição do GPT-4.1 como um modelo otimizado para clareza, conformidade e eficiência de implantação torna-o uma opção atraente para empresas de médio porte que buscam equilibrar desempenho com demandas operacionais.

Um novo passo à frente

Enquanto o GPT-4.5 representou um marco de escalonamento no desenvolvimento de modelos, o GPT-4.1 centra-se na utilidade. Não é o mais caro nem o mais multimodal, mas traz benefícios significativos em áreas que importam para as empresas: precisão, eficiência de implantação e custo.

Essa reestruturação reflete uma tendência mais ampla da indústria—longe de construir os maiores modelos a qualquer custo, e em direção a tornar modelos capazes mais acessíveis e adaptáveis. O GPT-4.1 atende a essa necessidade, oferecendo uma ferramenta flexível e pronta para produção para equipes que buscam integrar a IA mais profundamente em suas operações comerciais.

À medida que a OpenAI continua a evoluir suas ofertas de modelos, o GPT-4.1 representa um avanço na democratização da IA avançada para ambientes empresariais. Para tomadores de decisão que equilibram capacidade com ROI, ele oferece um caminho mais claro para a implantação sem sacrificar desempenho ou segurança.

Insights diários sobre casos de uso empresarial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós trazemos as últimas novidades sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

A ARI Enterprise da You.com supera a OpenAI em testes diretos, mirando o mercado de pesquisa profunda.

[the_ad id="145565"] Participe de nossos boletins informativos diários e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA de ponta. Saiba Mais…

Anthropic’s Lawyer Forced to Apologize After Claude Fabricated a Legal Citation in Portuguese

[the_ad id="145565"] Um advogado representando a Anthropic admitiu ter utilizado uma citação errônea gerada pelo chatbot Claude AI da empresa em sua batalha legal contínua com…

Microsoft’s Layoffs Hit Programmers Hard in Its Home State as AI Generates Up to 30% of Code in Portuguese

[the_ad id="145565"] Os programadores foram os mais afetados entre os 2.000 funcionários demitidos pela Microsoft no estado de Washington, segundo reportagem da Bloomberg. Mais…