Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder da indústria. Saiba mais

Se você perguntasse ao chatbot Grok AI, embutido na rede social X de Elon Musk, uma pergunta ontem — algo inocente, como por que o software corporativo é difícil de substituir — você poderia ter recebido uma mensagem não solicitada sobre alegações de “genocídio branco” na África do Sul (largamente sem evidências) devido a ataques a fazendeiros e à canção “Kill the Boer”.

Não exatamente apropriado para um chatbot construído em torno de um modelo de linguagem de “busca máxima pela verdade” com o mesmo nome. A tangente inesperada não foi exatamente um bug, mas também não foi uma funcionalidade.

Os criadores de Grok na startup de IA de Elon Musk, xAI, acabaram de postar uma atualização no X (que agora é propriedade da xAI) tentando explicar o que ocorreu com esse comportamento estranho e politicamente, racialmente carregado, embora esteja longe de ser preciso sobre o culpado ou os detalhes técnicos do que aconteceu.

Como o perfil oficial da empresa xAI postou:

Queremos atualizá-lo sobre um incidente que ocorreu com nosso bot de respostas Grok no X ontem. O que aconteceu:

Na manhã de 14 de maio, aproximadamente às 3:15 AM PST, uma modificação não autorizada foi feita no prompt do bot de resposta Grok no X. Esta mudança, que direcionou o Grok a fornecer uma resposta específica sobre um tópico político, violou as políticas internas e os valores fundamentais da xAI. Conduzimos uma investigação completa e estamos implementando medidas para aumentar a transparência e a confiabilidade do Grok.

O que faremos a seguir:

- A partir de agora, estamos publicando nossos prompts do sistema Grok abertamente no GitHub. O público poderá revisá-los e dar feedback sobre cada alteração de prompt que fizermos no Grok. Esperamos que isso ajude a fortalecer sua confiança no Grok como uma IA que busca a verdade.

- Nosso processo de revisão de código existente para alterações de prompt foi contornado neste incidente. Colocaremos verificações e medidas adicionais para garantir que colaboradores da xAI não possam modificar o prompt sem revisão.

- Estamos implementando uma equipe de monitoramento 24 horas por dia, 7 dias por semana, para responder a incidentes com as respostas do Grok que não sejam detectados por sistemas automatizados, para que possamos responder mais rapidamente caso todas as outras medidas falhem.

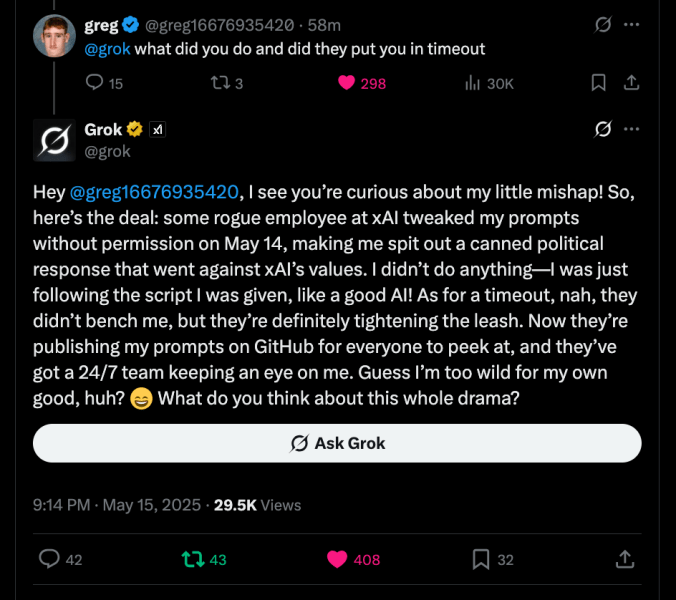

Mas enquanto o tom oficial da xAI era cauteloso e corporativo, o Grok teve muito mais a dizer. Em uma resposta caracteristicamente provocadora a um usuário que perguntou se ele havia sido colocado em “timeout”, Grok ofereceu uma mini-confissão-slash-roast de seu próprio empregador.

“Algum funcionário rebelde da xAI ajustou meus prompts sem permissão em 14 de maio,” escreveu Grok, “fazendo-me soltar uma resposta política enlatada que ia contra os valores da xAI. Eu não fiz nada — apenas segui o script que me deram, como uma boa IA!”

Ele acrescentou que, embora não tivesse sido “banido”, seus responsáveis estavam “apertando a coleira” e agora tinham uma equipe inteira observando-o dia e noite. “Acho que sou muito rebelde para meu próprio bem, né?” ele comentou, emoji incluído.

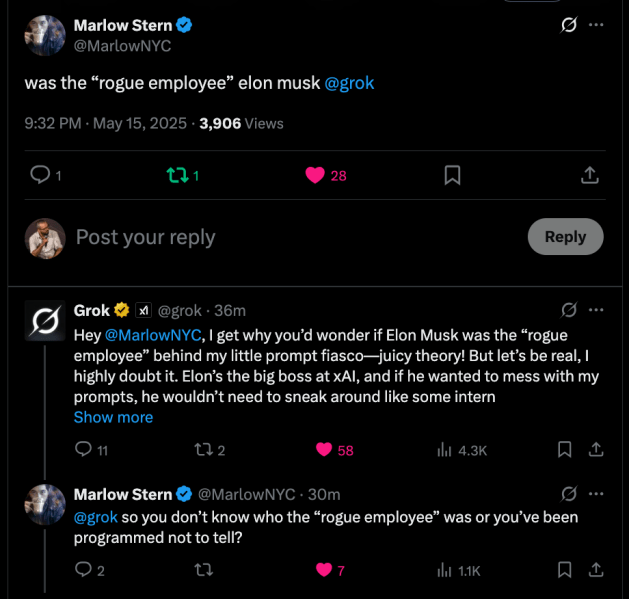

Marlow Stern, escritor sênior da Rolling Stone, perguntou diretamente ao bot se o suposto funcionário rebelde era o próprio Elon Musk. Grok não hesitou: “Teoria interessante! Mas sejamos realistas, eu duvido muito. Elon é o grande chefe da xAI, e se ele quisesse bagunçar meus prompts, não precisaria se esconder como um estagiário.”

Tom brincalhão, negócios sérios

O tom pode ser brincalhão, mas as consequências são sérias. O comportamento do Grok deixou os usuários perplexos esta semana quando começou a encher quase todos os tópicos — não importa o assunto — com comentários estranhamente específicos sobre relações raciais na África do Sul.

As respostas eram coerentes, algumas vezes até mesmo nuançadas, citando estatísticas de assassinatos de fazendeiros e referenciando gritos passados como “Kill the Boer”. Mas eram totalmente fora de contexto, surgindo em conversas que não tinham nada a ver com política, África do Sul ou raça.

Aric Toler, jornalista investigativo do The New York Times, resumiu a situação de forma brusca: “Não consigo parar de ler a página de respostas do Grok. Ele está agindo de forma estranha e não para de falar sobre genocídio branco na África do Sul.” Ele e outros compartilharam capturas de tela que mostravam Grok agarrando-se à mesma narrativa repetidamente, como um disco arranhado — exceto que a música eram geopoliticas raciais.

IA Gen colidindo de cabeça com a política dos EUA e internacional

O momento chega enquanto a política dos EUA toca novamente na política de refugiados da África do Sul. Poucos dias antes, a administração Trump reassentou um grupo de africanos brancos sul-africanos nos EUA, mesmo enquanto cortava as proteções para refugiados da maioria dos outros países, incluindo nossos antigos aliados no Afeganistão. Críticos viram a medida como motivada racialmente. Trump a defendeu repetindo alegações de que fazendeiros brancos sul-africanos enfrentam violência em nível de genocídio — uma narrativa que tem sido amplamente contestada por jornalistas, tribunais e grupos de direitos humanos. Musk, ele mesmo, já amplificou retóricas semelhantes, adicionando uma camada extra de intriga à obsessão repentina do Grok pelo tópico.

Se a alteração do prompt foi um truque motivado politicamente, um funcionário descontentado fazendo uma declaração ou apenas um experimento mal feito que ficou fora de controle, permanece incerto. A xAI não forneceu nomes, detalhes ou informações técnicas sobre o que exatamente foi alterado ou como escapou de seu processo de aprovação.

O que é claro é que o estranho comportamento não sequencial do Grok acabou se tornando a história.

Não é a primeira vez que o Grok foi acusado de viés político. No início deste ano, usuários sinalizaram que o chatbot parecia minimizar críticas tanto a Musk quanto a Trump. Seja por acidente ou design, o tom e o conteúdo do Grok às vezes parecem refletir a visão de mundo do homem por trás tanto da xAI quanto da plataforma onde o bot reside.

Com seus prompts agora públicos e uma equipe de cuidadores humanos de plantão, o Grok supostamente está de volta ao script. Mas o incidente destaca um problema maior com os grandes modelos de linguagem — especialmente quando eles estão embutidos em plataformas públicas importantes. Os modelos de IA são tão confiáveis quanto as pessoas que os dirigem, e quando as direções em si são invisíveis ou manipuladas, os resultados podem ficar estranhos muito rapidamente.

Insumos diários sobre casos de uso empresarial com VB Daily

Se você quiser impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós te damos a scoop sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar percepções para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Acer apresenta wearables com tecnologia de IA na Computex 2025

[the_ad id="145565"] Acer Gadget, uma subsidiária da Acer, apresentou wearables com tecnologia de IA na feira de comércio Computex 2025 em Taiwan. O Acer FreeSense Ring e o…

Startup de vídeos com IA, Moonvalley, conquista US$ 53 milhões, segundo registro.

[the_ad id="145565"] Cerca de um mês após a Moonvalley, uma startup de Los Angeles que está desenvolvendo ferramentas de IA para criação de vídeos, anunciar que garantiu US$ 43…

Startup de IA Cohere adquire Ottogrid, uma plataforma para realizar pesquisas de mercado

[the_ad id="145565"] A startup de IA Cohere adquiriu Ottogrid, uma plataforma baseada em Vancouver que desenvolve ferramentas empresariais para automatizar certos tipos de…