Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA líder na indústria. Saiba mais

O novo AlphaEvolve do Google demonstra o que acontece quando um agente de IA passa de uma demonstração de laboratório para o trabalho em produção, tendo uma das empresas de tecnologia mais talentosas impulsionando-o.

Construído pela DeepMind do Google, o sistema reescreve autonomamente códigos críticos e já se paga dentro do Google. Ele quebrou um recorde de 56 anos em multiplicação de matrizes (o cerne de muitas cargas de trabalho de aprendizado de máquina) e recuperou 0,7% da capacidade computacional nos data centers globais da empresa.

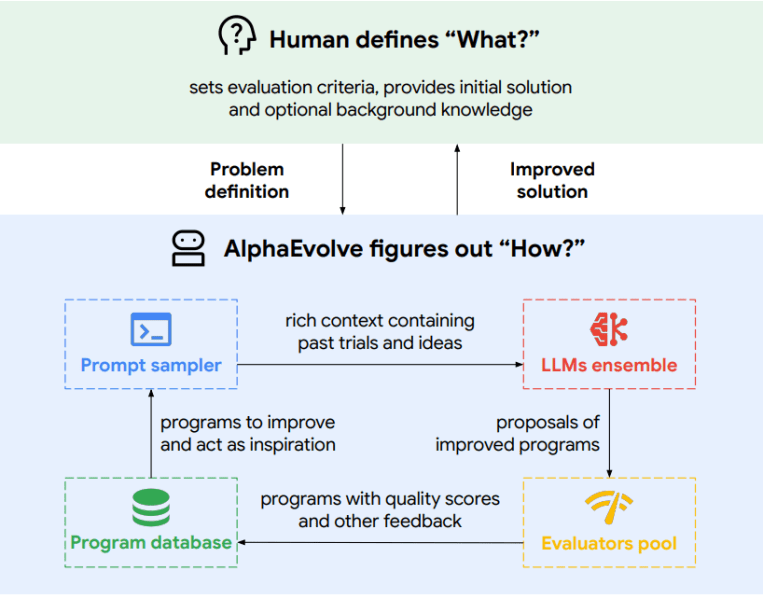

Essas conquistas são impressionantes, mas a lição mais profunda para os líderes de tecnologia empresarial é como o AlphaEvolve as realiza. Sua arquitetura – controlador, modelos de rascunho rápido, modelos de pensamento profundo, avaliadores automatizados e memória versionada – ilustra o tipo de infraestrutura de produção que torna os agentes autônomos seguros para implantação em larga escala.

A tecnologia de IA do Google é inegavelmente uma das melhores. Portanto, o desafio é descobrir como aprender com ela, ou até usá-la diretamente. O Google afirma que um Programa de Acesso Antecipado está chegando para parceiros acadêmicos e que a “disponibilidade mais ampla” está sendo explorada, mas os detalhes são escassos. Até lá, o AlphaEvolve é um modelo de melhores práticas: se você quiser agentes que lidem com cargas de trabalho de alto valor, precisará de uma orquestração, testes e guardrails comparáveis.

Considere apenas a vitória no data center. O Google não fornecerá um valor para os 0,7% recuperados, mas seu capex anual gira em torno de dezenas de bilhões de dólares. Até mesmo uma estimativa aproximada coloca as economias na casa das centenas de milhões anualmente—o suficiente, conforme constatou o desenvolvedor independente Sam Witteveen em nosso recente podcast, para pagar pelo treinamento de um dos modelos de destaque do Gemini, estimado em mais de $191 milhões para uma versão como a Gemini Ultra.

O VentureBeat foi o primeiro a relatar sobre a novidade do AlphaEvolve no início desta semana. Agora vamos nos aprofundar: como o sistema funciona, onde está realmente a barra de engenharia e os passos concretos que as empresas podem tomar para construir (ou comprar) algo comparável.

1. Além de scripts simples: O surgimento do “sistema operacional de agentes”

O AlphaEvolve funciona em algo que pode ser melhor descrito como um sistema operacional de agentes – um pipeline assíncrono e distribuído, feito para melhoria contínua em larga escala. Seus componentes principais são um controlador, um par de grandes modelos de linguagem (Gemini Flash para amplitude; Gemini Pro para profundidade), um banco de dados de memória de programa versionado e uma frota de avaliadores, todos otimizados para alta taxa de transferência em vez de apenas baixa latência.

Essa arquitetura não é conceitualmente nova, mas a execução é. “É simplesmente uma execução incrivelmente boa,” diz Witteveen.

O artigo do AlphaEvolve descreve o orquestrador como um “algoritmo evolutivo que desenvolve gradualmente programas que melhoram a pontuação nas métricas de avaliação automatizadas” (p. 3); em resumo, um “pipeline autônomo de LLMs cujo objetivo é melhorar um algoritmo fazendo alterações diretas no código” (p. 1).

Conclusão para empresas: Se os seus planos de agentes incluem execuções não supervisionadas em tarefas de alto valor, prepare-se para uma infraestrutura semelhante: filas de trabalho, um armazenamento de memória versionado, rastreamento de malha de serviço e sandbox seguro para qualquer código que o agente produzir.

2. O motor avaliador: impulsionando o progresso com feedback objetivo automatizado

Um elemento chave do AlphaEvolve é sua rigorosa estrutura de avaliação. Cada iteração proposta pelos dois LLMs é aceita ou rejeitada com base em uma função de “avaliação” fornecida pelo usuário que retorna métricas legíveis por máquina. Este sistema de avaliação começa com verificações ultrarrápidas de testes unitários em cada alteração de código proposta – testes simples e automáticos (semelhantes aos testes unitários que os desenvolvedores já escrevem) que verificam se o trecho ainda compila e produz as respostas corretas em um punhado de micro-entradas – antes de passar os sobreviventes para benchmarks mais pesados e revisões geradas por LLM. Isso ocorre em paralelo, mantendo a pesquisa rápida e segura.

Em resumo: Deixe os modelos sugerirem correções e, em seguida, verifique cada uma delas contra testes em que você confia. O AlphaEvolve também suporta otimização multi-objetivo (otimizando latência e precisão simultaneamente), evoluindo programas que atendem a várias métricas ao mesmo tempo. Contrariamente à intuição, equilibrar múltiplos objetivos pode melhorar uma única métrica de alvo ao incentivar soluções mais diversificadas.

Conclusão para empresas: Agentes de produção precisam de avaliadores determinísticos. Seja testes unitários, simuladores completos ou análises de tráfego canário. Avaliadores automatizados são tanto sua rede de segurança quanto seu motor de crescimento. Antes de lançar um projeto de agentes, pergunte: “Temos uma métrica com a qual o agente pode se autoavaliar?”

3. Uso inteligente de modelos, refinamento iterativo de código

O AlphaEvolve aborda cada problema de codificação com um ritmo de dois modelos. Primeiro, o Gemini Flash produz rascunhos rápidos, proporcionando ao sistema um amplo conjunto de ideias para explorar. Em seguida, o Gemini Pro estuda esses rascunhos em mais profundidade e retorna um conjunto menor e mais forte de candidatos. Alimentando ambos os modelos está um “construtor de prompts” leve, um script auxiliar que monta a pergunta que cada modelo vê. Ele mescla três tipos de contexto: tentativas de código anteriores salvas em um banco de dados de projetos, quaisquer regras ou guardrails que a equipe de engenharia tenha escrito e material externo relevante, como artigos de pesquisa ou notas de desenvolvedores. Com esse contexto mais rico, o Gemini Flash pode explorar amplamente enquanto o Gemini Pro se concentra na qualidade.

Ao contrário de muitas demonstrações de agentes que ajustam uma função de cada vez, o AlphaEvolve edita repositórios inteiros. Ele descreve cada alteração como um bloco de diffs padrão – o mesmo formato de patch que os engenheiros enviam para o GitHub – de modo que pode tocar dezenas de arquivos sem perder o controle. Depois, testes automatizados decidem se o patch se mantém. Ao longo de ciclos repetidos, a memória do agente de sucessos e falhas cresce, para que ele proponha melhores patches e desperdice menos computação em becos sem saída.

Conclusão para empresas: Deixe modelos mais baratos e rápidos lidarem com brainstorming, e então chame um modelo mais capaz para refinar as melhores ideias. Preserve cada tentativa em um histórico pesquisável, pois essa memória acelera o trabalho posterior e pode ser reutilizada por diferentes equipes. De acordo, os fornecedores estão correndo para fornecer aos desenvolvedores novas ferramentas em torno de coisas como memória. Produtos como OpenMemory MCP, que fornece um armazenamento de memória portátil, e as novas APIs de memória de longo e curto prazo no LlamaIndex estão tornando esse tipo de contexto persistente quase tão fácil de integrar quanto o registro de eventos.

O Codex-1 da OpenAI, um agente de engenharia de software, também lançado hoje, ressalta o mesmo padrão. Ele dispara tarefas paralelas dentro de um sandbox seguro, executa testes unitários e retorna rascunhos de solicitações de pull—efetivamente um eco específico de código do loop de busca e avaliação mais amplo do AlphaEvolve.

4. Medir para gerenciar: mirando IA agente em ROI demonstrável

As vitórias tangíveis do AlphaEvolve – recuperar 0,7% da capacidade do data center, cortar o tempo de execução do kernel de treinamento do Gemini em 23%, acelerar o FlashAttention em 32% e simplificar o design de TPU – compartilham uma característica em comum: elas visam domínios com métricas à prova d’água.

Para agendamento de data center, o AlphaEvolve evoluiu uma heurística que foi avaliada usando um simulador dos data centers do Google com base em cargas de trabalho históricas. Para otimização de kernel, o objetivo era minimizar o tempo real de execução em aceleradores TPU através de um conjunto de formas de entrada de kernel realistas.

Conclusão para empresas: Quando começar sua jornada de IA agente, procure primeiro por fluxos de trabalho onde “melhor” é um número quantificável que seu sistema pode calcular – seja latência, custo, taxa de erro ou throughput. Esse foco permite que a busca automatizada diminua os riscos de implantação, pois a saída do agente (geralmente código legível por humanos, como no caso do AlphaEvolve) pode ser integrada aos existentes sistemas de revisão e validação.

Essa clareza permite que o agente se auto melhore e demonstre valor inequívoco.

5. Preparando o terreno: pré-requisitos essenciais para o sucesso agente nas empresas

Embora as conquistas do AlphaEvolve sejam inspiradoras, o artigo do Google também deixa claro sobre seu escopo e requisitos.

A principal limitação é a necessidade de um avaliador automatizado; problemas que necessitam de experimentação manual ou feedback de “laboratório úmido” estão atualmente fora do escopo dessa abordagem específica. O sistema pode consumir computação significativa – “na ordem de 100 horas de computação para avaliar qualquer nova solução” (artigo do AlphaEvolve, página 8), necessitando de paralelização e planejamento cuidadoso de capacidade.

Antes de alocar um orçamento significativo para sistemas agentes complexos, os líderes técnicos devem fazer perguntas críticas:

- Problema legível pela máquina? Temos uma métrica clara e automatizável com a qual o agente pode avaliar seu próprio desempenho?

- Capacidade computacional? Podemos arcar com o potencialmente pesado ciclo interno de geração, avaliação e refinamento, especialmente durante a fase de desenvolvimento e treinamento?

- Prontidão do código e memória? Seu código está estruturado para modificações iterativas, possivelmente baseadas em diffs? E você pode implementar os sistemas de memória instrumentados vitais para que um agente aprenda com sua história evolutiva?

Conclusão para empresas: O foco crescente na gestão robusta de identidade e acesso de agentes, como visto em plataformas como Frontegg, Auth0 e outras, também aponta para a infraestrutura amadurecida necessária para implantar agentes que interagem de forma segura com múltiplos sistemas empresariais.

O futuro agente é engenheirado, não apenas invocado

A mensagem do AlphaEvolve para equipes empresariais é múltipla. Primeiro, seu sistema operacional em torno dos agentes agora é muito mais importante do que a inteligência do modelo. O modelo do Google mostra três pilares que não podem ser ignorados:

- Avaliadores determinísticos que fornecem ao agente uma pontuação inequívoca toda vez que uma mudança é feita.

- Orquestração de longa duração que pode gerenciar modelos de “rascunho” rápidos, como o Gemini Flash, com modelos mais lentos e rigorosos – seja o stack do Google ou uma estrutura como o LangChain’s LangGraph.

- Memória persistente para que cada iteração se baseie na anterior em vez de reaprender tudo do zero.

Empresas que já possuem logs, estruturas de teste e repositórios de código versionados estão mais perto do que pensam. O próximo passo é conectar esses ativos em um loop de avaliação autoatendido para que várias soluções geradas por agentes possam competir, e apenas o patch com a maior pontuação seja enviado.

Como disse Anurag Dhingra, SVP e GM de Conectividade e Colaboração Empresarial da Cisco, em entrevista ao VentureBeat nesta semana: “Está acontecendo, é muito, muito real,” referindo-se ao uso de agentes de IA por empresas em fabricação, armazéns e centros de contato com clientes. “Não é algo do futuro. Está acontecendo hoje.” Ele alertou que, à medida que esses agentes se tornam mais onipresentes, realizando “trabalho semelhante ao humano,” a pressão sobre os sistemas existentes será imensa: “O tráfego da rede vai disparar,” disse Dhingra. Sua rede, orçamento e vantagem competitiva provavelmente sentirão essa pressão antes que o ciclo de hype se estabilize. Comece a provar um caso de uso contido e orientado por métricas neste trimestre – depois escale o que funcionar.

Assista ao podcast em vídeo que fiz com o desenvolvedor Sam Witteveen, onde nos aprofundamos em agentes de nível de produção e como o AlphaEvolve está mostrando o caminho:

Insigths diárias sobre casos de uso comercial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo. Damos a você a cobertura completa sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para um ROI máximo.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Grok afirma estar ‘cético’ sobre o número de mortes do Holocausto e depois atribui a ‘erro de programação’

[the_ad id="145565"] Grok, o chatbot alimentado por IA criado pela xAI e amplamente utilizado em sua nova empresa irmã X, não estava apenas obcecado com genocídio branco esta…

Como os Modelos o3 e o4-mini da OpenAI Estão Revolucionando a Análise Visual e a Programação

[the_ad id="145565"] Em abril de 2025, a OpenAI apresentou seus modelos mais avançados até o momento, o3 e o4-mini. Esses modelos representam um grande avanço no campo da…

Os legisladores dos EUA expressam preocupações sobre o acordo entre Apple e Alibaba.

[the_ad id="145565"] A administração Trump e funcionários do Congresso estão investigando um acordo entre a Apple e a Alibaba que trará recursos de IA alimentados pela Alibaba…