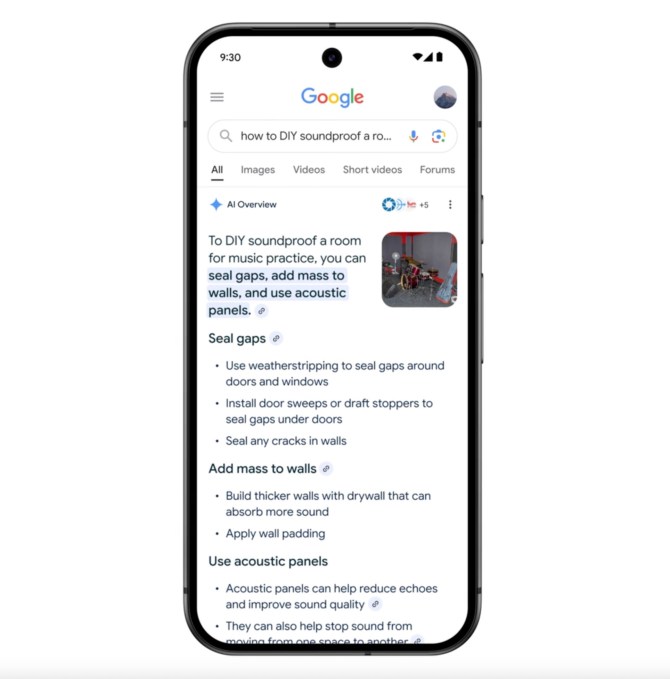

O Modo AI do Google, um recurso experimental de Pesquisa do Google que permite aos usuários fazer perguntas complexas e multifacetadas através de uma interface de IA, será disponibilizado para todos nos EUA a partir desta semana, anunciou a empresa em sua conferência anual de desenvolvedores, Google I/O 2025, na terça-feira.

O recurso se baseia na experiência de busca alimentada por IA já existente do Google, as Visões Gerais de IA, que exibem resumos gerados por IA na parte superior da página de resultados de busca. Lançadas no ano passado, as Visões Gerais de IA tiveram resultados mistos, já que a IA do Google ofereceu respostas e conselhos questionáveis, como a sugestão de usar cola na pizza, entre outras coisas.

No entanto, o Google afirma que as Visões Gerais de IA são um sucesso em termos de adoção, mesmo que não em precisão, pois mais de 1,5 bilhões de usuários mensais utilizaram o recurso de IA. Agora, sairá dos Laboratórios, se expandirá para mais de 200 países e territórios e será disponibilizado em mais de 40 idiomas, segundo a empresa.

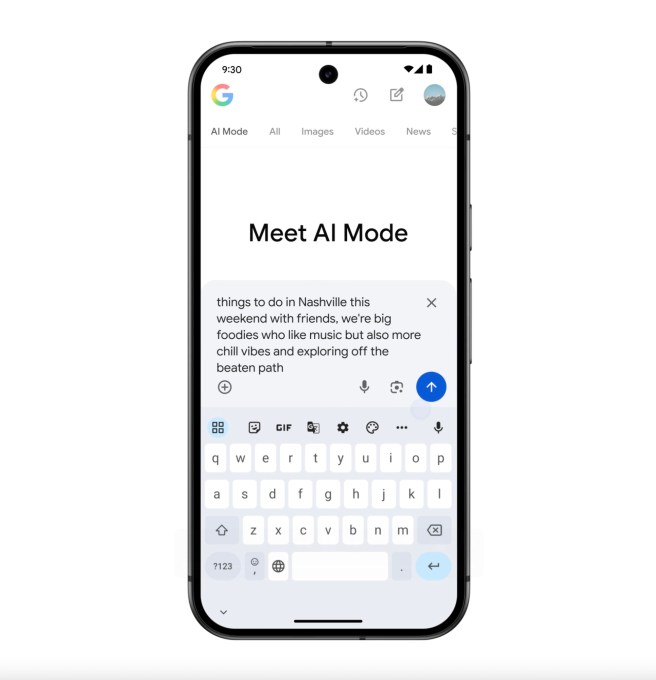

O Modo AI, por sua vez, permite que os usuários façam perguntas complexas e solicitem perguntas de acompanhamento. Inicialmente disponível nos Laboratórios de Pesquisa do Google para testes, o recurso chegou enquanto outras empresas de IA, como Perplexity e OpenAI, expandiram para o território do Google com recursos de busca na web próprios. Preocupado em ceder parte do mercado de buscas para rivais, o Modo AI representa a proposta do Google sobre como será o futuro da busca.

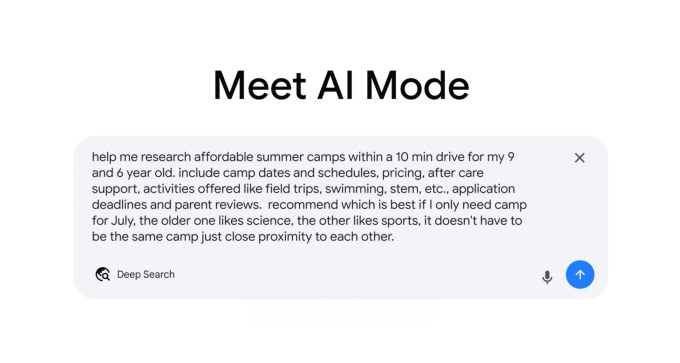

À medida que o Modo AI é lançado de forma mais ampla, o Google está destacando algumas de suas novas funcionalidades, incluindo a Busca Profunda. Enquanto o Modo AI divide uma pergunta em diferentes subtópicos para responder à sua consulta, a Busca Profunda faz isso em grande escala. Ela pode emitir dezenas ou até centenas de consultas para fornecer suas respostas, que também incluirão links para que você possa explorar a pesquisa por conta própria.

O resultado é um relatório totalmente citado gerado em minutos, potencialmente economizando horas de pesquisa, diz o Google.

A empresa sugeriu usar a funcionalidade de Busca Profunda para coisas como compras comparativas, seja para um eletrodoméstico de alto custo ou um acampamento de verão para os filhos.

Outra funcionalidade de compras alimentada por IA que está chegando ao Modo AI é uma opção virtual de “experimente” para roupas, que usa uma foto enviada de você mesmo para gerar uma imagem sua usando o item em questão. O recurso terá compreensão de formas 3D e tipos de tecidos, além de elasticidade, observa o Google, e começará a ser implementado nos Laboratórios de Pesquisa hoje.

Nos próximos meses, o Google diz que oferecerá uma ferramenta de compras para usuários dos EUA que comprará itens em seu nome após atingir um preço específico. (Você ainda terá que clicar em “comprar para mim” para iniciar esse agente, no entanto.)

Tanto as Visões Gerais de IA quanto o Modo AI agora usarão uma versão personalizada do Gemini 2.5, e o Google afirma que as capacidades do Modo AI serão gradualmente implantadas nas Visões Gerais de IA ao longo do tempo.

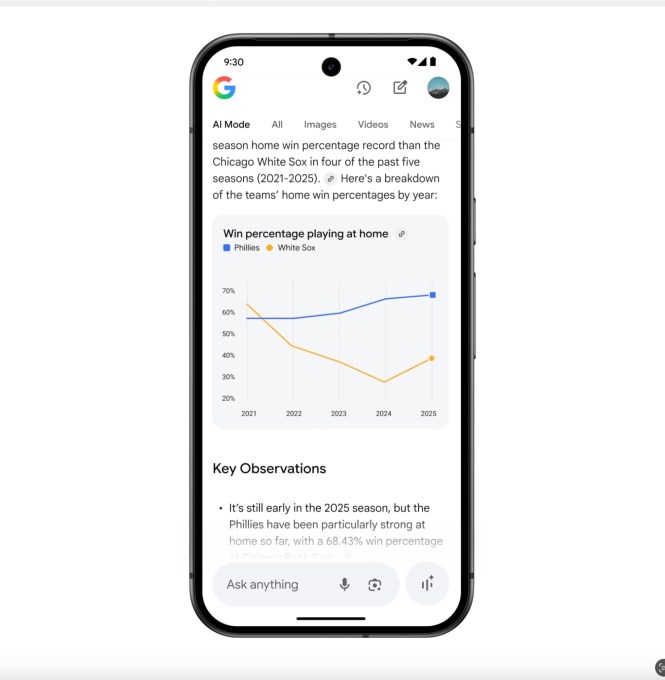

O Modo AI também suportará o uso de dados complexos em consultas sobre esportes e finanças, disponível nos Laboratórios em breve. Isso permite que os usuários façam perguntas complexas — como “compare as porcentagens de vitórias em casa dos Phillies e dos White Sox por ano nos últimos cinco anos.” A IA pesquisará em várias fontes, reunirá esses dados em uma única resposta e até criará visualizações em tempo real para ajudar você a entender melhor os dados.

Outro recurso aproveita o Project Mariner, o agente do Google que pode interagir com a web para tomar ações em seu nome. Inicialmente disponível para consultas envolvendo restaurantes, eventos e outros serviços locais, o Modo AI economizará seu tempo pesquisando preços e disponibilidade em vários sites para encontrar a melhor opção — como ingressos de concerto acessíveis, por exemplo.

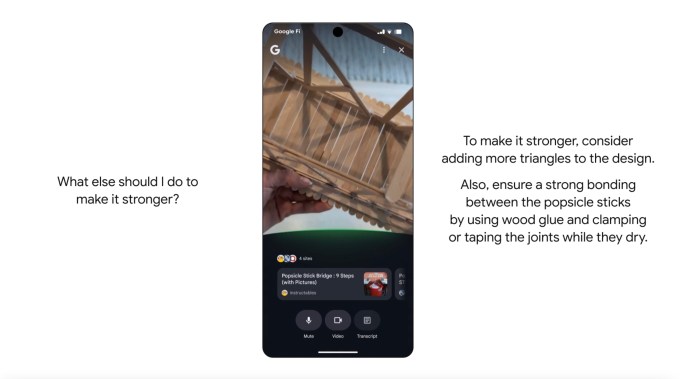

A Busca Ao Vivo, que será lançada no final do verão, permitirá que você faça perguntas com base no que a câmera do seu telefone está vendo em tempo real. Isso vai além das capacidades de busca visual do Google Lens, uma vez que você pode ter uma conversa interativa com a IA usando vídeo e áudio, semelhante ao sistema de IA multimodal do Google, o Project Astra.

Os resultados da pesquisa também serão personalizados com base em suas buscas anteriores, e se você optar por conectar seus Apps do Google usando um recurso que será implementado neste verão. Por exemplo, se você conectar seu Gmail, o Google poderá conhecer suas datas de viagem a partir de um e-mail de confirmação de reserva e, em seguida, usá-las para recomendar eventos na cidade que você estará visitando enquanto estiver lá. (Esperando alguma resistência devido a preocupações com a privacidade, o Google observa que você pode conectar ou desconectar seus aplicativos a qualquer momento.)

O Gmail é o primeiro aplicativo a ser suportado com contexto personalizado, observa a empresa.

Conteúdo relacionado

Google apresenta óculos baseados em Android XR e anuncia parceria com a Warby Parker.

[the_ad id="145565"] O Google está desafiando os óculos Meta da Ray-Ban ao anunciar novas parcerias na Google I/O 2025 com a Gentle Monster e a Warby Parker para criar óculos…

Google apresenta o Modo Comprar com IA, com rastreamento de preços, checkout autônomo e experiência de prova virtual.

[the_ad id="145565"] O Google anunciou na Google I/O 2025 que está adicionando diversos recursos impulsionados por IA para compradores online, incluindo um novo painel visual…

O Google está lançando uma integração do Gemini no Chrome.

[the_ad id="145565"] O Google anunciou na Google I/O 2025, na terça-feira, que está lançando uma integração do Gemini no Chrome. A gigante da tecnologia afirma que a nova…