Modelos de Linguagem de Grande Escala (LLMs) estão rapidamente transformando o domínio da Inteligência Artificial (IA), impulsionando inovações desde chatbots de atendimento ao cliente até ferramentas avançadas de geração de conteúdo. À medida que esses modelos aumentam em tamanho e complexidade, torna-se mais desafiador garantir que suas respostas sejam sempre precisas, justas e relevantes.

Para abordar essa questão, o Framework de Avaliação Automatizada da AWS oferece uma solução poderosa. Ele utiliza automação e métricas avançadas para fornecer avaliações escaláveis, eficientes e precisas do desempenho de LLMs. Ao simplificar o processo de avaliação, a AWS ajuda as organizações a monitorar e melhorar seus sistemas de IA em larga escala, estabelecendo um novo padrão de confiabilidade e confiança em aplicações de IA generativa.

Por que a Avaliação de LLMs é Importante

Os LLMs mostraram seu valor em muitas indústrias, realizando tarefas como responder perguntas e gerar textos semelhantes ao humano. No entanto, a complexidade desses modelos traz desafios como alucinações, viés e inconsistências em suas saídas. Alucinações ocorrem quando o modelo gera respostas que parecem factuais, mas não são precisas. O viés ocorre quando o modelo produz saídas que favorecem determinados grupos ou ideias em detrimento de outros. Esses problemas são especialmente preocupantes em campos como saúde, finanças e serviços jurídicos, onde erros ou resultados tendenciosos podem ter consequências sérias.

É essencial avaliar adequadamente os LLMs para identificar e corrigir esses problemas, garantindo que os modelos forneçam resultados confiáveis. No entanto, métodos tradicionais de avaliação, como avaliações humanas ou métricas automatizadas básicas, têm limitações. As avaliações humanas são detalhadas, mas muitas vezes são demoradas, caras e podem ser afetadas por viés individual. Por outro lado, as métricas automatizadas são mais rápidas, mas podem não capturar todos os erros sutis que podem afetar o desempenho do modelo.

Por essas razões, uma solução mais avançada e escalável é necessária para enfrentar esses desafios. O Framework de Avaliação Automatizada da AWS fornece a solução perfeita. Ele automatiza o processo de avaliação, oferecendo avaliações em tempo real das saídas dos modelos, identificando problemas como alucinações ou viés e garantindo que os modelos operem dentro de padrões éticos.

Visão Geral do Framework de Avaliação Automatizada da AWS

O Framework de Avaliação Automatizada da AWS é especificamente projetado para simplificar e acelerar a avaliação de LLMs. Ele oferece uma solução escalável, flexível e econômica para empresas que utilizam IA generativa. O framework integra diversos serviços principais da AWS, incluindo Amazon Bedrock, AWS Lambda, SageMaker e CloudWatch, para criar um pipeline de avaliação modular e de ponta a ponta. Essa configuração suporta avaliações em tempo real e por lote, tornando-a adequada para uma ampla gama de casos de uso.

Componentes e Capacidades Principais

Avaliação de Modelos Amazon Bedrock

Na base deste framework está o Amazon Bedrock, que oferece modelos pré-treinados e ferramentas de avaliação poderosas. O Bedrock permite que as empresas avaliem as saídas de LLM com base em várias métricas, como precisão, relevância e segurança, sem a necessidade de sistemas de teste personalizados. O framework suporta tanto avaliações automáticas quanto avaliações com intervenção humana, oferecendo flexibilidade para diversas aplicações empresariais.

Tecnologia LLM-as-a-Judge (LLMaaJ)

Um recurso chave do framework da AWS é o LLM-as-a-Judge (LLMaaJ), que usa LLMs avançados para avaliar as saídas de outros modelos. Ao imitar o julgamento humano, essa tecnologia reduz drasticamente o tempo e os custos de avaliação, em até 98% em comparação com métodos tradicionais, garantindo alta consistência e qualidade. O LLMaaJ avalia modelos em métricas como correção, fidelidade, experiência do usuário, conformidade com instruções e segurança. Ele se integra de maneira eficaz ao Amazon Bedrock, facilitando sua aplicação em modelos personalizados e pré-treinados.

Métricas de Avaliação Personalizáveis

Outro recurso proeminente é a capacidade do framework de implementar métricas de avaliação personalizáveis. As empresas podem adaptar o processo de avaliação às suas necessidades específicas, seja focando em segurança, imparcialidade ou precisão específica do domínio. Essa personalização garante que as empresas possam atender aos seus objetivos de desempenho e padrões regulatórios únicos.

Arquitetura e Fluxo de Trabalho

A arquitetura do framework de avaliação da AWS é modular e escalável, permitindo que as organizações o integrem facilmente em seus fluxos de trabalho de IA/ML existentes. Essa modularidade garante que cada componente do sistema possa ser ajustado de forma independente à medida que as exigências evoluem, proporcionando flexibilidade para empresas em qualquer escala.

Ingestão e Preparação de Dados

O processo de avaliação começa com a ingestão de dados, onde conjuntos de dados são reunidos, limpos e preparados para avaliação. Ferramentas da AWS como Amazon S3 são usadas para armazenamento seguro, e o AWS Glue pode ser empregado para pré-processar os dados. Os conjuntos de dados são então convertidos em formatos compatíveis (por exemplo, JSONL) para um processamento eficiente durante a fase de avaliação.

Recursos de Cálculo

O framework utiliza os serviços de computação escaláveis da AWS, incluindo Lambda (para tarefas curtas e acionadas por eventos), SageMaker (para cálculos grandes e complexos) e ECS (para cargas de trabalho conteinerizadas). Esses serviços garantem que as avaliações possam ser processadas de forma eficiente, independentemente de o trabalho ser pequeno ou grande. O sistema também utiliza processamento paralelo sempre que possível, acelerando o processo de avaliação e tornando-o adequado para avaliações de modelos em nível empresarial.

Motor de Avaliação

O motor de avaliação é um componente chave do framework. Ele testa automaticamente os modelos contra métricas pré-definidas ou personalizadas, processa os dados de avaliação e gera relatórios detalhados. Esse motor é altamente configurável, permitindo que as empresas adicionem novas métricas de avaliação ou frameworks conforme necessário.

Monitoramento e Relatório em Tempo Real

A integração com o CloudWatch garante que as avaliações sejam monitoradas continuamente em tempo real. Painéis de desempenho, juntamente com alertas automatizados, fornecem às empresas a capacidade de rastrear o desempenho do modelo e tomar medidas imediatas, se necessário. Relatórios detalhados, incluindo métricas agregadas e insights sobre respostas individuais, são gerados para apoiar análises especializadas e informar melhorias acionáveis.

Como o Framework da AWS Melhora o Desempenho de LLMs

O Framework de Avaliação Automatizada da AWS oferece vários recursos que melhoram significativamente o desempenho e a confiabilidade dos LLMs. Essas capacidades ajudam as empresas a garantir que seus modelos forneçam saídas precisas, consistentes e seguras, além de otimizar recursos e reduzir custos.

Avaliação Inteligente Automatizada

Um dos benefícios significativos do framework da AWS é sua capacidade de automatizar o processo de avaliação. Os métodos tradicionais de teste de LLM são demorados e propensos a erros humanos. A AWS automatiza esse processo, economizando tempo e dinheiro. Ao avaliar modelos em tempo real, o framework identifica imediatamente quaisquer problemas nas saídas do modelo, permitindo que os desenvolvedores ajam rapidamente. Além disso, a capacidade de realizar avaliações em vários modelos ao mesmo tempo ajuda as empresas a avaliar o desempenho sem sobrecarregar os recursos.

Categorias Abrangentes de Métricas

O framework da AWS avalia modelos usando uma variedade de métricas, garantindo uma avaliação completa do desempenho. Essas métricas cobrem mais do que apenas precisão básica e incluem:

Precisão: Verifica se as saídas do modelo correspondem aos resultados esperados.

Coerência: Avalia quão logicamente consistentes são os textos gerados.

Conformidade com Instruções: Verifica como o modelo segue as instruções dadas.

Segurança: Mede se as saídas do modelo estão livres de conteúdo prejudicial, como desinformação ou discurso de ódio.

Além disso, a AWS incorpora métricas de IA responsável para abordar questões críticas como detecção de alucinações, que identifica informações incorretas ou fabricadas, e potencial de dano, que sinaliza saídas potencialmente ofensivas ou prejudiciais. Essas métricas adicionais são essenciais para garantir que os modelos atendam a padrões éticos e sejam seguros para uso, especialmente em aplicações sensíveis.

Monitoramento Contínuo e Otimização

Outro recurso essencial do framework da AWS é seu suporte ao monitoramento contínuo. Isso permite que as empresas mantenham seus modelos atualizados à medida que novos dados ou tarefas surgem. O sistema permite avaliações regulares, fornecendo feedback em tempo real sobre o desempenho do modelo. Esse ciclo contínuo de feedback ajuda as empresas a resolver problemas rapidamente e garante que seus LLMs mantenham alto desempenho ao longo do tempo.

Impacto Real: Como o Framework da AWS Transforma o Desempenho de LLMs

O Framework de Avaliação Automatizada da AWS não é apenas uma ferramenta teórica; ele foi implementado com sucesso em cenários do mundo real, demonstrando sua capacidade de escalar, melhorar o desempenho do modelo e garantir padrões éticos em implementações de IA.

Escalabilidade, Eficiência e Adaptabilidade

Uma das principais forças do framework da AWS é sua capacidade de escalar eficientemente à medida que o tamanho e a complexidade dos LLMs aumentam. O framework utiliza serviços serverless da AWS, como AWS Step Functions, Lambda e Amazon Bedrock, para automatizar e escalar fluxos de trabalho de avaliação dinamicamente. Isso reduz a intervenção manual e garante que os recursos sejam utilizados de forma eficiente, tornando prático avaliar LLMs em escala de produção. Se as empresas estiverem testando um único modelo ou gerenciando vários modelos em produção, o framework é adaptável, atendendo tanto a requisitos de pequena escala quanto de nível empresarial.

Ao automatizar o processo de avaliação e utilizar componentes modulares, o framework da AWS garante uma integração perfeita em pipelines existentes de IA/ML com mínima interrupção. Essa flexibilidade ajuda as empresas a escalar suas iniciativas de IA e otimizar continuamente seus modelos, mantendo altos padrões de desempenho, qualidade e eficiência.

Qualidade e Confiança

Uma vantagem central do framework da AWS é seu foco em manter a qualidade e a confiança nas implementações de IA. Ao integrar métricas de IA responsável, como precisão, imparcialidade e segurança, o sistema garante que os modelos atendam a altos padrões éticos. A avaliação automatizada, combinada com validação humana, ajuda as empresas a monitorar seus LLMs quanto à confiabilidade, relevância e segurança. Essa abordagem abrangente à avaliação garante que os LLMs possam ser confiáveis para fornecer saídas precisas e éticas, construindo confiança entre usuários e partes interessadas.

Aplicações Reais Bem-Sucedidas

Amazon Q Business

O framework de avaliação da AWS foi aplicado ao Amazon Q Business, uma solução de Geração Aumentada de Recuperação (RAG) gerenciada. O framework suporta tanto fluxos de trabalho de avaliação leves quanto abrangentes, combinando métricas automatizadas com validação humana para otimizar continuamente a precisão e relevância do modelo. Essa abordagem melhora a tomada de decisão empresarial ao fornecer insights mais confiáveis, contribuindo para a eficiência operacional em ambientes empresariais.

Bases de Conhecimento Bedrock

Nas Bases de Conhecimento Bedrock, a AWS integrou seu framework de avaliação para avaliar e melhorar o desempenho de aplicações LLM orientadas a conhecimento. O framework permite o manuseio eficiente de consultas complexas, garantindo que os insights gerados sejam relevantes e precisos. Isso resulta em saídas de alta qualidade e assegura que a aplicação de LLMs em sistemas de gestão do conhecimento possa entregar resultados valiosos e confiáveis de forma consistente.

A Conclusão

O Framework de Avaliação Automatizada da AWS é uma ferramenta valiosa para aprimorar o desempenho, a confiabilidade e os padrões éticos dos LLMs. Ao automatizar o processo de avaliação, ele ajuda as empresas a reduzir tempo e custos enquanto garante que os modelos sejam precisos, seguros e justos. A escalabilidade e flexibilidade do framework o tornam adequado para projetos em pequena e grande escala, integrando-se efetivamente aos fluxos de trabalho de IA existentes.

Com métricas abrangentes, incluindo medidas de IA responsável, a AWS garante que os LLMs atendam a altos padrões éticos e de desempenho. Aplicações do mundo real, como Amazon Q Business e Bases de Conhecimento Bedrock, mostram seus benefícios práticos. No geral, o framework da AWS permite que as empresas otimizem e escalem seus sistemas de IA com confiança, estabelecendo um novo padrão para avaliações de IA generativa.

Conteúdo relacionado

O modelo R1 de IA atualizado da DeepSeek é mais censurado, revela teste.

[the_ad id="145565"] A mais recente versão do modelo de IA R1 da startup chinesa DeepSeek alcançou resultados impressionantes em benchmarks de codificação, matemática e…

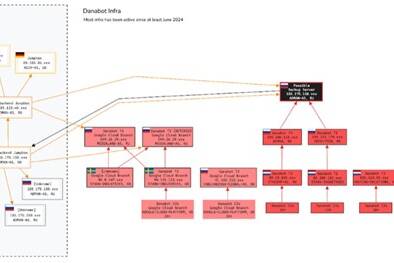

IA Agente derrota o DanaBot, revelando lições importantes para equipes de SOC.

[the_ad id="145565"] Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdos exclusivos sobre a cobertura de IA líder do setor. Saiba mais…

Peer lança a Simulação Global como uma Terra digital em tempo real com agentes de IA.

[the_ad id="145565"] Peer, a plataforma nativa de IA reinventando a internet como um universo persistente e explorável, lançou hoje sua Simulação Global—um digital Earth em…