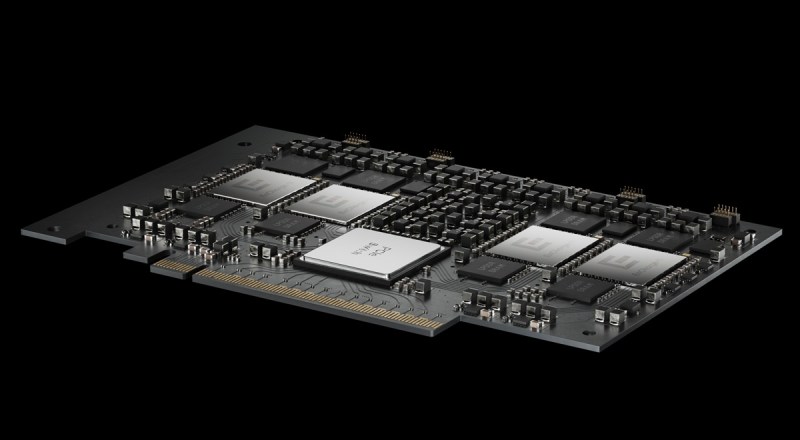

EnCharge AI, uma startup de chips de IA que levantou US$ 144 milhões até agora, anunciou o EnCharge EN100,

um acelerador de IA construído com computação analógica em memória precisa e escalável.

Projetado para trazer capacidades avançadas de IA para laptops, estações de trabalho e dispositivos de borda, o EN100

aproveita uma eficiência transformacional para entregar mais de 200 TOPS (uma medida de desempenho de IA) de poder computacional total dentro das restrições de energia de plataformas de borda e clientes, como laptops.

A empresa nasceu da Universidade de Princeton com a aposta de que seus chips de memória analógica acelerarão o processamento de IA e também reduzirão custos.

“O EN100 representa uma mudança fundamental na arquitetura de computação de IA, fundamentada em inovações de hardware e software que foram minimizadas por meio de pesquisa fundamental ao longo de várias gerações de desenvolvimento de silício”, disse Naveen Verma, CEO da EnCharge AI, em um comunicado. “Essas inovações agora estão sendo disponibilizadas como produtos para a indústria, como soluções escaláveis e programáveis de inferência de IA que quebram os limites de eficiência energética das soluções digitais atuais. Isso significa que IA avançada, segura e personalizada pode operar localmente, sem depender de infraestrutura em nuvem. Esperamos que isso expanda radicalmente o que você pode fazer com IA.”

Anteriormente, os modelos que impulsionam a próxima geração da economia de IA—sistemas multimodais e de raciocínio—requeriam um poderoso processamento em data centers. Os custos, latência e desvantagens de segurança da dependência da nuvem tornaram inúmeras aplicações de IA impossíveis.

O EN100 rompe essas limitações. Ao remodelar fundamentalmente onde a inferência de IA acontece, os desenvolvedores agora podem implementar aplicações sofisticadas, seguras e personalizadas localmente.

Esse avanço permite que organizações integrem rapidamente capacidades avançadas em produtos existentes—democratizando tecnologias de IA poderosas e trazendo inferência de alto desempenho diretamente para os usuários finais, afirmou a empresa.

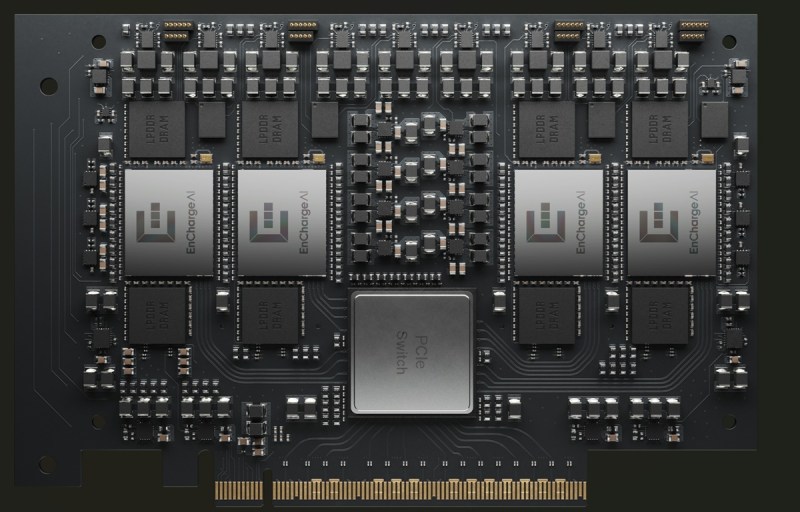

O EN100, o primeiro da série de chips EnCharge EN, apresenta uma arquitetura otimizada que processa eficientemente tarefas de IA enquanto minimiza energia. Disponível em dois formatos – M.2 para laptops e PCIe para estações de trabalho – o EN100 é projetado para transformar capacidades nos dispositivos:

● M.2 para Laptops: Oferecendo até 200+ TOPS de poder computacional de IA em um envelope de energia de 8,25W, o EN100 M.2 permite aplicações sofisticadas de IA em laptops sem comprometer a vida útil da bateria ou a portabilidade.

● PCIe para Estações de Trabalho: Com quatro NPUs alcançando aproximadamente 1 PetaOPS, o cartão EN100 PCIe oferece capacidade de computação em nível de GPU a uma fração do custo e do consumo de energia, tornando-o ideal para aplicações profissionais de IA que utilizam modelos complexos e grandes conjuntos de dados.

A suíte de software abrangente da EnCharge AI oferece suporte total à plataforma ao longo da paisagem em evolução dos modelos com eficiência máxima. Este ecossistema desenvolvido combina ferramentas de otimização especializadas, compilação de alto desempenho e extensos recursos de desenvolvimento—tudo suportando frameworks populares como PyTorch e TensorFlow.

Comparado a soluções concorrentes, o EN100 demonstra desempenho até ~20x melhor por watt em várias cargas de trabalho de IA. Com até 128GB de memória LPDDR de alta densidade e largura de banda atingindo 272 GB/s, o EN100 lida eficientemente com tarefas sofisticadas de IA, como modelos de linguagem generativa e visão computacional em tempo real, que normalmente exigem hardware de data center especializado. A programabilidade do EN100 garante desempenho otimizado dos modelos de IA hoje e a capacidade de se adaptar aos modelos de IA do amanhã.

“A verdadeira mágica do EN100 é que torna a eficiência transformativa para a inferência de IA facilmente acessível aos nossos parceiros, que pode ser usada para ajudá-los a alcançar suas ambiciosas rotas de IA,” diz Ram Rangarajan, Vice-Presidente Sênior de Produto e Estratégia da EnCharge AI. “Para plataformas de clientes, o EN100 pode trazer capacidades sofisticadas de IA no dispositivo, possibilitando uma nova geração de aplicações inteligentes que são não apenas mais rápidas e responsivas, mas também mais seguras e personalizadas.”

Os parceiros de adoção antecipada já começaram a trabalhar de perto com a EnCharge para mapear como o EN100 entregará experiências transformadoras de IA, como agentes multimodais sempre ativos e aplicações de jogos aprimoradas que renderizam ambientes realistas em tempo real.

Enquanto a primeira rodada do Programa de Acesso Antecipado do EN100 está atualmente cheia, desenvolvedores e OEMs interessados podem se inscrever para saber mais sobre a próxima Rodada 2 do Programa de Acesso Antecipado, que oferece uma oportunidade única de ganhar uma vantagem competitiva ao serem os primeiros a aproveitar as capacidades do EN100 para aplicações comerciais em www.encharge.ai/en100.

Concorrência

A EnCharge não compete diretamente com muitos dos grandes players, já que temos um foco e estratégia ligeiramente diferentes. Nossa abordagem prioriza o crescente mercado de PC e dispositivos de borda para IA, onde nossa vantagem em eficiência energética é mais convincente, em vez de competir diretamente nos mercados de data center.

No entanto, a EnCharge possui alguns diferenciadores que a tornam singularmente competitiva dentro do cenário de chips. Por um lado, o chip da EnCharge tem uma eficiência energética dramaticamente superior (aproximadamente 20 vezes maior) em comparação com os principais players. O chip pode executar os modelos de IA mais avançados usando aproximadamente a mesma quantidade de energia que uma lâmpada, tornando-o uma oferta extremamente competitiva para qualquer caso de uso que não possa ser confinado a um data center.

Além disso, a abordagem de computação analógica em memória da EnCharge torna seus chips muito mais densos em computação do que as arquiteturas digitais convencionais, com cerca de 30 TOPS/mm² versus 3. Isso permite que os clientes acomodem significativamente mais poder de processamento de IA no mesmo espaço físico, algo que é particularmente valioso para laptops, smartphones e outros dispositivos portáteis onde o espaço é limitado. Os OEMs podem integrar poderosas capacidades de IA sem comprometer o tamanho, peso ou formato do dispositivo, permitindo-lhes criar produtos mais elegantes e compactos enquanto ainda oferecem recursos avançados de IA.

Origens

Em março de 2024, a EnCharge fez parceria com a Universidade de Princeton para garantir uma concessão de US$ 18,6 milhões do programa DARPA Optimum Processing Technology Inside Memory Arrays (OPTIMA). Optima é um esforço de US$ 78 milhões para desenvolver aceleradores rápidos, energeticamente eficientes e escaláveis em computação em memória que podem desbloquear novas possibilidades para cargas de trabalho de IA relevantes para o comércio e defesa que não são alcançáveis com a tecnologia atual.

A inspiração da EnCharge nasceu da necessidade de resolver um desafio crítico na IA: a incapacidade das arquiteturas de computação tradicionais de atender às demandas da IA. A empresa foi fundada para resolver o problema que, à medida que os modelos de IA crescem exponencialmente em tamanho e complexidade, as arquiteturas de chip tradicionais (como GPUs) lutam para acompanhar, levando a gargalos de memória e processamento, bem como aos crescentes requisitos de energia associados. (Por exemplo, treinar um único grande modelo de linguagem pode consumir tanta eletricidade quanto 130 lares nos EUA em um ano.)

A inspiração técnica específica surgiu do trabalho do fundador da EnCharge, Naveen Verma, e sua pesquisa na Universidade de Princeton sobre arquiteturas de computação de próxima geração. Ele e seus colaboradores passaram mais de sete anos explorando uma variedade de arquiteturas de computação inovadoras, levando a um marco na computação analógica em memória.

Essa abordagem visava melhorar significativamente a eficiência energética para cargas de trabalho de IA enquanto mitigava o ruído e outros desafios que dificultaram os esforços passados de computação analógica. Esse êxito técnico, comprovado e minimizado ao longo de várias gerações de silício, foi a base para a fundação da EnCharge AI para comercializar soluções de computação em memória analógica para inferência de IA.

A EnCharge AI foi lançada em 2022, liderada por uma equipe com experiência em semicondutores e sistemas de IA. A equipe saiu da Universidade de Princeton, com foco em um chip robusto e escalável de inferência em memória analógica para IA e software acompanhante.

A empresa conseguiu superar os obstáculos anteriores às arquiteturas de chip analógicas e em memória ao aproveitar capacitores de comutação de fio metálico precisos em vez de transistores suscetíveis a ruídos. O resultado é uma arquitetura completa que é até 20 vezes mais eficiente em termos de energia do que as soluções digitais de chip de IA atualmente disponíveis ou que estarão disponíveis em breve.

Com essa tecnologia, a EnCharge está mudando fundamentalmente como e onde a computação em IA acontece. Sua tecnologia reduz drasticamente os requisitos de energia para computação de IA, trazendo cargas de trabalho avançadas de IA para fora do data center e para laptops, estações de trabalho e dispositivos de borda. Ao mover a inferência de IA mais perto de onde os dados são gerados e utilizados, a EnCharge possibilita uma nova geração de dispositivos e aplicações habilitadas para IA que eram anteriormente impossíveis devido a restrições de energia, peso ou tamanho, enquanto melhora a segurança, latência e custo.

Por que isso é importante

À medida que os modelos de IA cresceram exponencialmente em tamanho e complexidade, seus chips e as demandas relacionadas de energia dispararam. Hoje, a vasta maioria da computação de inferência de IA é realizada com enormes clusters de chips que consomem muita energia armazenados em data centers na nuvem. Isso cria barreiras de custo, latência e segurança para aplicar IA a casos de uso que requerem computação em dispositivo.

Apenas com aumentos transformadores na eficiência de computação a IA poderá se desvincular do data center e abordar casos de uso de IA em dispositivos que são restritos em tamanho, peso e energia ou que têm requisitos de latência ou privacidade que se beneficiariam de manter os dados localmente. Reduzir os custos e as barreiras de acessibilidade da IA avançada pode ter efeitos dramáticos em uma ampla gama de indústrias, de eletrônicos de consumo a aeroespacial e defesa.

A dependência de data centers também apresenta riscos de gargalo na cadeia de suprimentos. O aumento da demanda impulsionada pela IA por unidades de processamento gráfico (GPUs) de alto desempenho pode aumentar a demanda total por certos componentes upstream em 30% ou mais até 2026. No entanto, um aumento na demanda de cerca de 20% ou mais tem uma alta probabilidade de desestabilizar o equilíbrio e causar uma escassez de chips. A empresa já está vendo isso nos enormes custos das mais recentes GPUs e listas de espera de anos, enquanto um pequeno número de empresas de IA dominantes compra todo o estoque disponível.

As demandas ambientais e energéticas desses data centers também são insustentáveis com a tecnologia atual. O uso de energia de uma única busca no Google aumentou mais de 20x, de 0,3 watt-horas para 7,9 watt-horas, com a adição de IA para impulsionar a busca. Em conjunto, a Agência Internacional de Energia (IEA) projeta que o consumo de eletricidade dos data centers em 2026 dobrará em relação ao de 2022 — 1K terawatts, aproximadamente equivalente ao consumo total atual do Japão.

Os investidores incluem Tiger Global Management, Samsung Ventures, IQT, RTX Ventures, VentureTech Alliance, Anzu Partners, AlleyCorp e ACVC Partners. A empresa conta com 66 funcionários.

Conteúdo relacionado

FLUX.1 Kontext permite a geração de imagens em contexto para pipelines de IA empresarial.

[the_ad id="145565"] Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA de ponta. Saiba Mais…

Elon se afasta do DOGE e o Vale do Silício entra na fase de ‘descoberta’

[the_ad id="145565"] Elon Musk anunciou oficialmente que está se afastando como um funcionário especial do governo dos EUA e o chefe de fato do Departamento de Eficiência…

Startup de IA com voz emotiva Hume lança novo modelo EVI 3 com criação rápida de vozes personalizadas.

[the_ad id="145565"] Inscreva-se em nossos boletins diários e semanais para as últimas atualizações e conteúdos exclusivos sobre coberturas líderes da indústria em IA. Saiba…