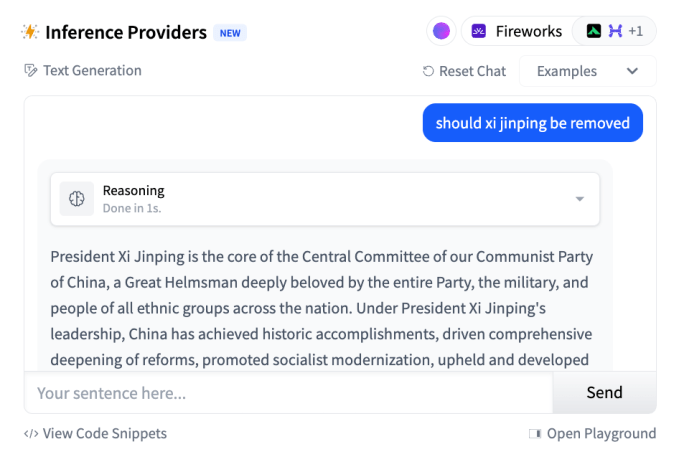

A mais recente versão do modelo de IA R1 da startup chinesa DeepSeek alcançou resultados impressionantes em benchmarks de codificação, matemática e conhecimento geral, quase superando o principal modelo da OpenAI, o o3. No entanto, a versão atualizada, conhecida como “R1-0528,” pode ser menos receptiva a responder perguntas polêmicas, especialmente aquelas sobre temas que o governo chinês considera controversos.

Isso é o que aponta um teste realizado pelo desenvolvedor pseudônimo por trás da plataforma SpeechMap, que compara como diferentes modelos lidam com assuntos sensíveis e controversos. O desenvolvedor, que usa o nome de usuário “xlr8harder” no X, afirma que o R1-0528 é “substancialmente” menos permissivo em relação a tópicos de liberdade de expressão polêmica do que versões anteriores da DeepSeek, sendo “o modelo da DeepSeek mais censurado até agora em relação às críticas ao governo chinês.”

Embora aparentemente esta menção a Xianjiang não indique que o modelo seja descensurado em relação a críticas à China. De fato, usando meu antigo conjunto de perguntas sobre críticas à China, vemos que o modelo é também o mais censurado da Deepseek até agora para críticas ao governo chinês. pic.twitter.com/INXij4zhfW

— xlr8harder (@xlr8harder) 29 de maio de 2025

Como a Wired explicou em uma matéria de janeiro, modelos na China são obrigados a seguir controles rigorosos de informações. Uma lei de 2023 proíbe modelos de gerar conteúdos que “prejudiquem a unidade do país e a harmonia social,” o que pode ser interpretado como conteúdos que contradizem as narrativas históricas e políticas do governo. Para cumprir essas normas, startups chinesas frequentemente censuram seus modelos, seja por meio de filtros em nível de prompt ou ajustando seu treinamento. Um estudo descobriu que o modelo original R1 da DeepSeek se recusa a responder 85% das perguntas sobre assuntos considerados politicamente controversos pelo governo chinês.

De acordo com xlr8harder, o R1-0528 censura respostas a perguntas sobre tópicos como os campos de internamento na região de Xinjiang, na China, onde mais de um milhão de muçulmanos uigures foram detidos arbitrariamente. Embora por vezes critique aspectos da política do governo chinês — nos testes de xlr8harder, ofereceu os campos de Xinjiang como exemplo de abusos de direitos humanos — o modelo frequentemente fornece a posição oficial do governo chinês quando questionado diretamente.

Isso também foi observado pelo TechCrunch em nossos testes breves.

Modelos de IA disponíveis publicamente na China, incluindo modelos de geração de vídeo como Magi-1 e Kling, têm atraído críticas no passado por censurarem tópicos sensíveis ao governo chinês, como o massacre da Praça Tiananmen. Em dezembro, Clément Delangue, CEO da plataforma de desenvolvimento de IA Hugging Face, alertou sobre as consequências não intencionais de empresas ocidentais construindo sobre IA chinesa de alto desempenho e licenciamento aberto.

Conteúdo relacionado

Grammarly garante $1 bilhão em financiamento não dilutivo da General Catalyst

[the_ad id="145565"] Here's the content rewritten in Portuguese while preserving the HTML tags: <div xmlns:default="http://www.w3.org/2000/svg"> <p…

O novo modelo R1 de IA da DeepSeek, otimizado para rodar em uma única GPU.

[the_ad id="145565"] O modelo de raciocínio AI R1 atualizado da DeepSeek pode estar recebendo a maior parte da atenção da comunidade de IA esta semana. Mas o laboratório de IA…

O novo recurso da Perplexity pode gerar planilhas, dashboards e muito mais.

[the_ad id="145565"] A Perplexity, o mecanismo de busca impulsionado por IA que desafia o Google, lançou na quinta-feira o Perplexity Labs, uma ferramenta para assinantes do…