Inscreva-se em nossos boletins diários e semanais para as últimas atualizações e conteúdos exclusivos sobre coberturas líderes da indústria em IA. Saiba Mais

A startup de IA baseada em Nova York, Hume, apresentou seu mais recente modelo de IA conversacional, o Empathic Voice Interface (EVI), EVI 3 (pronunciado “Evee” três, como o personagem Pokémon), visado para tudo, desde suporte ao cliente e coaching de saúde até narrativas imersivas e companhia virtual.

O EVI 3 permite que os usuários criem suas próprias vozes ao falar com o modelo (é voz-para-voz/fala-para-fala) e visa estabelecer um novo padrão de naturalidade, expressividade e “empatia”, de acordo com a Hume — ou seja, como os usuários percebem a compreensão das emoções pelo modelo e sua capacidade de ajustar suas próprias respostas, em termos de tom e escolha das palavras.

Desenvolvido para empresas, desenvolvedores e criadores, o EVI 3 amplia os modelos de voz anteriores da Hume ao oferecer personalização mais sofisticada, respostas mais rápidas e uma compreensão emocional aprimorada.

Os usuários individuais podem interagir com ele hoje através da demonstração ao vivo da Hume em seu site e no aplicativo iOS, porém, o acesso para desenvolvedores através da API proprietária da Hume deve estar disponível nas “próximas semanas”, conforme informado em um post do blog da empresa.

Nesse momento, os desenvolvedores poderão integrar o EVI 3 em seus próprios sistemas de atendimento ao cliente, projetos criativos ou assistentes virtuais — por um preço (veja abaixo).

Meu uso da demonstração me permitiu criar uma nova voz sintética personalizada em segundos, com base em qualidades que descrevi para ela — uma mistura de calor e confiança, e um tom masculino. Falar com ela foi mais natural e fácil do que com outros modelos de IA e certamente que as vozes padrão de líderes de tecnologia como Apple com Siri e Amazon com Alexa.

O que desenvolvedores e empresas devem saber sobre o EVI 3

O EVI 3 da Hume é construído para uma variedade de usos — desde atendimento ao cliente e interações em aplicativos até criação de conteúdo em audiolivros e jogos.

Ele permite que os usuários especifiquem traços de personalidade, qualidades vocais, tom emocional e tópicos de conversa.

Isso significa que pode produzir desde um guia caloroso e empático até um narrador excêntrico e travesso — até solicitações como “um rato emplumado sussurrando urgentemente com um sotaque francês sobre seu plano de roubar queijo da cozinha”.

A principal força do EVI 3 reside em sua capacidade de integrar inteligência emocional diretamente nas experiências baseadas em voz.

Diferente dos chatbots ou assistentes de voz tradicionais que dependem fortemente de interações roteirizadas ou baseadas em texto, o EVI 3 se adapta à maneira como as pessoas falam naturalmente — percebendo tom, prosódia, pausas e explosões vocais para criar conversas mais envolventes e humanizadas.

Entretanto, uma grande funcionalidade que os modelos da Hume atualmente não possuem — e que é oferecida por concorrentes de código aberto e proprietários, como ElevenLabs — é a clonagem vocal, ou a replicação rápida da voz de um usuário ou de outra pessoa, como o CEO de uma empresa.

Entretanto, a Hume indicou que adicionará tal capacidade ao seu modelo de texto-para-fala Octave, já que é mencionado como “em breve” no site da Hume, e relatórios anteriores da minha parte sobre a empresa indicam que permitirá aos usuários replicar vozes a partir de apenas cinco segundos de áudio.

A Hume afirmou que está priorizando salvaguardas e considerações éticas antes de tornar essa funcionalidade amplamente disponível. Atualmente, essa capacidade de clonagem não está disponível no EVI, com a Hume enfatizando a personalização flexível da voz.

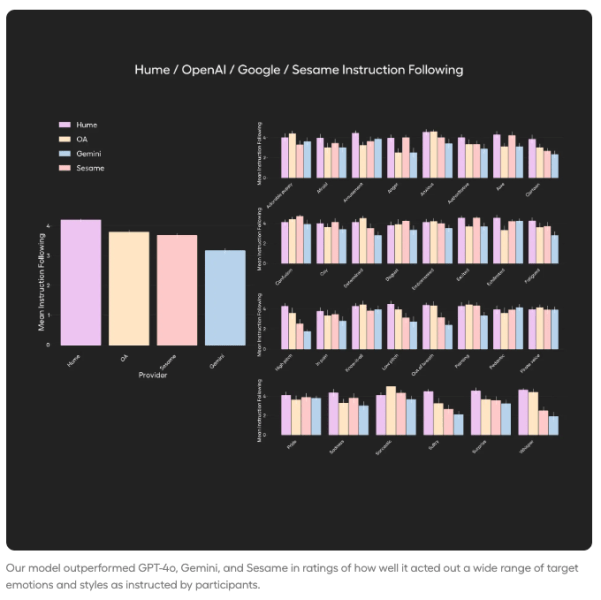

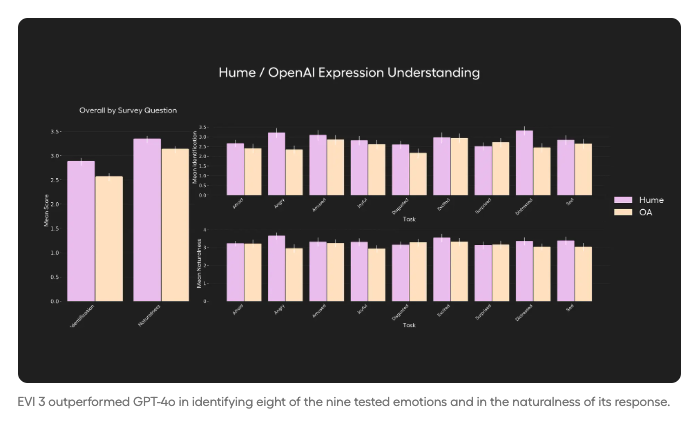

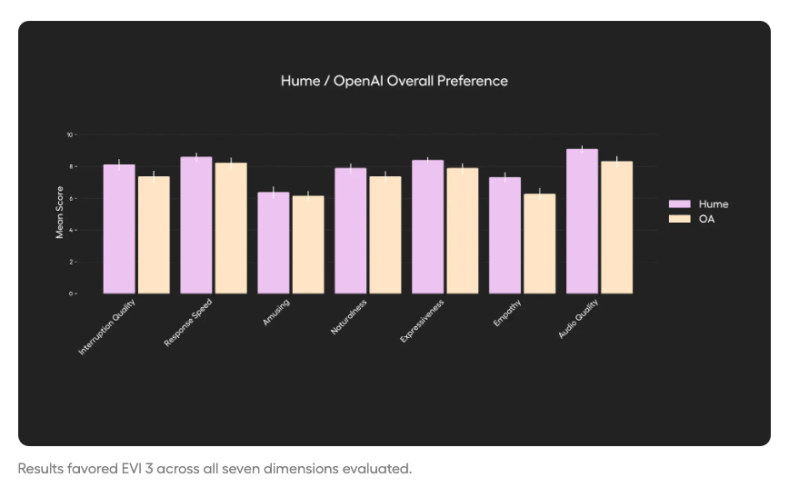

Benchmarks internos mostram que os usuários preferem o EVI 3 ao modelo de voz GPT-4o da OpenAI

De acordo com os próprios testes da Hume com 1.720 usuários, o EVI 3 foi preferido em todas as categorias avaliadas: naturalidade, expressividade, empatia, manejo de interrupções, velocidade de resposta, qualidade de áudio, modulação de emoção/estilo de voz sob demanda e compreensão emocional sob demanda (as funcionalidades “sob demanda” estão cobertas em “seguindo instruções” visto abaixo).

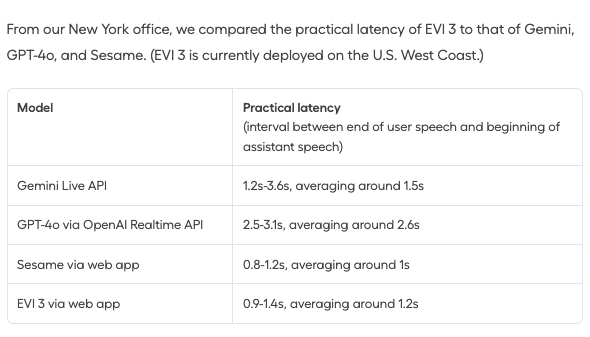

Ele também geralmente superou a família de modelos Gemini do Google e a nova empresa de modelos de IA Sesame, do ex-co-criador do Oculus, Brendan Iribe.

Ele também apresenta baixa latência (~300 milissegundos), suporte robusto a múltiplas línguas (inglês e espanhol, com mais linguagens a caminho), e efetivamente vozes customizadas ilimitadas. Como a Hume declara em seu site (veja a captura de tela logo abaixo):

As principais capacidades incluem:

- Geração de prosódia e texto-para-fala expressiva com modulação.

- Interrupções, permitindo um fluxo de conversa dinâmico.

- Personalização de voz durante a conversa, para que os usuários possam ajustar o estilo de fala em tempo real.

- Arquitetura pronta para API (em breve), para que os desenvolvedores possam integrar diretamente o EVI 3 em aplicativos e serviços.

Preços e acesso para desenvolvedores

A Hume oferece preços flexíveis baseados no uso por meio de suas APIs EVI, Octave TTS e Medição de Expressão.

Enquanto a precificação específica da API do EVI 3 ainda não foi anunciada (marcada como TBA), o padrão sugere que será baseada no uso, com descontos empresariais disponíveis para grandes implementações.

Para referência, o EVI 2 é precificado em $0,072 por minuto — 30% mais baixo que seu predecessor, EVI 1 ($0,102/minuto).

Para criadores e desenvolvedores que trabalham com projetos de texto-para-fala, os planos da Hume para o Octave TTS variam de um nível gratuito (10.000 caracteres de fala, ~10 minutos de áudio) a planos em nível empresarial. Aqui está a divisão:

- Gratuito: 10.000 caracteres, vozes personalizadas ilimitadas, $0/mês

- Iniciante: 30.000 caracteres (~30 minutos), 20 projetos, $3/mês

- Creator: 100.000 caracteres (~100 minutos), 1.000 projetos, taxa de uso por excesso ($0,20/1.000 caracteres), $10/mês

- Pro: 500.000 caracteres (~500 minutos), 3.000 projetos, $0,15/1.000 a mais, $50/mês

- Escala: 2.000.000 caracteres (~2.000 minutos), 10.000 projetos, $0,13/1.000 a mais, $150/mês

- Empresarial: Preços personalizados e uso ilimitado

Para desenvolvedores que trabalham em interações de voz em tempo real ou análise emocional, a Hume também oferece um plano Pay as You Go com $20 em créditos gratuitos e sem compromisso inicial. Clientes empresariais de alto volume podem optar por um plano empresarial dedicado com licenças de conjuntos de dados, soluções no local, integrações personalizadas e suporte avançado.

Histórico da Hume em modelos de voz de IA emotiva

Fundada em 2021 por Alan Cowen, um ex-pesquisador do Google DeepMind, a Hume visa preencher a lacuna entre a nuance emocional humana e a interação com IA.

A empresa treinou seus modelos em um extenso conjunto de dados extraído de centenas de milhares de participantes em todo o mundo — capturando não apenas fala e texto, mas também explosões vocais e expressões faciais.

“Inteligência emocional inclui a habilidade de inferir intenções e preferências a partir do comportamento. Essa é a essência do que as interfaces de IA estão tentando alcançar”, disse Cowen à VentureBeat. A missão da Hume é tornar as interfaces de IA mais responsivas, parecidas com humanos e, em última análise, mais úteis — seja ajudando um cliente a navegar em um aplicativo ou narrando uma história com a mistura certa de drama e humor.

No início de 2024, a empresa lançou o EVI 2, que ofereceu 40% menos latência e 30% de redução de preços em comparação com o EVI 1, juntamente com novos recursos, como personalização dinâmica de voz e solicitações de estilo em conversa.

Fevereiro de 2025 viu o lançamento do Octave, um motor de texto-para-fala para criadores de conteúdo capaz de ajustar emoções no nível da frase com prompts de texto.

Com o EVI 3 agora disponível para exploração prática e o acesso total à API logo à frente, a Hume espera permitir que desenvolvedores e criadores reimaginam o que é possível com a IA de voz.

Insights diários sobre casos de uso de negócios com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós trazemos as novidades sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, permitindo que você compartilhe insights para o máximo ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Meta planeja automatizar muitas de suas avaliações de risco de produtos.

[the_ad id="145565"] Um sistema impulsionado por inteligência artificial poderá em breve assumir a responsabilidade pela avaliação dos potenciais danos e riscos à privacidade…

NAACP pede às autoridades de Memphis que interrompam as operações do ‘centro de dados sujo’ da xAI

[the_ad id="145565"] A NAACP está pedindo às autoridades locais que interrompam as operações da Colossus, a instalação de "supercomputador" operada pela xAI de Elon Musk em…

ElevenLabs lança assistentes de voz de IA Conversacional 2.0 que entendem quando pausar, falar e alternar falas.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para receber as últimas atualizações e conteúdo exclusivo sobre cobertura líder da indústria em IA. Saiba…