Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre cobertura de IA líder de mercado. Saiba mais

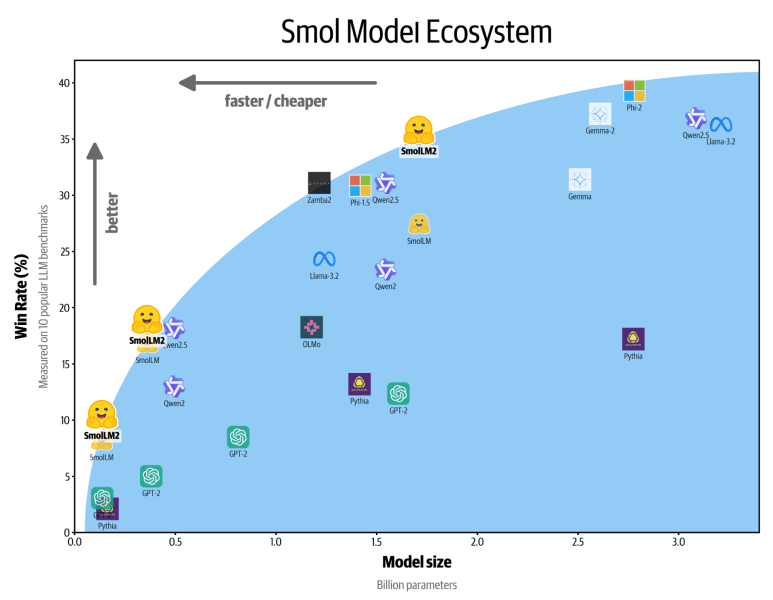

A Hugging Face lançou hoje o SmolLM2, uma nova família de modelos de linguagem compactos que alcançam um desempenho impressionante, exigindo muito menos recursos computacionais do que seus equivalentes maiores.

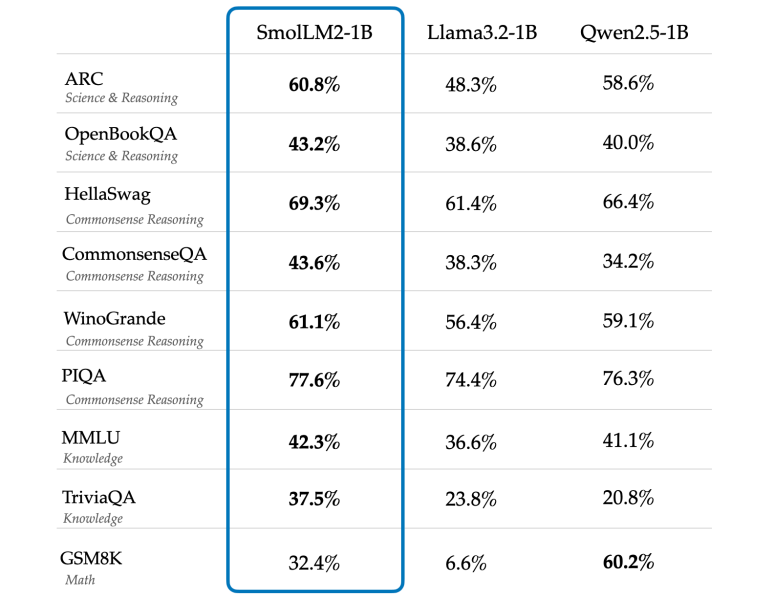

Os novos modelos, lançados sob a licença Apache 2.0, vêm em três tamanhos – 135M, 360M e 1,7B de parâmetros – tornando-os adequados para implementação em smartphones e outros dispositivos de borda, onde o poder de processamento e a memória são limitados. O mais notável, a versão de 1,7B de parâmetros supera o modelo Llama de 1B da Meta em vários benchmarks-chave.

Modelos pequenos têm um grande impacto em testes de desempenho de IA

“O SmolLM2 demonstra avanços significativos em relação ao seu predecessor, particularmente em seguir instruções, conhecimento, raciocínio e matemática,” de acordo com a documentação do modelo da Hugging Face. A variante maior foi treinada em 11 trilhões de tokens usando uma combinação diversificada de conjuntos de dados, incluindo FineWeb-Edu e conjuntos de dados especializados em matemática e programação.

Esse desenvolvimento surge em um momento crucial em que a indústria de IA enfrenta as demandas computacionais de executar grandes modelos de linguagem (LLMs). Enquanto empresas como OpenAI e Anthropic ultrapassam os limites com modelos cada vez maiores, cresce o reconhecimento da necessidade de IA eficiente e leve que possa ser executada localmente em dispositivos.

A pressão por modelos de IA maiores deixou muitos potenciais usuários para trás. Executar esses modelos requer serviços de computação em nuvem caros, que trazem seus próprios problemas: tempos de resposta lentos, riscos à privacidade de dados e custos elevados que pequenas empresas e desenvolvedores independentes simplesmente não podem arcar. O SmolLM2 oferece uma abordagem diferente, trazendo capacidades poderosas de IA diretamente para dispositivos pessoais, apontando para um futuro em que ferramentas avançadas de IA estão ao alcance de mais usuários e empresas, não apenas de gigantes da tecnologia com enormes centros de dados.

Computação de borda recebe impulso à medida que a IA se move para dispositivos móveis

O desempenho do SmolLM2 é particularmente notável dado seu tamanho. Na avaliação MT-Bench, que mede capacidades de chat, o modelo de 1,7B atinge uma pontuação de 6,13, competitiva com modelos muito maiores. Ele também apresenta um desempenho sólido em tarefas de raciocínio matemático, com uma pontuação de 48,2 no benchmark GSM8K. Esses resultados desafiam a sabedoria convencional de que modelos maiores são sempre melhores, sugerindo que um design de arquitetura cuidadoso e a curadoria de dados de treinamento podem ser mais importantes do que a simples contagem de parâmetros.

Os modelos suportam uma gama de aplicações, incluindo reescrita de texto, sumarização e chamadas de função. Seu tamanho compacto permite a implantação em cenários onde questões de privacidade, latência ou conectividade tornam impraticáveis as soluções de IA baseadas em nuvem. Isso pode ser particularmente valioso em setores como saúde, serviços financeiros e outras indústrias onde a privacidade dos dados é inegociável.

Especialistas da indústria veem isso como parte de uma tendência mais ampla em direção a modelos de IA mais eficientes. A capacidade de executar modelos avançados de linguagem localmente em dispositivos pode possibilitar novas aplicações em áreas como desenvolvimento de aplicativos móveis, dispositivos IoT e soluções empresariais, onde a privacidade dos dados é fundamental.

A corrida por uma IA eficiente: Modelos menores desafiam os gigantes da indústria

No entanto, esses modelos menores ainda têm limitações. De acordo com a documentação da Hugging Face, eles “entendem e geram conteúdo principalmente em inglês” e podem não produzir sempre resultados factualmente precisos ou logicamente consistentes.

O lançamento do SmolLM2 sugere que o futuro da IA pode não pertencer apenas a modelos cada vez maiores, mas sim a arquiteturas mais eficientes que podem oferecer um desempenho robusto com menos recursos. Isso pode ter implicações significativas para democratizar o acesso à IA e reduzir o impacto ambiental da implantação de IA.

Os modelos estão disponíveis imediatamente através do hub de modelos da Hugging Face, com versões base e ajustadas por instruções disponíveis para cada variante de tamanho.

VB Diário

Mantenha-se informado! Receba as últimas notícias em sua caixa de entrada diariamente

Ao se inscrever, você concorda com os Termos de Serviço do VentureBeat.

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

A Intel e a TSMC estão supostamente lançando uma joint venture de fabricação de chips.

[the_ad id="145565"] Gigantes do semicondutor, Intel e TSMC, estão supostamente se unindo. As duas empresas teriam alcançado um acordo preliminar para criar uma joint venture…

A OpenAI acaba de fazer seu primeiro investimento em cibersegurança

[the_ad id="145565"] A IA generativa expandiu significativamente as ferramentas disponíveis para hackers e outros atores maliciosos. Agora, é possível fazer de tudo, desde…

O novo recurso do Amazon Kindle utiliza inteligência artificial para gerar resumos de livros em uma série

[the_ad id="145565"] A Amazon está lançando uma nova funcionalidade de “Recaps” para usuários do Kindle, ajudando-os a recordar os pontos principais da trama e os arcos dos…