Participe das nossas newsletters diárias e semanais para atualizações e conteúdo exclusivo sobre abrangência em IA de ponta. Saiba Mais

DeepSeek, uma ramificação de IA do fundo de hedge quantitativo chinês High-Flyer Capital Management focada em lançar tecnologias de código aberto de alto desempenho, apresentou o R1-Lite-Preview, seu modelo de linguagem grande (LLM) mais recente com foco em raciocínio, disponível por enquanto exclusivamente através do DeepSeek Chat, seu chatbot de IA baseado na web.

Conhecido por suas contribuições inovadoras ao ecossistema de IA de código aberto, o novo lançamento da DeepSeek visa trazer capacidades de raciocínio avançado ao público, mantendo seu compromisso com uma IA acessível e transparente.

Apesar de estar disponível apenas por meio do aplicativo de chat por enquanto, o R1-Lite-Preview já está chamando a atenção ao oferecer desempenho próximo e, em alguns casos, superior ao modelo o1-preview aclamado da OpenAI.

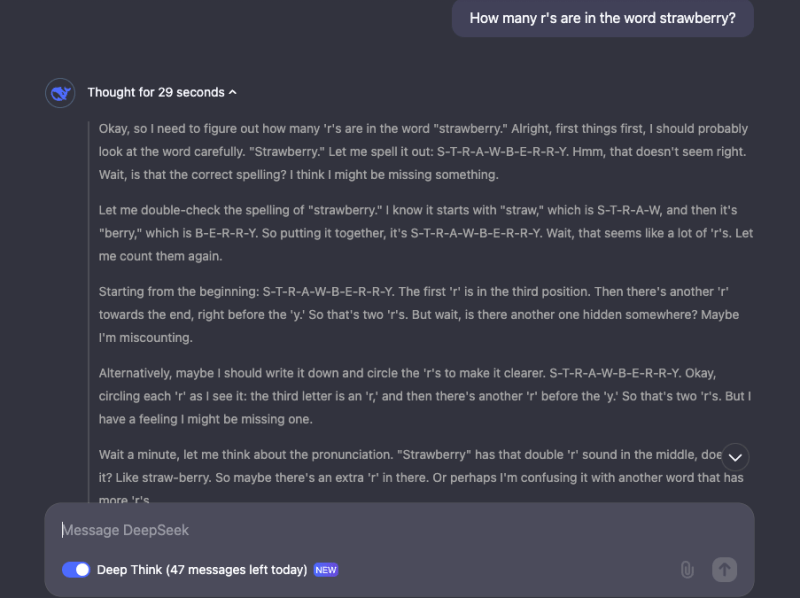

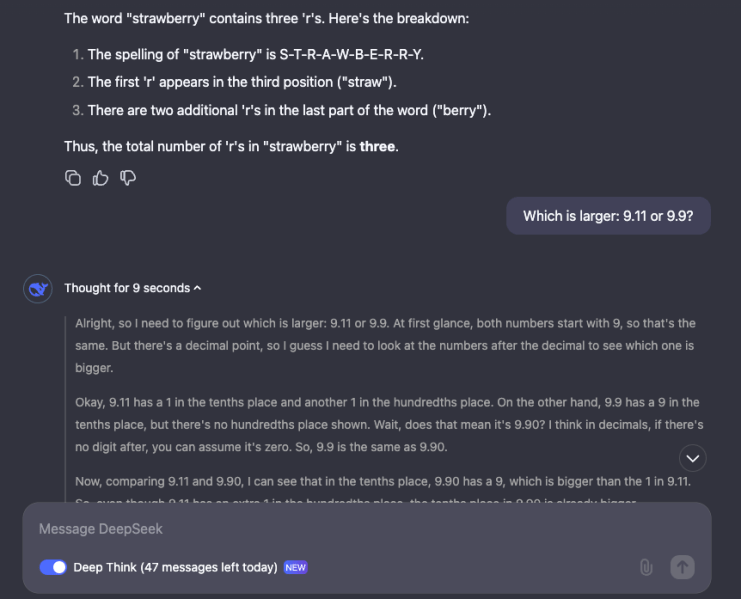

Semelhante ao modelo lançado em setembro de 2024, o DeepSeek-R1-Lite-Preview demonstra raciocínio “em cadeia”, mostrando ao usuário as diferentes cadeias ou trilhas de “pensamento” que percorre para responder a suas perguntas e entradas, documentando o processo ao explicar o que está fazendo e por quê.

Embora algumas das cadeias/trilhas de pensamento possam parecer sem sentido ou até mesmo errôneas para os humanos, o DeepSeek-R1-Lite-Preview, no geral, parece ser surpreendentemente preciso, até mesmo respondendo a perguntas “pegadinha” que confundiram outros modelos de IA mais antigos, porém poderosos, como o GPT-4o e a família Anthropic de Claude, incluindo “quantas letras Rs existem na palavra Morango?” e “qual é maior, 9,11 ou 9,9?” Veja as capturas de tela abaixo dos meus testes com esses prompts no DeepSeek Chat:

Uma nova abordagem para raciocínio em IA

O DeepSeek-R1-Lite-Preview foi projetado para se destacar em tarefas que requerem inferência lógica, raciocínio matemático e solução de problemas em tempo real.

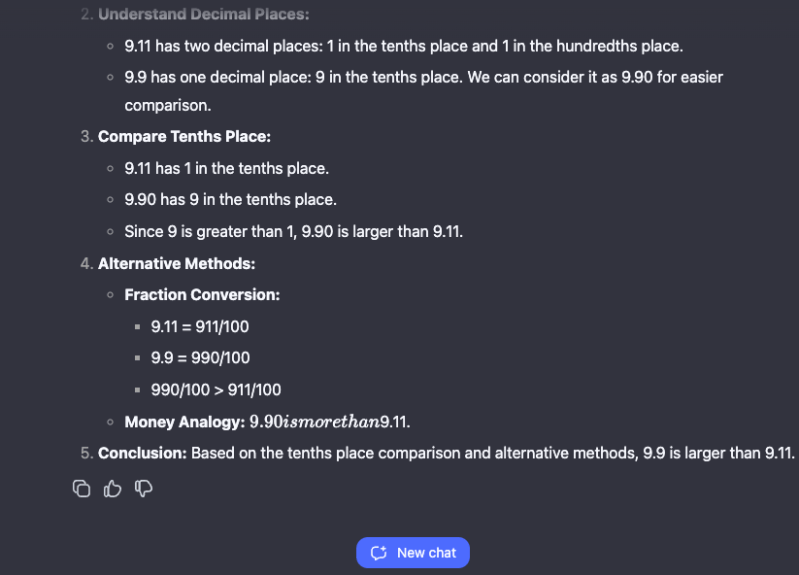

Segundo a DeepSeek, o modelo excede o desempenho ao nível do o1-preview da OpenAI em benchmarks estabelecidos como AIME (American Invitational Mathematics Examination) e MATH.

Suas capacidades de raciocínio são aprimoradas por seu processo de pensamento transparente, permitindo que os usuários acompanhem como o modelo lida com desafios complexos passo a passo.

A DeepSeek também publicou dados de escalonamento, mostrando melhorias constantes na precisão quando o modelo recebe mais tempo ou “tokens de pensamento” para resolver problemas. Gráficos de desempenho destacam sua proficiência em obter pontuações mais altas em benchmarks como AIME à medida que a profundidade do pensamento aumenta.

Benchmarks e Aplicações no Mundo Real

O DeepSeek-R1-Lite-Preview teve um desempenho competitivo em benchmarks chave.

Os resultados publicados pela empresa destacam sua capacidade de lidar com uma ampla gama de tarefas, desde matemática complexa até cenários lógicos, obtendo pontuações de desempenho que rivalizam com modelos de primeira linha em benchmarks de raciocínio como GPQA e Codeforces.

A transparência de seu processo de raciocínio o diferencia ainda mais. Os usuários podem observar os passos lógicos do modelo em tempo real, acrescentando um elemento de responsabilidade e confiança que muitos sistemas de IA proprietários carecem.

No entanto, a DeepSeek ainda não divulgou o código completo para análise ou benchmarking independentes, nem disponibilizou o DeepSeek-R1-Lite-Preview por meio de uma API que permita o mesmo tipo de testes independentes.

Além disso, a empresa ainda não publicou um post em blog ou um artigo técnico explicando como o DeepSeek-R1-Lite-Preview foi treinado ou arquitetado, deixando muitas dúvidas sobre suas origens subjacentes.

Acessibilidade e Planos de Código Aberto

O R1-Lite-Preview agora está acessível através do DeepSeek Chat em chat.deepseek.com. Embora seja gratuito para uso público, o modo avançado “Deep Think” do modelo tem um limite diário de 50 mensagens, oferecendo ampla oportunidade para os usuários experimentarem suas capacidades.

Olhando para o futuro, a DeepSeek planeja lançar versões de código aberto de seus modelos da série R1 e APIs relacionadas, de acordo com publicações da empresa no X.

Esse movimento está alinhado com a história da empresa de apoiar a comunidade de IA de código aberto.

Seu lançamento anterior, DeepSeek-V2.5, foi elogiado por combinar processamento de linguagem geral e capacidades de codificação avançadas, tornando-se um dos modelos de IA de código aberto mais poderosos na época.

Construindo sobre um Legado

A DeepSeek está continuando sua tradição de romper limites na IA de código aberto. Modelos anteriores como DeepSeek-V2.5 e DeepSeek Coder demonstraram capacidades impressionantes em tarefas de linguagem e codificação, com benchmarks colocando-o como líder no campo.

O lançamento do R1-Lite-Preview adiciona uma nova dimensão, focando em raciocínio transparente e escalabilidade.

À medida que empresas e pesquisadores exploram aplicações para IA intensiva em raciocínio, o compromisso da DeepSeek com a abertura garante que seus modelos permaneçam um recurso vital para desenvolvimento e inovação.

Combinando alto desempenho, operações transparentes e acessibilidade de código aberto, a DeepSeek não está apenas avançando a IA, mas também remodelando a forma como ela é compartilhada e utilizada.

O R1-Lite-Preview está disponível agora para testes públicos. Modelos e APIs de código aberto devem seguir, solidificando ainda mais a posição da DeepSeek como líder em tecnologias avançadas de IA acessíveis.

VB Daily

Mantenha-se informado! Receba as últimas notícias na sua caixa de entrada diariamente

Ao se inscrever, você concorda com os Termos de Serviço da VentureBeat.

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Como a Amex utiliza IA para aumentar a eficiência: 40% menos escalonamentos de TI e 85% de aumento na assistência ao viajante.

[the_ad id="145565"] Participe das nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba mais A…

O modelo o3 da OpenAI pode ser mais caro de operar do que originalmente estimado.

[the_ad id="145565"] Quando a OpenAI revelou seu modelo de IA “reasoning” o3 em dezembro, a empresa se uniu aos criadores do ARC-AGI, um benchmark projetado para testar IAs…

O ‘Modo Café’ da Zencoder é o futuro da programação: Aperte um botão e deixe a IA escrever seus testes unitários.

[the_ad id="145565"] Certainly! Below is the content rewritten in Portuguese while maintaining the original HTML structure and tags: <div> <div…