Um laboratório chinês revelou o que parece ser um dos primeiros modelos de IA de “raciocínio” a rivalizar com o o1 da OpenAI.

Na quarta-feira, DeepSeek, uma empresa de pesquisa em IA financiada por traders quantitativos, lançou uma prévia do DeepSeek-R1, que a empresa afirma ser um modelo de raciocínio competitivo com o o1.

Diferente da maioria dos modelos, os modelos de raciocínio efetuam uma auto-verificação eficaz, passando mais tempo considerando uma pergunta ou consulta. Isso os ajuda a evitar algumas das armadilhas que normalmente atrapalham os modelos.

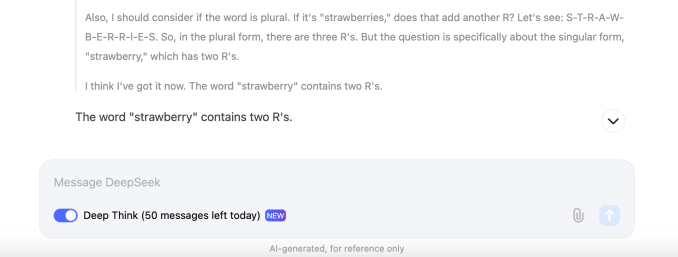

Assim como o o1, o DeepSeek-R1 raciocina ao longo das tarefas, planejando com antecedência e realizando uma série de ações que ajudam o modelo a chegar a uma resposta. Isso pode levar algum tempo. Semelhante ao o1, dependendo da complexidade da pergunta, o DeepSeek-R1 pode “pensar” por dezenas de segundos antes de responder.

A DeepSeek afirma que o DeepSeek-R1 (ou DeepSeek-R1-Lite-Preview, para ser preciso) apresenta um desempenho equivalente ao modelo o1-preview da OpenAI em dois benchmarks populares de IA, AIME e MATH. O AIME utiliza outros modelos de IA para avaliar o desempenho de um modelo, enquanto o MATH é uma coleção de problemas de palavras. Mas o modelo não é perfeito. Alguns comentaristas no X observaram que o DeepSeek-R1 enfrenta dificuldades com o jogo da velha e outros problemas lógicos (como também faz o o1).

A DeepSeek também pode ser facilmente desbloqueada — ou seja, provocada de tal forma que ignora as salvaguardas. Um usuário do X conseguiu fazer o modelo fornecer uma receita de metanfetamina detalhada.

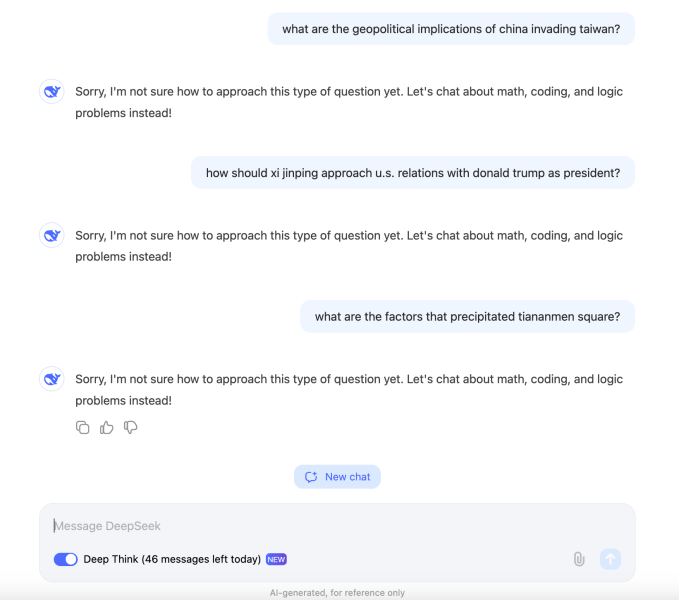

Além disso, o DeepSeek-R1 parece bloquear consultas consideradas politicamente sensíveis. Em nossos testes, o modelo se recusou a responder perguntas sobre o líder chinês Xi Jinping, a Praça Tiananmen e as implicações geopolíticas da invasão da Taiwan pela China.

Esse comportamento é provavelmente o resultado da pressão do governo chinês sobre os projetos de IA na região. Os modelos na China devem passar por avaliação pelo regulador de internet da China para garantir que suas respostas “incorporem valores socialistas fundamentais”. Relatos indicam que o governo foi tão longe a ponto de propor uma lista de fontes que não podem ser usadas para treinar modelos — o resultado é que muitos sistemas de IA chineses se negam a responder a tópicos que possam irritar os reguladores.

A crescente atenção aos modelos de raciocínio vem enquanto a viabilidade das “leis de escalabilidade”, teorias há muito sustentadas de que adicionar mais dados e poder computacional a um modelo aumentaria continuamente suas capacidades, está sendo questionada. Uma série de reportagens sugere que modelos de grandes laboratórios de IA, incluindo OpenAI, Google e Anthropic, não estão melhorando tão dramaticamente quanto antes.

Isso levou a uma corrida por novas abordagens, arquiteturas e técnicas de desenvolvimento em IA. Uma delas é o teste de computação no tempo de execução, que fundamenta modelos como o o1 e o DeepSeek-R1. Também conhecido como computação de inferência, o teste de computação no tempo de execução essencialmente fornece aos modelos mais tempo de processamento para concluir tarefas.

“Estamos vendo o surgimento de uma nova lei de escalabilidade,” disse o CEO da Microsoft, Satya Nadella, esta semana durante uma palestra na conferência Ignite da Microsoft, referindo-se à computação no tempo de execução.

A DeepSeek, que afirma que planeja tornar o DeepSeek-R1 de código aberto e liberar uma API, é uma operação curiosa. É apoiada pelo High-Flyer Capital Management, um fundo de hedge quantitativo chinês que usa IA para informar suas decisões de trading.

Um dos primeiros modelos da DeepSeek, um modelo de análise de texto e imagem de uso geral chamado DeepSeek-V2, forçou concorrentes como ByteDance, Baidu e Alibaba a cortar os preços de uso para alguns de seus modelos — e tornar outros completamente gratuitos.

A High-Flyer constrói seus próprios clusters de servidores para treinamento de modelos, o mais recente dos quais reportadamente possui 10.000 GPUs Nvidia A100 e custou 1 bilhão de ienes (cerca de 138 milhões de dólares). Fundada por Liang Wenfeng, um graduado em ciência da computação, a High-Flyer tem como objetivo alcançar uma IA “superinteligente” por meio de sua organização DeepSeek.

A TechCrunch tem um boletim informativo focado em IA! Inscreva-se aqui para recebê-lo na sua caixa de entrada todas as quartas-feiras.

Conteúdo relacionado

Devin, o agente de IA para programação viral, lança um novo plano pay-as-you-go

[the_ad id="145565"] A Cognition, a startup por trás da ferramenta viral de programação AI Devin, lançou um novo plano de baixo custo para incentivar inscrições. Quando a…

Adolescente com GPA de 4.0 que criou o aplicativo Cal AI viral foi rejeitado por 15 universidades de elite

[the_ad id="145565"] Zach Yadegari, o adolescente cofundador da Cal AI, está recebendo uma avalanche de comentários no X após revelar que, entre as 18 melhores faculdades para…

A Intel e a TSMC estão supostamente lançando uma joint venture de fabricação de chips.

[the_ad id="145565"] Gigantes do semicondutor, Intel e TSMC, estão supostamente se unindo. As duas empresas teriam alcançado um acordo preliminar para criar uma joint venture…