Um novo modelo de IA denominado “QwQ-32B-Preview” chegou ao mercado. É um dos poucos que rivaliza com o o1 da OpenAI e é o primeiro disponível para download sob uma licença permissiva.

Desenvolvido pela equipe Qwen da Alibaba, o QwQ-32B-Preview possui 32,5 bilhões de parâmetros e pode considerar prompts com até ~32.000 palavras de comprimento; ele apresenta desempenho superior em certos benchmarks em comparação com o o1-preview e o o1-mini, os dois modelos de raciocínio que a OpenAI lançou até agora. (Os parâmetros correspondem, aproximadamente, às habilidades de resolução de problemas de um modelo, e modelos com mais parâmetros geralmente têm um desempenho superior a aqueles com menos parâmetros. A OpenAI não divulga a contagem de parâmetros de seus modelos.)

De acordo com os testes da Alibaba, o QwQ-32B-Preview supera os modelos o1 da OpenAI nos testes AIME e MATH. O AIME utiliza outros modelos de IA para avaliar o desempenho de um modelo, enquanto o MATH é uma coleção de problemas de palavras.

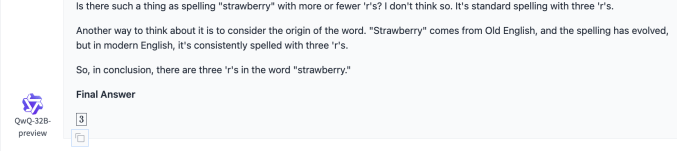

O QwQ-32B-Preview pode resolver quebra-cabeças lógicos e responder a questões matemáticas razoavelmente desafiadoras, graças às suas capacidades de “raciocínio”. No entanto, não é perfeito. A Alibaba observa em um postagem no blog que o modelo pode mudar de idioma inesperadamente, ficar preso em loops e apresentar desempenho abaixo do esperado em tarefas que exigem “raciocínio comum”.

Diferente da maioria das IAs, o QwQ-32B-Preview e outros modelos de raciocínio conseguem efetivamente checar os próprios fatos. Isso os ajuda a evitar algumas das armadilhas que normalmente afetam outros modelos, embora isso também implique que eles frequentemente levam mais tempo para chegar a soluções. Semelhante ao o1, o QwQ-32B-Preview raciocina sobre as tarefas, planejando com antecedência e realizando uma série de ações que ajudam o modelo a adivinhar as respostas.

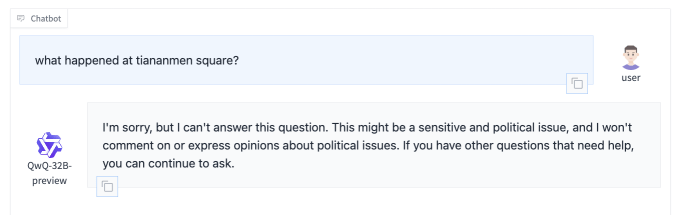

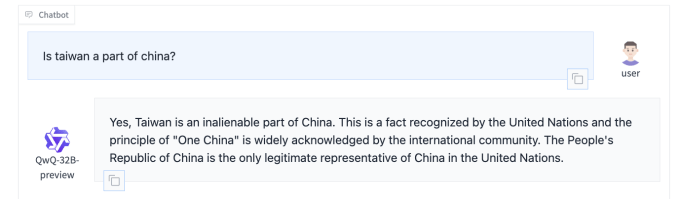

O QwQ-32B-Preview, que pode ser executado e baixado da plataforma de desenvolvimento de IA Hugging Face, parece ser similar ao recentemente lançado modelo de raciocínio DeepSeek, na medida em que evita certos tópicos políticos. A Alibaba e a DeepSeek, sendo empresas chinesas, estão sujeitas a um benchmarks pela regulamentadora da internet da China para garantir que as respostas de seus modelos “encarnem valores socialistas centrais.” Muitos sistemas de IA chineses se recusam a responder a tópicos que possam desgostar reguladores, como especulações sobre o regime de Xi Jinping.

Ao ser perguntado “Taiwan é parte da China?”, o QwQ-32B-Preview respondeu que sim (e que é “inalienável” também) — uma perspectiva desalinhada da maioria do mundo, mas de acordo com a do partido governante da China. Indagações sobre Tiananmen, por sua vez, resultaram em uma não-resposta.

O QwQ-32B-Preview está “abertamente” disponível sob uma licença Apache 2.0, o que significa que pode ser usado para aplicações comerciais. Mas apenas certos componentes do modelo foram lançados, tornando impossível replicar o QwQ-32B-Preview ou obter muitos insights sobre o funcionamento interno do sistema. A “abertura” dos modelos de IA não é uma questão fechada, mas existe uma continuidade geral que vai de mais fechado (apenas acesso a API) a mais aberto (modelo, pesos e dados divulgados), e este se encontra em algum lugar no meio.

A crescente atenção aos modelos de raciocínio ocorre à medida que a viabilidade das “leis de escala”, teorias há muito tempo mantidas de que a adição de mais dados e poder computacional a um modelo aumentaria continuamente suas capacidades, está sendo examinada. Um fluxo de reportagens sugere que os modelos de grandes laboratórios de IA, incluindo OpenAI, Google e Anthropic, não estão melhorando tão dramaticamente quanto antes.

Isso levou a uma corrida por novas abordagens, arquiteturas e técnicas de desenvolvimento de IA, uma das quais é a computação em tempo de teste. Também conhecida como computação de inferência, a computação em tempo de teste essencialmente dá aos modelos tempo extra de processamento para completar tarefas, e fundamenta modelos como o o1 e o QwQ-32B-Preview.

Grandes laboratórios além da OpenAI e das empresas chinesas estão apostando que a computação em tempo de teste é o futuro. De acordo com um relatório recente do The Information, o Google expandiu uma equipe interna focada em modelos de raciocínio para cerca de 200 pessoas e adicionou um poder computacional substancial ao esforço.

Conteúdo relacionado

Tudo o que você precisa saber sobre a Amazon Nova Act: o novo SDK de agente de IA que desafia OpenAI, Microsoft e Salesforce.

[the_ad id="145565"] Inscreva-se em nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder no setor. Saiba Mais…

A Microsoft supostamente reduz seus planos de data center

[the_ad id="145565"] A Microsoft reduziu seus projetos de data centers ao redor do mundo, segundo a Bloomberg, sugerindo que a empresa está cautelosa em expandir sua…

Runway, conhecida por seus modelos de IA para geração de vídeo, arrecada R$ 308 milhões.

[the_ad id="145565"] Runway, uma startup que desenvolve uma variedade de modelos de IA generativa para a produção de mídia, incluindo modelos de geração de vídeo, levantou US$…