A Amazon Web Services (AWS), a divisão de computação em nuvem da Amazon, está lançando uma nova ferramenta para combater as alucinações — isto é, cenários em que um modelo de IA se comporta de forma não confiável.

Anunciado na conferência re:Invent 2024 da AWS em Las Vegas, o serviço Automated Reasoning checks verifica e valida as respostas de um modelo, cruzando informações fornecidas pelos clientes para garantir a precisão. (Sim, a palavra “checks” está em letras minúsculas.) A AWS afirma em um comunicado à imprensa que o Automated Reasoning checks é o “primeiro” e “único” salvaguarda contra alucinações.

Mas isso é, bem… generoso.

O Automated Reasoning checks é quase idêntico ao recurso de Correção que a Microsoft lançou neste verão, que também sinaliza textos gerados por IA que podem estar factualmente errados. O Google também oferece uma ferramenta na Vertex AI, sua plataforma de desenvolvimento de IA, que permite que os clientes “fundamentem” modelos usando dados de provedores de terceiros, seus próprios conjuntos de dados ou Google Search.

De qualquer forma, o Automated Reasoning checks, que está disponível através do serviço de hospedagem de modelos Bedrock da AWS (especificamente a ferramenta Guardrails), tenta descobrir como um modelo chegou a uma resposta — e discernir se a resposta está correta. Os clientes fazem o upload de informações para estabelecer uma verdade fundamental, e o Automated Reasoning checks cria regras que podem ser refinadas e aplicadas a um modelo.

À medida que um modelo gera respostas, o Automated Reasoning checks as verifica e, em caso de uma provável alucinação, utiliza a verdade fundamental para encontrar a resposta correta. Ele apresenta essa resposta ao lado da provável inverdade para que os clientes vejam o quão distante o modelo pode ter estado.

A AWS afirma que a PwC já está usando o Automated Reasoning checks para projetar assistentes de IA para seus clientes. Swami Sivasubramanian, VP de IA e dados da AWS, sugeriu que esse tipo de ferramenta é exatamente o que está atraindo clientes para o Bedrock.

“Com o lançamento dessas novas capacidades”, disse ele em um comunicado, “estamos inovando em nome dos clientes para resolver alguns dos principais desafios que toda a indústria enfrenta ao mover aplicações de IA generativa para a produção.” A base de clientes do Bedrock cresceu 4,7 vezes no ano passado, atingindo dezenas de milhares de clientes, acrescentou Sivasubramanian.

Mas, como um especialista me disse neste verão, tentar eliminar alucinações da IA generativa é como tentar eliminar hidrogênio da água.

Os modelos de IA alucinam porque eles realmente não “sabem” nada. Eles são sistemas estatísticos que identificam padrões em uma série de dados e prevêm quais dados vêm a seguir com base em exemplos previamente vistos. Segue-se que as respostas de um modelo não são respostas, mas sim previsões de como as perguntas deveriam ser respondidas — dentro de uma margem de erro.

A AWS afirma que o Automated Reasoning checks utiliza raciocínio “logicamente preciso” e “verificável” para chegar a suas conclusões. Mas a empresa não apresentou dados que comprovem que a ferramenta é confiável.

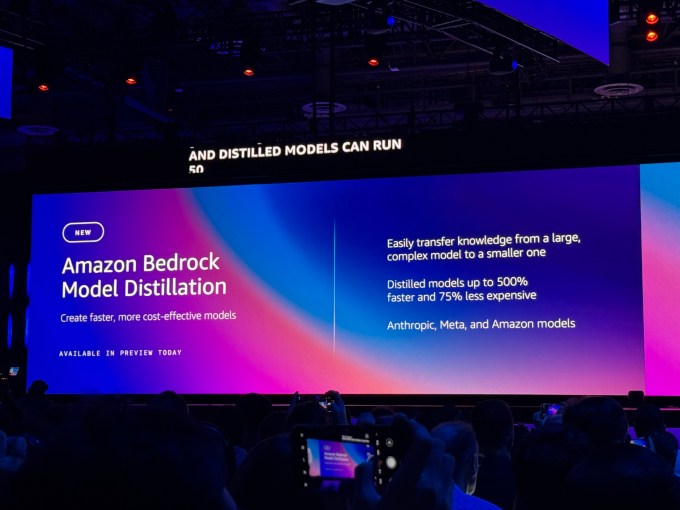

Em outras notícias do Bedrock, a AWS anunciou esta manhã o Model Distillation, uma ferramenta para transferir as capacidades de um modelo grande (por exemplo, Llama 405B) para um modelo menor (por exemplo, Llama 8B) que é mais barato e mais rápido de executar. Uma resposta ao Distillation no Azure AI Foundry, o Model Distillation oferece uma maneira de experimentar com vários modelos sem quebrar o banco, afirma a AWS.

“Depois que o cliente fornece exemplos de prompts, a Amazon Bedrock fará todo o trabalho de gerar respostas e ajustar o modelo menor,” explicou a AWS em um post no blog, “e pode até criar mais dados de exemplo, se necessário, para completar o processo de destilação.”

Mas há algumas ressalvas.

O Model Distillation só funciona com modelos hospedados no Bedrock da Anthropic e Meta, no momento. Os clientes precisam selecionar um modelo grande e pequeno da mesma “família” de modelos — os modelos não podem ser de provedores diferentes. E os modelos destilados perderão um pouco de precisão — “menos de 2%”, afirma a AWS.

Se nada disso impedir você, o Model Distillation já está disponível em prévia, juntamente com o Automated Reasoning checks.

Também está disponível em prévia a “colaboração multi-agente”, um novo recurso do Bedrock que permite aos clientes designar IA para subtarefas em um projeto maior. Parte do Bedrock Agents, a contribuição da AWS para a moda dos agentes de IA, a colaboração multi-agente oferece ferramentas para criar e ajustar IA para tarefas como revisar registros financeiros e avaliar tendências globais.

Os clientes podem até designar um “agente supervisor” para dividir e roteirizar tarefas para as IAs automaticamente. O supervisor pode “[dar] acesso a informações específicas que os agentes precisam para completar seu trabalho,” diz a AWS, e “[determinar] quais ações podem ser processadas em paralelo e quais precisam de detalhes de outras tarefas antes que um agente possa prosseguir.”

“Uma vez que todos os [AIs] especializados completem suas entradas, o agente supervisor [pode reunir] as informações e [sintetizar] os resultados,” escreveu a AWS no post.

Parece interessante. Mas, como com todas essas funcionalidades, teremos que ver como funciona quando implantado no mundo real.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…