Junte-se aos nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a liderança da indústria em cobertura de IA. Saiba mais

Hugging Face conquistou um avanço notável em inteligência artificial ao introduzir modelos de visão-linguagem que funcionam em dispositivos tão pequenos quanto smartphones, superando seus antecessores que exigiam centros de dados massivos.

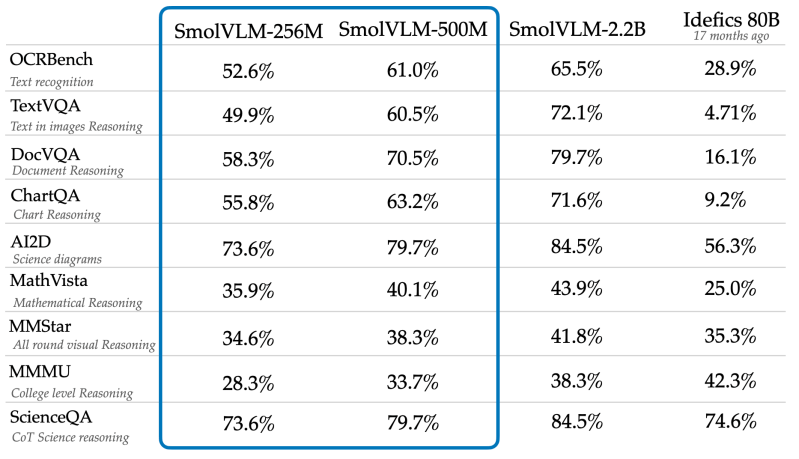

O novo modelo SmolVLM-256M da empresa, que requer menos de um gigabyte de memória GPU, supera o desempenho do seu modelo Idefics 80B de apenas 17 meses atrás — um sistema 300 vezes maior. Essa redução dramática de tamanho enquanto melhora a capacidade marca um momento decisivo para a implantação prática da IA.

“Quando lançamos o Idefics 80B em agosto de 2023, fomos a primeira empresa a abrir código de um modelo de linguagem de vídeo,” disse Andrés Marafioti, Engenheiro de Pesquisa em Aprendizado de Máquina na Hugging Face, em uma entrevista exclusiva à VentureBeat. “Ao alcançar uma redução de tamanho de 300x e ao mesmo tempo melhorar o desempenho, o SmolVLM representa um avanço nos modelos de visão-linguagem.”

Modelos de IA menores que funcionam em dispositivos do dia a dia

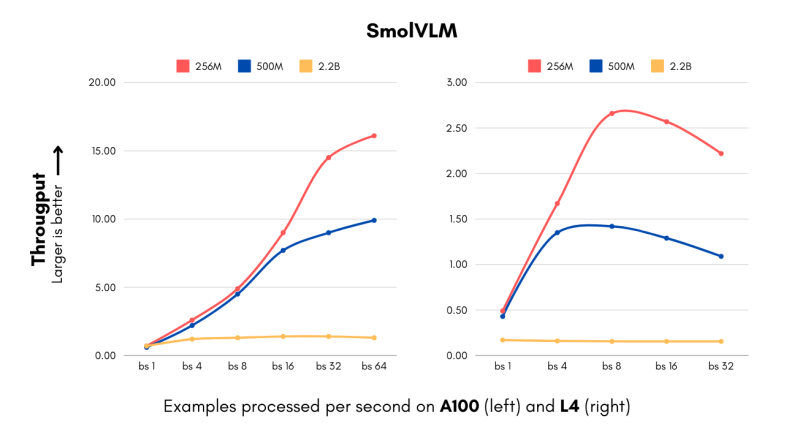

O avanço chega em um momento crucial para empresas que lutam contra os custos astronômicos de computação para implementar sistemas de IA. Os novos modelos SmolVLM — disponíveis em 256M e 500M parâmetros — processam imagens e entendem conteúdo visual a velocidades anteriormente inatingíveis para sua classe de tamanho.

A versão menor processa 16 exemplos por segundo enquanto utiliza apenas 15GB de RAM com um tamanho de lote de 64, tornando-a particularmente atraente para empresas que buscam processar grandes volumes de dados visuais. “Para uma empresa de médio porte que processa 1 milhão de imagens por mês, isso se traduz em economias anuais substanciais em custos de computação,” disse Marafioti à VentureBeat. “A redução da pegada de memória significa que as empresas podem implantar em instâncias de nuvem mais baratas, diminuindo os custos de infraestrutura.”

O desenvolvimento já chamou a atenção de grandes players da tecnologia. A IBM fez uma parceria com a Hugging Face para integrar o modelo de 256M no Docling, seu software de processamento de documentos. “Embora a IBM certamente tenha acesso a recursos de computação substanciais, usar modelos menores como esses permite que eles processem milhões de documentos por uma fração do custo,” afirmou Marafioti.

Como a Hugging Face reduziu o tamanho do modelo sem comprometer a potência

Os ganhos de eficiência vêm de inovações técnicas nos componentes de processamento de visão e linguagem. A equipe mudou de um codificador de visão de 400M parâmetros para uma versão de 93M parâmetros e implementou técnicas de compressão de token mais agressivas. Essas mudanças mantêm o alto desempenho enquanto reduzem drasticamente os requisitos computacionais.

Para startups e pequenas empresas, esses desenvolvimentos podem ser transformadores. “As startups agora podem lançar produtos de visão computacional sofisticados em semanas em vez de meses, com custos de infraestrutura que eram proibitivos há apenas alguns meses,” disse Marafioti.

O impacto vai além das economias de custos, possibilitando aplicações totalmente novas. Os modelos estão impulsionando capacidades avançadas de busca de documentos através do ColiPali, um algoritmo que cria bancos de dados pesquisáveis a partir de arquivos de documentos. “Eles obtêm desempenhos muito próximos aos de modelos 10x maiores enquanto aumentam significativamente a velocidade com a qual o banco de dados é criado e pesquisado, tornando a pesquisa visual em toda a empresa acessível para empresas de todos os tipos pela primeira vez,” de acordo com Marafioti.

Por que modelos de IA menores são o futuro do desenvolvimento de IA

O avanço desafia a sabedoria convencional sobre a relação entre tamanho do modelo e capacidade. Embora muitos pesquisadores tenham assumido que modelos maiores eram necessários para tarefas avançadas de visão-linguagem, o SmolVLM demonstra que arquiteturas menores e mais eficientes podem alcançar resultados similares. A versão de 500M parâmetros atinge 90% do desempenho de seu parente de 2.2B em benchmarks-chave.

Em vez de sugerir um platô de eficiência, Marafioti vê esses resultados como evidência de potencial não aproveitado: “Até hoje, o padrão era lançar VLMs começando em 2B parâmetros; pensávamos que modelos menores não eram úteis. Estamos provando que, de fato, modelos de 1/10 do tamanho podem ser extremamente úteis para as empresas.”

Esse desenvolvimento chega em meio a crescentes preocupações sobre o impacto ambiental da IA e os custos de computação. Ao reduzir drasticamente os recursos necessários para a IA de visão-linguagem, a inovação da Hugging Face pode ajudar a abordar ambas as questões enquanto torna capacidades avançadas de IA acessíveis a uma gama mais ampla de organizações.

Os modelos estão disponíveis como código aberto, continuando a tradição da Hugging Face de aumentar o acesso à tecnologia de IA. Essa acessibilidade, combinada com a eficiência dos modelos, poderia acelerar a adoção da IA de visão-linguagem em setores que vão desde a saúde até o varejo, onde os custos de processamento eram anteriormente proibitivos.

Em um campo onde maior sempre significou melhor, a conquista da Hugging Face sugere um novo paradigma: o futuro da IA pode não ser encontrado em modelos cada vez maiores rodando em data centers distantes, mas em sistemas ágeis e eficientes que funcionam diretamente em nossos dispositivos. Enquanto a indústria enfrenta questões de escala e sustentabilidade, esses modelos menores podem representar a maior quebra de paradigma até agora.

Insights diários sobre casos de uso empresarial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Damos a você informações privilegiadas sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para o máximo ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…