Uma equipe da plataforma de desenvolvimento de IA Hugging Face lançou o que afirmam serem os menores modelos de IA capazes de analisar imagens, vídeos curtos e textos.

Os modelos, SmolVLM-256M e SmolVLM-500M, foram projetados para funcionar bem em “dispositivos limitados” como laptops com menos de 1GB de RAM. A equipe afirma que eles também são ideais para desenvolvedores que buscam processar grandes quantidades de dados de maneira econômica.

SmolVLM-256M e SmolVLM-500M têm apenas 256 milhões e 500 milhões de parâmetros, respectivamente. (Os parâmetros correspondem, em termos gerais, às habilidades de resolução de problemas de um modelo, como seu desempenho em testes matemáticos.) Ambos os modelos podem realizar tarefas como descrever imagens ou clipes de vídeo e responder a perguntas sobre PDFs e seus elementos, incluindo texto escaneado e gráficos.

Para treinar SmolVLM-256M e SmolVLM-500M, a equipe do Hugging Face utilizou The Cauldron, uma coleção de 50 conjuntos de dados de texto e imagem de “alta qualidade”, e Docmatix, um conjunto de digitalizações de arquivos emparelhadas com legendas detalhadas. Ambos foram criados pela equipe M4 do Hugging Face, que desenvolve tecnologias de IA multimodal.

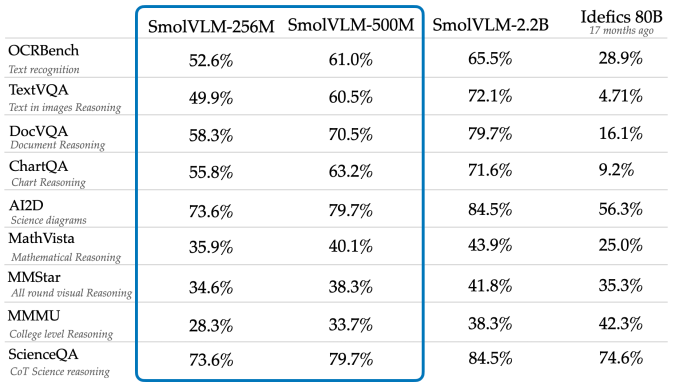

A equipe afirma que tanto o SmolVLM-256M quanto o SmolVLM-500M superam um modelo muito maior, o Idefics 80B, em benchmarks, incluindo AI2D, que avalia a capacidade dos modelos de analisar diagramas científicos em nível escolar. O SmolVLM-256M e o SmolVLM-500M estão disponíveis na web e para download no Hugging Face sob uma licença Apache 2.0, o que significa que podem ser usados sem restrições.

Modelos pequenos como SmolVLM-256M e SmolVLM-500M podem ser econômicos e versáteis, mas também podem conter falhas que não são tão pronunciadas em modelos maiores. Um estudo recente da Google DeepMind, da Microsoft Research e do instituto de pesquisa Mila em Quebec descobriu que muitos modelos pequenos se saem pior do que o esperado em tarefas complexas de raciocínio. Os pesquisadores especularam que isso pode ser devido ao fato de que modelos menores reconhecem padrões superficiais nos dados, mas têm dificuldade em aplicar esse conhecimento em novos contextos.

A TechCrunch tem um boletim informativo focado em IA! Inscreva-se aqui para recebê-lo em sua caixa de entrada toda quarta-feira.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…