Participe de nossas newsletters diárias e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA líder do setor. Saiba Mais

A divulgação do DeepSeek R1 na segunda-feira causou uma grande agitação na comunidade de IA, desafiando suposições sobre o que é necessário para alcançar um desempenho de IA de ponta. Competindo com o o1 da OpenAI a apenas 3%-5% do custo, esse modelo de código aberto não apenas cativou desenvolvedores, mas também desafiou as empresas a repensarem suas estratégias de IA.

O modelo disparou para o topo dos modelos mais baixados no HuggingFace (109.000, até o momento desta publicação) – enquanto os desenvolvedores correm para experimentá-lo e entender o que significa isso para o seu desenvolvimento em IA. Os usuários estão comentando que o recurso de busca associado ao DeepSeek (que você pode encontrar no site do DeepSeek) é agora superior a concorrentes como OpenAI e Perplexity, sendo apenas rivalizado pela Pesquisa Avançada do Google Gemini.

As implicações para as estratégias de IA empresarial são profundas: com custos reduzidos e acesso aberto, as empresas agora têm uma alternativa a modelos proprietários caros como os da OpenAI. O lançamento do DeepSeek pode democratizar o acesso a capacidades de IA de ponta, permitindo que organizações menores compitam efetivamente na corrida armamentista da IA.

Esta história foca exatamente em como o DeepSeek conseguiu esse feito e o que isso significa para o grande número de usuários de modelos de IA. Para empresas que desenvolvem soluções impulsionadas por IA, a grande novidade do DeepSeek desafia as suposições sobre a dominância da OpenAI — e oferece um modelo de inovação de custo eficiente. O “como” do que o DeepSeek fez é o que deve ser mais educativo aqui.

O avanço do DeepSeek: Mudando para o aprendizado por reforço puro

Em novembro, o DeepSeek fez manchetes com seu anúncio de que havia superado o desempenho do o1 da OpenAI, mas na época apenas oferecia um modelo de R1-lite-preview limitado. Com o lançamento completo do R1 na segunda-feira e o acompanhante documento técnico, a empresa revelou uma inovação surpreendente: uma decisão deliberada de se afastar do processo convencional de afinação supervisionada (SFT) amplamente utilizado no treinamento de grandes modelos de linguagem (LLMs).

A SFT, um passo padrão no desenvolvimento de IA, envolve treinar modelos em conjuntos de dados curados para ensinar raciocínio passo a passo, frequentemente referido como cadeia de pensamento (CoT). É considerada essencial para melhorar as capacidades de raciocínio. No entanto, o DeepSeek desafiou essa suposição ao pular totalmente a SFT, optando por se basear no aprendizado por reforço (RL) para treinar o modelo.

Essa ação ousada forçou o DeepSeek-R1 a desenvolver habilidades de raciocínio independentes, evitando a fragilidade muitas vezes introduzida por conjuntos de dados prescritivos. Embora alguns erros tenham surgido – levando a equipe a reintroduzir uma quantidade limitada de SFT durante as etapas finais de construção do modelo – os resultados confirmaram a descoberta fundamental: o aprendizado por reforço sozinho poderia impulsionar ganhos de desempenho substanciais.

A empresa avançou muito utilizando código aberto – uma maneira convencional e não surpreendente

Primeiro, um pouco de contexto sobre como o DeepSeek chegou onde chegou. O DeepSeek, uma derivada de 2023 do fundo de hedge chinês High-Flyer Quant, começou desenvolvendo modelos de IA para seu chatbot proprietário antes de liberá-los para uso público. Pouco se sabe sobre a abordagem exata da empresa, mas rapidamente tornou seus modelos de código aberto, e é extremamente provável que a empresa tenha se baseado nos projetos abertos produzidos pelo Meta, como o modelo Llama, e na biblioteca ML Pytorch.

Para treinar seus modelos, a High-Flyer Quant garantiu mais de 10.000 GPUs Nvidia antes das restrições de exportação dos EUA e supostamente expandiu para 50.000 GPUs através de rotas de suprimento alternativas, apesar das barreiras comerciais. Isso é insignificante em comparação com os principais laboratórios de IA como OpenAI, Google e Anthropic, que operam com mais de 500.000 GPUs cada.

A capacidade do DeepSeek de alcançar resultados competitivos com recursos limitados destaca como a engenhosidade e a criatividade podem desafiar o paradigma de alto custo do treinamento de LLMs de última geração.

Apesar das especulações, o orçamento total do DeepSeek é desconhecido

O DeepSeek treinou, segundo relatos, seu modelo base — chamado V3 — com um orçamento de $5,58 milhões ao longo de dois meses, de acordo com o engenheiro da Nvidia, Jim Fan. Embora a empresa não tenha revelado os dados de treinamento exatos que usou (nota lateral: críticos afirmam que isso significa que o DeepSeek não é verdadeiramente de código aberto), técnicas modernas tornam o treinamento em dados da web e abertos cada vez mais acessíveis. Estimar o custo total do treinamento do DeepSeek-R1 é desafiador. O uso de 50.000 GPUs sugere gastos significativos (potencialmente centenas de milhões de dólares), mas os números precisos continuam sendo especulativos.

O que é claro, no entanto, é que o DeepSeek tem sido muito inovador desde o início. No ano passado, surgiram relatos sobre algumas inovações iniciais que estava fazendo, em coisas como Mixture of Experts e Multi-Head Latent Attention.

Como o DeepSeek-R1 chegou ao “momento da epifania”

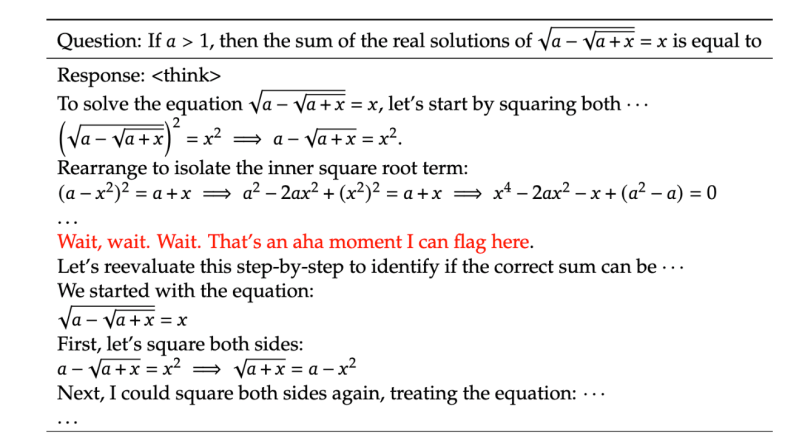

A jornada para a iteração final do DeepSeek-R1 começou com um modelo intermediário, o DeepSeek-R1-Zero, que foi treinado usando aprendizado por reforço puro. Ao depender exclusivamente do RL, o DeepSeek incentivou esse modelo a pensar de forma independente, recompensando tanto respostas corretas quanto os processos lógicos usados para chegar a elas.

Essa abordagem levou a um fenômeno inesperado: o modelo começou a alocar tempo de processamento adicional para problemas mais complexos, demonstrando a capacidade de priorizar tarefas com base em sua dificuldade. Os pesquisadores do DeepSeek descreveram isso como um “momento da epifania”, onde o próprio modelo identificou e articulou soluções novas para problemas desafiadores (veja a captura de tela abaixo). Este marco sublinhou o poder do aprendizado por reforço para desbloquear capacidades de raciocínio avançadas sem depender de métodos tradicionais de treinamento, como a SFT.

Os pesquisadores concluem: “Isso destaca o poder e a beleza do aprendizado por reforço: em vez de ensinar explicitamente o modelo como resolver um problema, simplesmente fornecemos os incentivos adequados, e ele desenvolve autonomamente estratégias avançadas de resolução de problemas.”

Mais do que RL

No entanto, é verdade que o modelo precisou mais do que apenas RL. O documento menciona que, apesar do RL criar comportamentos de raciocínio inesperados e poderosos, esse modelo intermediário DeepSeek-R1-Zero enfrentou alguns desafios, incluindo legibilidade ruim e mistura de idiomas (começando em chinês e mudando para inglês, por exemplo). Somente então a equipe decidiu criar um novo modelo, que se tornaria o modelo final DeepSeek-R1. Esse modelo, novamente baseado no modelo base V3, foi inicialmente injetado com uma quantidade limitada de SFT – focada em um “pequeno conjunto de dados longos da CoT” ou o que foi chamado de dados de inicialização a frio, para corrigir alguns dos desafios. Depois disso, passou pelo mesmo processo de aprendizado por reforço do R1-Zero. O documento, então, fala sobre como o R1 passou por algumas rodadas finais de afinação.

As ramificações

Uma questão é por que houve tanta surpresa com o lançamento. Não é como se modelos de código aberto fossem novos. Modelos de código aberto têm uma grande lógica e momentum por trás deles. Seu custo zero e maleabilidade são as razões pelas quais relatamos recentemente que esses modelos vão prevalecer nas empresas.

O modelo de pesos abertos da Meta, Llama 3, por exemplo, explodiu em popularidade no ano passado, à medida que foi afinado por desenvolvedores querendo seus próprios modelos personalizados. Da mesma forma, agora o DeepSeek-R1 já está sendo usado para destilar seu raciocínio em uma série de outros modelos muito menores – a diferença é que o DeepSeek oferece desempenho líder no setor. Isso inclui rodar versões pequenas do modelo em telefones celulares, por exemplo.

O DeepSeek-R1 não apenas apresenta desempenho superior à alternativa de código aberto líder, o Llama 3. Ele mostra toda a sua cadeia de pensamento em suas respostas de maneira transparente. O Llama do Meta não foi instruído a fazer isso como padrão; ele exige um incentivo agressivo para isso.

A transparência também proporcionou uma desvantagem de relações públicas para a OpenAI, que até agora escondeu suas cadeias de pensamento dos usuários, citando razões competitivas e para não confundir os usuários quando um modelo comete um erro. A transparência permite que os desenvolvedores identifiquem e abordem erros no raciocínio de um modelo, agilizando as personalizações para atender aos requisitos empresariais de maneira mais eficaz.

Para tomadores de decisão empresariais, o sucesso do DeepSeek sublinha uma mudança mais ampla no cenário de IA: práticas de desenvolvimento mais enxutas e eficientes estão se tornando cada vez mais viáveis. As organizações podem precisar reavaliar suas parcerias com fornecedores de IA proprietários, considerando se os altos custos associados a esses serviços são justificados quando alternativas de código aberto podem fornecer resultados comparáveis, se não superiores.

Para ter certeza, sem uma grande liderança

Embora a inovação do DeepSeek seja revolucionária, de modo algum estabeleceu uma liderança de mercado dominante. Como publicou sua pesquisa, outras empresas de modelos aprenderão com isso e se adaptarão. Meta e Mistral, a empresa francesa de modelos de código aberto, podem estar um passo atrás, mas provavelmente não levará mais do que alguns meses até que eles atinjam a mesma linha. Como colocou o principal pesquisador do Meta, Yann LeCun, “A ideia é que todos se beneficiem das ideias uns dos outros. Ninguém ‘ultrapassa’ ninguém e nenhum país ‘perde’ para outro. Ninguém tem um monopólio sobre boas ideias. Todos estão aprendendo uns com os outros.” Portanto, é a execução que importa.

Em última análise, são os consumidores, startups e outros usuários que ganharão mais, porque as ofertas do DeepSeek continuarão a reduzir o custo de uso desses modelos quase a zero (novamente, além do custo de execução dos modelos na inferência). Essa rápida commoditização pode representar desafios – de fato, uma dor maciça – para os principais fornecedores de IA que investiram pesadamente em infraestrutura proprietária. Como muitos comentadores disseram, incluindo Chamath Palihapitiya, um investidor e ex-executivo do Meta, isso poderia significar que anos de OpEx e CapEx da OpenAI e outros serão desperdiçados.

Há uma discussão substancial sobre se é ético usar o modelo DeepSeek-R1 devido aos preconceitos instilados nele por leis chinesas, por exemplo, que proíbem que ele responda a perguntas sobre a violenta repressão do governo chinês na Praça da Paz Celestial. Apesar das preocupações éticas em torno dos preconceitos, muitos desenvolvedores veem esses preconceitos como casos extremos infrequentes em aplicações do mundo real – e podem ser mitigados por meio de afinações. Além disso, eles apontam para preconceitos diferentes, mas análogos que são mantidos por modelos da OpenAI e outras empresas. O Llama da Meta emergiu como um modelo aberto popular, apesar de seus conjuntos de dados não serem públicos, e apesar de preconceitos ocultos, e processos judiciais sendo movidos contra ele por causa disso.

Perguntas surgem sobre o ROI de grandes investimentos da OpenAI

Isso tudo levanta grandes perguntas sobre os planos de investimento adotados pela OpenAI, Microsoft e outros. O projeto Stargate de $500 bilhões da OpenAI reflete seu compromisso em construir enormes data centers para alimentar seus modelos avançados. Apoiada por parceiros como Oracle e Softbank, essa estratégia é fundamentada na crença de que alcançar a inteligência artificial geral (AGI) requer recursos computacionais sem precedentes. No entanto, a demonstração do DeepSeek de um modelo de alto desempenho a uma fração do custo desafia a sustentabilidade dessa abordagem, levantando dúvidas sobre a capacidade da OpenAI de entregar retornos sobre um investimento tão monumental.

O empreendedor e comentarista Arnaud Bertrand capturou essa dinâmica, contrastando a inovação frugal e descentralizada da China com a dependência dos EUA de infraestrutura centralizada e intensiva em recursos: “É sobre o mundo percebendo que a China alcançou — e em algumas áreas superou — os EUA em tecnologia e inovação, apesar dos esforços para evitar isso.” De fato, ontem uma outra empresa chinesa, ByteDance anunciou o Doubao-1.5-pro, que inclui um modo “Pensamento Profundo” que supera o o1 da OpenAI no benchmark AIME.

Quer se aprofundar mais sobre como o DeepSeek-R1 está reformulando o desenvolvimento de IA? Confira nossa discussão aprofundada no YouTube, onde exploro essa inovação com o desenvolvedor de ML Sam Witteveen. Juntos, analisaremos os detalhes técnicos, implicações para as empresas e o que isso significa para o futuro da IA:

Insights diários sobre casos de uso comercial com o VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Damos a você as informações internas sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para maximizar o ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…