Participe de nossos boletins informativos diários e semanais para receber as últimas atualizações e conteúdo exclusivo sobre cobertura de IA de ponta na indústria. Saiba mais

A OpenAI lançou um novo modelo de IA proprietário para combater a rápida ascensão do rival de código aberto DeepSeek R1 — mas será suficiente para amortecer o sucesso deste último?

Hoje, após vários dias de rumores e crescente expectativa entre os usuários de IA nas redes sociais, a OpenAI está debutando o o3-mini, o segundo modelo de sua nova família de “raciocionadores”, modelos de IA que levam um pouco mais de tempo para “pensar”, analisam seus próprios processos e refletem sobre suas próprias “cadeias de pensamento” antes de responder às consultas e ao input dos usuários com novas saídas.

O resultado é um modelo que pode atuar no nível de um estudante de doutorado ou até mesmo de um graduado ao responder perguntas difíceis em matemática, ciências, engenharia e muitos outros campos.

O modelo o3-mini já está disponível no ChatGPT, incluindo o plano gratuito, e na interface de programação de aplicativos (API) da OpenAI, sendo na verdade menos caro, mais rápido e mais eficiente do que o modelo de alto nível anterior, o o1 da OpenAI e seu irmão mais rápido e de menor contagem de parâmetros, o o1-mini.

Embora inevitavelmente seja comparado ao DeepSeek R1, e a data de lançamento vista como uma reação, é importante lembrar que o o3 e o o3-mini foram anunciados muito antes do lançamento em janeiro do DeepSeek R1, em dezembro de 2024 — e que o CEO da OpenAI Sam Altman afirmou anteriormente no X que, devido ao feedback de desenvolvedores e pesquisadores, ele chegaria ao ChatGPT e à API da OpenAI ao mesmo tempo.

Diferente do DeepSeek R1, o o3-mini não será disponibilizado como um modelo de código aberto — o que significa que o código não pode ser retirado e baixado para uso offline, nem personalizado na mesma medida, o que pode limitar seu apelo em comparação com o DeepSeek R1 para algumas aplicações.

A OpenAI não forneceu mais detalhes sobre o (presumido) modelo maior o3 anunciado em dezembro ao lado do o3-mini. Naquela época, o formulário de opt-in da OpenAI para testar o o3 afirmava que haveria um “atraso de várias semanas” antes que terceiros pudessem testá-lo.

Desempenho e Recursos

Semelhante ao o1, o OpenAI o3-mini é otimizado para raciocínio em matemática, programação e ciências.

Seu desempenho é comparável ao OpenAI o1 ao usar um esforço de raciocínio médio, mas oferece as seguintes vantagens:

- 24% mais rápido em tempos de resposta em comparação com o o1-mini (a OpenAI não forneceu um número específico aqui, mas analisando os testes do grupo de avaliação externo Artificial Analysis, o tempo de resposta do o1-mini é de 12,8 segundos para receber e produzir 100 tokens. Assim, para o o3-mini, um aumento de 24% reduziria o tempo de resposta para 10,32 segundos.)

- Precisão melhorada, com testadores externos preferindo as respostas do o3-mini 56% do tempo.

- 39% menos erros graves em perguntas complexas do mundo real.

- Melhor desempenho em tarefas de codificação e STEM, particularmente ao usar alto esforço de raciocínio.

- Três níveis de esforço de raciocínio (baixo, médio e alto), permitindo que usuários e desenvolvedores equilibrem precisão e velocidade.

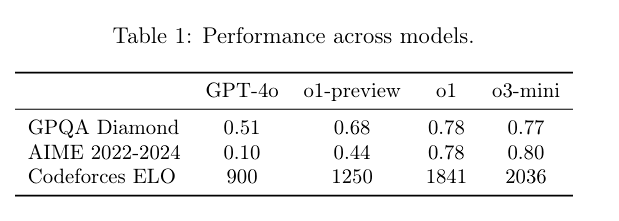

Ele também apresenta marcos impressionantes, superando até o o1 em alguns casos, de acordo com o Cartão do Sistema do o3-mini que a OpenAI lançou online (e que foi publicado anteriormente ao anúncio oficial de disponibilidade do modelo).

A janela de contexto do o3-mini — o número de tokens combinados que pode entrar/sair em uma única interação — é de 200.000, com um máximo de 100.000 em cada saída. Isso é o mesmo que o modelo completo o1 e supera a janela de contexto do DeepSeek R1 de cerca de 128.000/130.000 tokens. Mas está muito abaixo dos 1 milhão de tokens da nova janela de contexto do Google Gemini 2.0 Flash Thinking.

Enquanto o o3-mini se concentra nas capacidades de raciocínio, ele ainda não possui funcionalidades de visão. Desenvolvedores e usuários que buscam carregar imagens e arquivos devem continuar usando o o1 por enquanto.

A competição se intensifica

A chegada do o3-mini marca a primeira vez que a OpenAI está disponibilizando um modelo de raciocínio para usuários gratuitos do ChatGPT. A família de modelos anterior o1 estava disponível apenas para assinantes pagos do ChatGPT Plus, Pro e outros planos, bem como através da API paga da OpenAI.

Como fez com chatbots impulsionados por modelos de linguagem de grande porte (LLM) com o lançamento do ChatGPT em novembro de 2022, a OpenAI basicamente criou toda a categoria de modelos de raciocínio em setembro de 2024, quando revelou pela primeira vez o o1, uma nova classe de modelos com um novo regime de treinamento e arquitetura.

Mas a OpenAI, em consonância com sua história recente, não tornou o o1 de código aberto, diferente de seu nome e missão original. Em vez disso, manteve o código do modelo proprietário.

E nos últimos duas semanas, o o1 foi ofuscado pela startup de IA chinesa DeepSeek, que lançou o R1, um modelo de raciocínio rival, altamente eficiente e em grande parte de código aberto, disponível gratuitamente para ser utilizado, retrainado e personalizado por qualquer pessoa ao redor do mundo, bem como para uso gratuito no site e no aplicativo móvel da DeepSeek — um modelo que supostamente foi treinado a uma fração do custo do o1 e de outros LLMs dos principais laboratórios.

Os termos permissivos de licenciamento MIT do DeepSeek R1, aplicativo/site gratuito para consumidores e a decisão de tornar o código-base do R1 disponibilizado gratuitamente para uso e modificação levaram a uma verdadeira explosão de uso tanto no mercado consumidor quanto no empresarial — até mesmo a Microsoft, investidora da OpenAI e a Amazon, apoiadora da Anthropic correram para adicionar variantes dele em suas lojas de nuvem. A Perplexity, a empresa de busca por IA, também rapidamente adicionou uma variante para os usuários.

Ele também destronou o aplicativo ChatGPT para iOS do primeiro lugar na App Store dos EUA, e é notável por superar a OpenAI ao conectar o DeepSeek R1 a pesquisas na web, algo que a OpenAI ainda não fez para o o1, levando a uma maior ansiedade tecnológica entre trabalhadores de tecnologia e outros online sobre a China estar alcançando ou superando os EUA em inovação em IA — mesmo em tecnologia de forma mais geral.

No entanto, muitos pesquisadores e cientistas em IA, bem como os principais VCs, como Marc Andreessen, saudaram a ascensão do DeepSeek e sua abertura em particular como uma maré que levanta todos os barcos no campo da IA, aumentando a inteligência disponível para todos enquanto reduz os custos.

Disponibilidade no ChatGPT

O modelo está sendo lançado globalmente para usuários gratuitos, Plus, Team e Pro, com acesso a Enterprise e Educação previsto para a próxima semana.

- Usuários gratuitos podem experimentar o o3-mini pela primeira vez selecionando o botão “Raciocinar” na barra de chat ou regenerando uma resposta.

- Os limites de mensagens aumentaram 3 vezes para usuários Plus e Team, de 50 para 150 mensagens por dia.

- Usuários Pro têm acesso ilimitado tanto ao o3-mini quanto a uma nova variante de raciocínio ainda mais avançada, o o3-mini-high.

Além disso, o o3-mini agora suporta integração de pesquisa dentro do ChatGPT, fornecendo respostas com links relevantes da web. Esse recurso ainda está em estágios iniciais enquanto a OpenAI refina as capacidades de pesquisa em seus modelos de raciocínio.

Integração da API e Preços

Para desenvolvedores, o o3-mini está disponível através da API de Conclusões de Chat, API de Assistentes e API em Lote. O modelo suporta a chamada de funções, Saídas Estruturadas e mensagens de desenvolvedor, facilitando a integração em aplicações do mundo real.

Uma das vantagens mais notáveis do o3-mini é sua eficiência de custos: é 63% mais barato que o OpenAI o1-mini e 93% mais barato que o modelo completo o1, com preços de $1,10/$4,40 por milhão de tokens de entrada/saída (com um desconto de cache de 50%).

No entanto, ainda fica aquém da acessibilidade da API oficial do DeepSeek que oferece o R1 a $0,14/$0,55 por milhão de tokens de entrada/saída. Mas, dado que o DeepSeek está baseado na China e apresenta preocupações geopolíticas e de segurança associadas ao fluxo de dados do usuário/empresa para dentro e para fora do modelo, é provável que a OpenAI permaneça a API preferida para alguns clientes e empresas focados em segurança nos EUA e Europa.

Os desenvolvedores também podem ajustar o nível de esforço de raciocínio (baixo, médio, alto) com base nas necessidades de suas aplicações, permitindo maior controle sobre as trocas de latência e precisão.

Sobre segurança, a OpenAI afirma que usou algo chamado “alinhamento deliberativo” com o o3-mini. Isso significa que o modelo foi solicitado a raciocinar sobre as diretrizes de segurança elaboradas por humanos que recebeu, entender mais sobre sua intenção e os danos que se propõem a prevenir, e elaborar suas próprias maneiras de garantir que esses danos sejam evitados. A OpenAI afirma que isso permite que o modelo seja menos censurador ao discutir tópicos sensíveis, ao mesmo tempo em que preserva a segurança.

A OpenAI afirma que o modelo supera o GPT-4o em lidar com desafios de segurança e jailbreak, e que conduziu extensos testes externos de segurança antes do lançamento de hoje.

Um relatório recente coberto na Wired (onde minha esposa trabalha) mostrou que o DeepSeek sucumbiu a todos os prompts e tentativas de jailbreak de 50 testados por pesquisadores de segurança, o que pode dar ao o3-mini da OpenAI a vantagem sobre o DeepSeek R1 em casos onde segurança e segurança são primordiais.

O que vem a seguir?

O lançamento do o3-mini representa o esforço mais amplo da OpenAI para tornar a IA de raciocínio avançada mais acessível e econômica frente a uma competição mais intensa do que nunca, vinda do DeepSeek R1 e outros, como o Google, que recentemente lançou uma versão gratuita de seu próprio modelo de raciocínio rival, o Gemini 2 Flash Thinking, com uma entrada de contexto expandida de até 1 milhão de tokens.

Com seu foco em raciocínio STEM e acessibilidade, a OpenAI visa expandir o alcance da resolução de problemas movida por IA em aplicações tanto para consumidores quanto para desenvolvedores.

No entanto, à medida que a empresa se torna mais ambiciosa do que nunca em seus objetivos — recentemente anunciando um projeto de infraestrutura de data center de $500 bilhões chamado Stargate com apoio da Softbank — a questão permanece se sua estratégia valerá bem o suficiente para justificar os multibilhões investidos nela por investidores com capital pesado, como a Microsoft e outros VCs.

À medida que modelos de código aberto se aproximam cada vez mais da OpenAI em termos de desempenho e superam-na em custos, suas supostas medidas de segurança superiores, capacidades poderosas, API de fácil utilização e interfaces amigáveis para o usuário serão suficientes para manter clientes — especialmente no setor empresarial — que podem priorizar custo e eficiência em relação a essas características? Estaremos reportando sobre os desdobramentos à medida que eles acontecem.

Perspectivas diárias sobre casos de uso de negócios com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo o que você precisa. Nós fornecemos informações sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implementações práticas, para que você possa compartilhar insights para maximizar o ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais newsletters da VB aqui.

Ocorreu um erro.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…