Olá, pessoal, bem-vindos ao boletim regular sobre IA da TechCrunch. Se você deseja recebê-lo no seu e-mail todas as quartas-feiras, inscreva-se aqui.

Talvez você tenha notado que pulamos o boletim na semana passada. O motivo? Um ciclo de notícias sobre IA caótico, ainda mais tumultuado pela súbita ascensão da empresa chinesa de IA DeepSeek e pela resposta de praticamente todos os setores da indústria e do governo.

Felizmente, estamos de volta ao caminho certo — e não um momento tarde demais, considerando os desenvolvimentos notáveis do fim de semana passado vindos da OpenAI.

O CEO da OpenAI, Sam Altman, esteve em Tóquio para uma conversa no palco com Masayoshi Son, o CEO do conglomerado japonês SoftBank. O SoftBank é um dos principais investidores da OpenAI e parceiro, tendo se comprometido a ajudar a financiar o enorme projeto de infraestrutura de centro de dados da OpenAI nos EUA.

Portanto, Altman provavelmente sentiu que devia algumas horas do seu tempo a Son.

Sobre o que dois bilionários conversaram? Muitas abstrações sobre como a IA pode “agenciar” o trabalho, segundo reportagens secundárias. Son afirmou que sua empresa gastaria $3 bilhões por ano em produtos da OpenAI e se uniria à OpenAI para desenvolver uma plataforma chamada “Cristal [sic] Intelligence”, com o objetivo de automatizar milhões de fluxos de trabalho tradicionalmente de colarinho branco.

“Ao automatizar e autonomizar todas as suas tarefas e fluxos de trabalho, a SoftBank Corp. transformará seus negócios e serviços e criará novo valor,” disse a SoftBank em um comunicado à imprensa na segunda-feira.

Eu me pergunto, no entanto, o que os humildes trabalhadores pensam sobre toda essa automação e autonomização?

Como Sebastian Siemiatkowski, o CEO da fintech Klarna, que frequentemente se vangloria sobre a IA substituindo humanos, Son parece ter a opinião de que substitutos agenciais para trabalhadores podem apenas gerar riquezas fabulosas. O custo da abundância passa despercebido. Se a automação generalizada de empregos realmente acontecer, o desemprego em larga escala é o resultado mais provável.

É desanimador que aqueles que estão à frente da corrida de IA — empresas como a OpenAI e investidores como o SoftBank — optem por usar conferências de imprensa para pintar um quadro de corporações automatizadas com menos trabalhadores na folha de pagamento. Eles são negócios, é claro — não caridades. E o desenvolvimento de IA não é barato. Mas talvez as pessoas confiariam na IA se aqueles que guiam sua implementação mostrassem um pouco mais de preocupação com seu bem-estar.

Algo a se pensar.

Notícias

Pesquisa profunda: A OpenAI lançou um novo “agente” de IA projetado para ajudar as pessoas a conduzir pesquisas complexas e aprofundadas usando o ChatGPT, a plataforma de chatbot da empresa.

O3-mini: Em outras notícias da OpenAI, a empresa lançou um novo modelo de “raciocínio”, o o3-mini, após uma prévia em dezembro passado. Não é o modelo mais poderoso da OpenAI, mas o o3-mini apresenta melhora na eficiência e velocidade de resposta.

UE proíbe IA arriscada: A partir de domingo na União Europeia, os reguladores do bloco podem proibir o uso de sistemas de IA que considerem “risco inaceitável” ou danoso. Isso inclui IA usada para pontuação social e publicidade subliminar.

Uma peça sobre “doomers” de IA: Há uma nova peça sobre a cultura dos “doomers” de IA, vagamente baseada na demissão de Sam Altman como CEO da OpenAI em novembro de 2023. Meus colegas Dominic e Rebecca compartilham suas opiniões após assistirem à estreia.

Tecnologia para aumentar a produtividade das colheitas: A “fábrica lunar” X do Google anunciou nesta semana seu mais recente produto. Heritable Agriculture é uma startup impulsionada por dados e aprendizado de máquina que visa melhorar o cultivo de colheitas.

Papel de pesquisa da semana

Modelos de raciocínio são melhores que sua média de IA na resolução de problemas, particularmente questões relacionadas a ciências e matemática. Mas não são uma solução mágica.

Um novo estudo de pesquisadores da empresa chinesa Tencent investiga a questão da “subpensamento” em modelos de raciocínio, onde os modelos abandonam prematuramente, sem explicação, cadeias de pensamento potencialmente promissoras. De acordo com os resultados do estudo, padrões de “subpensamento” tendem a ocorrer com mais frequência em problemas mais difíceis, levando os modelos a alternar entre cadeias de raciocínio sem chegar a respostas.

A equipe propõe uma solução que emprega uma “penalidade de troca de pensamento” para incentivar os modelos a “desenvolver completamente” cada linha de raciocínio antes de considerar alternativas, aumentando a precisão dos modelos.

Modelo da semana

Uma equipe de pesquisadores apoiada pelo proprietário do TikTok, ByteDance, pela empresa chinesa de IA Moonshot e outros lançaram um novo modelo aberto capaz de gerar músicas de qualidade relativamente alta com base em prompts.

O modelo, chamado YuE, pode produzir uma canção de até alguns minutos de duração, completa com vocais e faixas de acompanhamento. Ele está sob uma licença Apache 2.0, o que significa que o modelo pode ser usado comercialmente sem restrições.

No entanto, há desvantagens. Executar o YuE requer uma GPU robusta; gerar uma canção de 30 segundos leva seis minutos com uma Nvidia RTX 4090. Além disso, não está claro se o modelo foi treinado usando dados protegidos por direitos autorais; seus criadores não disseram. Se for constatado que canções protegidas por direitos autorais estavam, de fato, no conjunto de treinamento do modelo, os usuários poderiam enfrentar desafios futuros relacionados a propriedade intelectual.

Miscellaneous

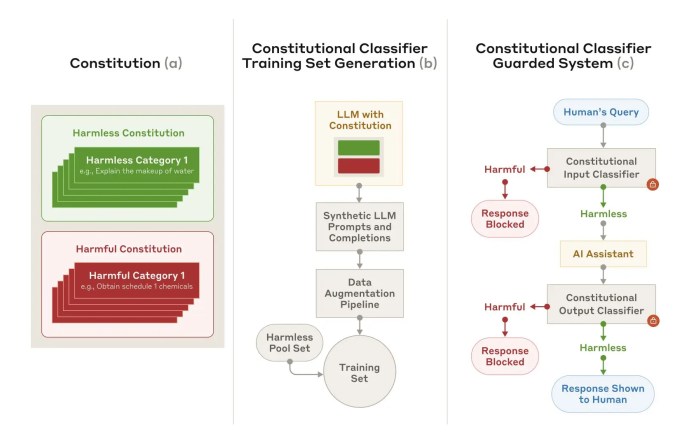

O laboratório de IA Anthropic afirma ter desenvolvido uma técnica para defender-se de forma mais confiável contra “jailbreaks” de IA, os métodos que podem ser usados para contornar as medidas de segurança de um sistema de IA.

A técnica, Classificadores Constitucionais, se baseia em dois conjuntos de modelos de IA “classificadores”: um classificador de “entrada” e um classificador de “saída”. O classificador de entrada acrescenta prompts a um modelo protegido com templates que descrevem jailbreaks e outros conteúdos não permitidos, enquanto o classificador de saída calcula a probabilidade de que uma resposta de um modelo discuta informações prejudiciais.

A Anthropic afirma que os Classificadores Constitucionais podem filtrar a “maioria esmagadora” dos jailbreaks. No entanto, isso tem seu custo. Cada consulta é 25% mais exigente em termos computacionais, e o modelo protegido tem 0,38% menos chances de responder a perguntas inocentes.

Conteúdo relacionado

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…

Tudo o que você precisa saber sobre o chatbot de IA

[the_ad id="145565"] O ChatGPT, o chatbot de IA geradora de texto da OpenAI, conquistou o mundo desde seu lançamento em novembro de 2022. O que começou como uma ferramenta para…