Inscreva-se em nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura líder da indústria em IA. Saiba mais

A série de modelos de linguagem grande (LLMs) Gemini do Google começou de forma complicada há quase um ano, com alguns incidentes embaraçosos de geração de imagens, mas tem melhorado constantemente. A empresa parece estar determinada a fazer de seu esforço de segunda geração — Gemini 2.0 — a maior e melhor versão até agora para consumidores e empresas.

Hoje, a empresa anunciou o lançamento geral do Gemini 2.0 Flash, a introdução do Gemini 2.0 Flash-Lite e uma versão experimental do Gemini 2.0 Pro.

Esses modelos, projetados para apoiar desenvolvedores e empresas, estão agora acessíveis através do Google AI Studio e do Vertex AI, com o Flash-Lite em pré-visualização pública e o Pro disponível para testes iniciais.

“Todos esses modelos terão entrada multimodal com saída de texto no lançamento, com mais modalidades prontas para disponibilidade geral nos próximos meses,” escreveu Koray Kavukcuoglu, diretor de tecnologia da Google DeepMind, em um artigo do blog de anúncio da empresa — destacando uma vantagem que o Google está trazendo para a mesa, mesmo enquanto concorrentes como a DeepSeek e a OpenAI continuam lançando poderosos rivais.

Google aproveita suas forças multimodais

Nem o DeepSeek R1 nem o novo modelo o3-mini da OpenAI conseguem aceitar entradas multimodais, isto é, imagens e arquivos enviados ou anexos.

Enquanto o DeepSeek R1 pode aceitá-los em seu site e chat de aplicativos móveis, ele realiza reconhecimento óptico de caracteres (OCR), uma tecnologia de mais de 60 anos, para extrair apenas o texto desses uploads — não entendendo ou analisando realmente nenhuma das outras características contidas neles.

No entanto, ambos são uma nova classe de modelos de “raciocínio” que deliberadamente demoram mais para pensar nas respostas e refletir sobre “cadeias de pensamento” e a correção de suas respostas. Isso se opõe a LLMs típicos como a série pro do Gemini 2.0, portanto, a comparação entre Gemini 2.0 e DeepSeek R1 e OpenAI o3 é um pouco como comparar maçãs com laranjas.

Mas também houve novidades no campo do raciocínio hoje no Google: o CEO do Google, Sundar Pichai, se manifestou na rede social X para declarar que o aplicativo móvel Google Gemini para iOS e Android foi atualizado com o modelo de raciocínio próprio do Google, Gemini 2.0 Flash Thinking, e que o modelo pode ser conectado aos serviços existentes de sucesso do Google, como Google Maps, YouTube e Google Search, permitindo uma nova gama de pesquisas e interações impulsionadas por IA que simplesmente não podem ser igualadas por iniciantes como DeepSeek e OpenAI.

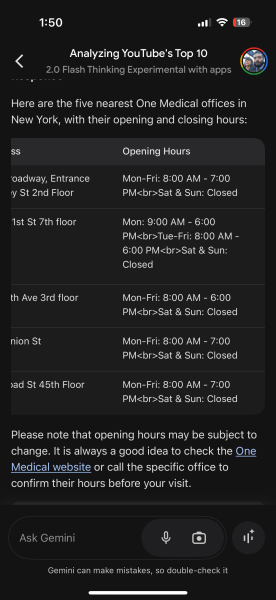

Eu experimentei brevemente no aplicativo Google Gemini para iOS em meu iPhone enquanto escrevia este texto, e foi impressionante com base nas minhas consultas iniciais, pensando através das semelhanças dos 10 vídeos mais populares do YouTube do último mês e também me fornecendo uma tabela de consultórios médicos próximos e horas de funcionamento, tudo em segundos.

Gemini 2.0 Flash entra em lançamento geral

O modelo Gemini 2.0 Flash, originalmente lançado como uma versão experimental em dezembro, agora está pronto para produção.

Projetado para aplicações de IA de alta eficiência, ele oferece respostas de baixa latência e suporta raciocínio multimodal em grande escala.

Um grande benefício em relação à concorrência está em sua janela de contexto, ou o número de tokens que o usuário pode adicionar na forma de um prompt e receber de volta em uma interação de ida e volta com um chatbot alimentado por LLM ou interface de programação de aplicativos.

Enquanto muitos modelos líderes, como o novo o3-mini da OpenAI que foi lançado na semana passada, suportam 200.000 ou menos tokens — equivalente a um romance de 400-500 páginas de densidade de informação — o Gemini 2.0 Flash suporta 1 milhão, o que significa que é capaz de lidar com enormes quantidades de informação, tornando-o particularmente útil para tarefas de alta frequência e grande escala.

Gemini 2.0 Flash-Lite chega para reduzir a curva de custo ao menor nível até agora

O Gemini 2.0 Flash-Lite, por sua vez, é um novo modelo de linguagem grande voltado para fornecer uma solução de IA econômica sem comprometer a qualidade.

A Google DeepMind afirma que o Flash-Lite supera seu antecessor de tamanho completo (com maior contagem de parâmetros), Gemini 1.5 Flash, em benchmarks de terceiros, como MMLU Pro (77,6% vs. 67,3%) e programação Bird SQL (57,4% vs. 45,6%), enquanto mantém a mesma precificação e velocidade.

Ele também suporta entrada multimodal e possui uma janela de contexto de 1 milhão de tokens, semelhante ao modelo Flash completo.

Atualmente, o Flash-Lite está disponível em pré-visualização pública pelo Google AI Studio e Vertex AI, com disponibilidade geral esperada nas próximas semanas.

Como mostrado na tabela abaixo, o Gemini 2.0 Flash-Lite custa $0,075 por milhão de tokens (de entrada) e $0,30 por milhão de tokens (de saída). O Flash-Lite é posicionado como uma opção altamente acessível para desenvolvedores, superando o Gemini 1.5 Flash em praticamente todos os benchmarks enquanto mantém a mesma estrutura de custo.

Logan Kilpatrick enfatizou a acessibilidade e o valor dos modelos, afirmando: “O Gemini 2.0 Flash é a melhor proposta de valor de qualquer LLM, é hora de construir!”

De fato, comparado a outros LLMs tradicionais de liderança disponíveis via API de provedores, como OpenAI 4o-mini ($0,15/$0,6 por 1 milhão de tokens de entrada/saída), Anthropic Claude ($0,8/$4 por 1M de entrada/saída), e até mesmo o LLM tradicional V3 da DeepSeek ($0,14/$0,28), o Gemini 2.0 Flash parece ser a melhor opção em termos de custo-benefício.

Gemini 2.0 Pro chega em disponibilidade experimental com janela de contexto de 2 milhões de tokens

Para usuários que exigem capacidades de IA mais avançadas, o modelo Gemini 2.0 Pro (Experimental) já está disponível para teste.

A Google DeepMind descreve isso como seu modelo mais forte em desempenho de codificação e manipulação de prompts complexos. Ele apresenta uma janela de contexto de 2 milhões de tokens e capacidades de raciocínio aprimoradas, com a capacidade de integrar ferramentas externas como Google Search e execução de código.

Sam Witteveen, cofundador e CEO da Red Dragon AI, e um especialista externo do Google Developer em Machine Learning que costuma colaborar com o VentureBeat, discutiu o modelo Pro em uma análise no YouTube. “O novo modelo Gemini 2.0 Pro tem uma janela de contexto de dois milhões de tokens, suporta ferramentas, execução de código, chamada de funções e vínculo com a pesquisa do Google — tudo o que tínhamos no Pro 1.5, mas melhorado.”

Ele também observou a abordagem iterativa do Google para o desenvolvimento de IA: “Uma das principais diferenças na estratégia do Google é que eles lançam versões experimentais de modelos antes de se tornarem GA (geralmente acessíveis), permitindo uma iteração rápida com base no feedback.”

Os benchmarks de desempenho ilustram ainda mais as capacidades da família de modelos Gemini 2.0. O Gemini 2.0 Pro, por exemplo, supera o Flash e o Flash-Lite em tarefas como raciocínio, compreensão multilíngue e processamento de longos contextos.

Segurança em IA e Desenvolvimentos Futuros

Além dessas atualizações, a Google DeepMind está implementando novas medidas de segurança para os modelos Gemini 2.0. A empresa está aproveitando técnicas de aprendizado por reforço para melhorar a precisão das respostas, usando IA para criticar e refinar suas próprias produções. Além disso, os testes automáticos de segurança estão sendo utilizados para identificar vulnerabilidades, incluindo ameaças de injeção de prompt indiretas.

Olhando para o futuro, a Google DeepMind planeja expandir as capacidades da família de modelos Gemini 2.0, com modalidades adicionais além do texto previstas para se tornarem geralmente disponíveis nos próximos meses.

Com essas atualizações, o Google está reforçando seu impulso no desenvolvimento de IA, oferecendo uma gama de modelos projetados para eficiência, acessibilidade e resolução avançada de problemas, respondendo ao crescimento da DeepSeek com seu próprio conjunto de modelos que vão de poderosos a extremamente poderosos e de muito acessíveis a apenas ligeiramente menos (mas ainda consideravelmente) acessíveis.

Será que isso será suficiente para ajudar o Google a conquistar parte do mercado de IA empresarial, que antes era dominado pela OpenAI e agora foi abalado pela DeepSeek? Nós continuaremos acompanhando e informaremos você!

Insights diários sobre casos de uso comercial com VB Daily

Se você quer impressionar seu chefe, o VB Daily tem tudo para você. Damos a você a visão interna sobre o que as empresas estão fazendo com IA generativa, desde mudanças regulatórias até implantações práticas, para que você possa compartilhar insights para o máximo ROI.

Leia nossa Política de Privacidade

Obrigado por se inscrever. Confira mais boletins do VB aqui.

Ocorreu um erro.

Conteúdo relacionado

Pesquisador de IA renomado lança startup polêmica para substituir todos os trabalhadores humanos em todos os lugares

[the_ad id="145565"] De vez em quando, uma startup do Vale do Silício lança uma missão tão “absurdamente” descrita que é difícil discernir se a startup é real ou apenas uma…

ChatGPT se refere a usuários pelo nome sem solicitação, e alguns acham isso ‘estranho’

[the_ad id="145565"] Alguns usuários do ChatGPT notaram um fenômeno estranho recentemente: O chatbot ocasionalmente se refere a eles pelo nome enquanto raciocina sobre…

De ‘acompanhar’ a ‘nos acompanhar’: Como o Google silenciosamente assumiu a liderança em IA empresarial.

[the_ad id="145565"] Participe de nossos boletins diários e semanais para as últimas atualizações e conteúdo exclusivo sobre a cobertura de IA de ponta. Saiba Mais Há…